浏览器工作原理与实践

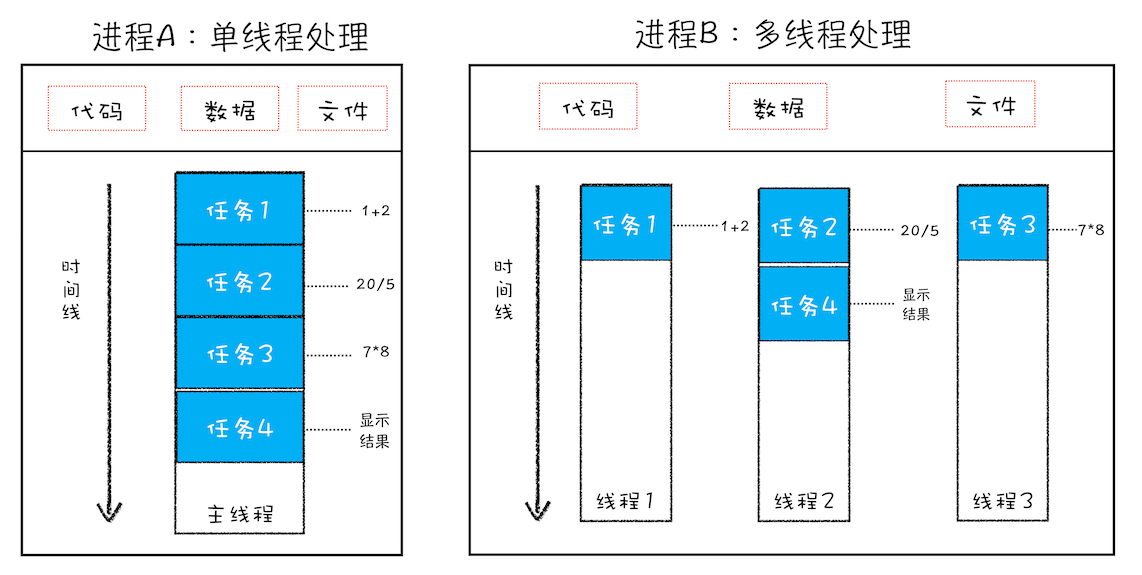

线程 VS 进程

一个进程就是一个程序的运行实例。详细解释就是,启动一个程序的时候,操作系统会为该程序创建一块内存,用来存放代码、运行中的数据和一个执行任务的主线程,我们把这样的一个运行环境叫进程。

线程是依附于进程的,而进程中使用多线程并行处理能提升运算效率

进程和线程的关系

1.进程中的任意一线程执行出错,都会导致整个进程的崩溃

A = 1+2

B = 20/0

C = 7*8我把上述三个表达式稍作修改,在计算 B 的值的时候,我把表达式的分母改成 0,当线程执行到 B = 20/0 时,由于分母为 0,线程会执行出错,这样就会导致整个进程的崩溃,当然另外两个线程执行的结果也没有了。

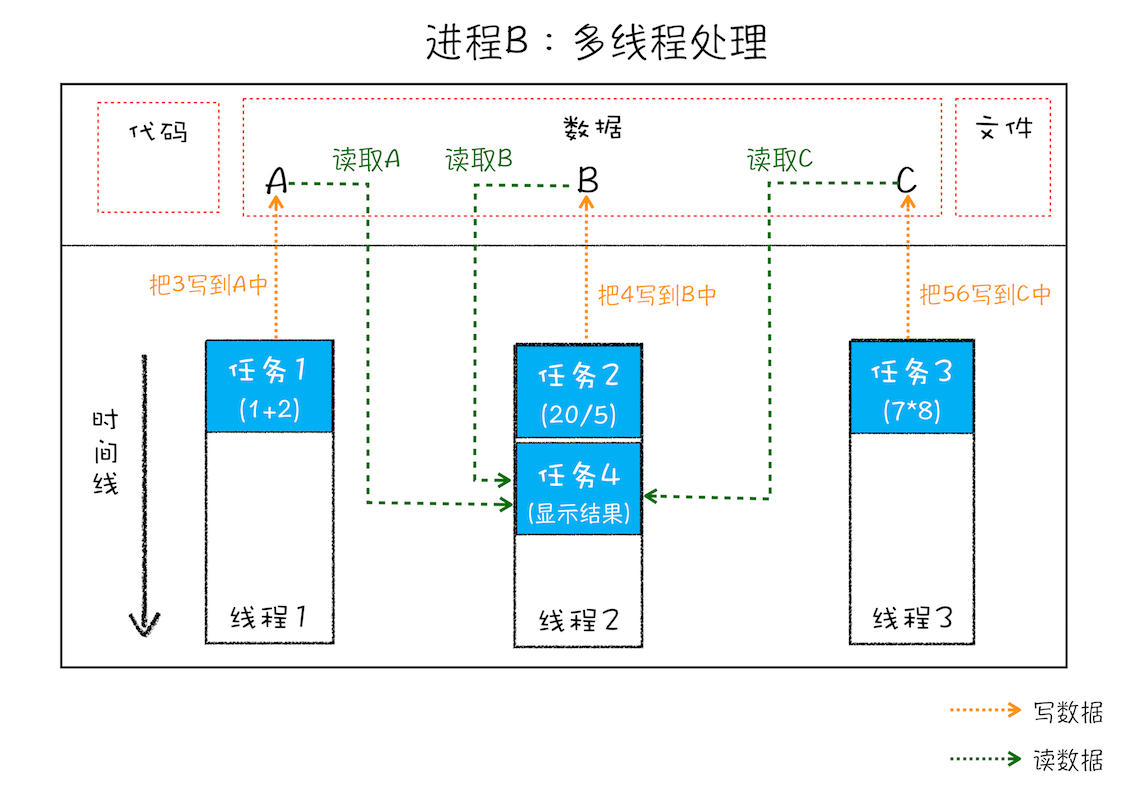

2.线程之间共享进程中的数据

线程之间可以对进程的公共数据进行读写操作

3.当一个进程关闭之后,操作系统会回收进程所占用的内存

当一个进程退出时,操作系统会回收该进程所申请的所有资源;即使其中任意线程因为操作不当导致内存泄漏,当进程退出时,这些内存也会被正确回收。

比如之前的 IE 浏览器,支持很多插件,而这些插件很容易导致内存泄漏,这意味着只要浏览器开着,内存占用就有可能会越来越多,但是当关闭浏览器进程时,这些内存就都会被系统回收掉。

4.进程之间的内容相互隔离

进程隔离是为保护操作系统中进程互不干扰的技术,每一个进程只能访问自己占有的数据,也就避免出现进程 A 写入数据到进程 B 的情况。正是因为进程之间的数据是严格隔离的,所以一个进程如果崩溃了,或者挂起了,是不会影响到其他进程的。如果进程之间需要进行数据的通信,这时候,就需要使用用于进程间通信(IPC)的机制了。

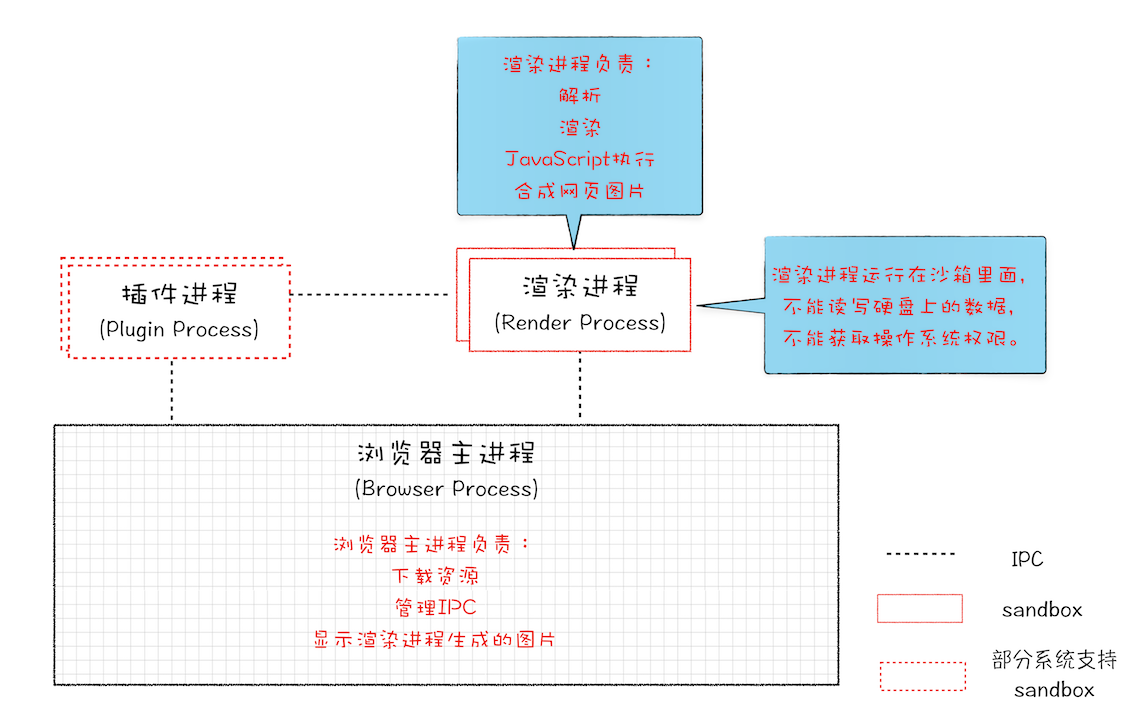

早期多进程架构

2008 年 Chrome 发布时的进程架构

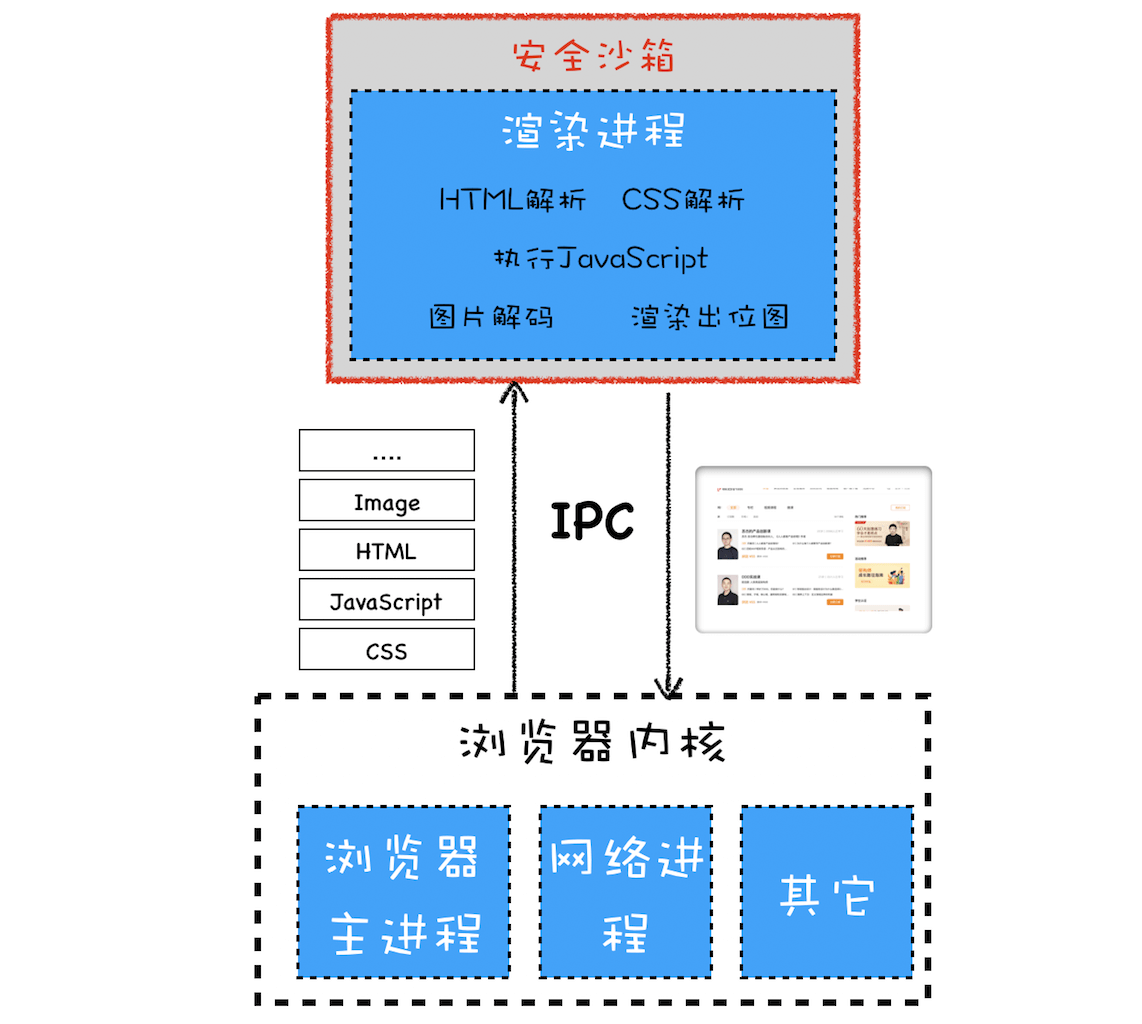

从图中可以看出,Chrome 的页面是运行在单独的渲染进程中的,同时页面里的插件也是运行在单独的插件进程之中,而进程之间是通过 IPC 机制进行通信(如图中虚线部分)。

1.不稳定的问题

由于进程是相互隔离的,所以当一个页面或者插件崩溃时,影响到的仅仅是当前的页面进程或者插件进程,并不会影响到浏览器和其他页面,这就完美地解决了页面或者插件的崩溃会导致整个浏览器崩溃,也就是不稳定的问题。

2.流畅的问题

JavaScript 也是运行在渲染进程中的,所以即使 JavaScript 阻塞了渲染进程,影响到的也只是当前的渲染页面,而并不会影响浏览器和其他页面,因为其他页面的脚本是运行在它们自己的渲染进程中的。所以当我们再在 Chrome 中运行上面那个死循环的脚本时,没有响应的仅仅是当前的页面。

当关闭一个页面时,整个渲染进程也会被关闭,之后该进程所占用的内存都会被系统回收,这样就轻松解决了浏览器页面的内存泄漏问题。

(除了脚本或者插件会让单进程浏览器变卡顿外,页面的内存泄漏也是单进程变慢的一个重要原因。通常浏览器的内核都是非常复杂的,运行一个复杂点的页面再关闭页面,会存在内存不能完全回收的情况,这样导致的问题是使用时间越长,内存占用越高,浏览器会变得越慢。)

3.安全问题

采用多进程架构的额外好处是可以使用安全沙箱,你可以把沙箱看成是操作系统给进程上了一把锁,沙箱里面的程序可以运行,但是不能在你的硬盘上写入任何数据,也不能在敏感位置读取任何数据,例如你的文档和桌面。Chrome 把插件进程和渲染进程锁在沙箱里面,这样即使在渲染进程或者插件进程里面执行了恶意程序,恶意程序也无法突破沙箱去获取系统权限。

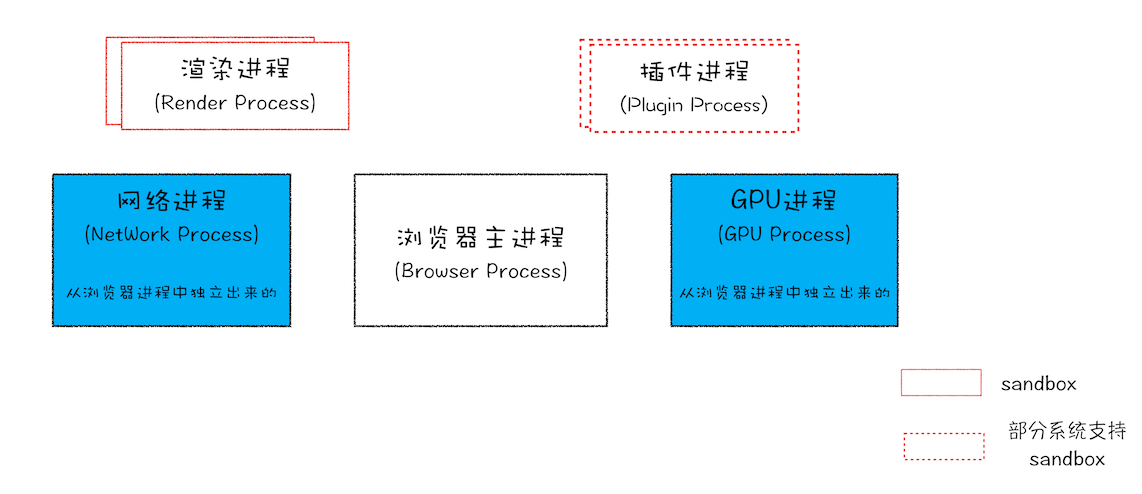

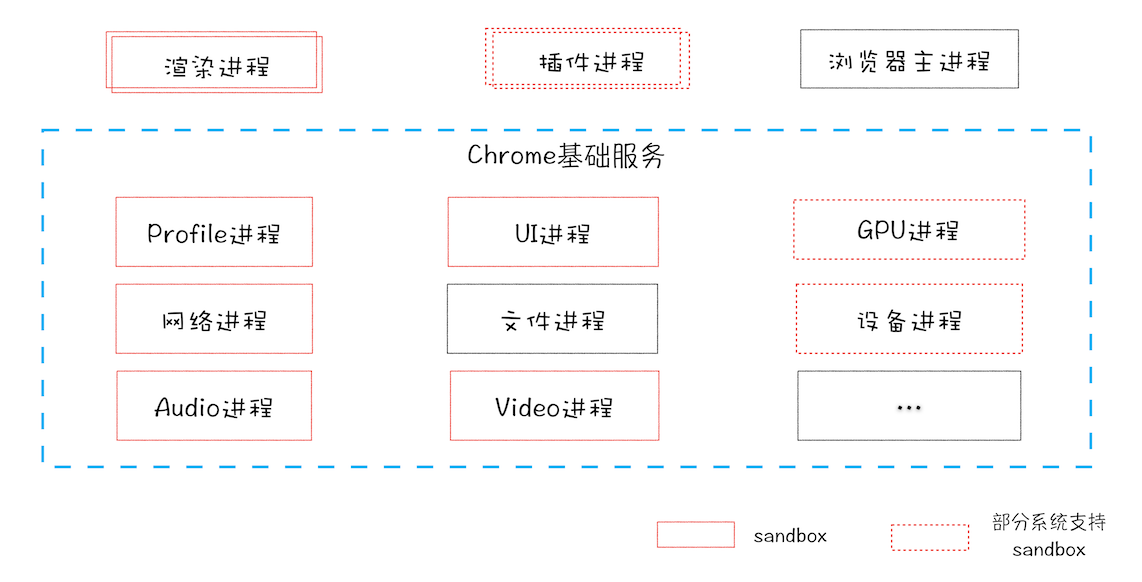

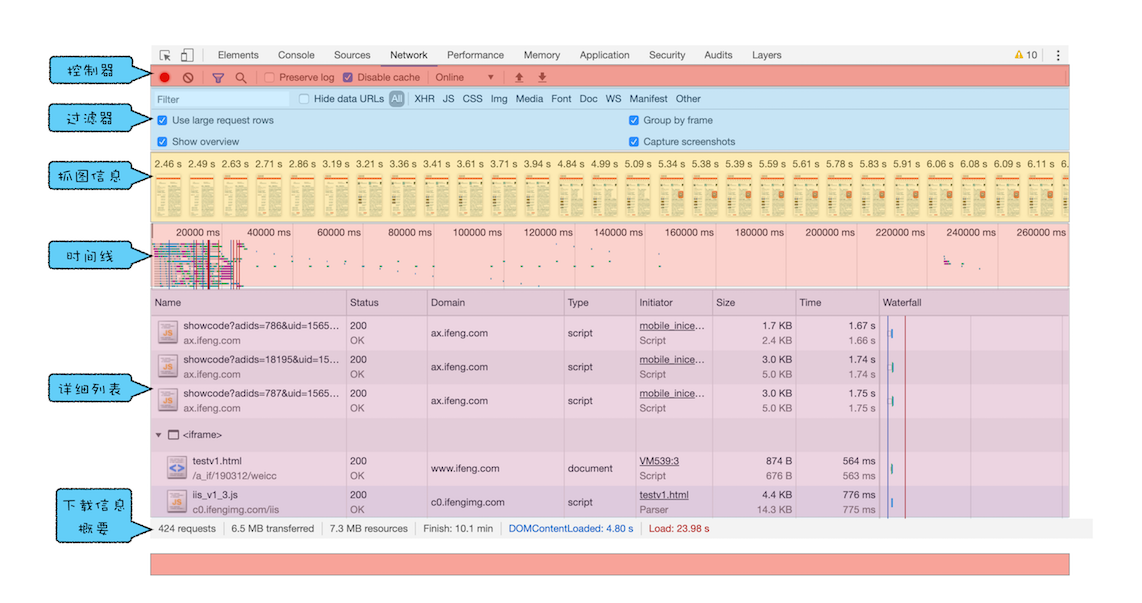

目前多进程架构

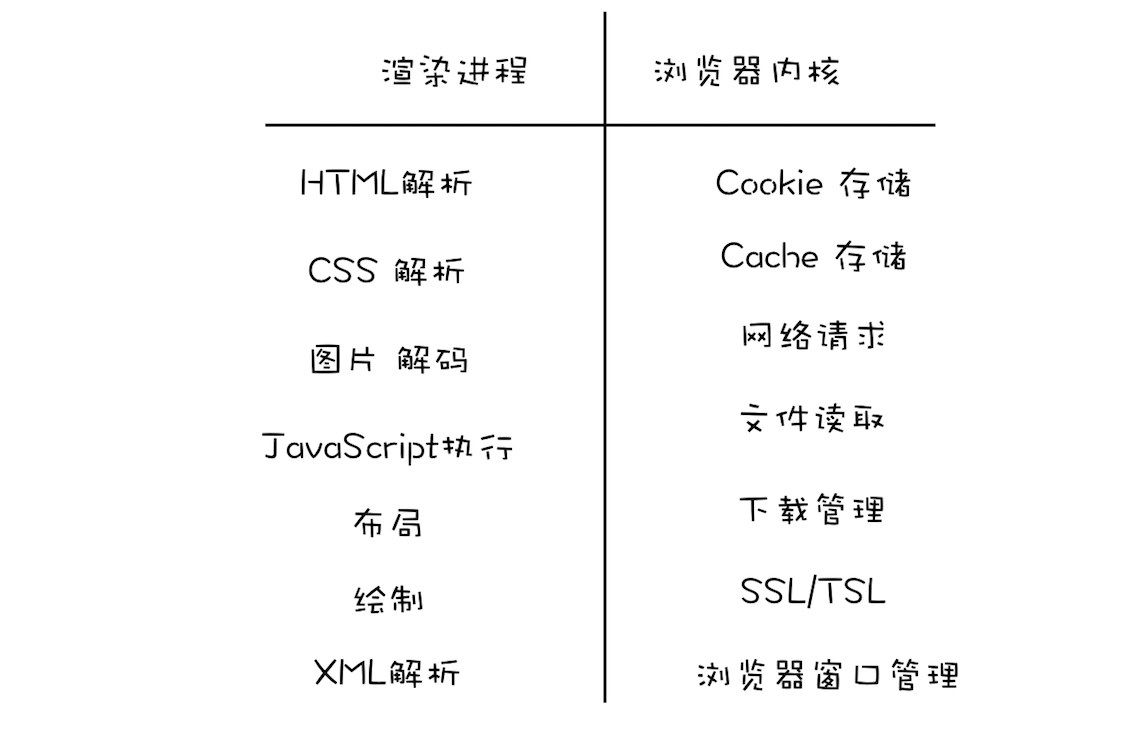

浏览器进程

主要负责界面显示、用户交互、子进程管理,同时提供存储等功能。

渲染进程

核心任务是将 HTML、CSS 和 JavaScript 转换为用户可以与之交互的网页,排版引擎 Blink 和 JavaScript 引擎 V8 都是运行在该进程中,默认情况下,Chrome 会为每个 Tab 标签创建一个渲染进程。出于安全考虑,渲染进程都是运行在沙箱模式下。

GPU 进程

其实,Chrome 刚开始发布的时候是没有 GPU 进程的。而 GPU 的使用初衷是为了实现 3D CSS 的效果,只是随后网页、Chrome 的 UI 界面都选择采用 GPU 来绘制,这使得 GPU 成为浏览器普遍的需求。最后,Chrome 在其多进程架构上也引入了 GPU 进程。

网络进程

主要负责页面的网络资源加载,之前是作为一个模块运行在浏览器进程里面的,直至最近才独立出来,成为一个单独的进程。

插件进程

主要是负责插件的运行,因插件易崩溃,所以需要通过插件进程来隔离,以保证插件进程崩溃不会对浏览器和页面造成影响。

存在的问题

更高的资源占用

因为每个进程都会包含公共基础结构的副本(如 JavaScript 运行环境),这就意味着浏览器会消耗更多的内存资源。

更复杂的体系架构

浏览器各模块之间耦合性高、扩展性差等问题,会导致现在的架构已经很难适应新的需求了。

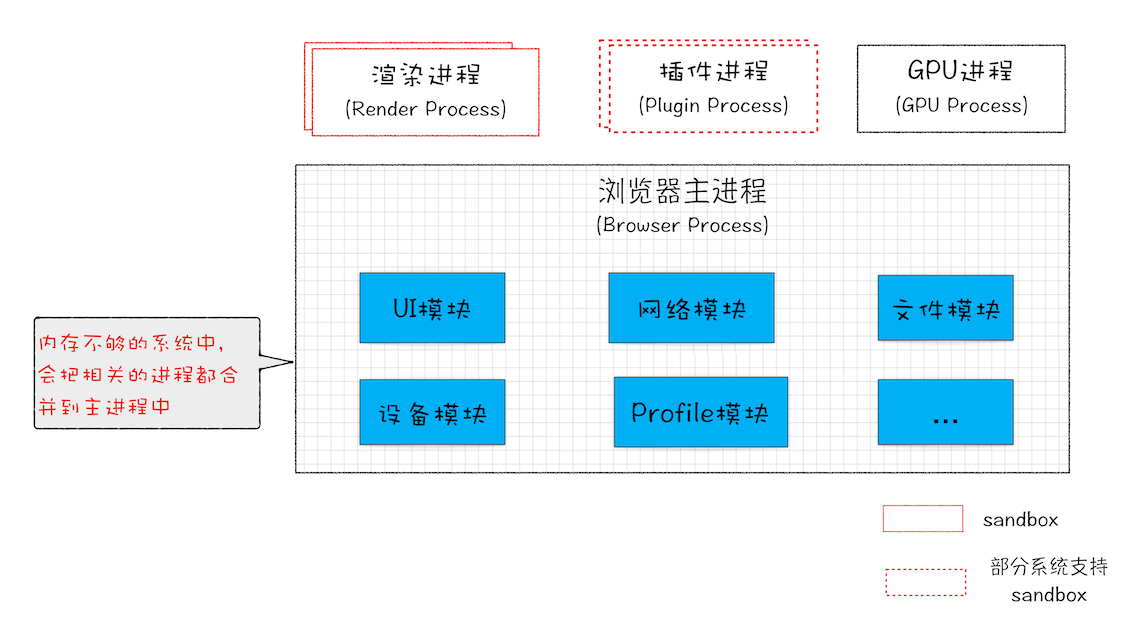

Chrome“面向服务的架构”(Services Oriented Architecture,简称 SOA)的进程模型图

Chrome 整体架构会朝向现代操作系统所采用的“面向服务的架构” 方向发展

各种模块会被重构成独立的服务(Service),每个服务(Service)都可以在独立的进程中运行,访问服务(Service)必须使用定义好的接口,通过 IPC 来通信,从而构建一个更内聚、松耦合、易于维护和扩展的系统,更好实现 Chrome 简单、稳定、高速、安全的目标。

Chrome 还提供灵活的弹性架构

在强大性能设备上会以多进程的方式运行基础服务,但是如果在资源受限的设备上(如下图),Chrome 会将很多服务整合到一个进程中,从而节省内存占用。

TCP/IP 协议

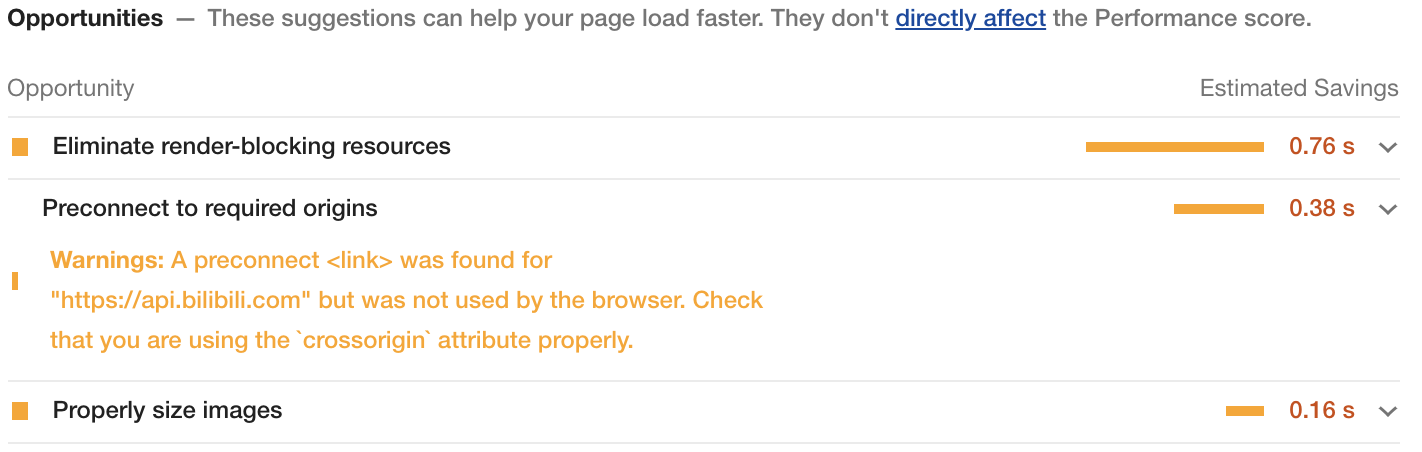

在衡量 Web 页面性能的时候有一个重要的指标叫“FP(First Paint)”,是指从页面加载到首次开始绘制的时长

影响 FP 指标的一个重要的因素是网络加载速度

不管你是使用 HTTP,还是使用 WebSocket,它们都是基于 TCP/IP 的

如何保证页面文件能被完整地送达浏览器呢?

互联网,实际上是一套理念和协议组成的体系架构

互联网中的数据是通过数据包来传输的。如果发送的数据很大,那么该数据就会被拆分为很多小数据包来传输

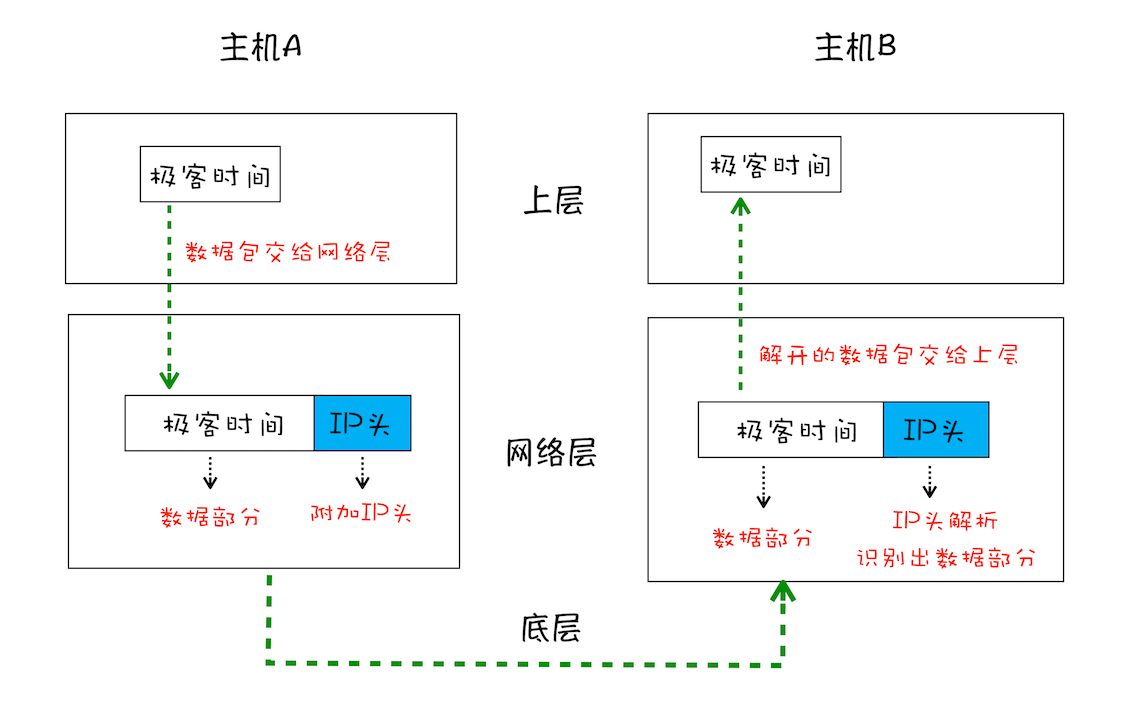

1.IP:把数据包送达目的主机

数据包要在互联网上进行传输,就要符合网际协议(Internet Protocol,简称 IP)标准

互联网上不同的在线设备都有唯一的地址

计算机的地址就称为 IP 地址,访问任何网站实际上只是你的计算机向另外一台计算机请求信息。

如果要想把一个数据包从主机 A 发送给主机 B,那么在传输之前,数据包上会被附加上主机 B 的 IP 地址信息,这样在传输过程中才能正确寻址。额外地,数据包上还会附加上主机 A 本身的 IP 地址,有了这些信息主机 B 才可以回复信息给主机 A。这些附加的信息会被装进一个叫 IP 头的数据结构里。IP 头是 IP 数据包开头的信息,包含 IP 版本、源 IP 地址、目标 IP 地址、生存时间等信息。

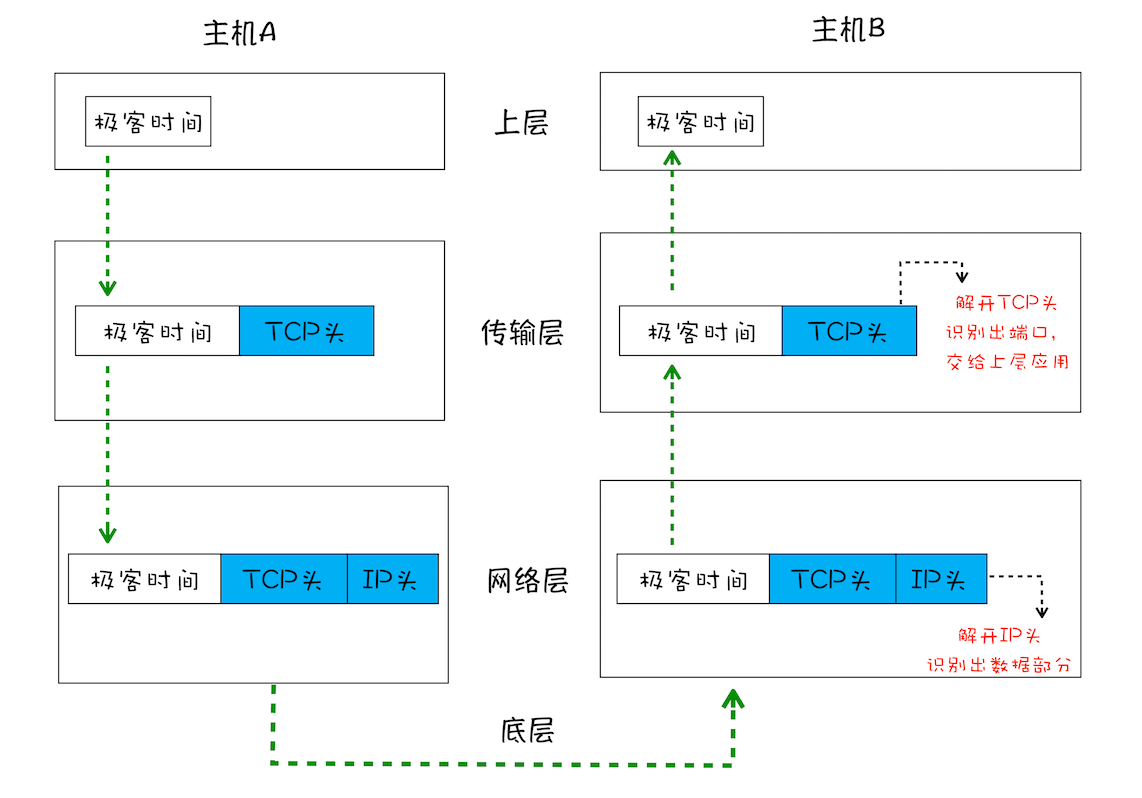

一个数据包从主机 A 到主机 B 的旅程:

1、上层将含有“极客时间”的数据包交给网络层;

2、网络层再将 IP 头附加到数据包上,组成新的 IP 数据包,并交给底层;

3、底层通过物理网络将数据包传输给主机 B;

4、数据包被传输到主机 B 的网络层,在这里主机 B 拆开数据包的 IP 头信息,并将拆开来的数据部分交给上层;

5、最终,含有“极客时间”信息的数据包就到达了主机 B 的上层了。

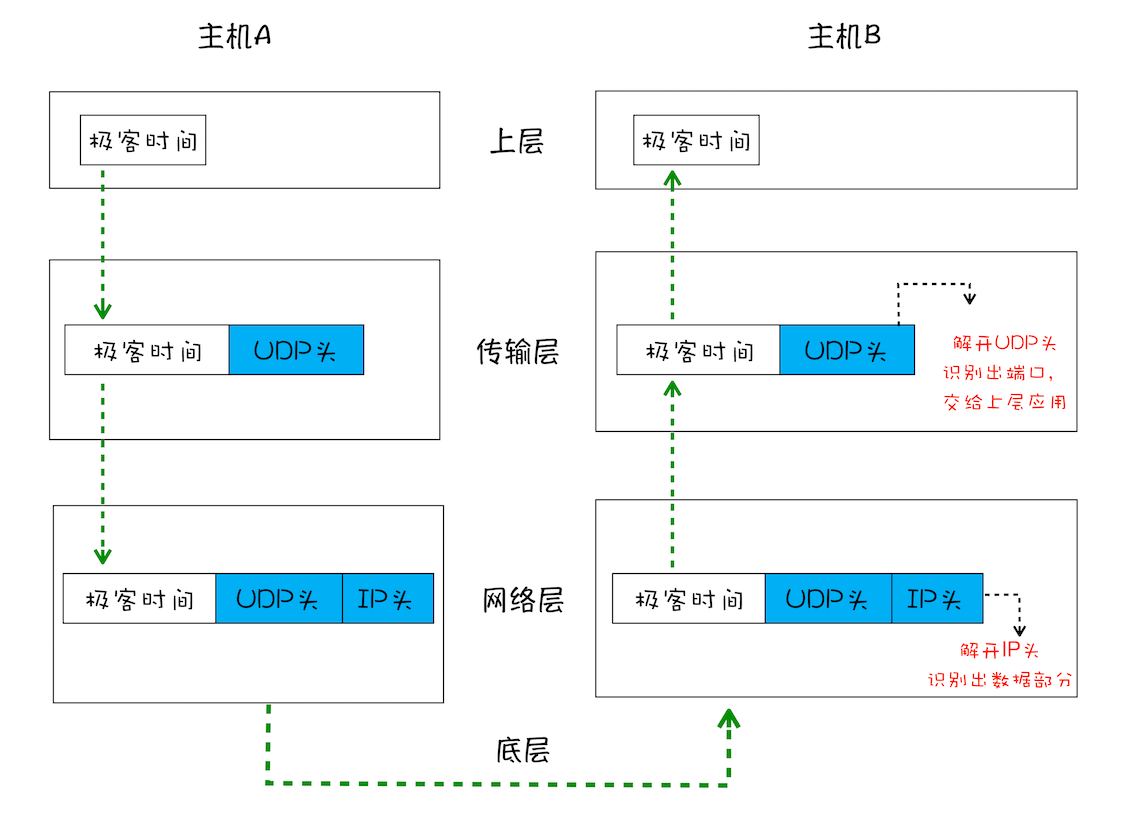

2.UDP:把数据包送达应用程序

IP 是非常底层的协议,只负责把数据包传送到对方电脑,但是对方电脑并不知道把数据包交给哪个程序。因此,需要基于 IP 之上开发能和应用打交道的协议,最常见的是“用户数据包协议(User Datagram Protocol)”,简称 UDP。

UDP 中一个最重要的信息是端口号,端口号其实就是一个数字,每个想访问网络的程序都需要绑定一个端口号。通过端口号 UDP 就能把指定的数据包发送给指定的程序了,所以 IP 通过 IP 地址信息把数据包发送给指定的电脑,而 UDP 通过端口号把数据包分发给正确的程序。和 IP 头一样,端口号会被装进 UDP 头里面,UDP 头再和原始数据包合并组成新的 UDP 数据包。UDP 头中除了目的端口,还有源端口号等信息。

一个数据包从主机 A 旅行到主机 B 的路线:

1、上层将含有“极客时间”的数据包交给传输层;

2、传输层会在数据包前面附加上 UDP 头,组成新的 UDP 数据包,再将新的 UDP 数据包交给网络层;

3、网络层再将 IP 头附加到数据包上,组成新的 IP 数据包,并交给底层;

4、数据包被传输到主机 B 的网络层,在这里主机 B 拆开 IP 头信息,并将拆开来的数据部分交给传输层;

5、在传输层,数据包中的 UDP 头会被拆开,并根据 UDP 中所提供的端口号,把数据部分交给上层的应用程序;

6、最终,含有“极客时间”信息的数据包就旅行到了主机 B 上层应用程序这里。

在使用 UDP 发送数据时,有各种因素会导致数据包出错,虽然 UDP 可以校验数据是否正确,但是对于错误的数据包,UDP 并不提供重发机制,只是丢弃当前的包,而且 UDP 在发送之后也无法知道是否能达到目的地。

虽说 UDP 不能保证数据可靠性,但是传输速度却非常快,所以 UDP 会应用在一些关注速度、但不那么严格要求数据完整性的领域,如在线视频、互动游戏等。

3.TCP:把数据完整地送达应用程序

对于浏览器请求,或者邮件这类要求数据传输可靠性(reliability)的应用,如果使用 UDP 来传输会存在两个问题:

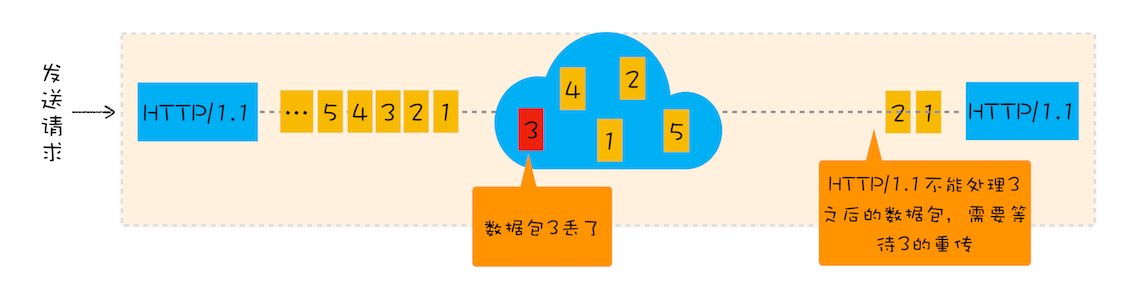

1、数据包在传输过程中容易丢失;

2、大文件会被拆分成很多小的数据包来传输,这些小的数据包会经过不同的路由,并在不同的时间到达接收端,而 UDP 协议并不知道如何组装这些数据包,从而把这些数据包还原成完整的文件。

基于这两个问题,我们引入 TCP 了。TCP(Transmission Control Protocol,传输控制协议)是一种面向连接的、可靠的、基于字节流的传输层通信协议。相对于 UDP,TCP 有下面两个特点:

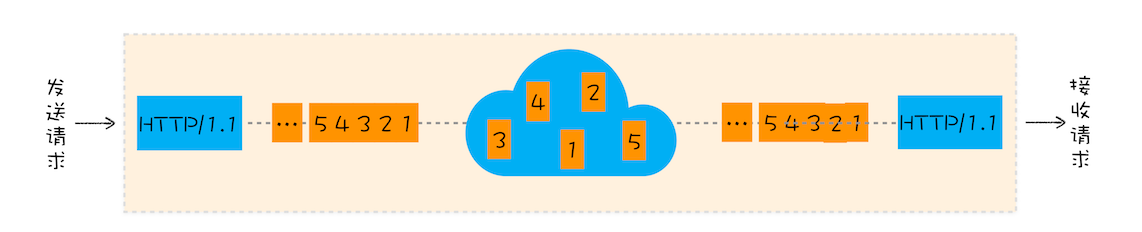

1、对于数据包丢失的情况,TCP 提供重传机制;

2、TCP 引入了数据包排序机制,用来保证把乱序的数据包组合成一个完整的文件。

和 UDP 头一样,TCP 头除了包含了目标端口和本机端口号外,还提供了用于排序的序列号,以便接收端通过序号来重排数据包。

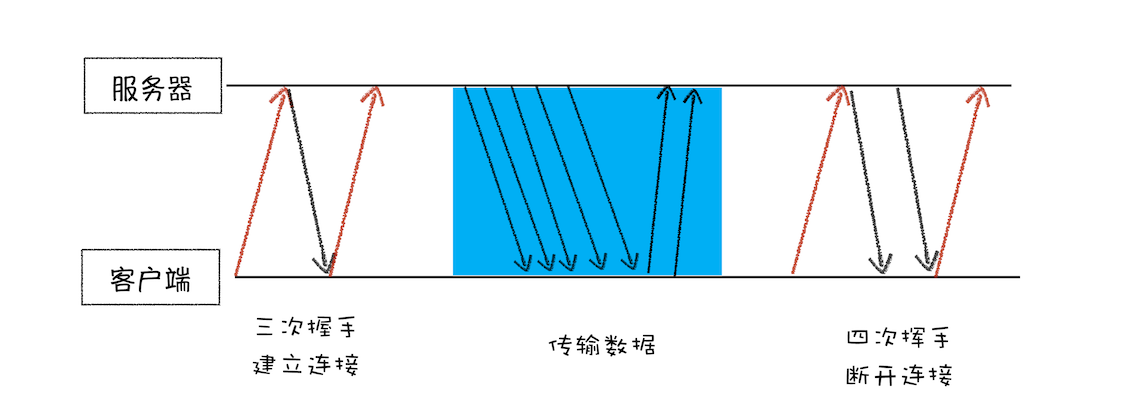

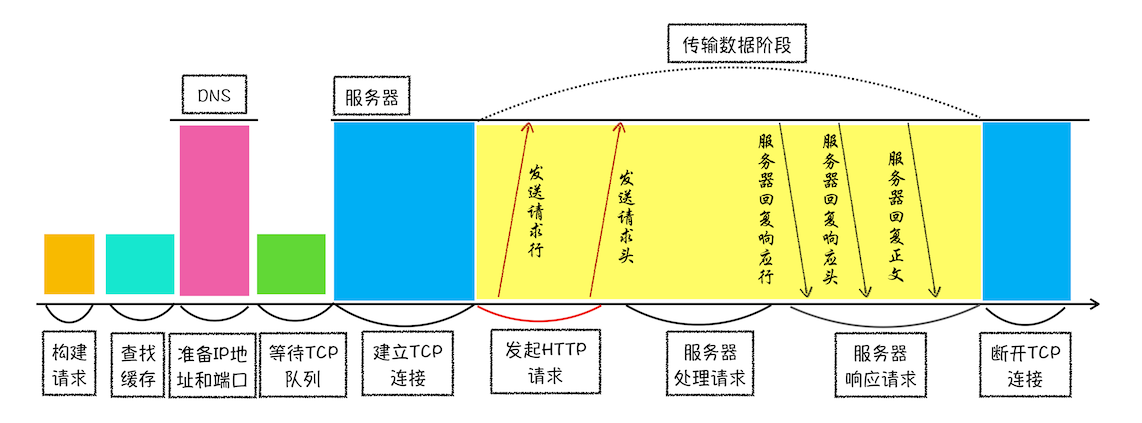

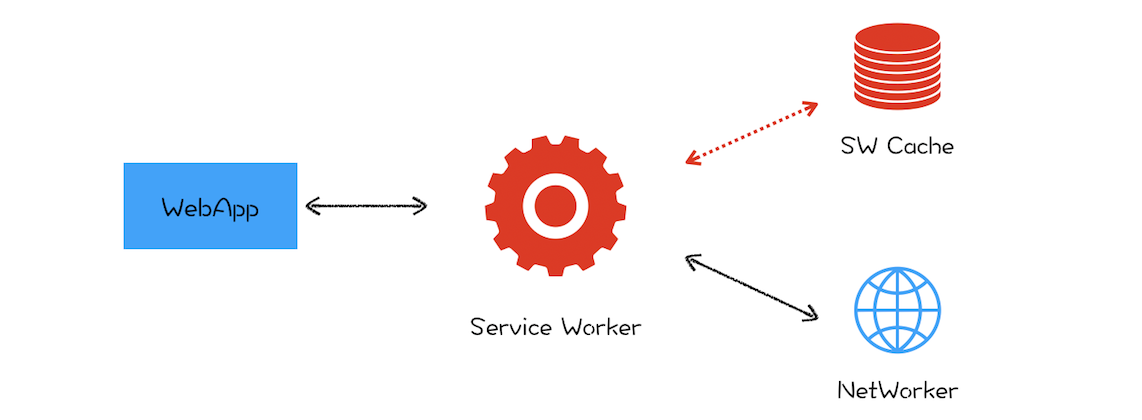

一个完整的 TCP 连接的生命周期包括了“建立连接”“传输数据”和“断开连接”三个阶段。

1、首先,建立连接阶段。这个阶段是通过“三次握手”来建立客户端和服务器之间的连接。TCP 提供面向连接的通信传输。面向连接是指在数据通信开始之前先做好两端之间的准备工作。所谓三次握手,是指在建立一个 TCP 连接时,客户端和服务器总共要发送三个数据包以确认连接的建立。

(第一次:客户端给服务端发送一个带有 SYN 标志的数据包 第二次:服务端给客户端发送带有 SYN 和 ACK 标志得数据包 第三次:客户端给服务端发送带有 ACK 标志的数据包)

2、其次,传输数据阶段。在该阶段,接收端需要对每个数据包进行确认操作,也就是接收端在接收到数据包之后,需要发送确认数据包给发送端。所以当发送端发送了一个数据包之后,在规定时间内没有接收到接收端反馈的确认消息,则判断为数据包丢失,并触发发送端的重发机制。同样,一个大的文件在传输过程中会被拆分成很多小的数据包,这些数据包到达接收端后,接收端会按照 TCP 头中的序号为其排序,从而保证组成完整的数据。

(如果一定时间内没有接收到数据包,会触发发送端的重传机制。等到重传之后才开始渲染。正常渲染是接受到 content-type 请求头开始渲染。 通过四次挥手断开连接。)

3、最后,断开连接阶段。数据传输完毕之后,就要终止连接了,涉及到最后一个阶段“四次挥手”来保证双方都能断开连接。

TCP 为了保证数据传输的可靠性,牺牲了数据包的传输速度,因为“三次握手”和“数据包校验机制”等把传输过程中的数据包的数量提高了一倍。

小结

1.浏览器可以同时打开多个页签,他们端口一样吗?如果一样,数据怎么知道去哪个页签?

端口一样的,网络进程知道每个 tcp 链接所对应的标签是那个,所以接收到数据后,会把数据分发给对应的渲染进程。

2.TCP 传送数据时 浏览器端就做渲染处理了么?如果前面数据包丢了 后面数据包先来是要等么?类似的那种实时渲染怎么处理?针对数据包的顺序性?

接收到 http 响应头中的 content-type 类型时就开始准备渲染进程了,响应体数据一旦接受到便开始做 DOM 解析了!基于 http 不用担心数据包丢失的问题,因为丢包和重传都是在 tcp 层解决的。http 能保证数据按照顺序接收的(也就是说,从 tcp 到 http 的数据就已经是完整的了,即便是实时渲染,如果发生丢包也得在重传后才能开始渲染)

3.http 和 websocket 都是属于应用层的协议吗?

都是应用层协议,而且 websocket 名字取的比较有迷惑性,其实和 socket 完全不一样,可以把 websocket 看出是 http 的改造版本,增加了服务器向客户端主动发送消息的能力。

4.关于 "数据在传输的过程中有可能会丢失或者出错",丢失的数据包去哪里了?凭空消失了吗?出错的数据包又变成啥了? 为什么会出错?

比如网络波动,物理线路故障,设备故障,恶意程序拦截,网络阻塞等等

一个包从源出发可能经过:交换机、家庭或公司网关出口、防火墙、运营商网络、目的地网关、防火墙、 交换机、到达目的地,在每一跳 packet 所途径的设备上有可能在二层被丢弃,Frame 直接被接收端网络 接口直接丢弃:

Frame CRC error

Frame overrun

Baby Jumbo Frame Size > Receiving Peer MRU

Jumbo Frame Size > Receiving Peer MRU

也有可能在三层上被丢弃:

IP TTL expired

IP Checksum error

Destination Unreachable

IP Packet (DF=1) > Outgoing MTU

ACL blocked

NAT Entry Non existed

也可能在路由器入口/出口 由于 buffer 满而尾丢:

input queue discard

output queue tail discard

也可能由于路由器、交换机 QoS policy 丢:

QoS police discard

也可能是因为到达目的地主机,但是

IP Reassemble 失败而被丢(Fragmented Packet Lost)

UDP/TCP/ICMP FCS error 被丢

Receive buffer 满而被丢

当设备决定 discard 某个特定的包时,只是把这个包所占用的 buffer 标志成可用状态,即可 override

HTTP 请求流程

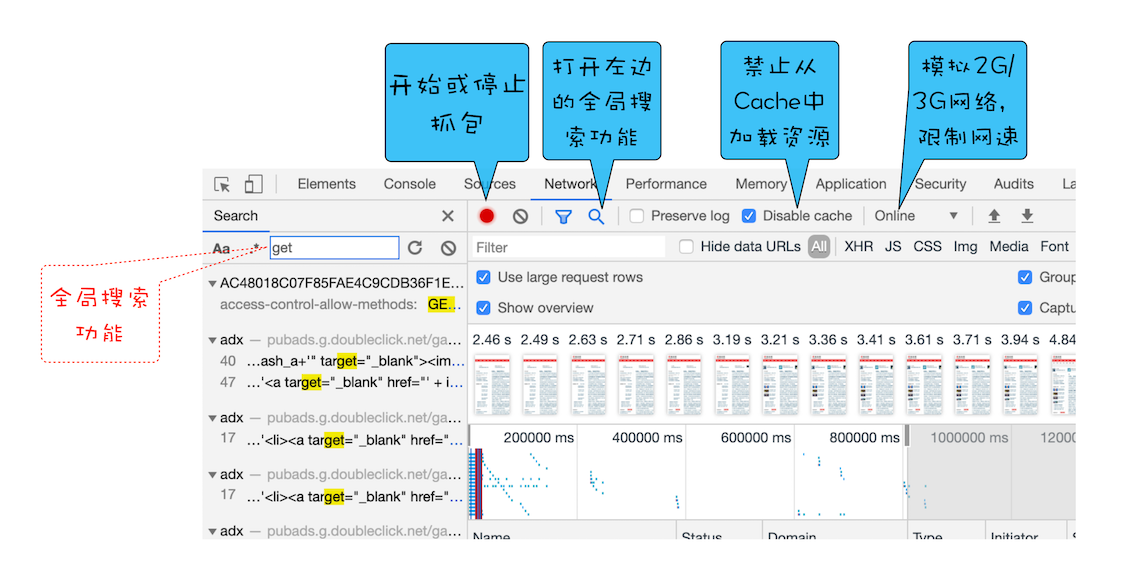

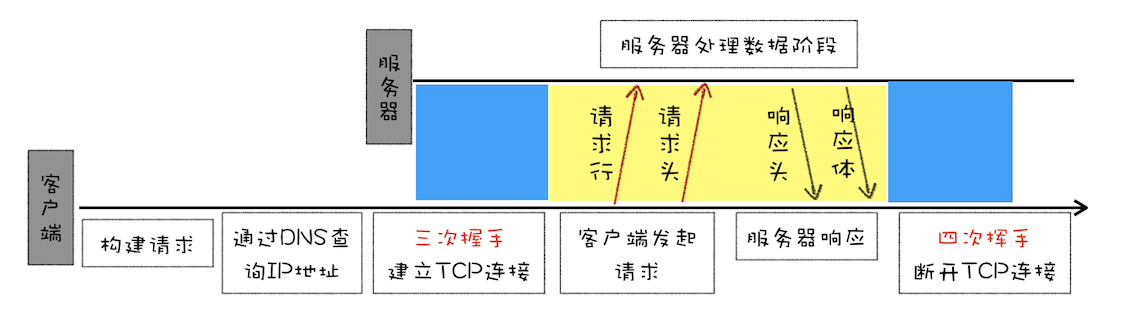

浏览器端发起 HTTP 请求流程

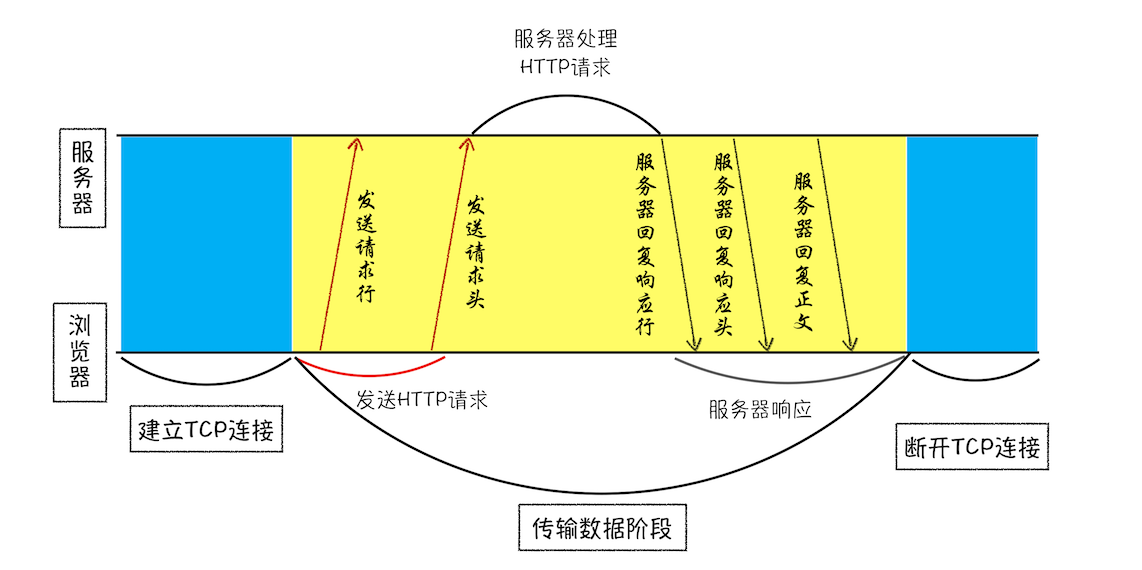

HTTP 协议,正是建立在 TCP 连接基础之上的。HTTP 是一种允许浏览器向服务器获取资源的协议,是 Web 的基础,通常由浏览器发起请求,用来获取不同类型的文件,例如 HTML 文件、CSS 文件、JavaScript 文件、图片、视频等。此外,HTTP 也是浏览器使用最广的协议

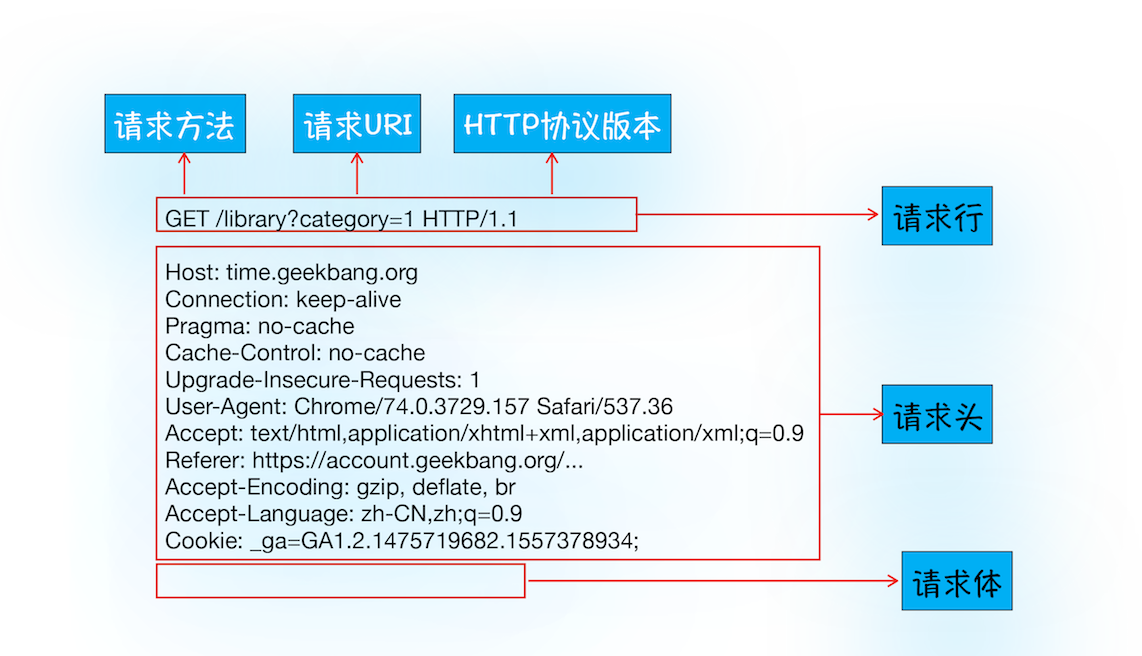

1、构建请求

首先,浏览器构建请求行信息(如下所示),构建好后,浏览器准备发起网络请求。

GET /index.html HTTP1.12、查找缓存

在真正发起网络请求之前,浏览器会先在浏览器缓存中查询是否有要请求的文件。其中,浏览器缓存是一种在本地保存资源副本,以供下次请求时直接使用的技术。

当浏览器发现请求的资源已经在浏览器缓存中存有副本,它会拦截请求,返回该资源的副本,并直接结束请求,而不会再去源服务器重新下载。

这样做的好处有:

1、缓解服务器端压力,提升性能(获取资源的耗时更短了);

2、对于网站来说,缓存是实现快速资源加载的重要组成部分。

当然,如果缓存查找失败,就会进入网络请求过程了。

3、 准备 IP 地址和端口

因为浏览器使用HTTP 协议作为应用层协议,用来封装请求的文本信息;并使用TCP/IP 作传输层协议将它发到网络上,所以在 HTTP 工作开始之前,浏览器需要通过 TCP 与服务器建立连接。也就是说HTTP 的内容是通过 TCP 的传输数据阶段来实现的

负责把域名和 IP 地址做一一映射关系。这套域名映射为 IP 的系统就叫做“域名系统”,简称DNS(Domain Name System)

浏览器会请求 DNS 返回域名对应的 IP。当然浏览器还提供了 DNS 数据缓存服务,如果某个域名已经解析过了,那么浏览器会缓存解析的结果,以供下次查询时直接使用,这样也会减少一次网络请求

通常情况下,如果 URL 没有特别指明端口号,那么 HTTP 协议默认是 80 端口

4、等待 TCP 队列

Chrome 有个机制,同一个域名同时最多只能建立 6 个 TCP 连接,如果在同一个域名下同时有 10 个请求发生,那么其中 4 个请求会进入排队等待状态,直至进行中的请求完成

当然,如果当前请求数量少于 6,会直接进入下一步,建立 TCP 连接

5、建立 TCP 连接

排队等待结束之后,终于可以快乐地和服务器握手了,在 HTTP 工作开始之前,浏览器通过 TCP 与服务器建立连接

6、发送 HTTP 请求

一旦建立了 TCP 连接,浏览器就可以和服务器进行通信了。而 HTTP 中的数据正是在这个通信过程中传输的

1、首先浏览器会向服务器发送请求行,它包括了请求方法、请求 URI(Uniform Resource Identifier)和 HTTP 版本协议,发送请求行,就是告诉服务器浏览器需要什么资源

另外一个常用的请求方法是 POST,它用于发送一些数据给服务器,比如登录一个网站,就需要通过 POST 方法把用户信息发送给服务器。如果使用 POST 方法,那么浏览器还要准备数据给服务器,这里准备的数据是通过请求体来发送

2、在浏览器发送请求行命令之后,还要以请求头形式发送其他一些信息,把浏览器的一些基础信息告诉服务器。比如包含了浏览器所使用的操作系统、浏览器内核等信息,以及当前请求的域名信息、浏览器端的 Cookie 信息,等等

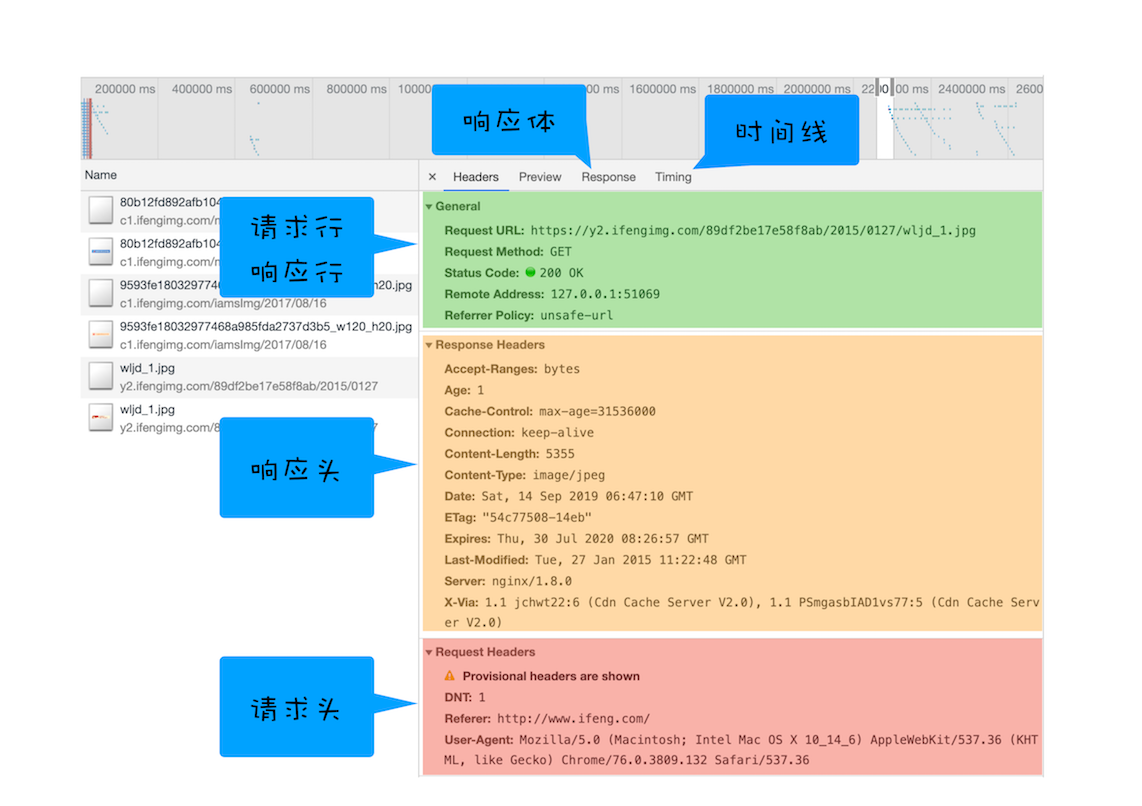

服务器端处理 HTTP 请求流程

1、返回请求

一旦服务器处理结束,便可以返回数据给浏览器了。你可以通过工具软件 curl 来查看返回请求数据,具体使用方法是在命令行中输入以下命令:

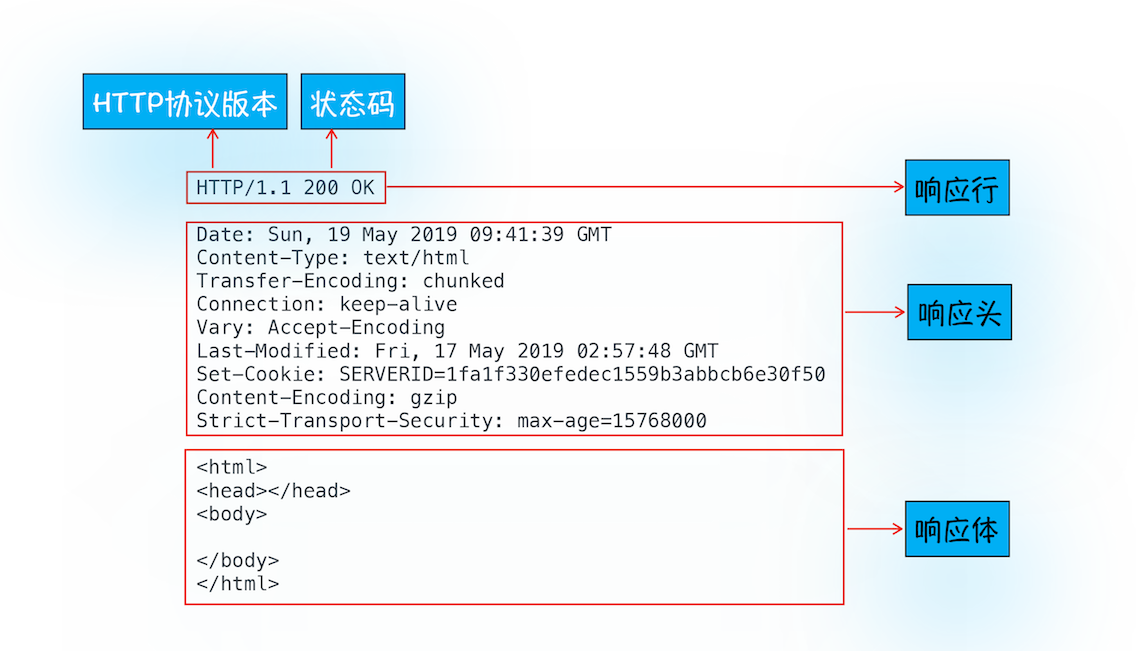

curl -i https://time.geekbang.org/注意这里加上了-i 是为了返回响应行、响应头和响应体的数据,返回的结果如下图所示,你可以结合这些数据来理解服务器是如何响应浏览器的

1、首先服务器会返回响应行,包括协议版本和状态码

但并不是所有的请求都可以被服务器处理的

一些无法处理或者处理出错的信息,服务器会通过请求行的状态码来告诉浏览器它的处理结果

2、随后,正如浏览器会随同请求发送请求头一样,服务器也会随同响应向浏览器发送响应头。响应头包含了服务器自身的一些信息,比如服务器生成返回数据的时间、返回的数据类型(JSON、HTML、流媒体等类型),以及服务器要在客户端保存的 Cookie 等信息

3、发送完响应头后,服务器就可以继续发送响应体的数据,通常,响应体就包含了 HTML 的实际内容

2、断开连接

通常情况下,一旦服务器向客户端返回了请求数据,它就要关闭 TCP 连接。不过如果浏览器或者服务器在其头信息中加入了:

Connection: Keep - Alive;那么 TCP 连接在发送后将仍然保持打开状态,这样浏览器就可以继续通过同一个 TCP 连接发送请求。保持 TCP 连接可以省去下次请求时需要建立连接的时间,提升资源加载速度。比如,一个 Web 页面中内嵌的图片就都来自同一个 Web 站点,如果初始化了一个持久连接,你就可以复用该连接,以请求其他资源,而不需要重新再建立新的 TCP 连接

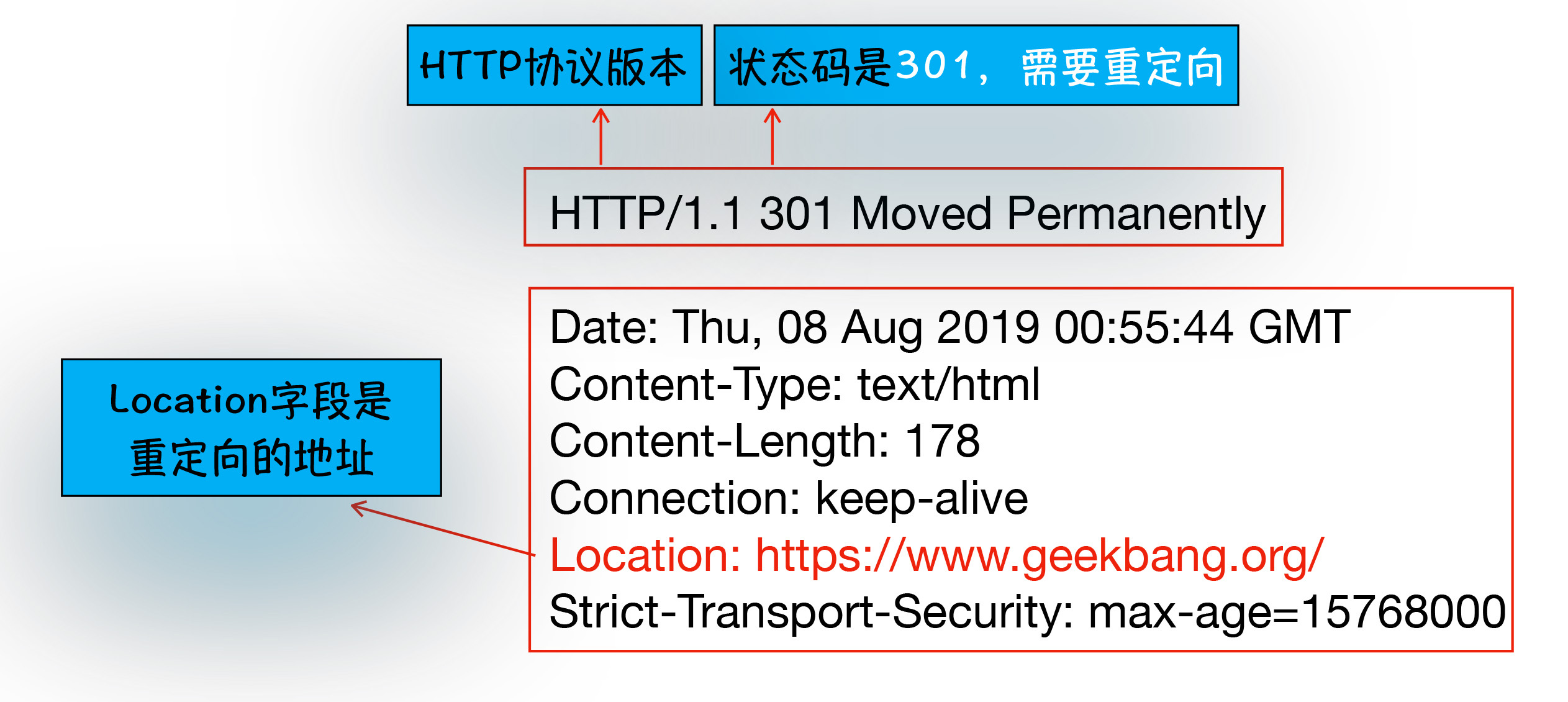

3、重定向

还有一种情况你需要了解下,比如当你在浏览器中打开 geekbang.org 后,你会发现最终打开的页面地址是 https://www.geekbang.org

这两个 URL 之所以不一样,是因为涉及到了一个重定向操作

跟前面一样,你依然可以使用 curl 来查看下请求 geekbang.org 会返回什么内容:

curl -I geekbang.org注意这里输入的参数是-I,和-i 不一样,-I 表示只需要获取响应头和响应行数据,而不需要获取响应体的数据,最终返回的数据如下图所示:

从图中你可以看到,响应行返回的状态码是 301,状态 301 就是告诉浏览器,我需要重定向到另外一个网址,而需要重定向的网址正是包含在响应头的 Location 字段中,接下来,浏览器获取 Location 字段中的地址,并使用该地址重新导航,这就是一个完整重定向的执行流程。这也就解释了为什么输入的是 geekbang.org,最终打开的却是 https://www.geekbang.org 了。

小结

1、为什么很多站点第二次打开速度会很快?

主要原因是第一次加载页面过程中,缓存了一些耗时的数据

DNS 缓存和页面资源缓存这两块数据是会被浏览器缓存的

其中,DNS 缓存比较简单,它主要就是在浏览器本地把对应的 IP 和域名关联起来

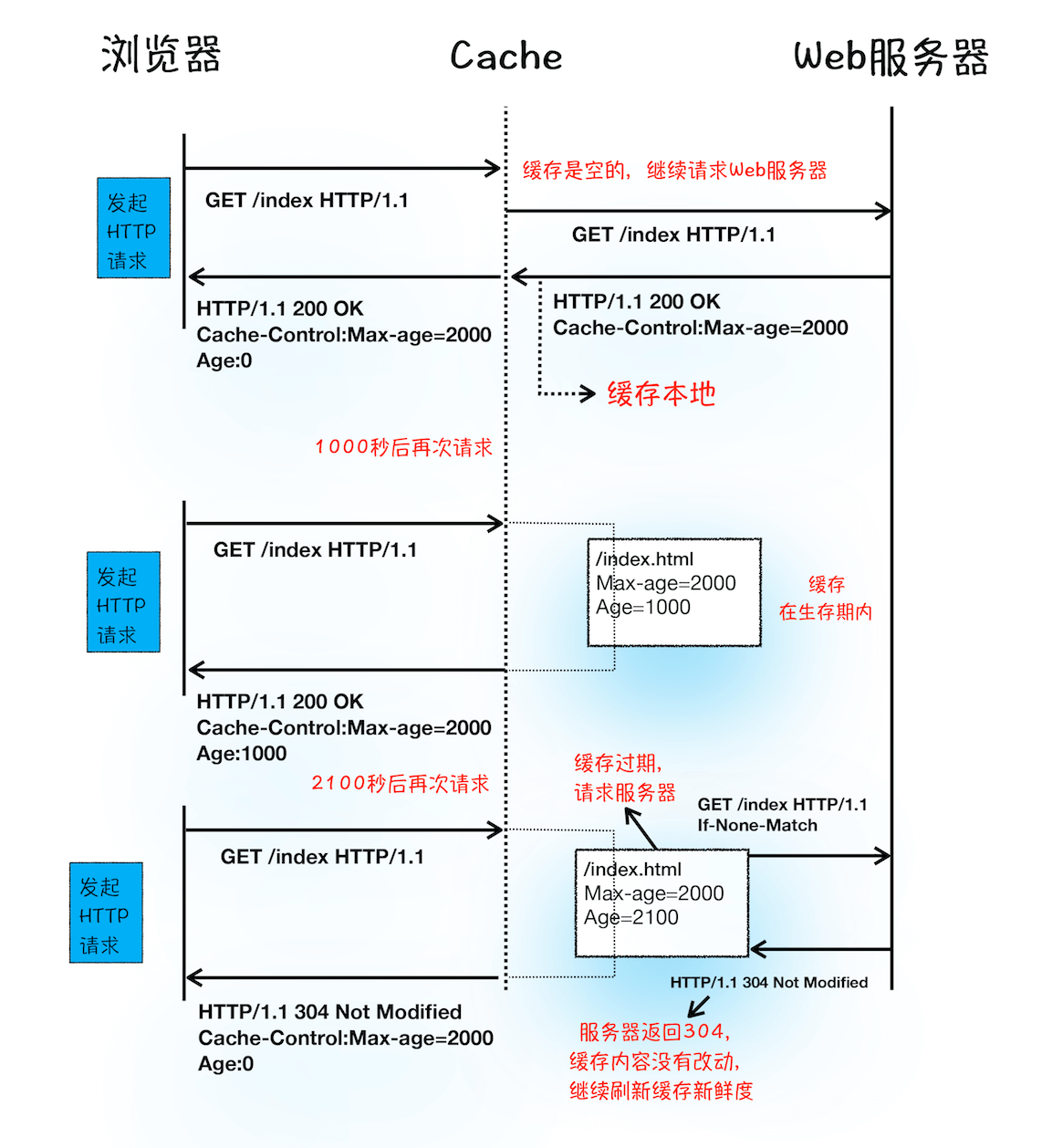

我们重点看下浏览器资源缓存,下面是缓存处理的过程:

从上图的第一次请求可以看出,当服务器返回HTTP 响应头给浏览器时,浏览器是通过响应头中的 Cache-Control 字段来设置是否缓存该资源。通常,我们还需要为这个资源设置一个缓存过期时长,而这个时长是通过 Cache-Control 中的 Max-age 参数来设置的,比如上图设置的缓存过期时间是 2000 秒。

Cache-Control:Max-age=2000这也就意味着,在该缓存资源还未过期的情况下, 如果再次请求该资源,会直接返回缓存中的资源给浏览器。

但如果缓存过期了,浏览器则会继续发起网络请求,并且在 HTTP 请求头中带上:

If-None-Match:"4f80f-13c-3a1xb12a"服务器收到请求头后,会根据 If-None-Match 的值来判断请求的资源是否有更新。

如果没有更新,就返回 304 状态码,相当于服务器告诉浏览器:“这个缓存可以继续使用,这次就不重复发送数据给你了。”

如果资源有更新,服务器就直接返回最新资源给浏览器。

简要来说,很多网站第二次访问能够秒开,是因为这些网站把很多资源都缓存在了本地,浏览器缓存直接使用本地副本来回应请求,而不会产生真实的网络请求,从而节省了时间。同时,DNS 数据也被浏览器缓存了,这又省去了 DNS 查询环节

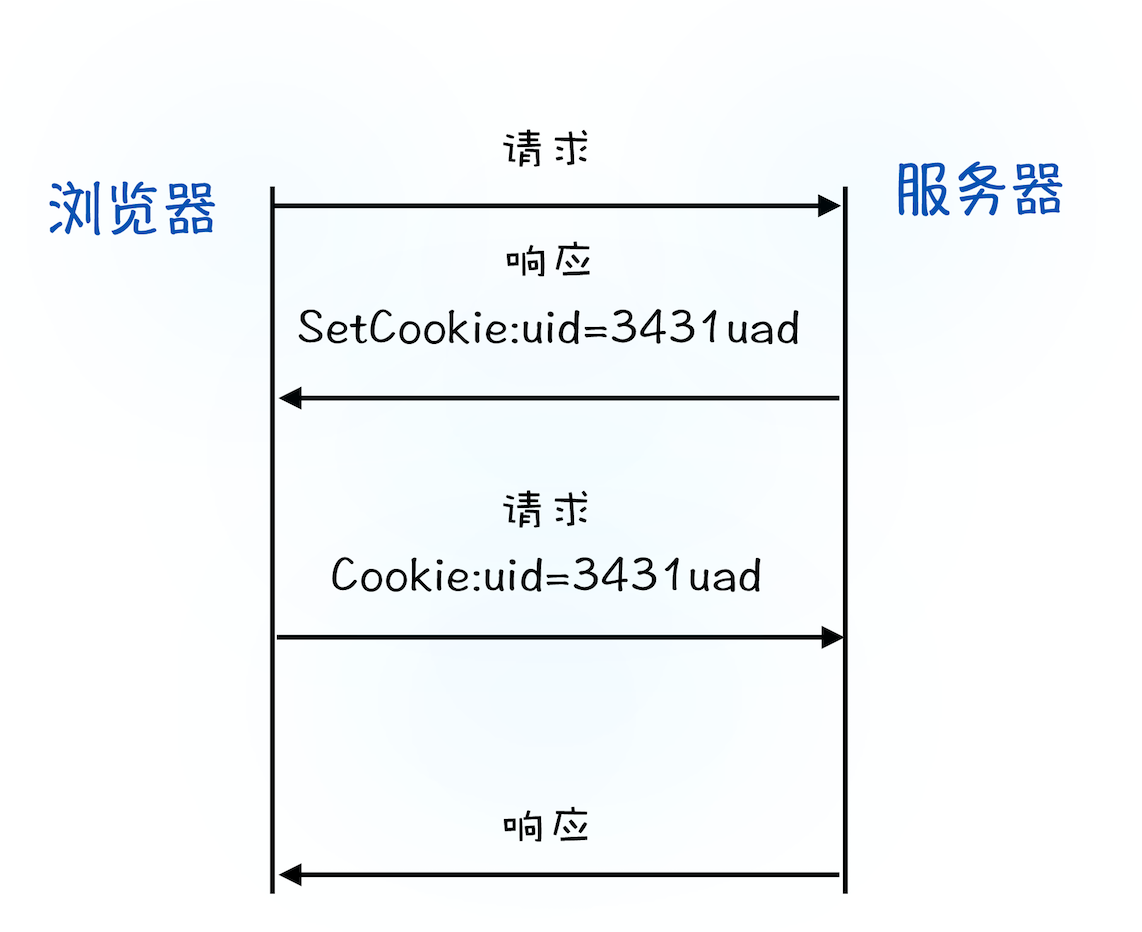

2、登录状态是如何保持的?

1、用户打开登录页面,在登录框里填入用户名和密码,点击确定按钮。点击按钮会触发页面脚本生成用户登录信息,然后调用 POST 方法提交用户登录信息给服务器。

2、服务器接收到浏览器提交的信息之后,查询后台,验证用户登录信息是否正确,如果正确的话,会生成一段表示用户身份的字符串,并把该字符串写到响应头的 Set-Cookie 字段里,如下所示,然后把响应头发送给浏览器。

Set-Cookie: UID=3431uad;3、浏览器在接收到服务器的响应头后,开始解析响应头,如果遇到响应头里含有 Set-Cookie 字段的情况,浏览器就会把这个字段信息保存到本地。比如把 UID=3431uad 保持到本地。

4、当用户再次访问时,浏览器会发起 HTTP 请求,但在发起请求之前,浏览器会读取之前保存的 Cookie 数据,并把数据写进请求头里的 Cookie 字段里(如下所示),然后浏览器再将请求头发送给服务器。

Cookie: UID=3431uad;5、服务器在收到 HTTP 请求头数据之后,就会查找请求头里面的“Cookie”字段信息,当查找到包含 UID=3431uad 的信息时,服务器查询后台,并判断该用户是已登录状态,然后生成含有该用户信息的页面数据,并把生成的数据发送给浏览器。

6、浏览器在接收到该含有当前用户的页面数据后,就可以正确展示用户登录的状态信息了。

Cookie 流程可以参考下图:

简单地说,如果服务器端发送的响应头内有 Set-Cookie 的字段,那么浏览器就会将该字段的内容保持到本地。当下次客户端再往该服务器发送请求时,客户端会自动在请求头中加入 Cookie 值后再发送出去。服务器端发现客户端发送过来的 Cookie 后,会去检查究竟是从哪一个客户端发来的连接请求,然后对比服务器上的记录,最后得到该用户的状态信息

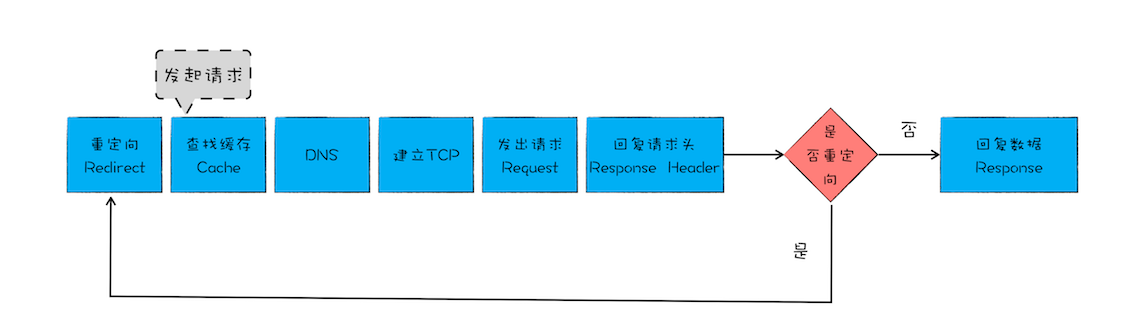

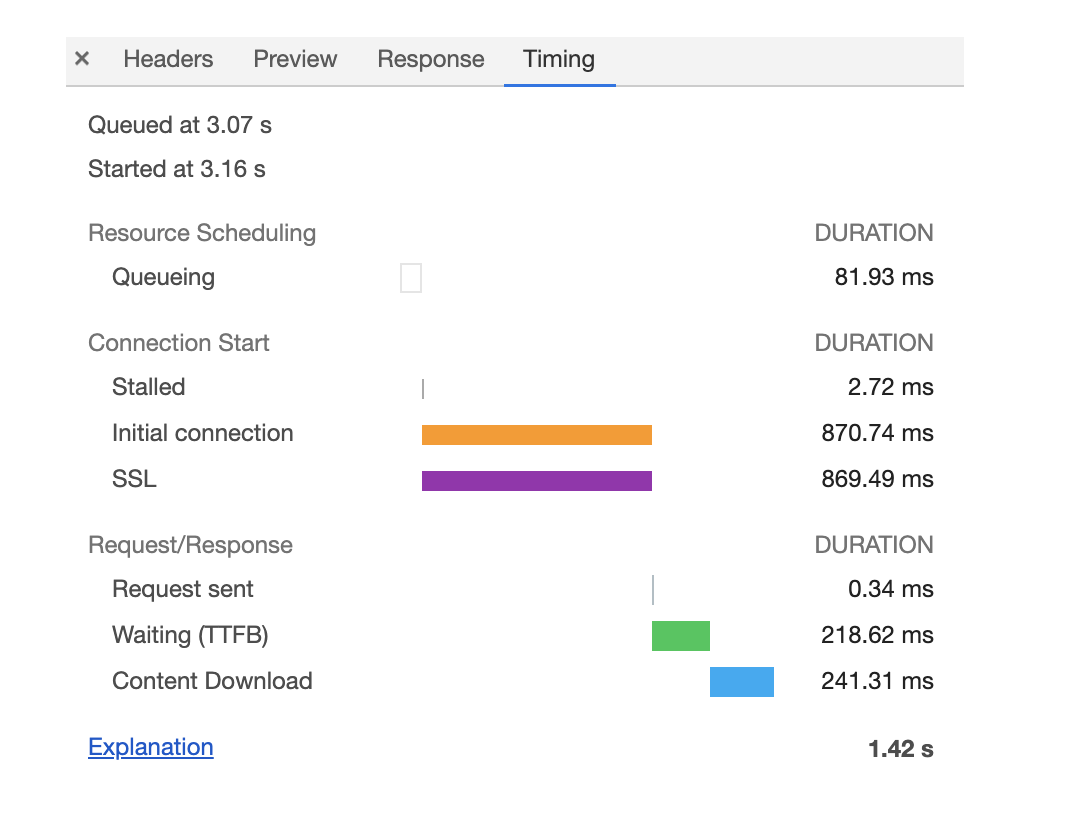

浏览器中的 HTTP 请求所经历的各个阶段

浏览器中的 HTTP 请求从发起到结束一共经历了如下八个阶段:构建请求、查找缓存、准备 IP 和端口、等待 TCP 队列、建立 TCP 连接、发起 HTTP 请求、服务器处理请求、服务器返回请求和断开连接

3、在浏览器中访问的时候打开 network 面板,发现缓存的来源有的 from disk 有的是 from memory。对于资源什么情况下缓存到硬盘什么时候缓存到内存?

这是浏览器的三级缓存机制,使用 memory cache 比 disk cache 的访问速度要快,还有另外一种 cache,是 service worker 的 cache

disk:新 tab 打开时,都是 disk

4、同一个域名下 6 个 tcp 连接怎么维护?

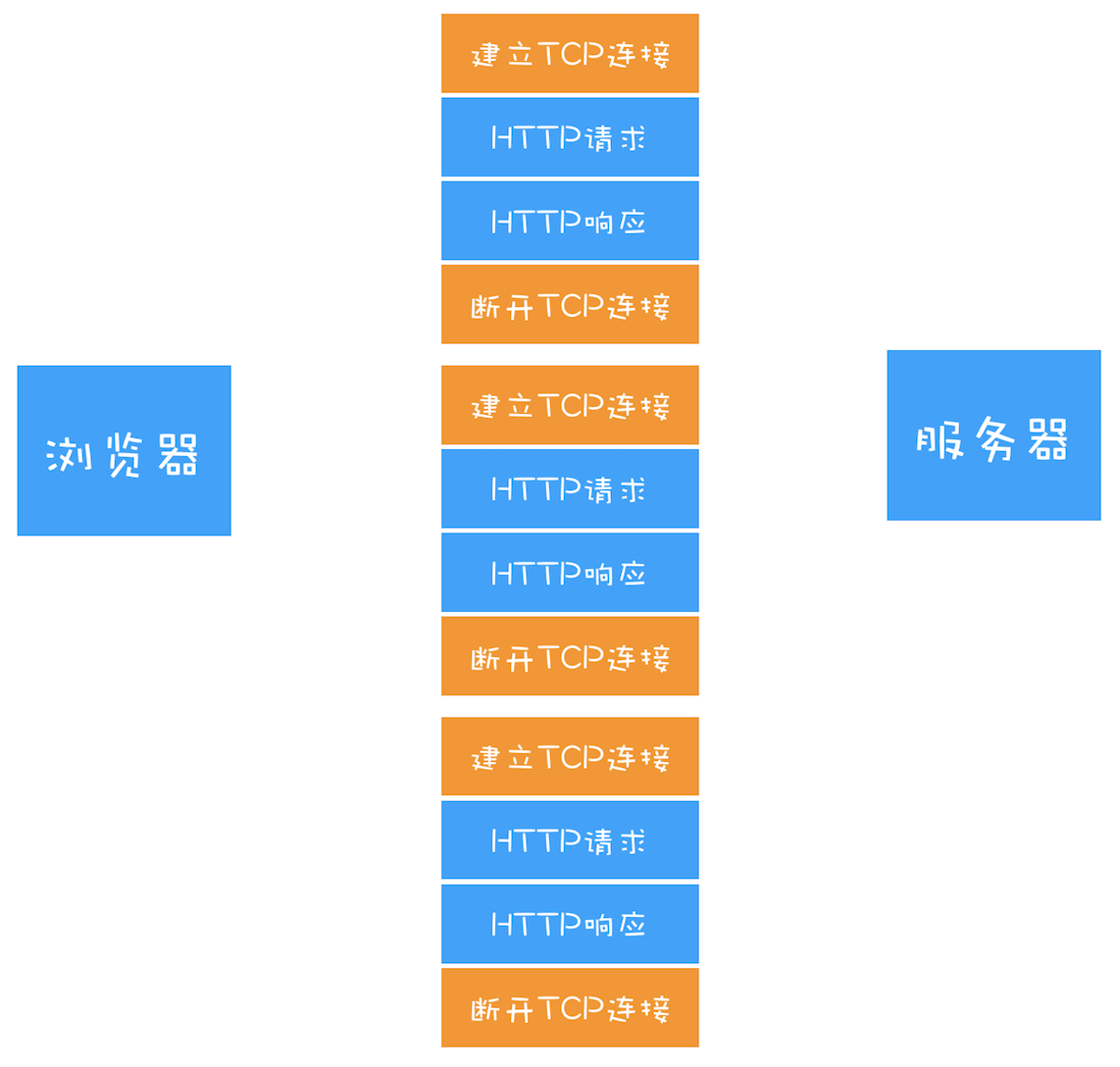

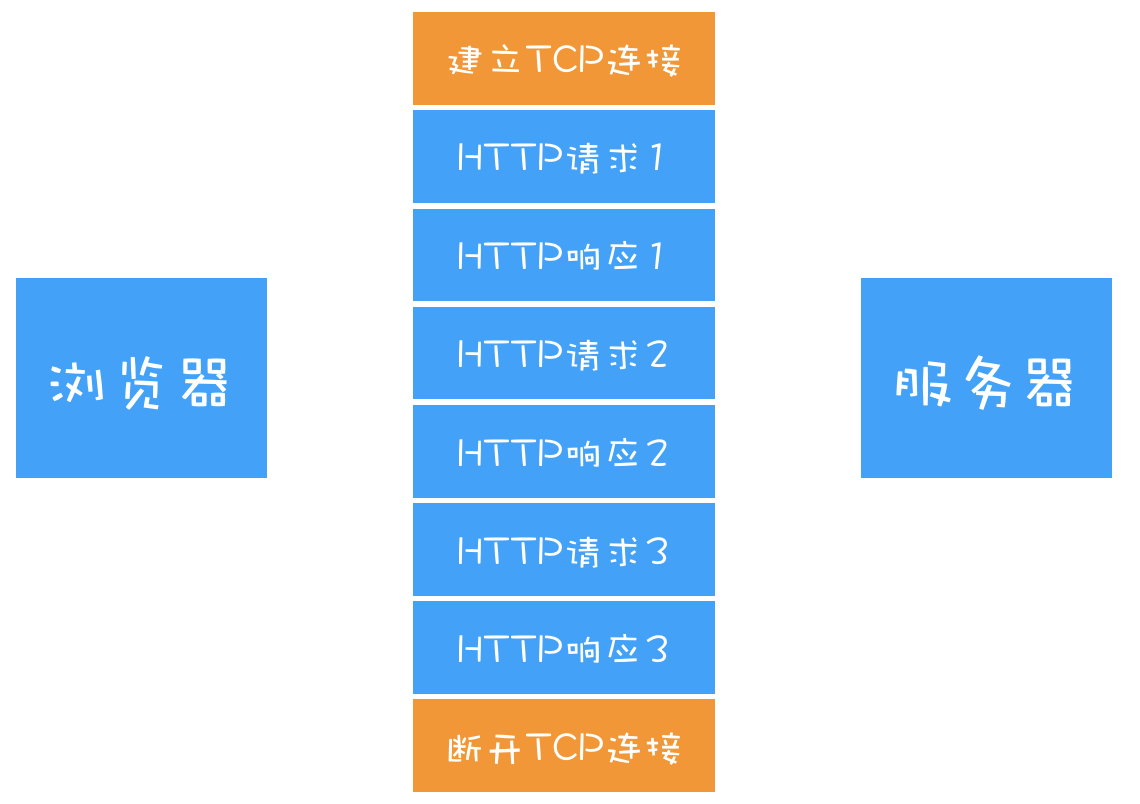

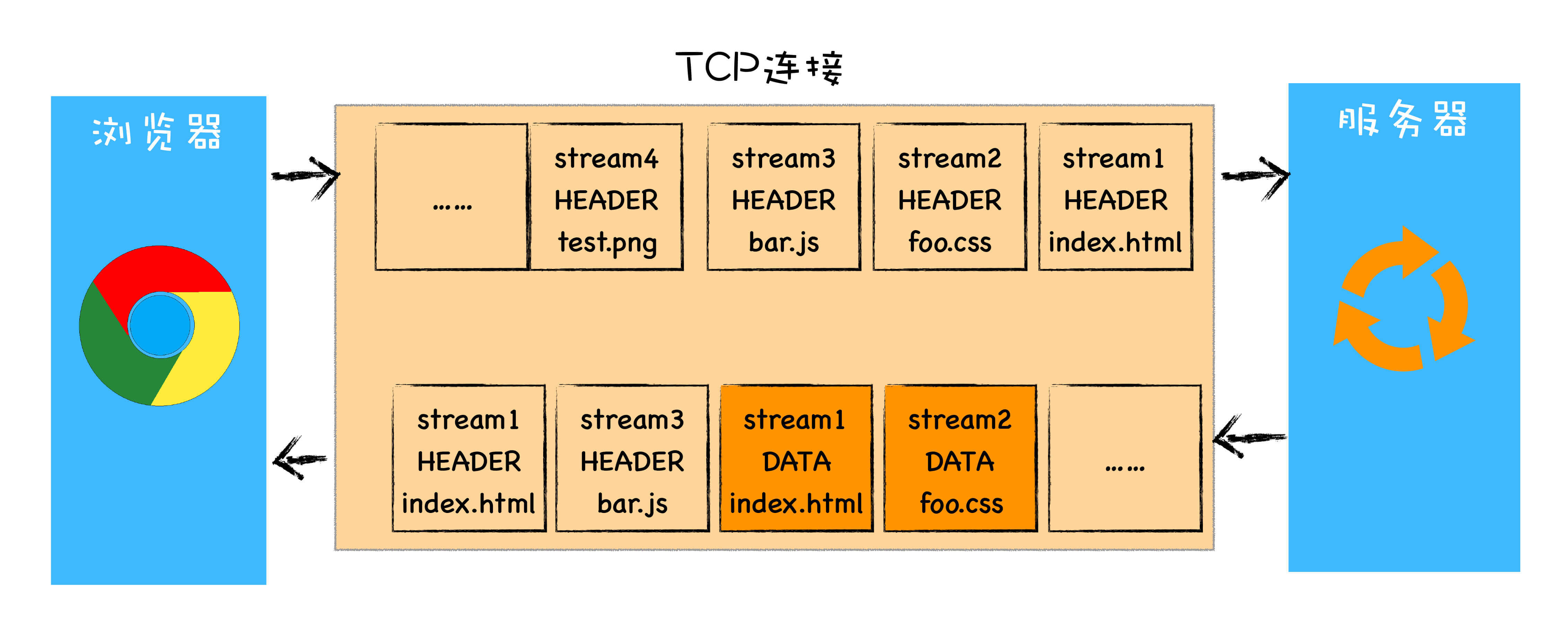

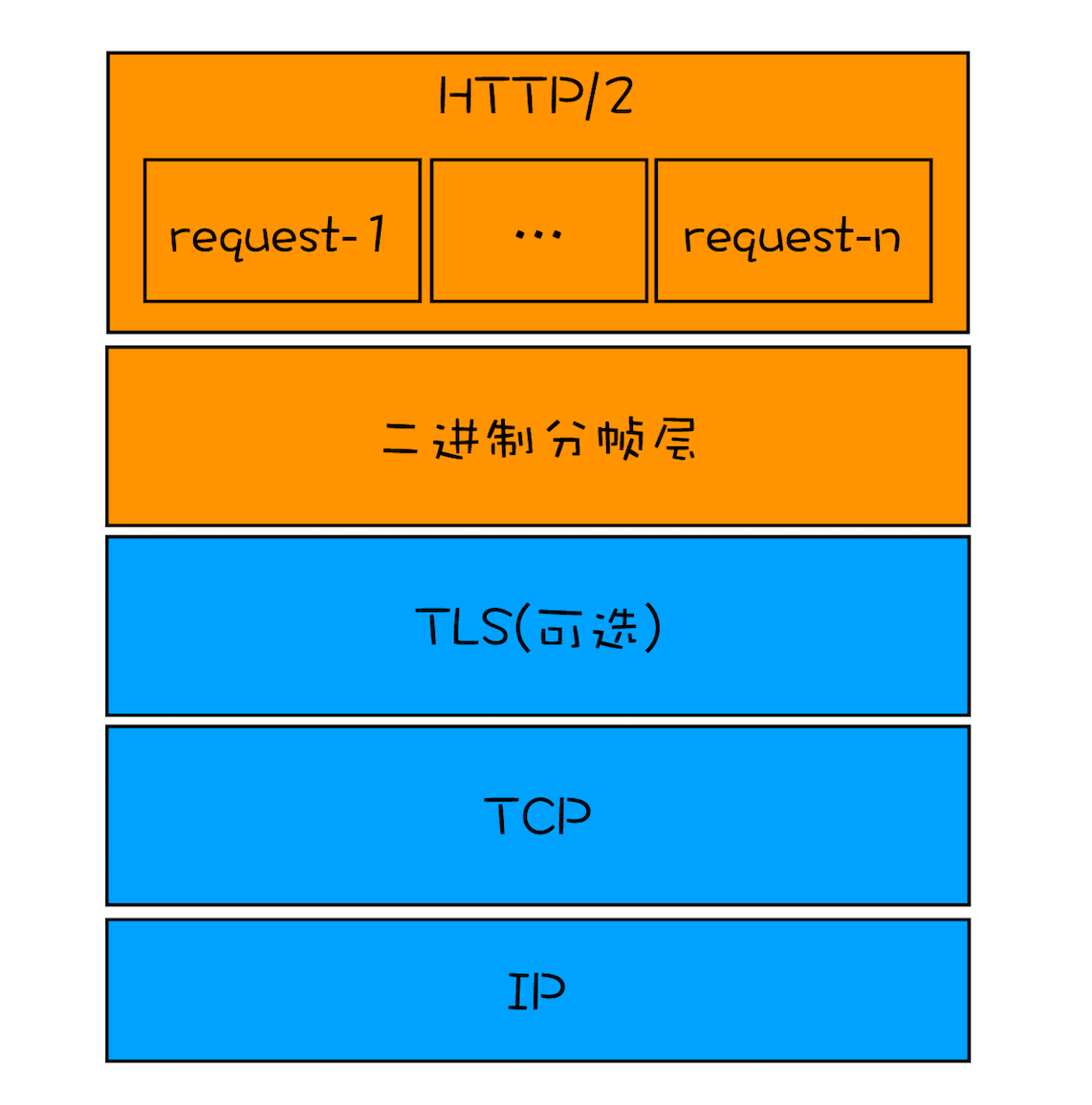

http/1.1 一个 tcp 同时只能处理一个请求,浏览器会为每个域名维护 6 个 tcp 连接!

但是每个 tcp 连接是可以复用的,也就是处理完一个请求之后,不断开这个 tcp 连接,可以用来处理下个 http 请求!

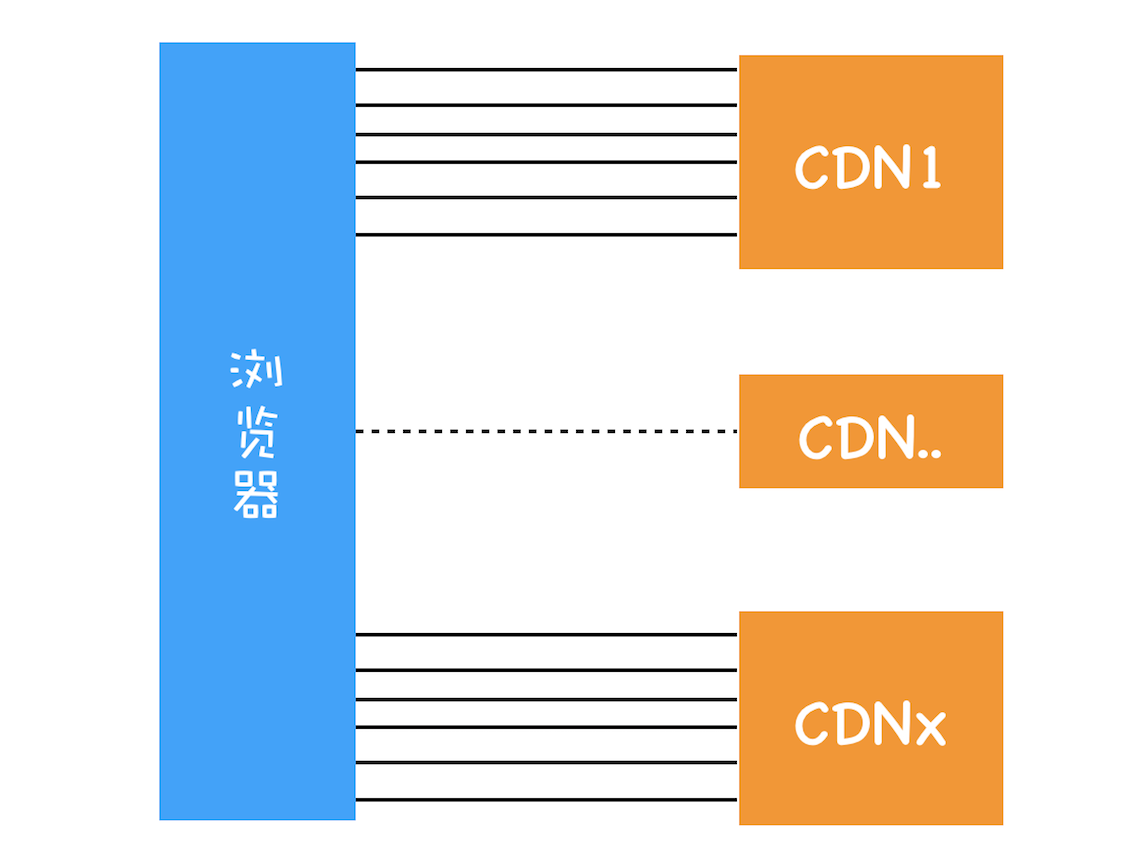

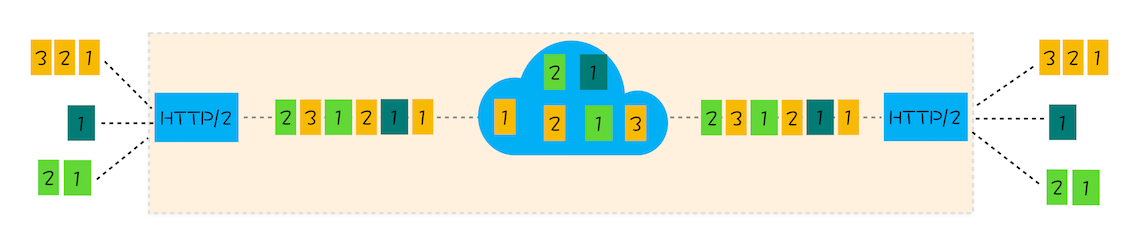

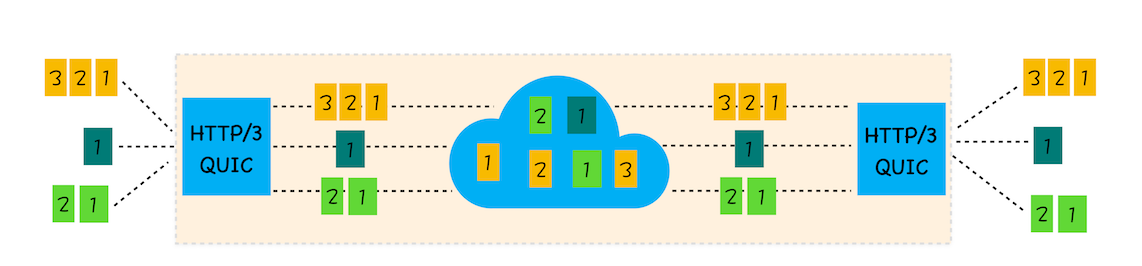

不过 http2 是可以并行请求资源的,所以如果使用 http2,浏览器只会为每个域名维护一个 tcp 连接

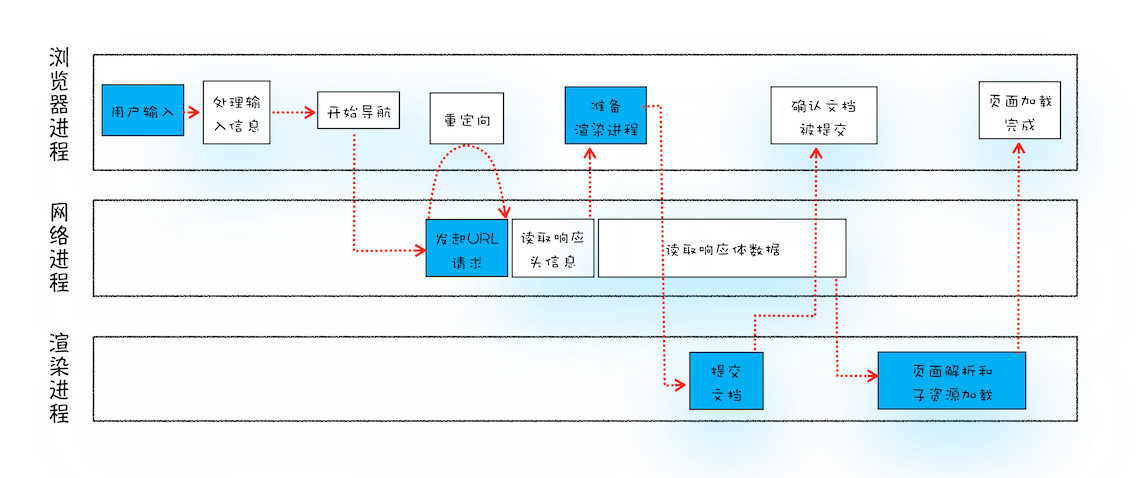

导航流程

从输入 URL 到页面展示完整流程示意图:

整个过程需要各个进程之间的配合:

浏览器进程主要负责用户交互、子进程管理和文件储存等功能。

网络进程是面向渲染进程和浏览器进程等提供网络下载功能。

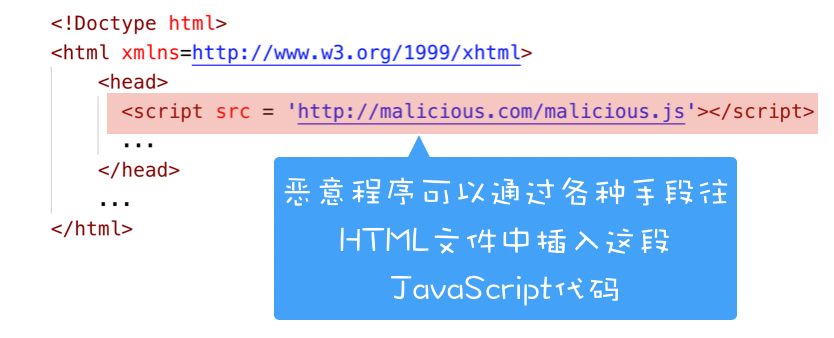

渲染进程的主要职责是把从网络下载的 HTML、JavaScript、CSS、图片等资源解析为可以显示和交互的页面。因为渲染进程所有的内容都是通过网络获取的,会存在一些恶意代码利用浏览器漏洞对系统进行攻击,所以运行在渲染进程里面的代码是不被信任的。这也是为什么 Chrome 会让渲染进程运行在安全沙箱里,就是为了保证系统的安全

导航流程:

首先,浏览器进程接收到用户输入的 URL 请求,浏览器进程便将该 URL 转发给网络进程。

然后,在网络进程中发起真正的 URL 请求。

接着网络进程接收到了响应头数据,便解析响应头数据,并将数据转发给浏览器进程。

浏览器进程接收到网络进程的响应头数据之后,发送“提交导航 (CommitNavigation)”消息到渲染进程;

渲染进程接收到“提交导航”的消息之后,便开始准备接收 HTML 数据,接收数据的方式是直接和网络进程建立数据管道;

最后渲染进程会向浏览器进程“确认提交”,这是告诉浏览器进程:“已经准备好接受和解析页面数据了”。

浏览器进程接收到渲染进程“提交文档”的消息之后,便开始移除之前旧的文档,然后更新浏览器进程中的页面状态。

这其中,用户发出 URL 请求到页面开始解析的这个过程,就叫做导航

从输入 URL 到页面展示

1、用户输入

当用户在地址栏中输入一个查询关键字时,地址栏会判断输入的关键字是搜索内容,还是请求的 URL。

如果是搜索内容,地址栏会使用浏览器默认的搜索引擎,来合成新的带搜索关键字的 URL。

如果判断输入内容符合 URL 规则,比如输入的是 time.geekbang.org,那么地址栏会根据规则,把这段内容加上协议,合成为完整的 URL,如 https://time.geekbang.org。

当用户输入关键字并键入回车之后,这意味着当前页面即将要被替换成新的页面,不过在这个流程继续之前,浏览器还给了当前页面一次执行 beforeunload 事件的机会,beforeunload 事件允许页面在退出之前执行一些数据清理操作,还可以询问用户是否要离开当前页面,比如当前页面可能有未提交完成的表单等情况,因此用户可以通过 beforeunload 事件来取消导航,让浏览器不再执行任何后续工作

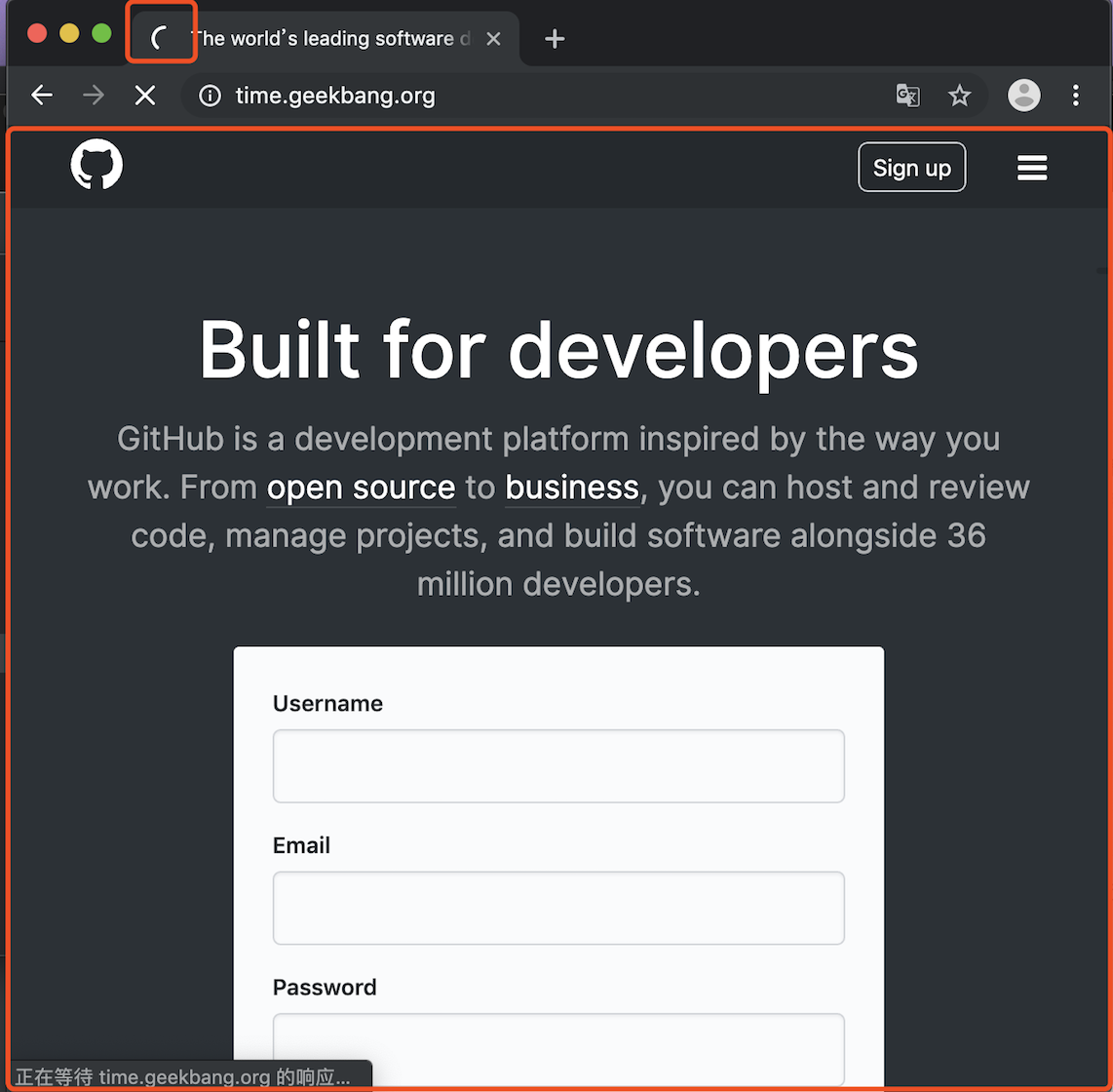

当前页面没有监听 beforeunload 事件或者同意了继续后续流程,那么浏览器便进入下图的状态:

从图中可以看出,当浏览器刚开始加载一个地址之后,标签页上的图标便进入了加载状态。但此时图中页面显示的依然是之前打开的页面内容,并没立即替换为极客时间的页面。因为需要等待提交文档阶段,页面内容才会被替换

2、URL 请求过程

接下来,便进入了页面资源请求过程。这时,浏览器进程会通过进程间通信(IPC)把 URL 请求发送至网络进程,网络进程接收到 URL 请求后,会在这里发起真正的 URL 请求流程

首先,网络进程会查找本地缓存是否缓存了该资源。如果有缓存资源,那么直接返回资源给浏览器进程;如果在缓存中没有查找到资源,那么直接进入网络请求流程。这请求前的第一步是要进行 DNS 解析,以获取请求域名的服务器 IP 地址。如果请求协议是 HTTPS,那么还需要建立 TLS 连接。

接下来就是利用 IP 地址和服务器建立 TCP 连接。连接建立之后,浏览器端会构建请求行、请求头等信息,并把和该域名相关的 Cookie 等数据附加到请求头中,然后向服务器发送构建的请求信息。

服务器接收到请求信息后,会根据请求信息生成响应数据(包括响应行、响应头和响应体等信息),并发给网络进程。等网络进程接收了响应行和响应头之后,就开始解析响应头的内容了。(为了方便讲述,下面我将服务器返回的响应头和响应行统称为响应头。)

(1)重定向

在接收到服务器返回的响应头后,网络进程开始解析响应头,如果发现返回的状态码是 301 或者 302,那么说明服务器需要浏览器重定向到其他 URL。这时网络进程会从响应头的 Location 字段里面读取重定向的地址,然后再发起新的 HTTP 或者 HTTPS 请求,一切又重头开始了。

在导航过程中,如果服务器响应行的状态码包含了 301、302 一类的跳转信息,浏览器会跳转到新的地址继续导航;如果响应行是 200,那么表示浏览器可以继续处理该请求

(2)响应数据类型处理

在处理了跳转信息之后,我们继续导航流程的分析。URL 请求的数据类型,有时候是一个下载类型,有时候是正常的 HTML 页面

Content-Type 是 HTTP 头中一个非常重要的字段, 它告诉浏览器服务器返回的响应体数据是什么类型,然后浏览器会根据 Content-Type 的值来决定如何显示响应体的内容。

Content-Type 不正确,比如将 text/html 类型配置成 application/octet-stream 类型,那么浏览器可能会曲解文件内容,比如会将一个本来是用来展示的页面,变成了一个下载文件

所以,不同 Content-Type 的后续处理流程也截然不同。如果 Content-Type 字段的值被浏览器判断为下载类型,那么该请求会被提交给浏览器的下载管理器,同时该 URL 请求的导航流程就此结束。但如果是 HTML,那么浏览器则会继续进行导航流程。由于 Chrome 的页面渲染是运行在渲染进程中的,所以接下来就需要准备渲染进程了

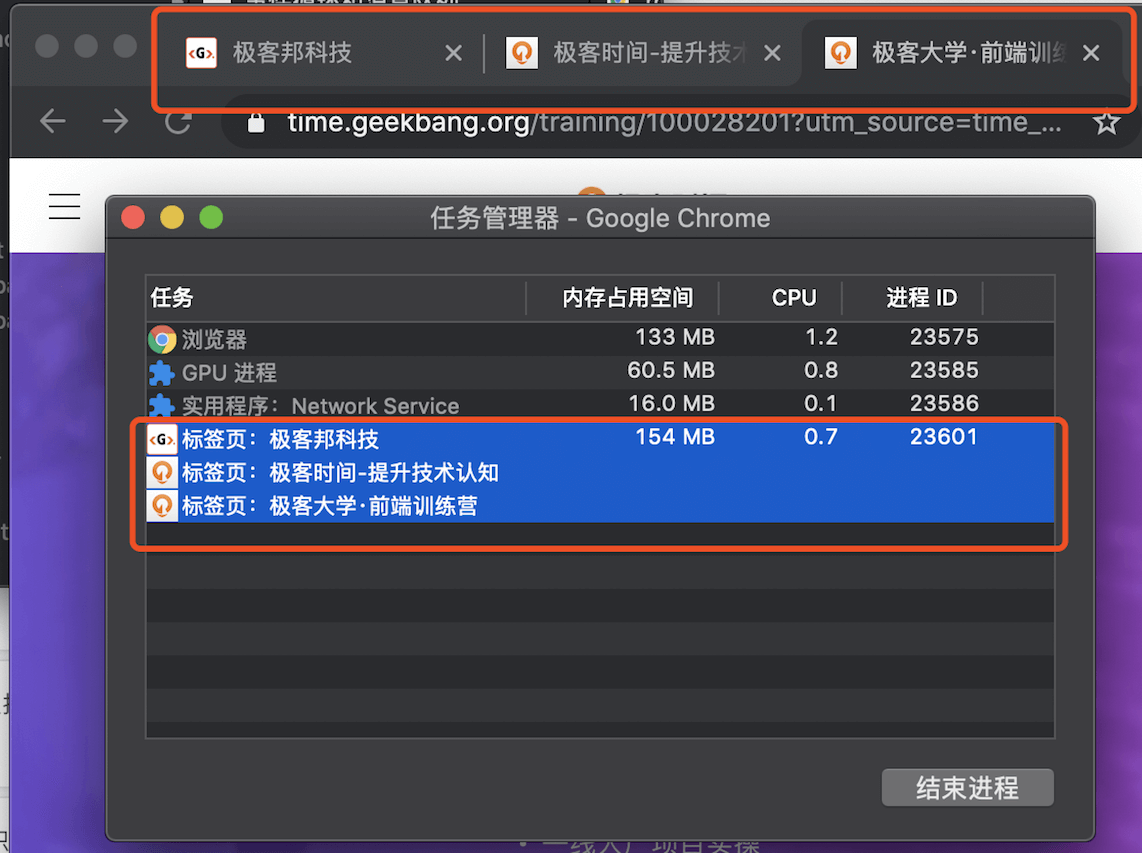

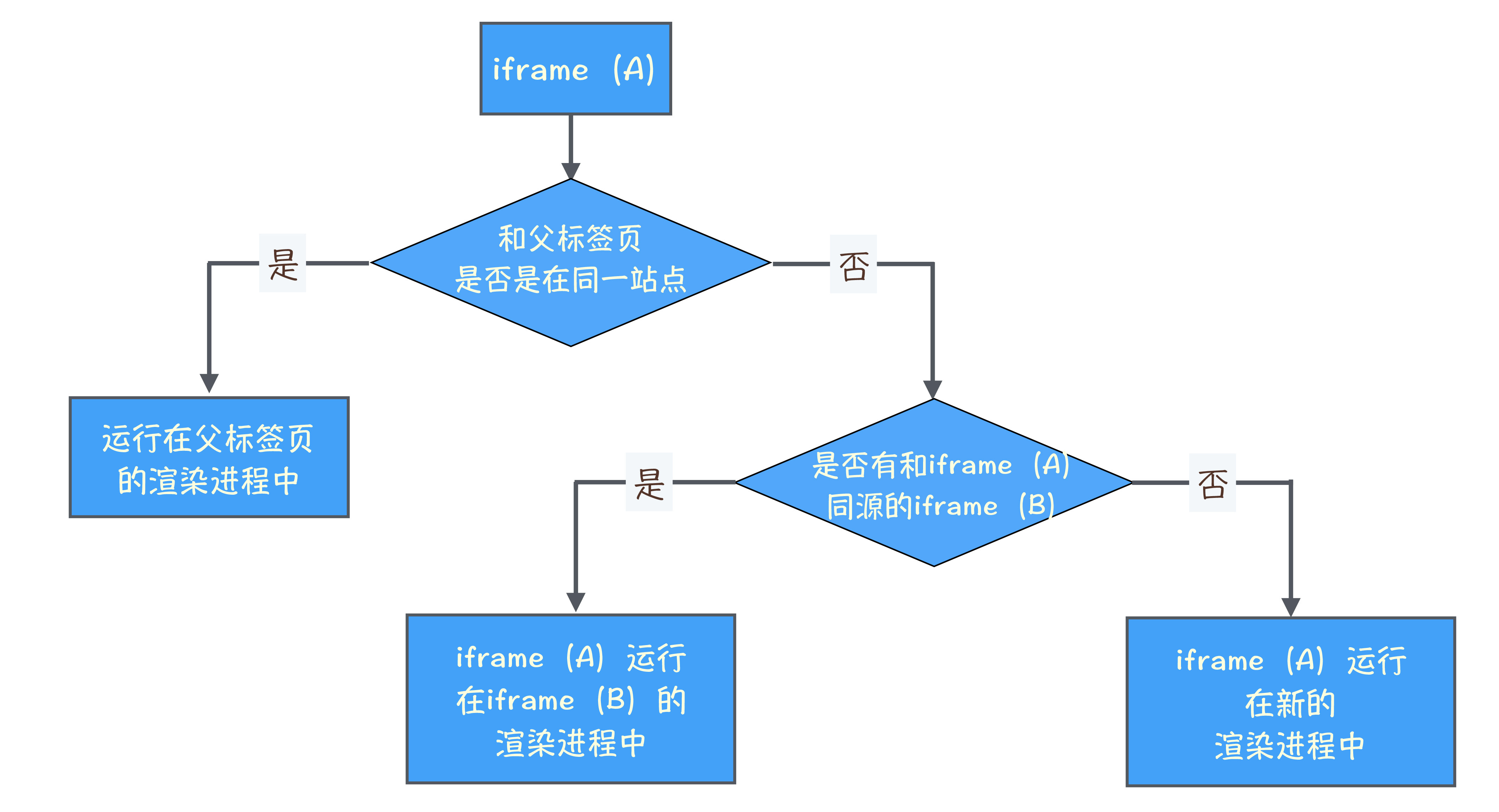

3、准备渲染进程

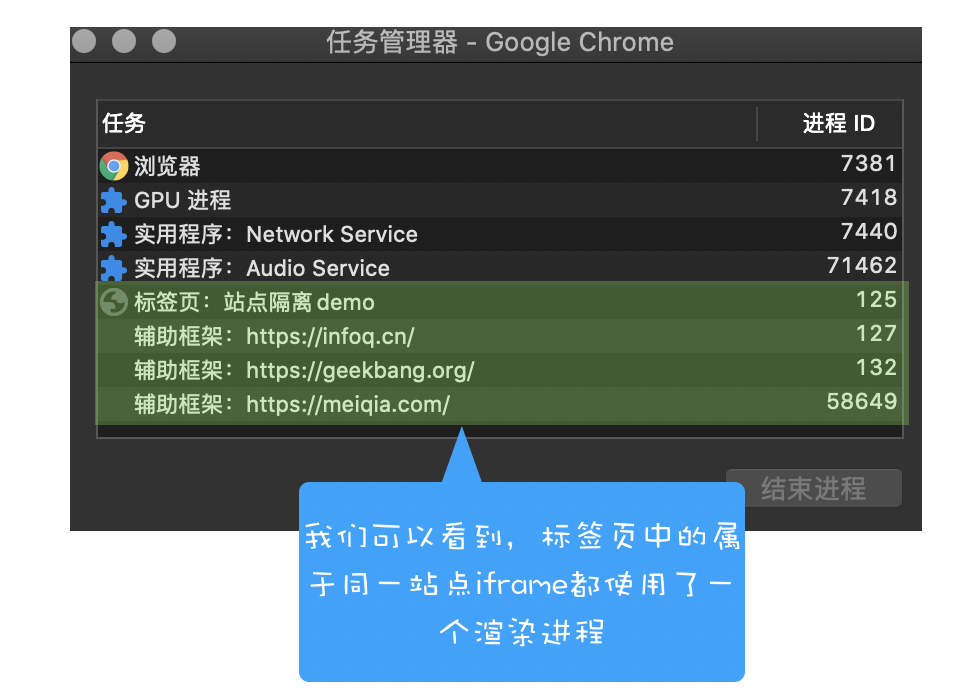

默认情况下,Chrome 会为每个页面分配一个渲染进程,也就是说,每打开一个新页面就会配套创建一个新的渲染进程。但是,也有一些例外,在某些情况下,浏览器会让多个页面直接运行在同一个渲染进程中

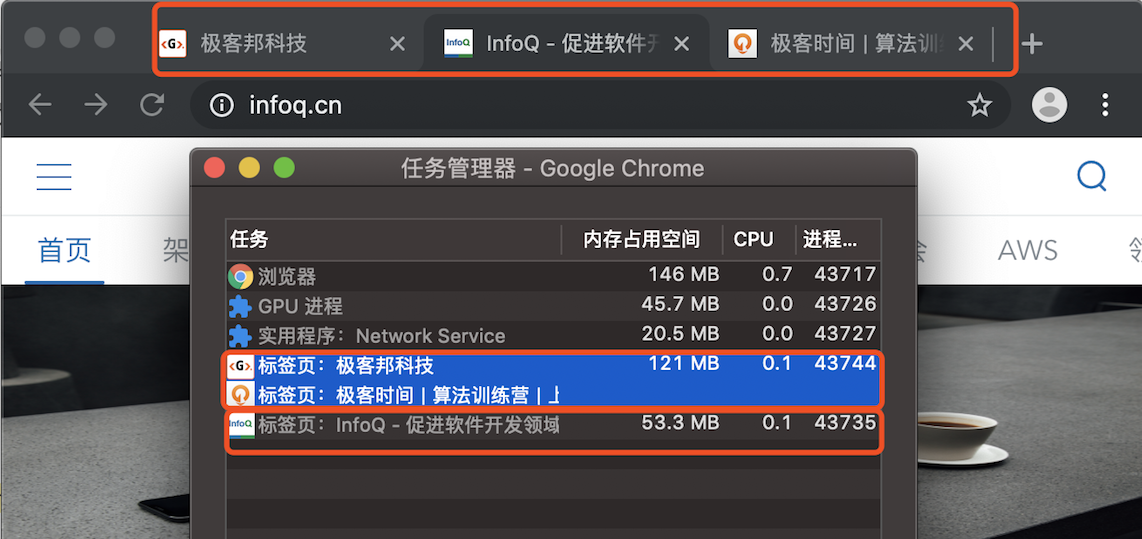

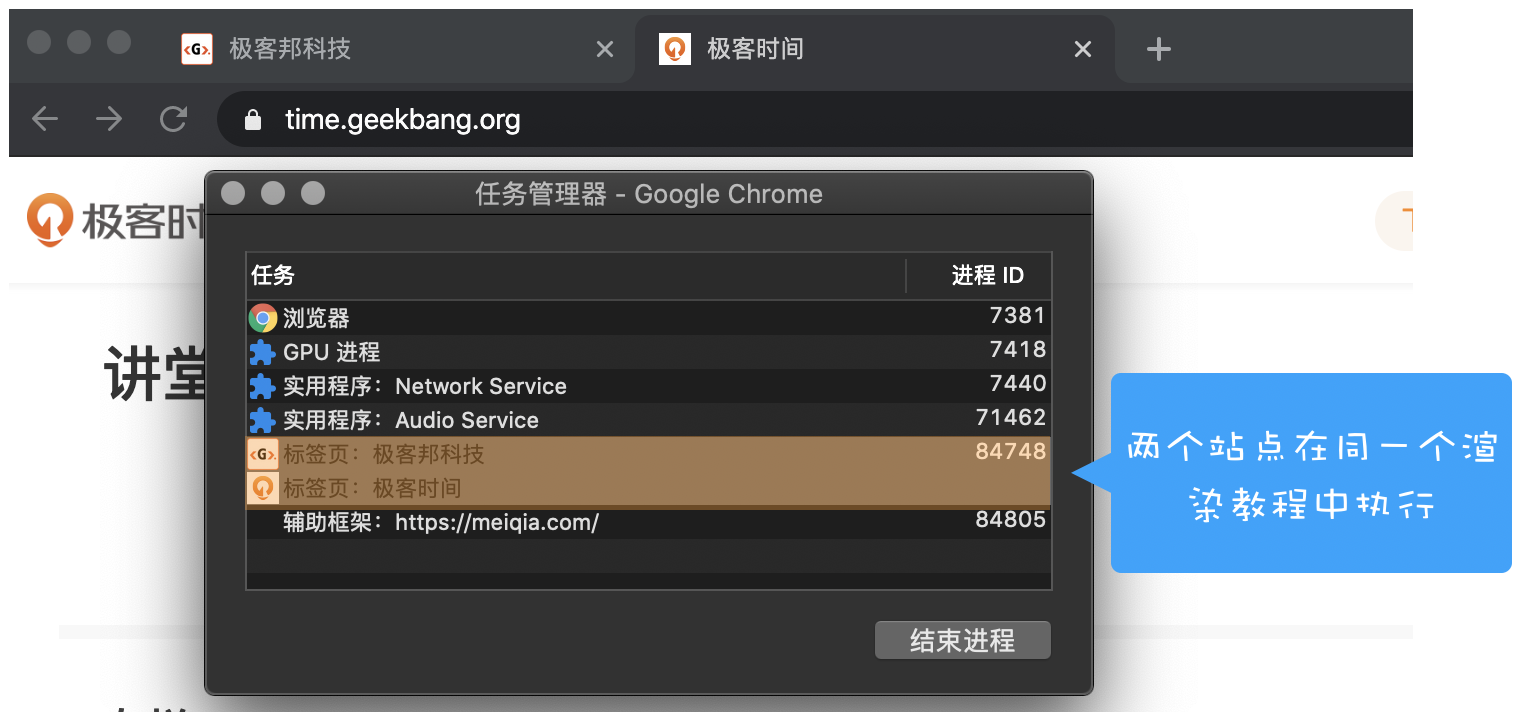

比如我从极客时间的首页里面打开了另外一个页面——算法训练营,我们看下图的 Chrome 的任务管理器截图:

从图中可以看出,打开的这三个页面都是运行在同一个渲染进程中,进程 ID 是 23601。

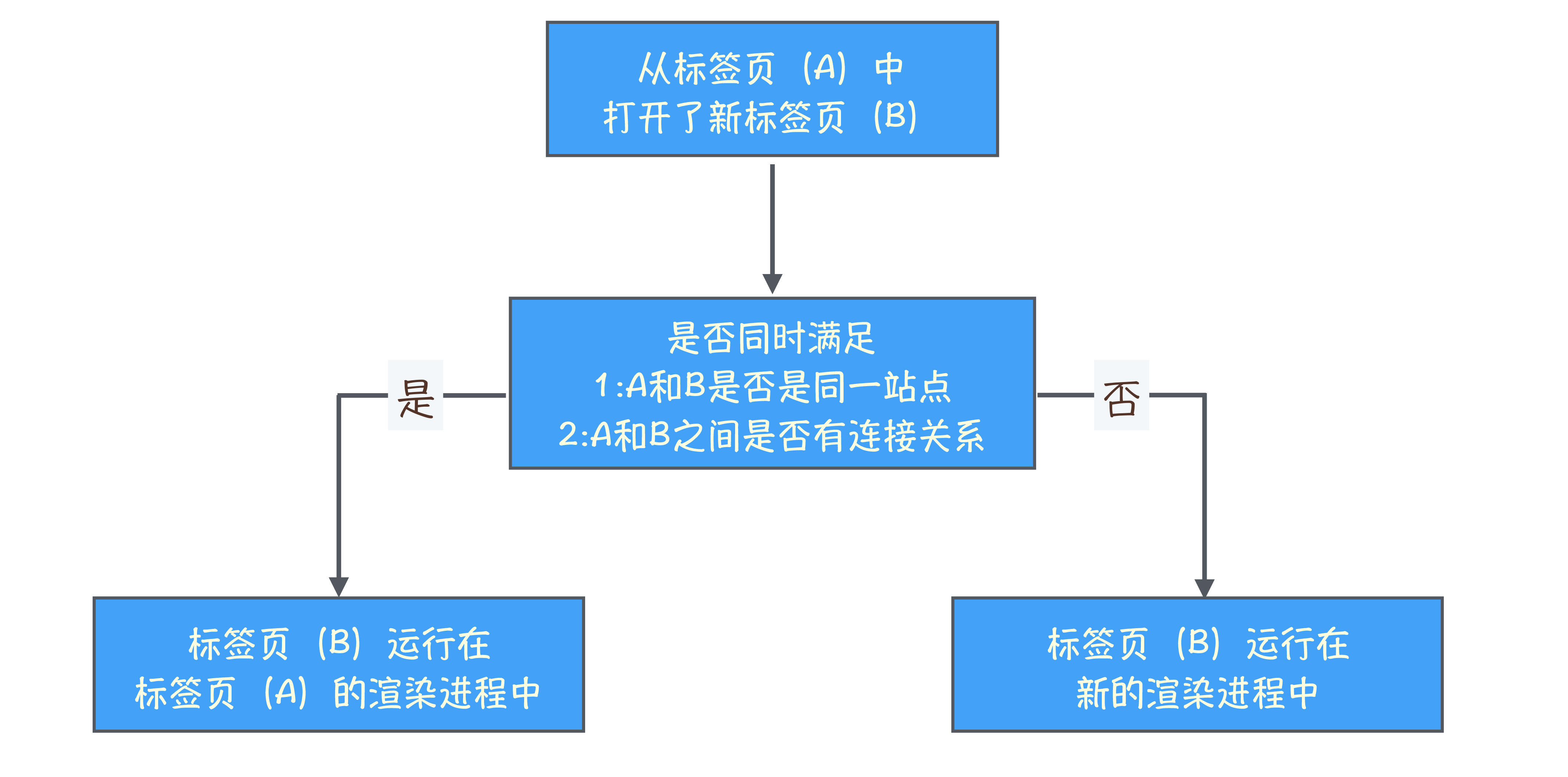

那什么情况下多个页面会同时运行在一个渲染进程中呢?

我们需要先了解下什么是同一站点(same-site)。具体地讲,我们将“同一站点”定义为根域名(例如,geekbang.org)加上协议(例如,https:// 或者 http://),还包含了该根域名下的所有子域名和不同的端口,比如下面这三个:

https://time.geekbang.org

https://www.geekbang.org

https://www.geekbang.org:8080它们都是属于同一站点,因为它们的协议都是 HTTPS,而且根域名也都是 geekbang.org

Chrome 的默认策略是,每个标签对应一个渲染进程。但如果从一个页面打开了另一个新页面,而新页面和当前页面属于同一站点的话,那么新页面会复用父页面的渲染进程。官方把这个默认策略叫 process-per-site-instance

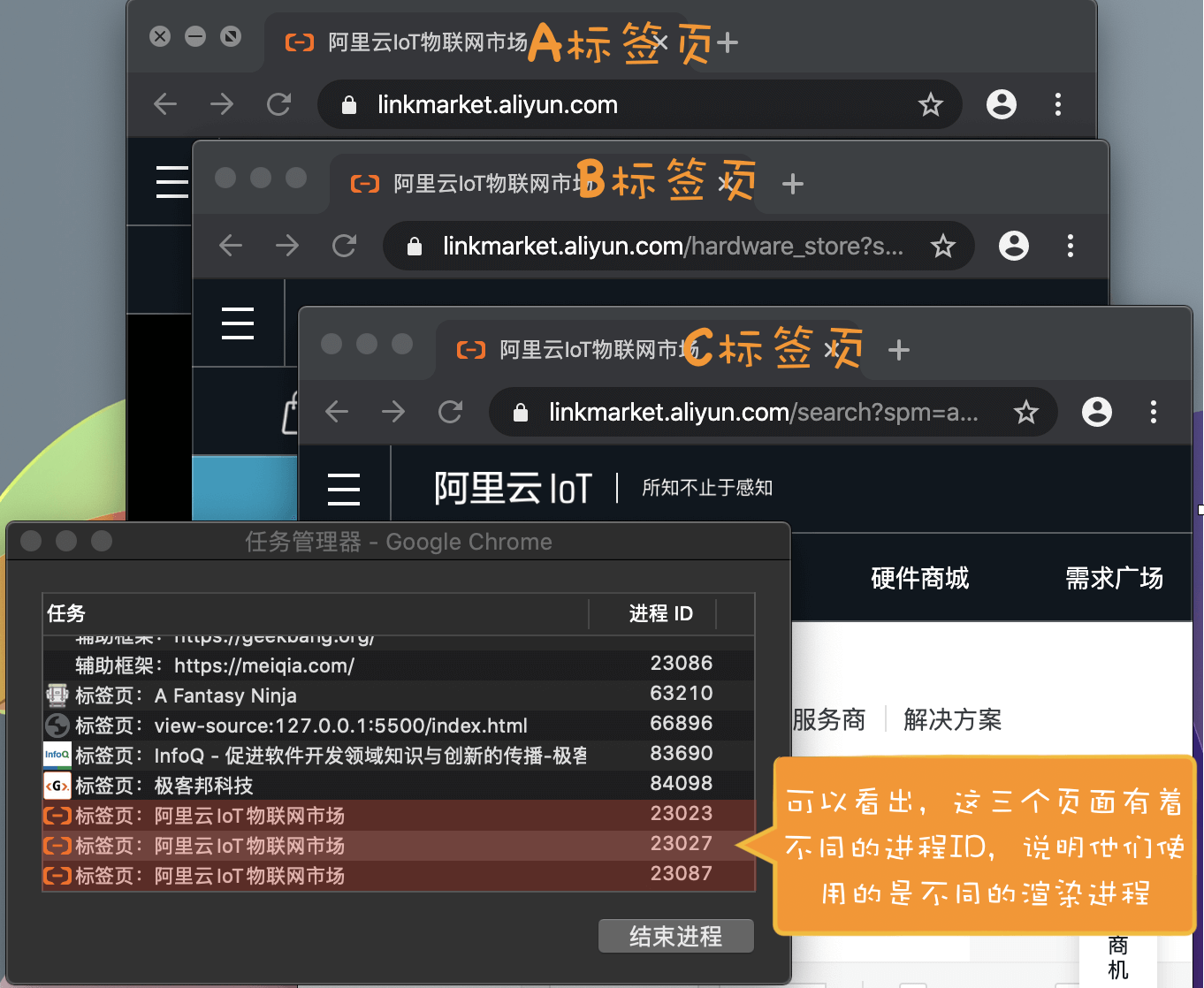

比如我通过极客邦页面里的链接打开 InfoQ 的官网(https://www.infoq.cn/ ), 因为 infoq.cn 和 geekbang.org 不属于同一站点,所以 infoq.cn 会使用一个新的渲染进程,你可以参考下图:

从图中任务管理器可以看出:由于极客邦和极客时间的标签页拥有相同的协议和根域名,所以它们属于同一站点,并运行在同一个渲染进程中;而 infoq.cn 的根域名不同于 geekbang.org,也就是说 InfoQ 和极客邦不属于同一站点,因此它们会运行在两个不同的渲染进程之中。

总结来说,打开一个新页面采用的渲染进程策略就是:

通常情况下,打开新的页面都会使用单独的渲染进程;

如果从 A 页面打开 B 页面,且 A 和 B 都属于同一站点的话,那么 B 页面复用 A 页面的渲染进程;如果是其他情况,浏览器进程则会为 B 创建一个新的渲染进程。

渲染进程准备好之后,还不能立即进入文档解析状态,因为此时的文档数据还在网络进程中,并没有提交给渲染进程,所以下一步就进入了提交文档阶段

4、提交文档

所谓提交文档,就是指浏览器进程将网络进程接收到的 HTML 数据提交给渲染进程,具体流程是这样的:

首先当浏览器进程接收到网络进程的响应头数据之后,便向渲染进程发起“提交文档”的消息;

渲染进程接收到“提交文档”的消息后,会和网络进程建立传输数据的“管道”;

等文档数据传输完成之后,渲染进程会返回“确认提交”的消息给浏览器进程;

浏览器进程在收到“确认提交”的消息后,会更新浏览器界面状态,包括了安全状态、地址栏的 URL、前进后退的历史状态,并更新 Web 页面。

其中,当渲染进程确认提交之后,更新内容如下图所示:

这也就解释了为什么在浏览器的地址栏里面输入了一个地址后,之前的页面没有立马消失,而是要加载一会儿才会更新页面。

5、渲染阶段

一旦文档被提交,渲染进程便开始页面解析和子资源加载了,关于这个阶段的完整过程,我会在下一篇文章中来专门介绍。这里你只需要先了解一旦页面生成完成,渲染进程会发送一个消息给浏览器进程,浏览器接收到消息后,会停止标签图标上的加载动画。如下所示:

总结

服务器可以根据响应头来控制浏览器的行为,如跳转、网络数据类型判断。

Chrome 默认采用每个标签对应一个渲染进程,但是如果两个页面属于同一站点,那这两个标签会使用同一个渲染进程。

浏览器的导航过程涵盖了从用户发起请求到提交文档给渲染进程的中间所有阶段。

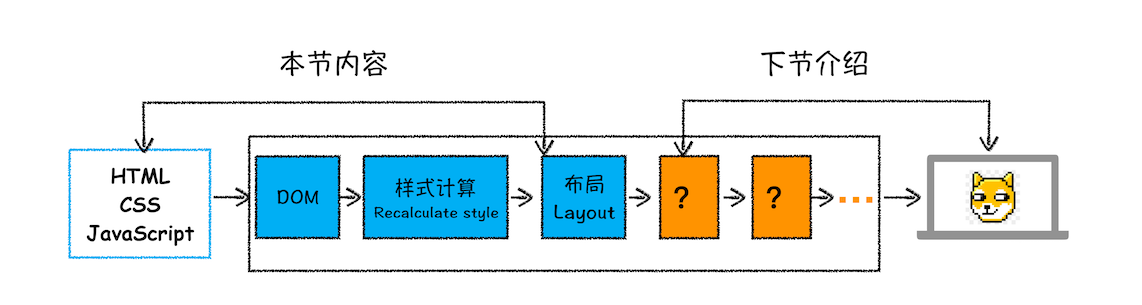

渲染流程

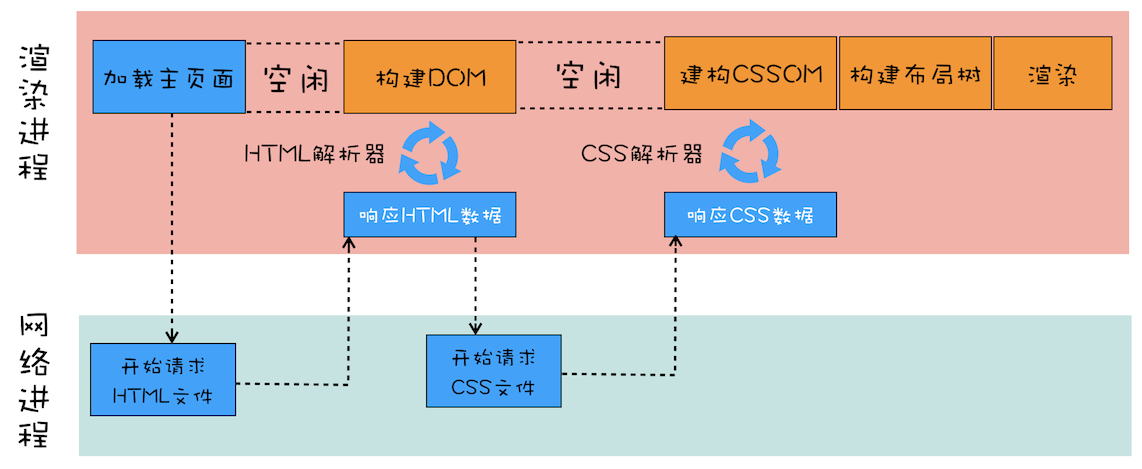

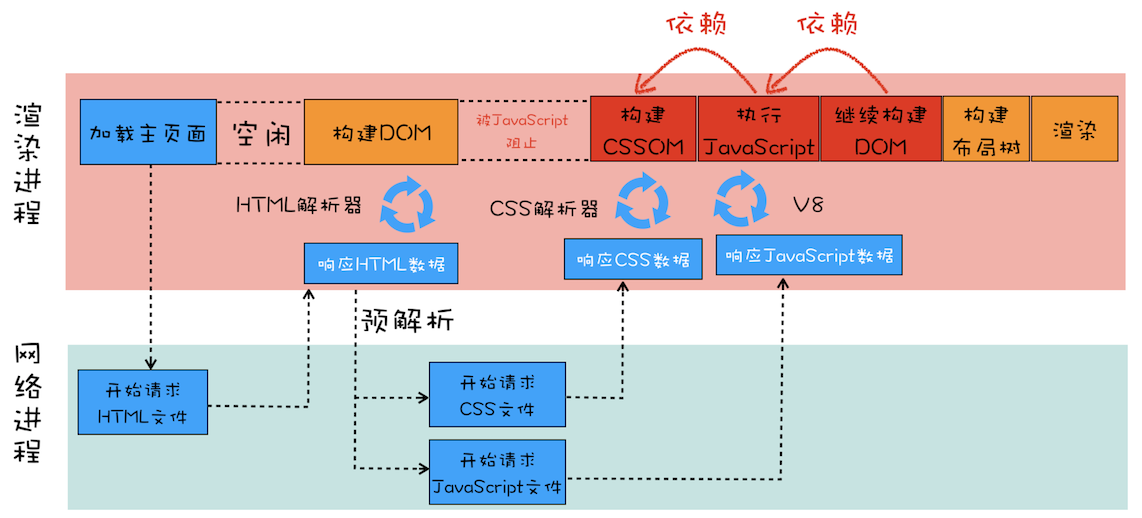

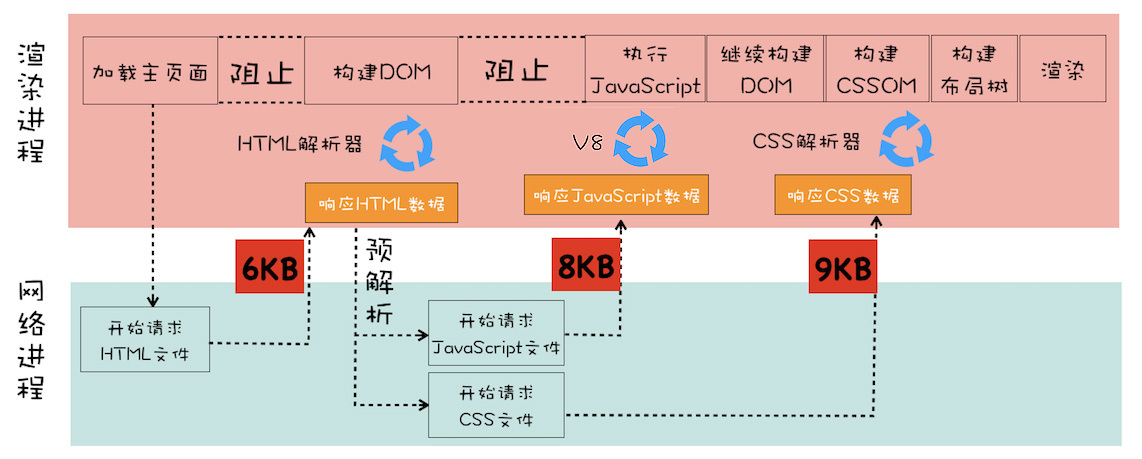

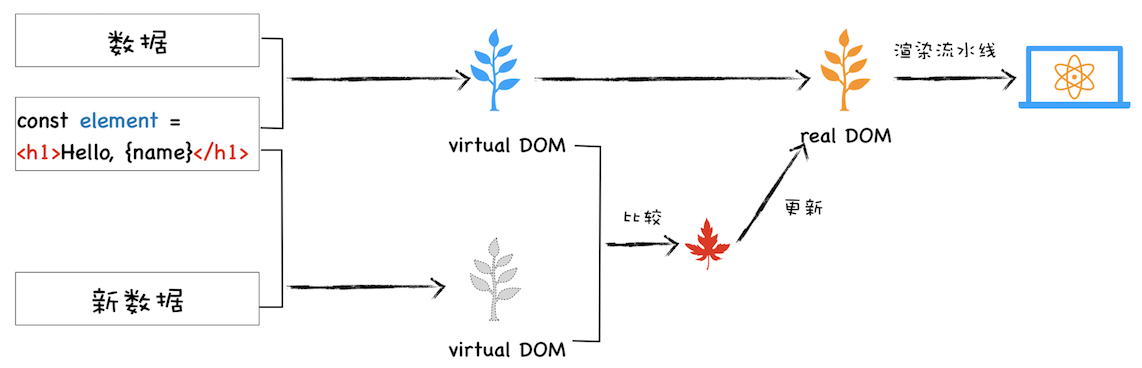

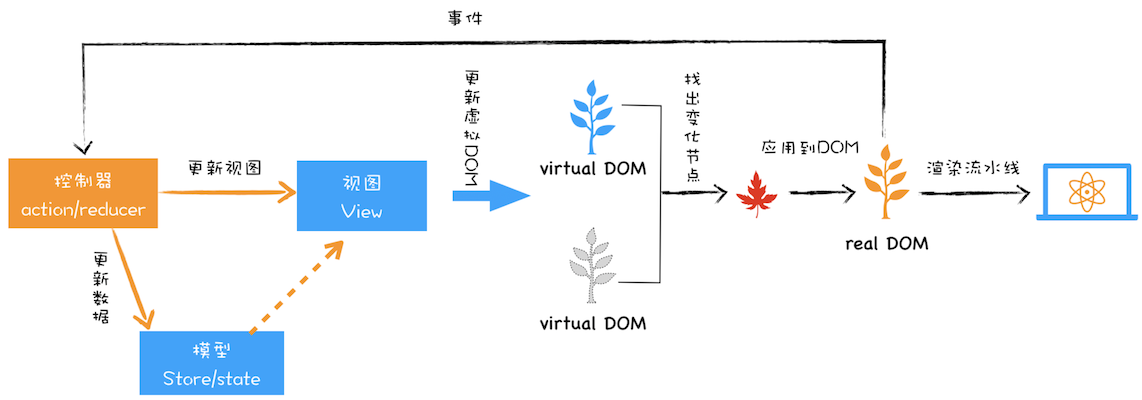

由于渲染机制过于复杂,所以渲染模块在执行过程中会被划分为很多子阶段,输入的 HTML 经过这些子阶段,最后输出像素。我们把这样的一个处理流程叫做渲染流水线,其大致流程如下图所示:

按照渲染的时间顺序,流水线可分为如下几个子阶段:

构建 DOM 树、样式计算、布局阶段、分层、绘制、分块、光栅化和合成。

内容比较多,我会用两篇文章来为你详细讲解这各个子阶段。接下来,在介绍每个阶段的过程中,你应该重点关注以下三点内容:

- 开始每个子阶段都有其输入的内容

- 然后每个子阶段有其处理过程

- 最终每个子阶段会生成输出内容

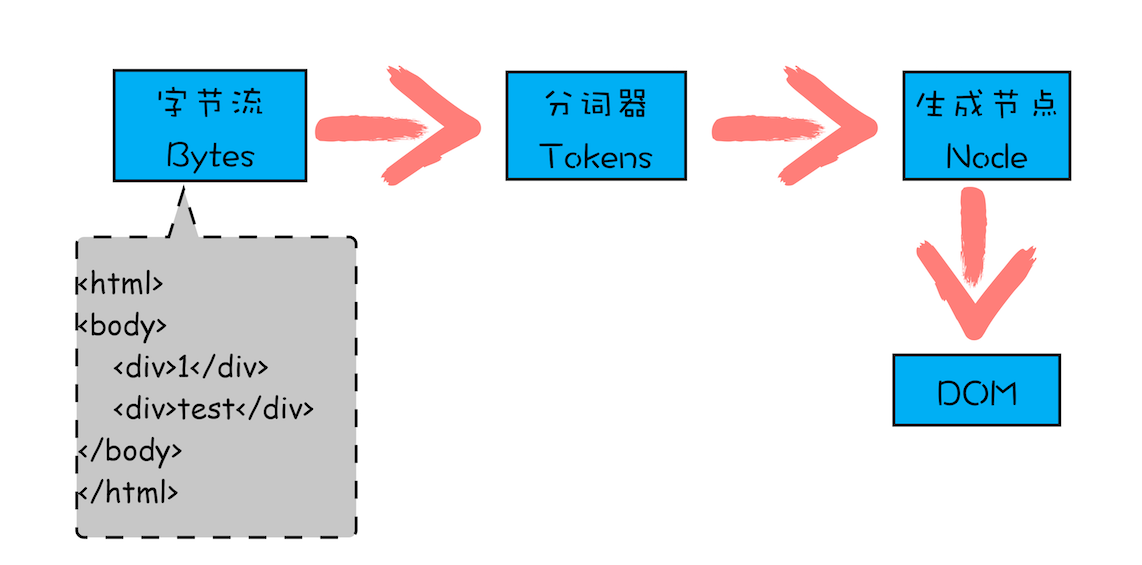

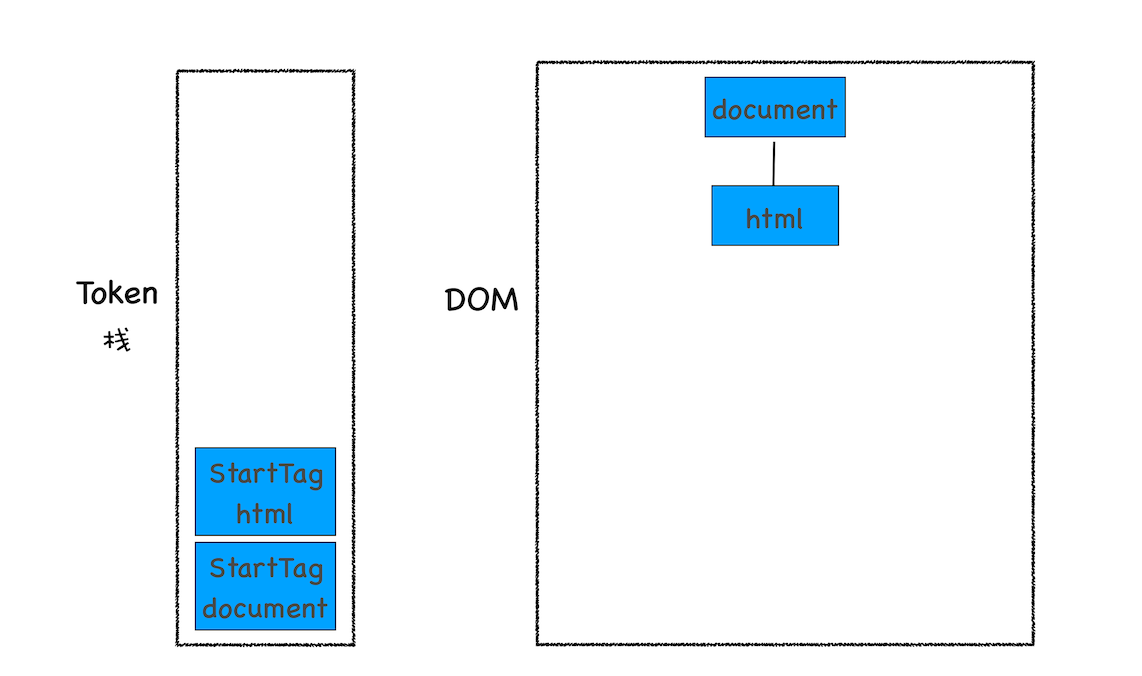

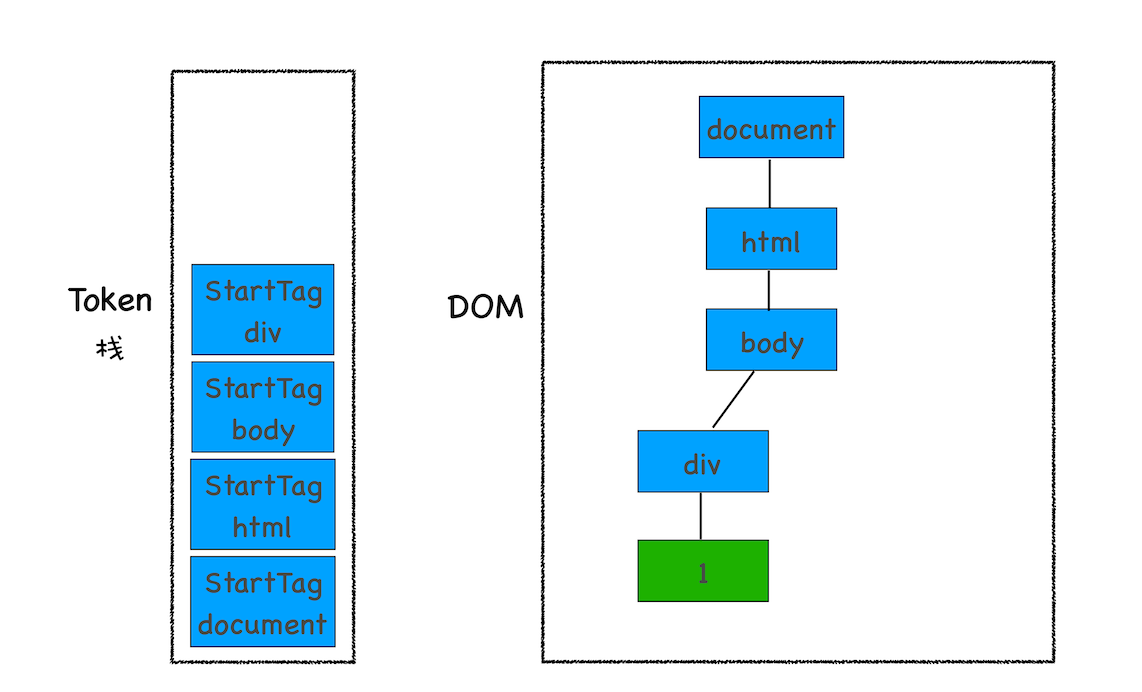

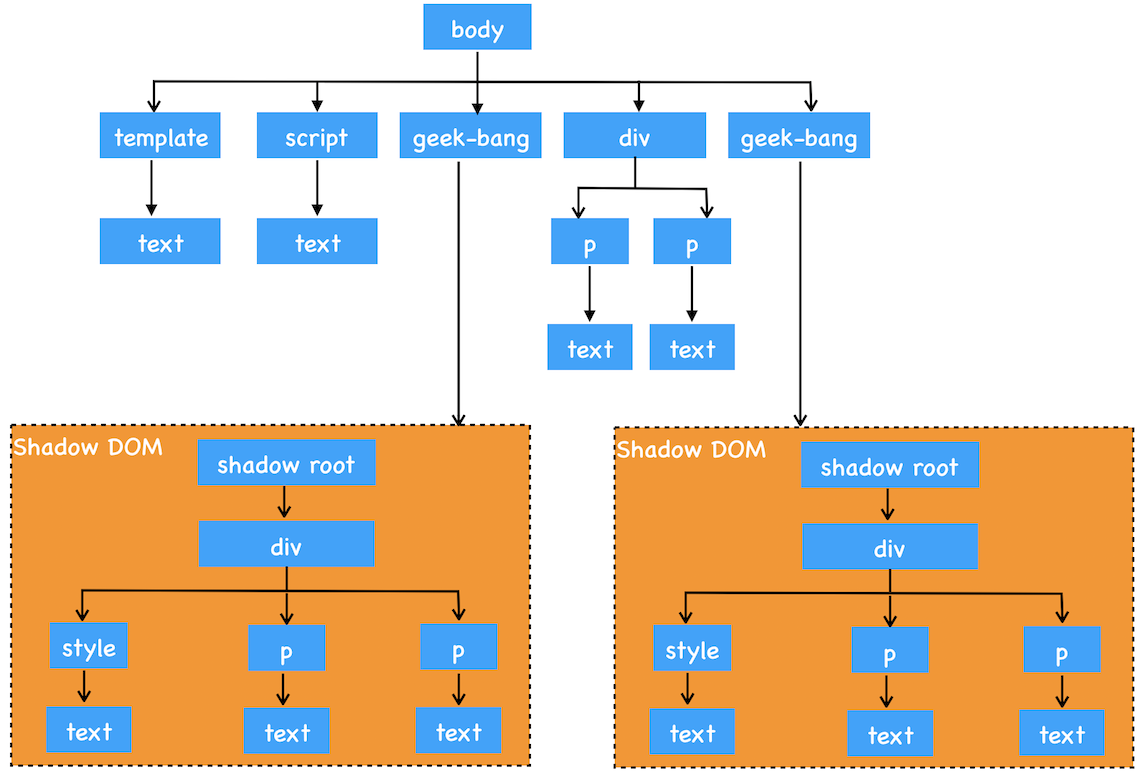

构建 DOM 树

为什么要构建 DOM 树呢?

这是因为浏览器无法直接理解和使用 HTML,所以需要将 HTML 转换为浏览器能够理解的结构——DOM 树

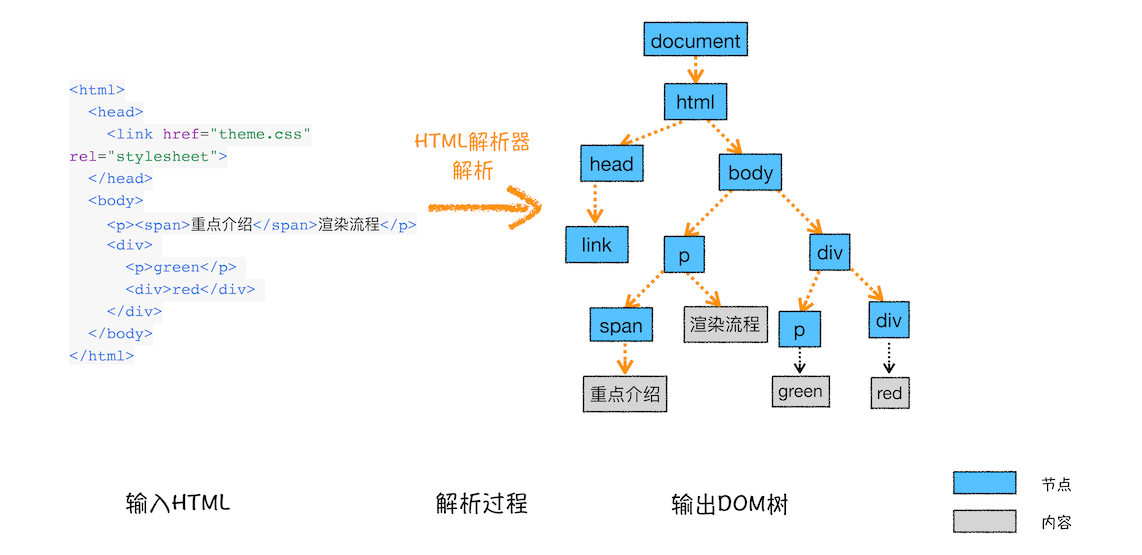

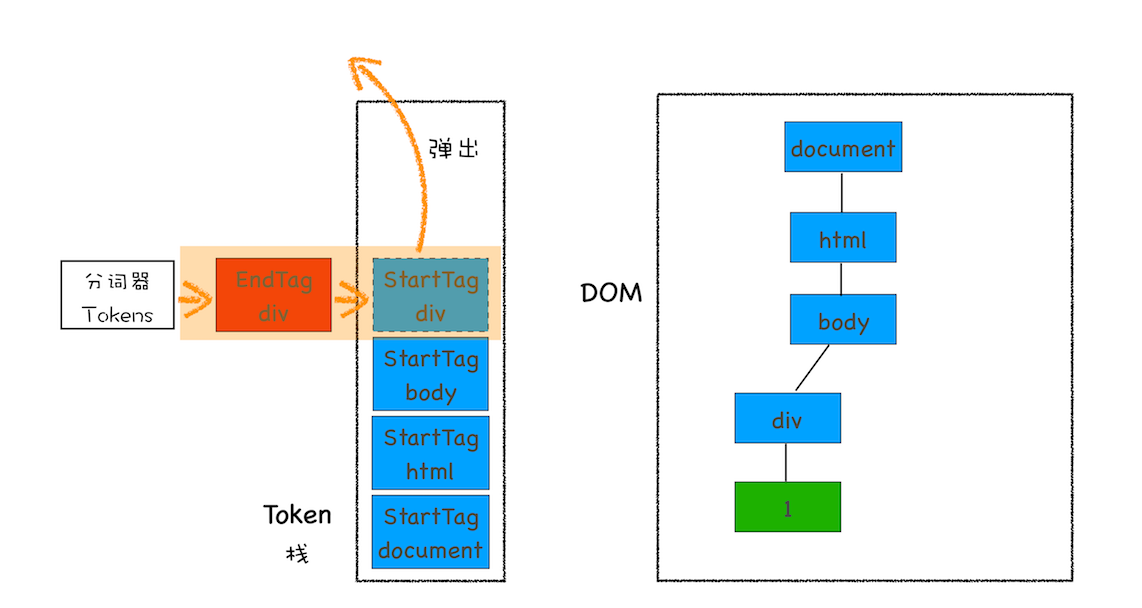

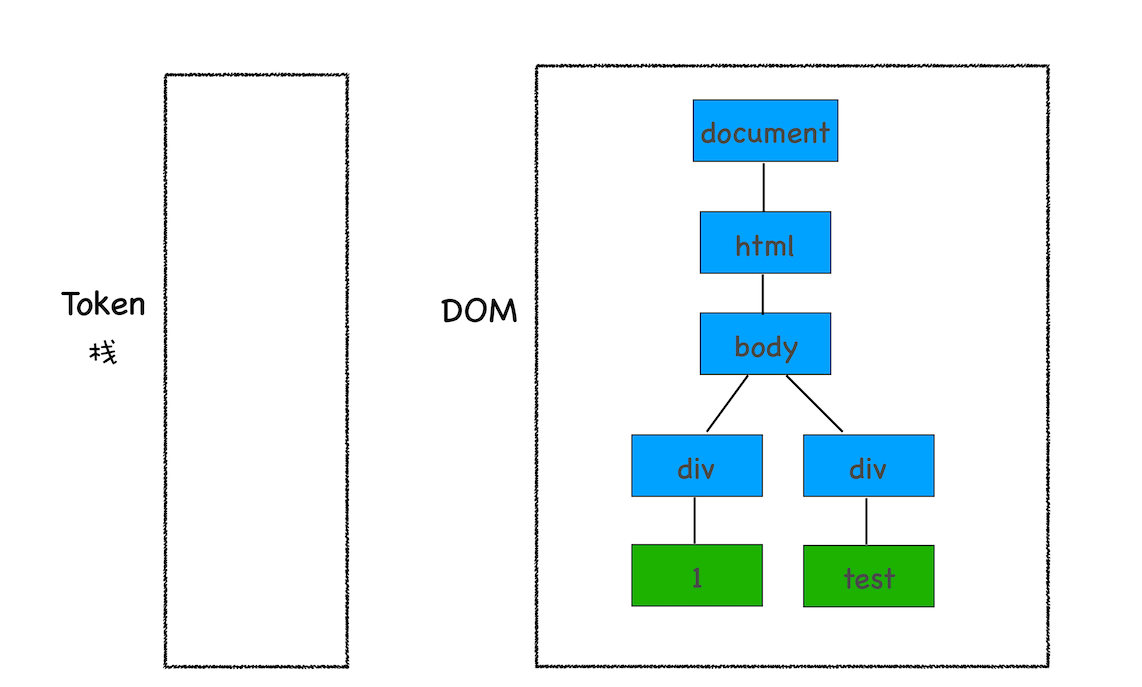

DOM 树的构建过程,你可以参考下图:

从图中可以看出,构建 DOM 树的输入内容是一个非常简单的 HTML 文件,然后经由 HTML 解析器解析,最终输出树状结构的 DOM

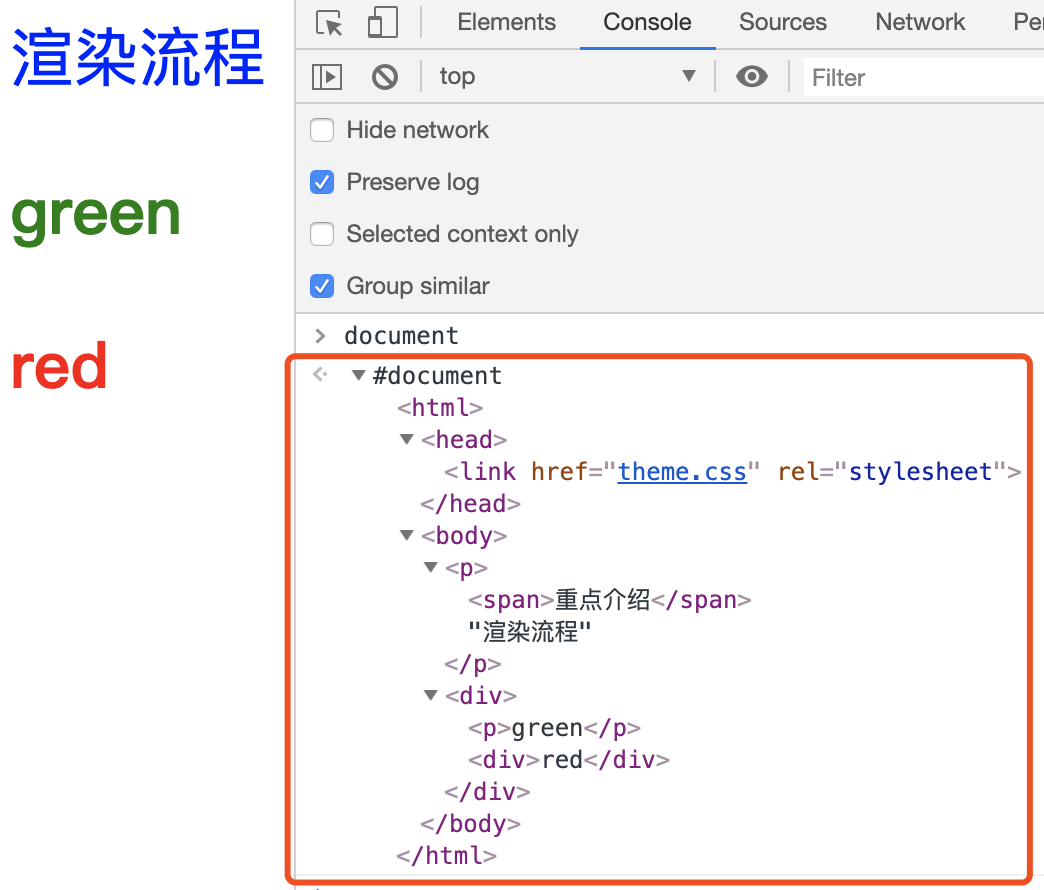

控制台中的 document 就是一个完整的 DOM 树结构:

图中的 document 就是 DOM 结构,你可以看到,DOM 和 HTML 内容几乎是一样的,但是和 HTML 不同的是,DOM 是保存在内存中树状结构,可以通过 JavaScript 来查询或修改其内容

要让 DOM 节点拥有正确的样式,这就需要样式计算了

样式计算(Recalculate Style)

样式计算的目的是为了计算出 DOM 节点中每个元素的具体样式,这个阶段大体可分为三步来完成

1、把 CSS 转换为浏览器能够理解的结构

CSS 来源主要有三种:

- 通过 link 引用的外部 CSS 文件

<style>标记内的 CSS- 元素的 style 属性内嵌的 CSS

和 HTML 文件一样,浏览器也是无法直接理解这些纯文本的 CSS 样式,所以当渲染引擎接收到 CSS 文本时,会执行一个转换操作,将 CSS 文本转换为浏览器可以理解的结构——styleSheets

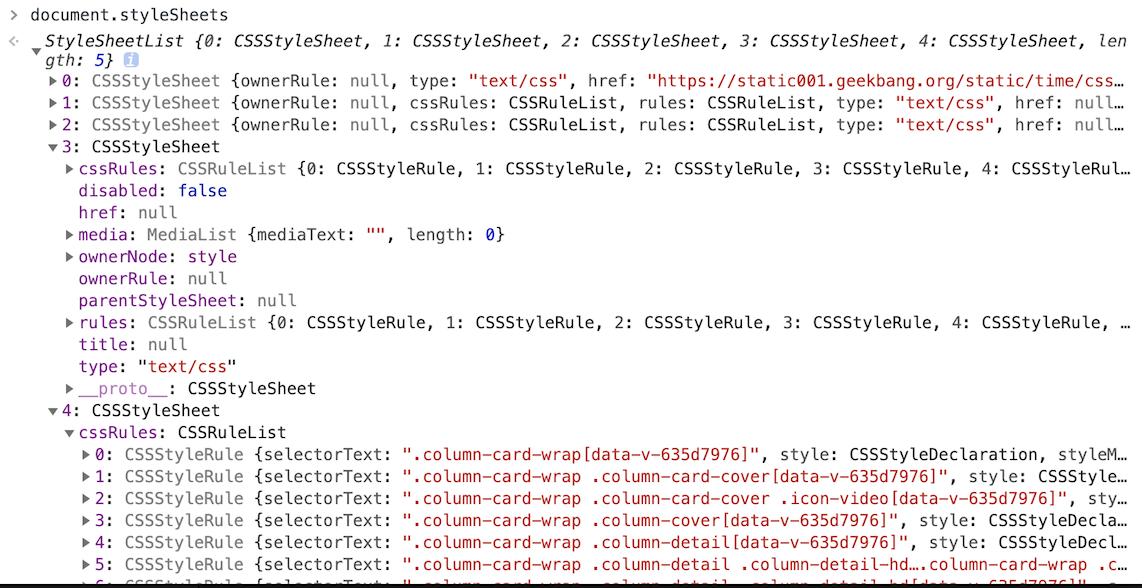

控制台中的 document.styleSheets 就是一个完整的 styleSheets 树结构:

道渲染引擎会把获取到的 CSS 文本全部转换为 styleSheets 结构中的数据,并且该结构同时具备了查询和修改功能,这会为后面的样式操作提供基础

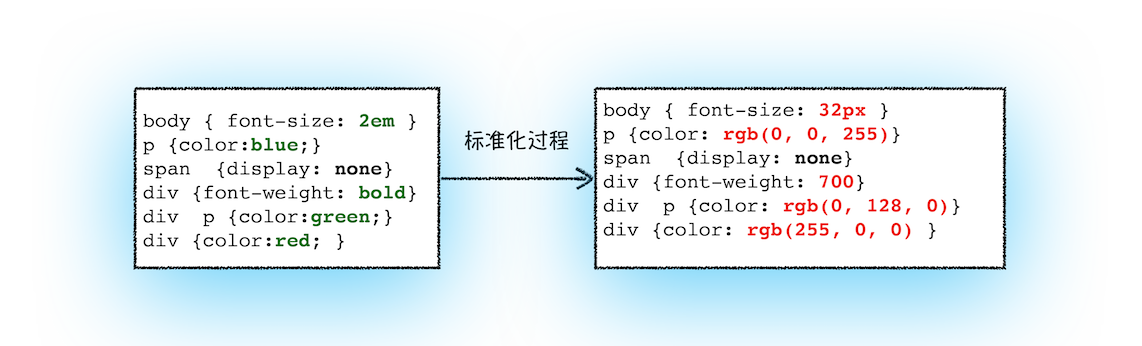

2、转换样式表中的属性值,使其标准化

现在我们已经把现有的 CSS 文本转化为浏览器可以理解的结构了,那么接下来就要对其进行属性值的标准化操作

body {

font-size: 2em;

}

p {

color: blue;

}

span {

display: none;

}

div {

font-weight: bold;

}

div p {

color: green;

}

div {

color: red;

}可以看到上面的 CSS 文本中有很多属性值,如 2em、blue、bold,这些类型数值不容易被渲染引擎理解,所以需要将所有值转换为渲染引擎容易理解的、标准化的计算值,这个过程就是属性值标准化

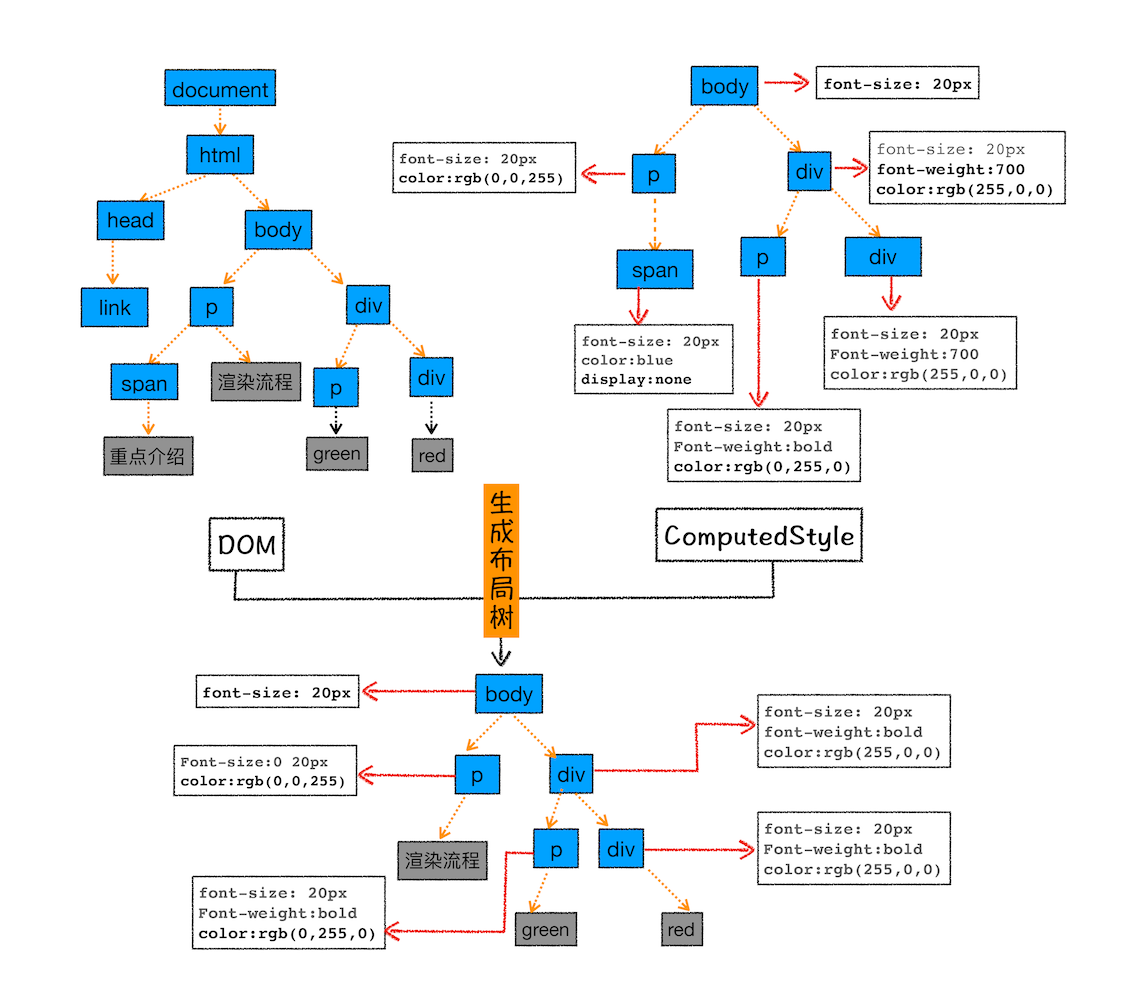

3. 计算出 DOM 树中每个节点的具体样式

现在样式的属性已被标准化了,接下来就需要计算 DOM 树中每个节点的样式属性了,如何计算呢?

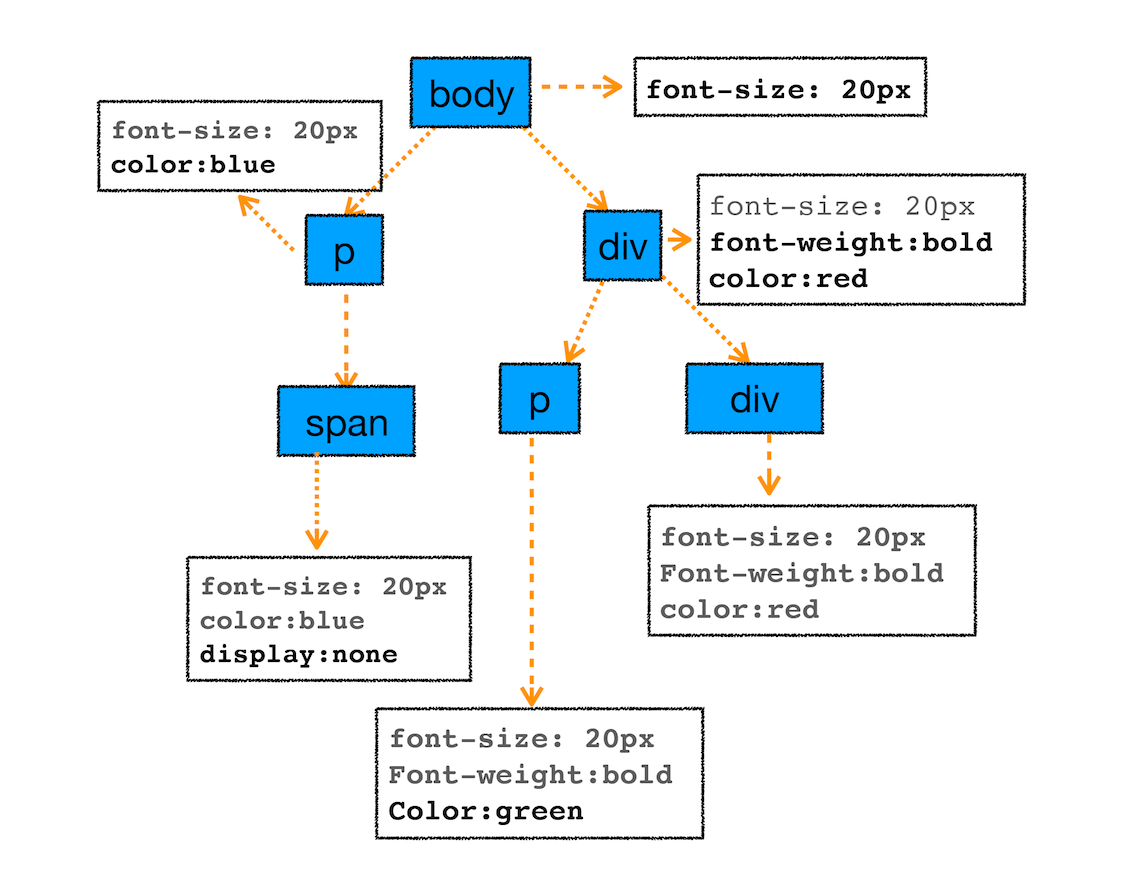

这就涉及到 CSS 的继承规则和层叠规则了

首先是 CSS 继承。CSS 继承就是每个 DOM 节点都包含有父节点的样式。这么说可能有点抽象,我们可以结合具体例子,看下面这样一张样式表是如何应用到 DOM 节点上的

body {

font-size: 20px;

}

p {

color: blue;

}

span {

display: none;

}

div {

font-weight: bold;

color: red;

}

div p {

color: green;

}这张样式表最终应用到 DOM 节点的效果如下图所示:

从图中可以看出,所有子节点都继承了父节点样式。比如 body 节点的 font-size 属性是 20,那 body 节点下面的所有节点的 font-size 都等于 20

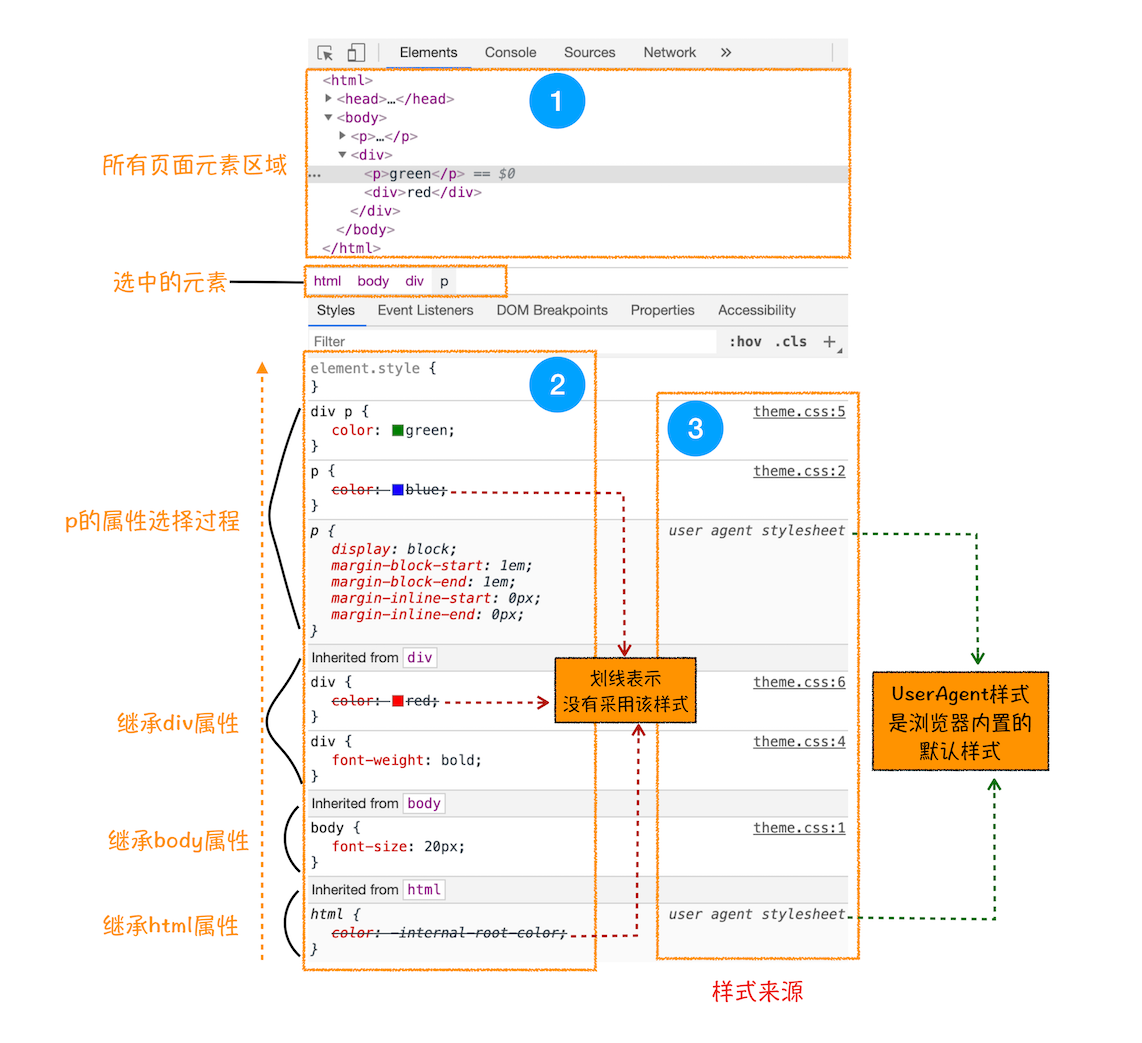

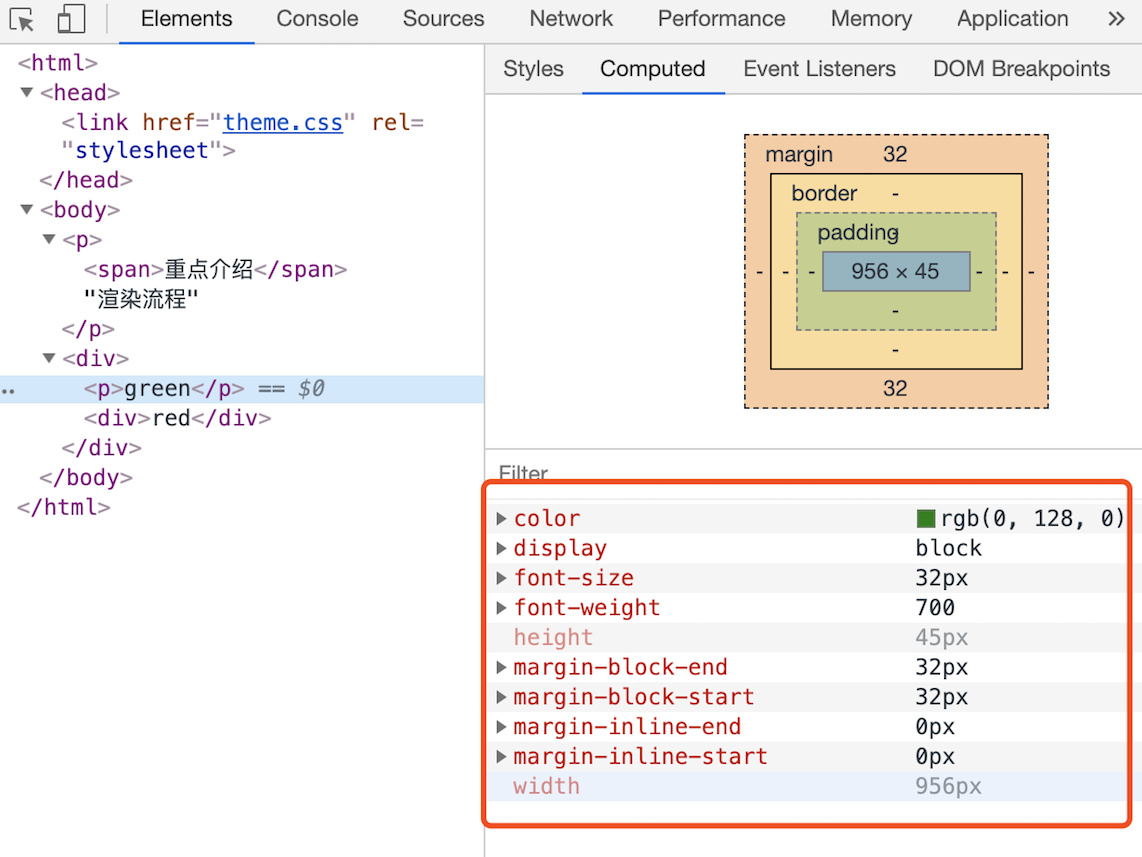

控制台中 element 标签页里选中元素可以看到详细的样式继承:

这个界面展示的信息很丰富,大致可描述为如下:

- 首先,可以选择要查看的元素的样式(位于图中的区域 2 中),在图中的第 1 个区域中点击对应的元素,就可以在下面的区域查看该元素的样式了。比如这里我们选择的元素是

<p>标签,位于 html.body.div. 这个路径下面 - 其次,可以从**样式来源(位于图中的区域 3 中)**中查看样式的具体来源信息,看看是来源于样式文件,还是来源于 UserAgent 样式表。这里需要特别提下 UserAgent 样式,它是浏览器提供的一组默认样式,如果你不提供任何样式,默认使用的就是 UserAgent 样式

- 最后,可以通过区域 2 和区域 3 来查看样式继承的具体过程

样式计算过程中的第二个规则是样式层叠。层叠是 CSS 的一个基本特征,它是一个定义了如何合并来自多个源的属性值的算法。它在 CSS 处于核心地位,CSS 的全称“层叠样式表”正是强调了这一点

总之,样式计算阶段的目的是为了计算出 DOM 节点中每个元素的具体样式,在计算过程中需要遵守 CSS 的继承和层叠两个规则。这个阶段最终输出的内容是每个 DOM 节点的样式,并被保存在 ComputedStyle 的结构内

控制台中 element 标签页里选中元素后点击 Computed 子标签可以查看最终样式:

布局阶段

现在,我们有 DOM 树和 DOM 树中元素的样式,但这还不足以显示页面,因为我们还不知道 DOM 元素的几何位置信息。那么接下来就需要计算出 DOM 树中可见元素的几何位置,我们把这个计算过程叫做布局

Chrome 在布局阶段需要完成两个任务:创建布局树和布局计算

1、创建布局树

DOM 树还含有很多不可见的元素,比如 head 标签,还有使用了 display:none 属性的元素。所以在显示之前,我们还要额外地构建一棵只包含可见元素布局树

从上图可以看出,DOM 树中所有不可见的节点都没有包含到布局树中

为了构建布局树,浏览器大体上完成了下面这些工作:

- 遍历 DOM 树中的所有可见节点,并把这些节点加到布局树中

- 而不可见的节点会被布局树忽略掉,如 head 标签下面的全部内容,再比如 body.p.span 这个元素,因为它的属性包含 dispaly:none,所以这个元素也没有被包进布局树

visibility: hidden 的元素会出现在布局树中,这与 display: none 是不同的

2、布局计算

现在我们有了一棵完整的布局树。那么接下来,就要计算布局树节点的坐标位置了。布局的计算过程非常复杂,我们这里先跳过不讲,等到后面章节中我再做详细的介绍。

在执行布局操作的时候,会把布局运算的结果重新写回布局树中,所以布局树既是输入内容也是输出内容,这是布局阶段一个不合理的地方,因为在布局阶段并没有清晰地将输入内容和输出内容区分开来。针对这个问题,Chrome 团队正在重构布局代码,下一代布局系统叫 LayoutNG,试图更清晰地分离输入和输出,从而让新设计的布局算法更加简单

总结(上)

比较完整的渲染流水线:

从图中可以看出,本节内容我们介绍了渲染流程的前三个阶段:DOM 生成、样式计算和布局。要点可大致总结为如下:

- 浏览器不能直接理解 HTML 数据,所以第一步需要将其转换为浏览器能够理解的 DOM 树结构

- 生成 DOM 树后,还需要根据 CSS 样式表,来计算出 DOM 树所有节点的样式

- 最后计算 DOM 元素的布局信息,使其都保存在布局树中

1、如果下载 CSS 文件阻塞了,会阻塞 DOM 树的合成吗?会阻塞页面的显示吗?

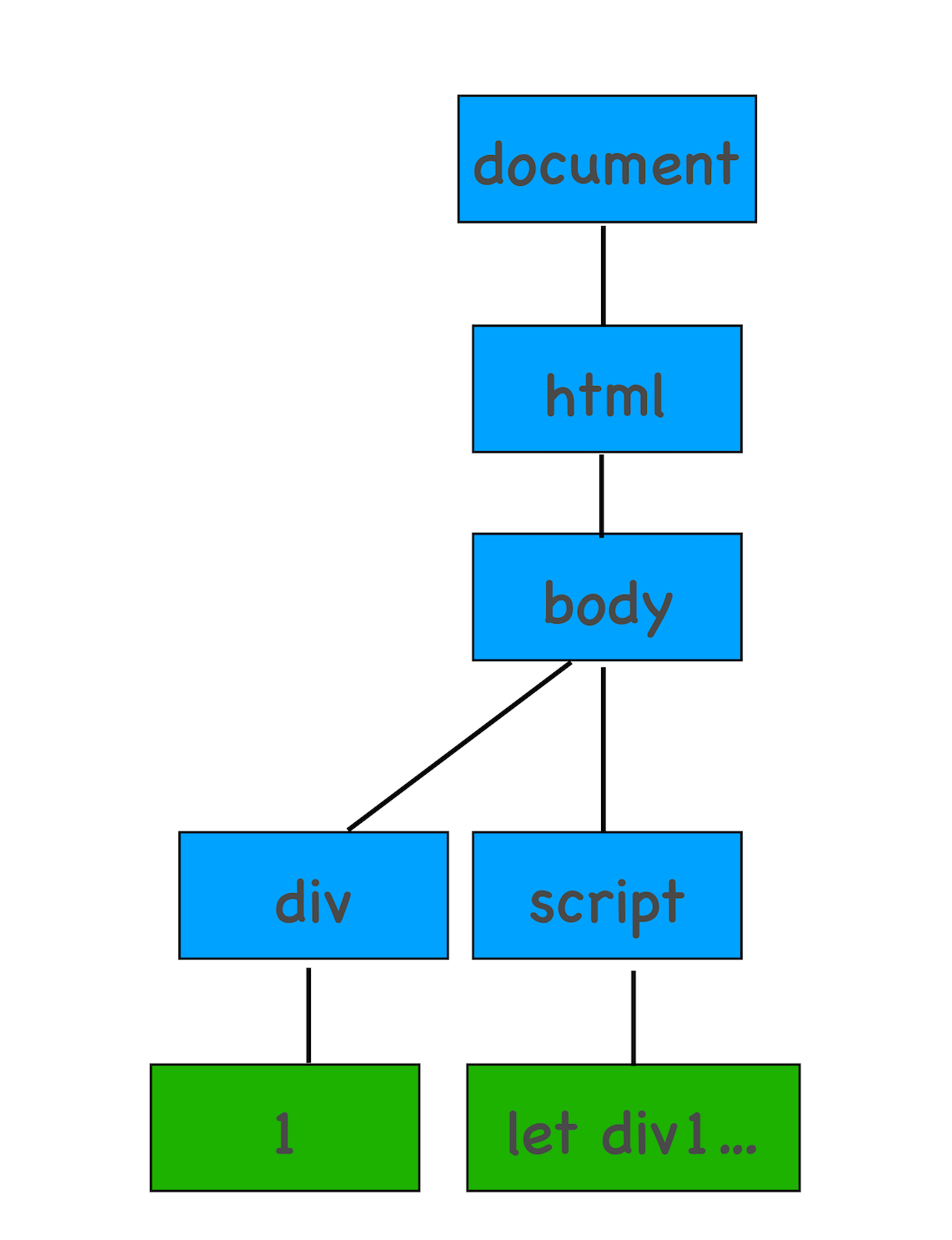

当从服务器接收 HTML 页面的第一批数据时,DOM 解析器就开始工作了,在解析过程中,如果遇到了内联 JS 脚本。DOM 解析器会先执行 JavaScript 脚本,执行完成之后,再继续往下解析

那么第二种情况复杂点了,我们内联的脚本替换成 js 外部文件。这种情况下,当解析到 JavaScript 的时候,会先暂停 DOM 解析,并下载 foo.js 文件,下载完成之后执行该段 JS 文件,然后再继续往下解析 DOM。这就是 JavaScript 文件为什么会阻塞 DOM 渲染

我们再看第三种情况,当我在 JavaScript 中访问了某个元素的样式,那么这时候就需要等待这个样式被下载完成才能继续往下执行,所以在这种情况下,CSS 也会阻塞 DOM 的解析

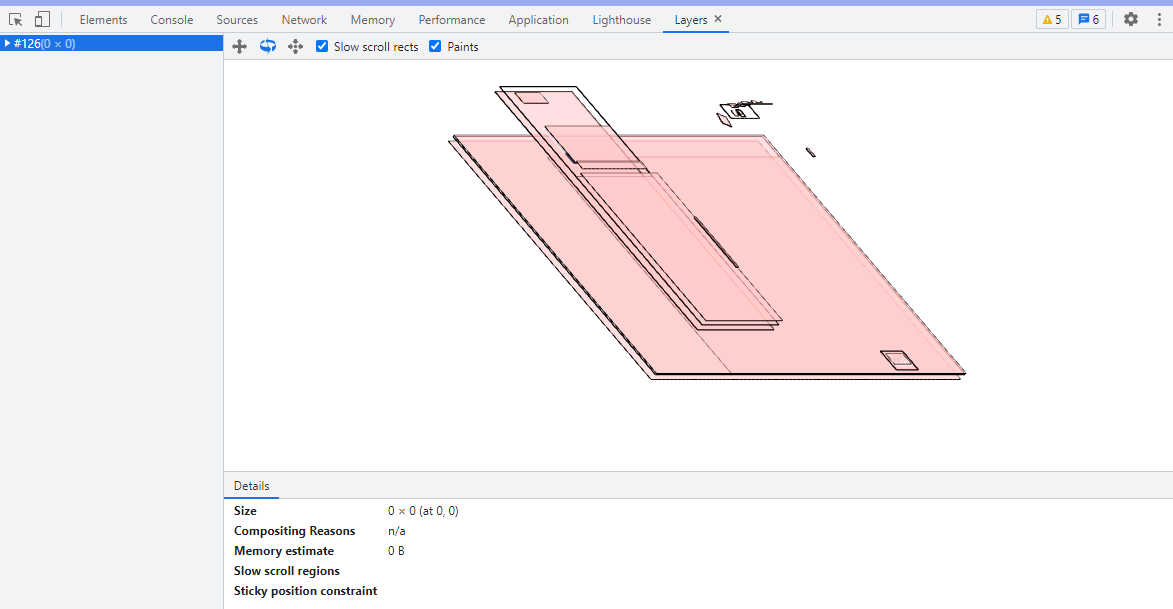

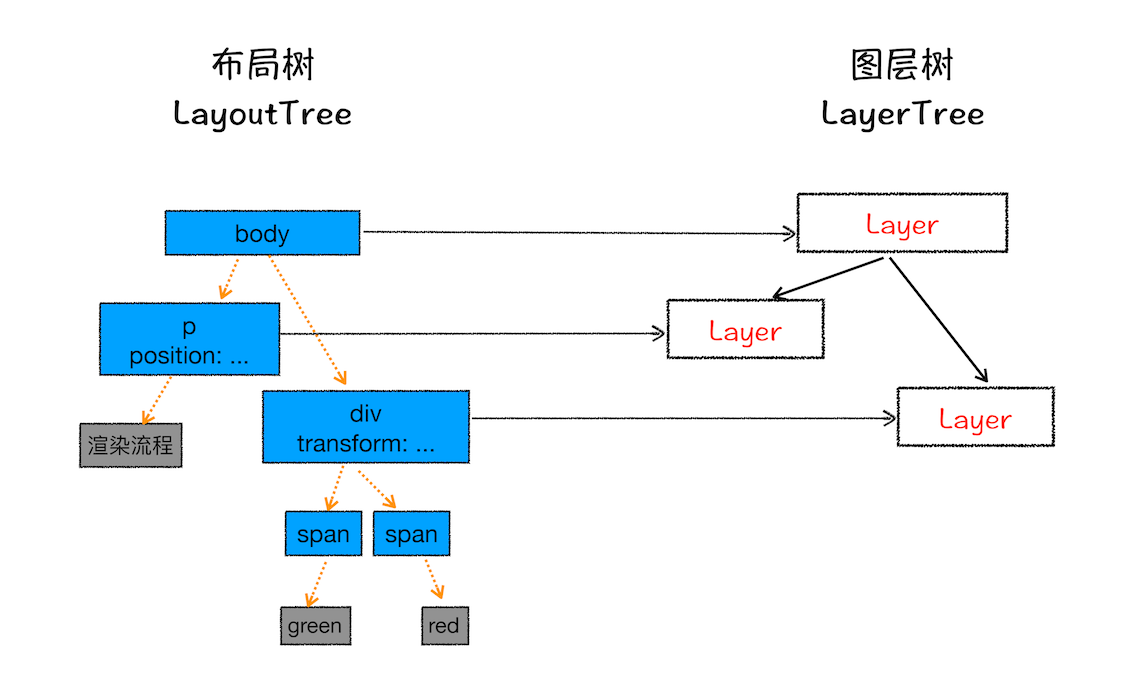

分层

有了布局树后,浏览器还不会着手绘制页面,因为页面中还有很多复杂的效果:一些复杂的 3D 变换、页面滚动,或者使用 z-indexing 做 z 轴排序等

为了更加方便地实现这些效果,渲染引擎还需要为特定的节点生成专用的图层,并生成一棵对应的图层树(LayerTree)

可以在控制台工具中打开 Layers 标签来查看图层树情况:

浏览器的页面实际上被分成了很多图层,这些图层叠加后合成了最终的页面

图层和布局树节点之间的关系,如文中图所示:

通常情况下,并不是布局树的每个节点都包含一个图层,如果一个节点没有对应的层,那么这个节点就从属于父节点的图层

通常满足下面两点中任意一点的元素就可以被提升为单独的一个图层:

第一点,拥有层叠上下文属性的元素会被提升为单独的一层

第二点,需要剪裁(clip)的地方也会被创建为图层

文档中的层叠上下文由满足以下任意一个条件的元素形成:

- 文档根元素(

<html>) position值为absolute(绝对定位)或relative(相对定位)且z-index值不为auto的元素position值为fixed(固定定位)或sticky(粘滞定位)的元素(沾滞定位适配所有移动设备上的浏览器,但老的桌面浏览器不支持)- flex (

flexbox) 容器的子元素,且z-index值不为auto - grid (

grid) 容器的子元素,且z-index值不为auto opacity属性值小于1的元素(参见 the specification for opacity)mix-blend-mode属性值不为normal的元素- 以下任意属性值不为 none 的元素:

isolation属性值为isolate的元素-webkit-overflow-scrolling属性值为touch的元素will-change值设定了任一属性而该属性在 non-initial 值时会创建层叠上下文的元素(参考这篇文章)contain属性值为layout、paint或包含它们其中之一的合成值(比如contain: strict、contain: content)的元素

出现裁剪情况的时候,渲染引擎会为文字部分单独创建一个层,如果出现滚动条,滚动条也会被提升为单独的层

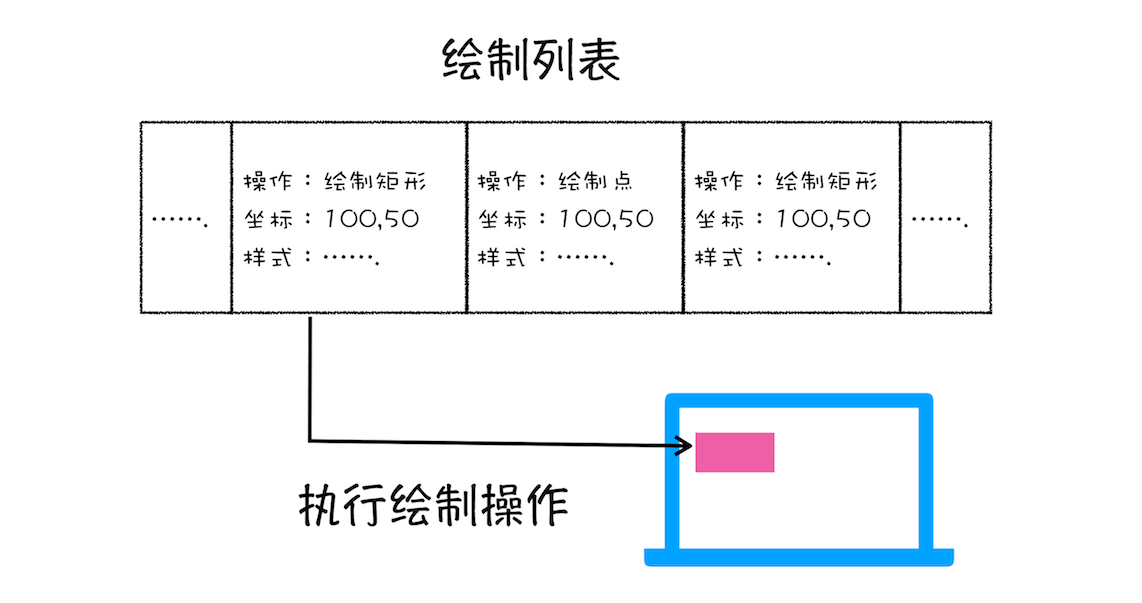

图层绘制

渲染引擎实现图层的绘制与之类似,会把一个图层的绘制拆分成很多小的绘制指令,然后再把这些指令按照顺序组成一个待绘制列表,如下图所示:

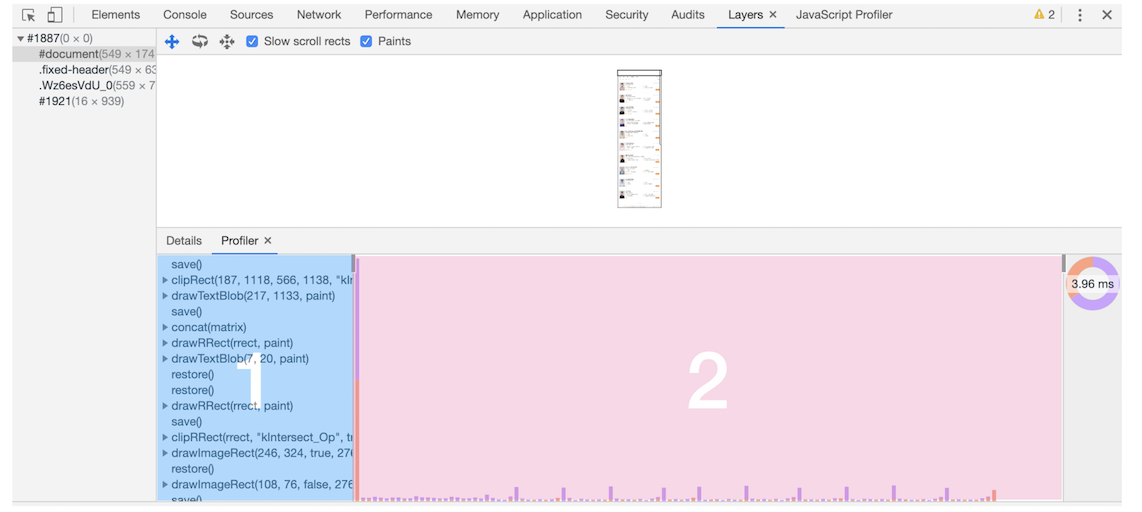

控制台 Layers 标签下 document 层可以看到绘制列表:

在该图中,区域 1 就是 document 的绘制列表,拖动区域 2 中的进度条可以重现列表的绘制过程

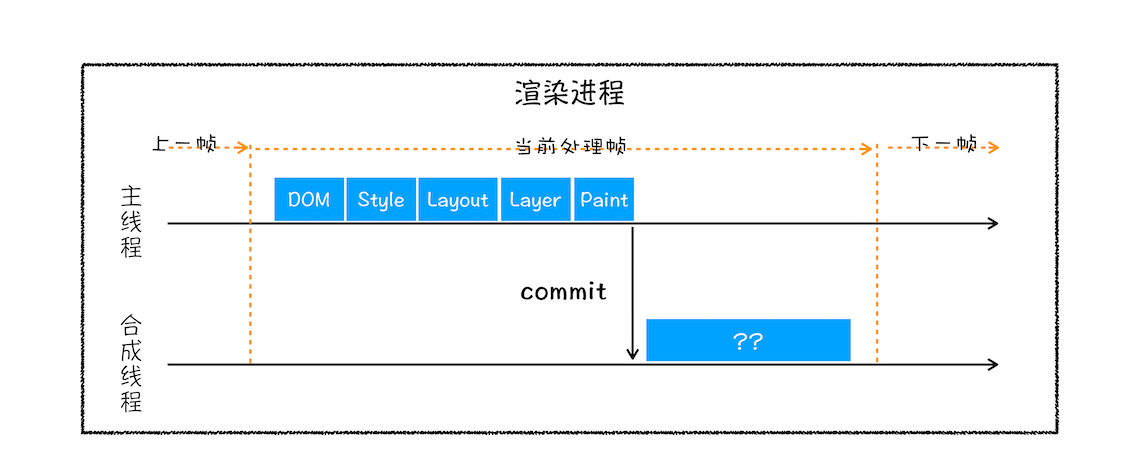

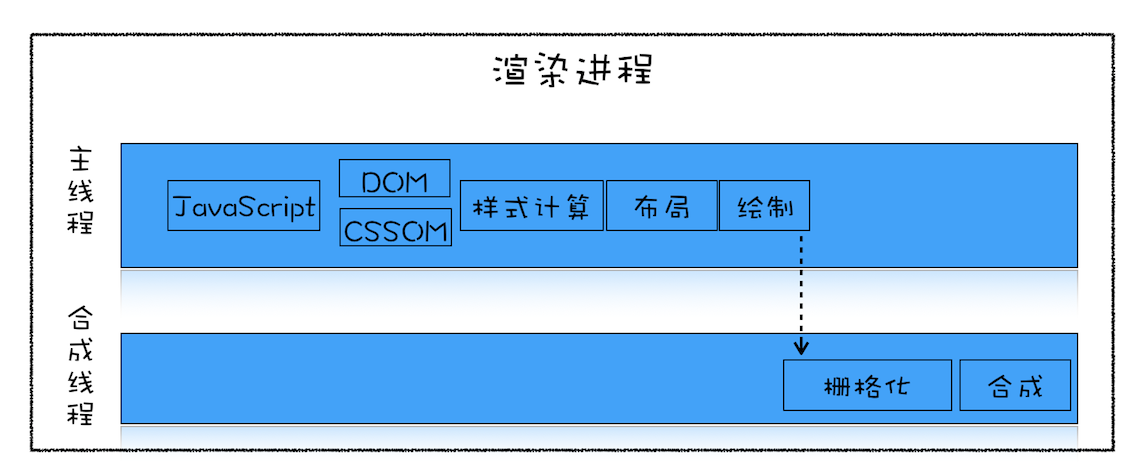

栅格化(raster)操作

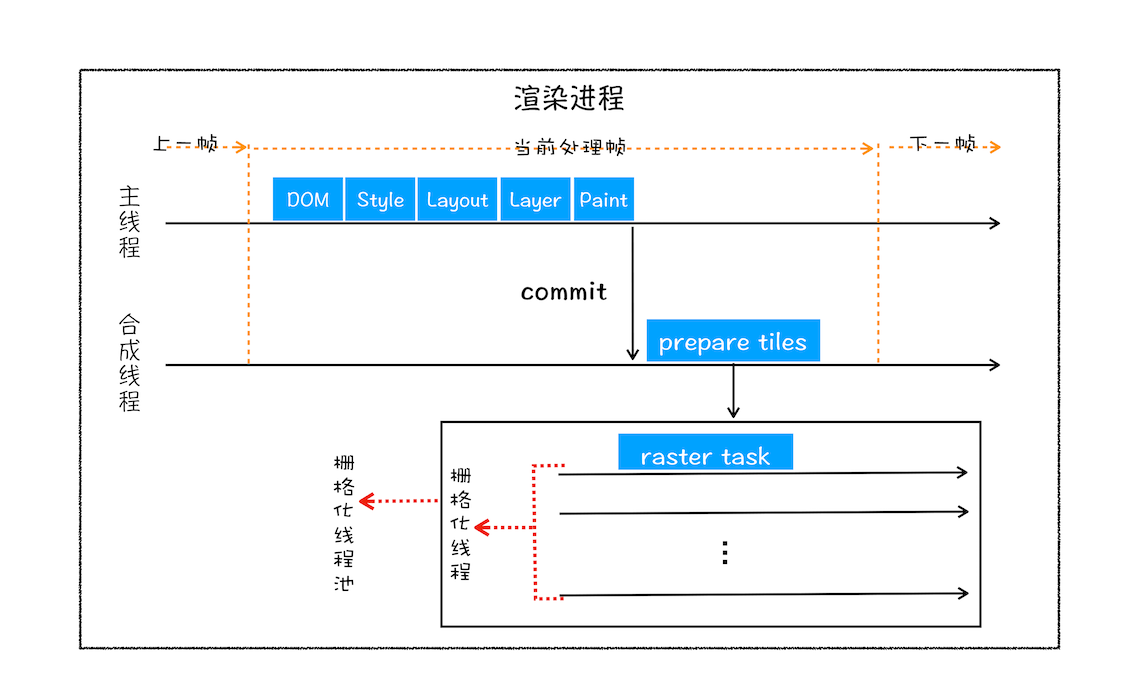

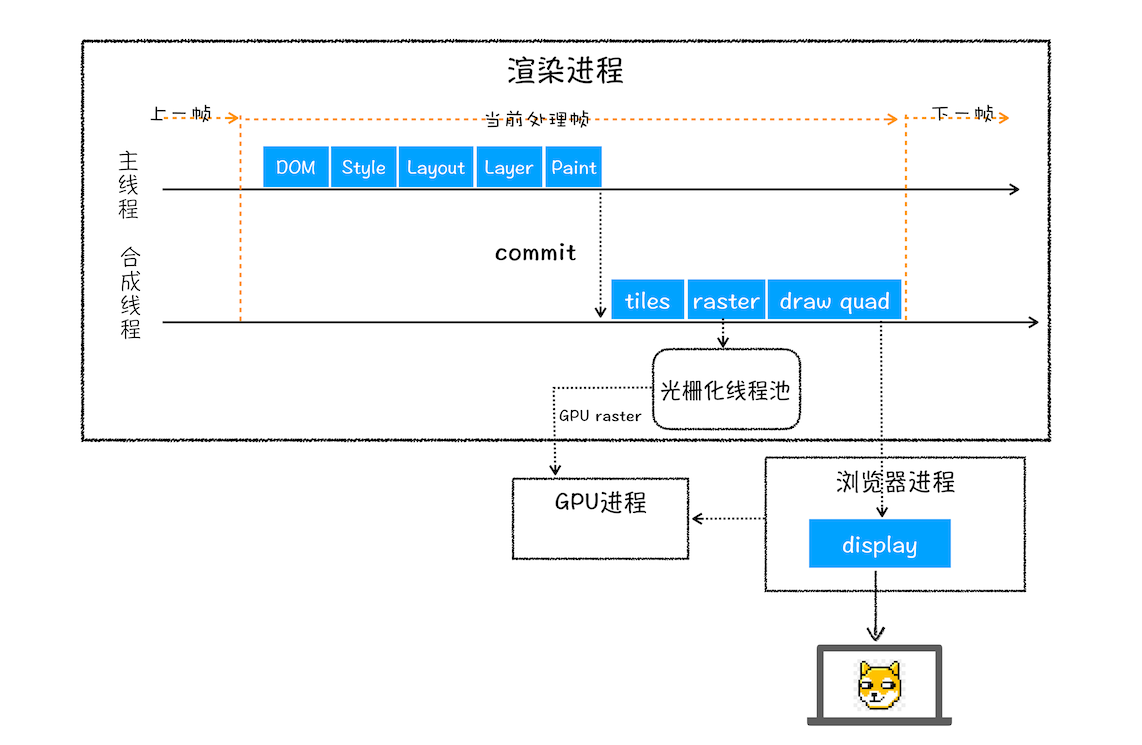

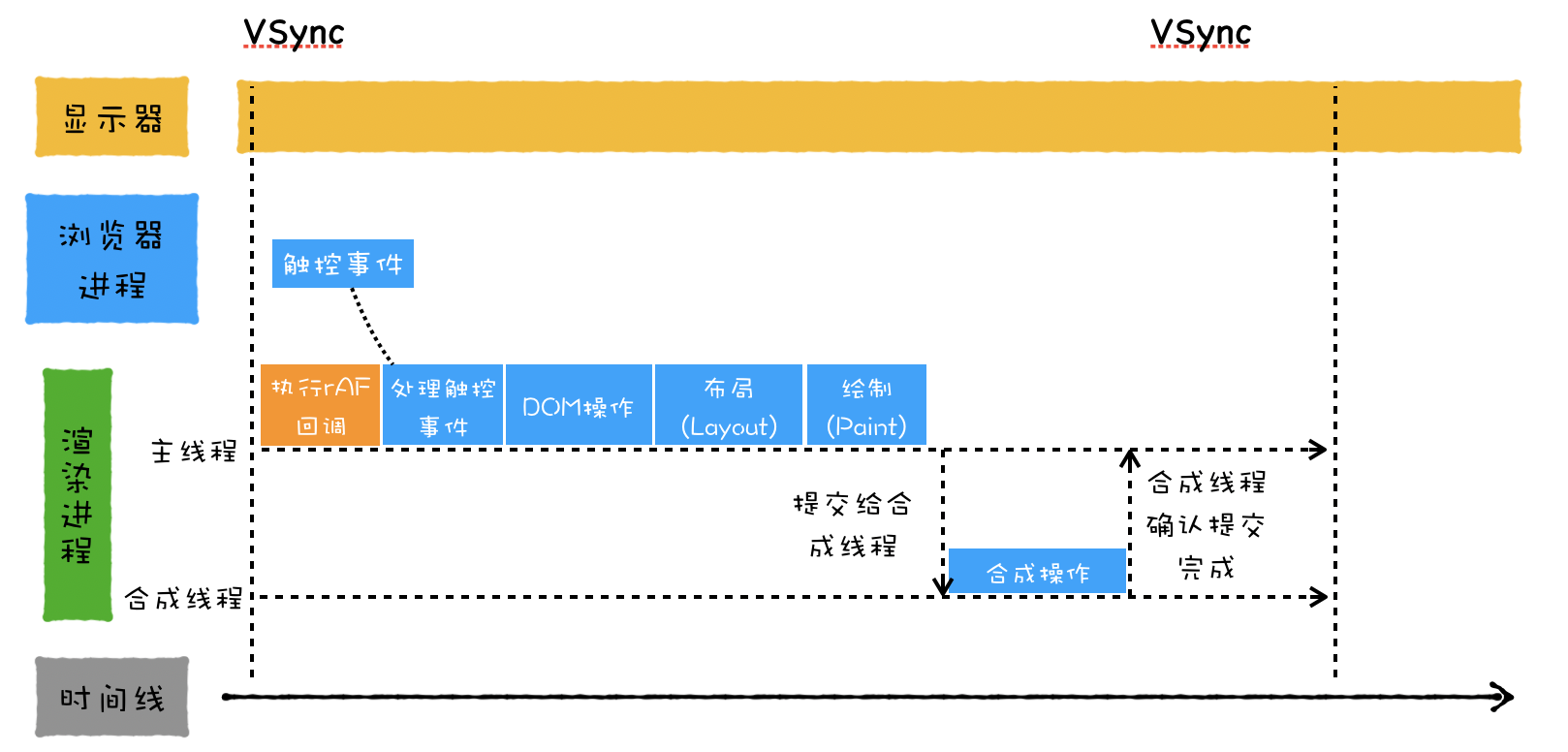

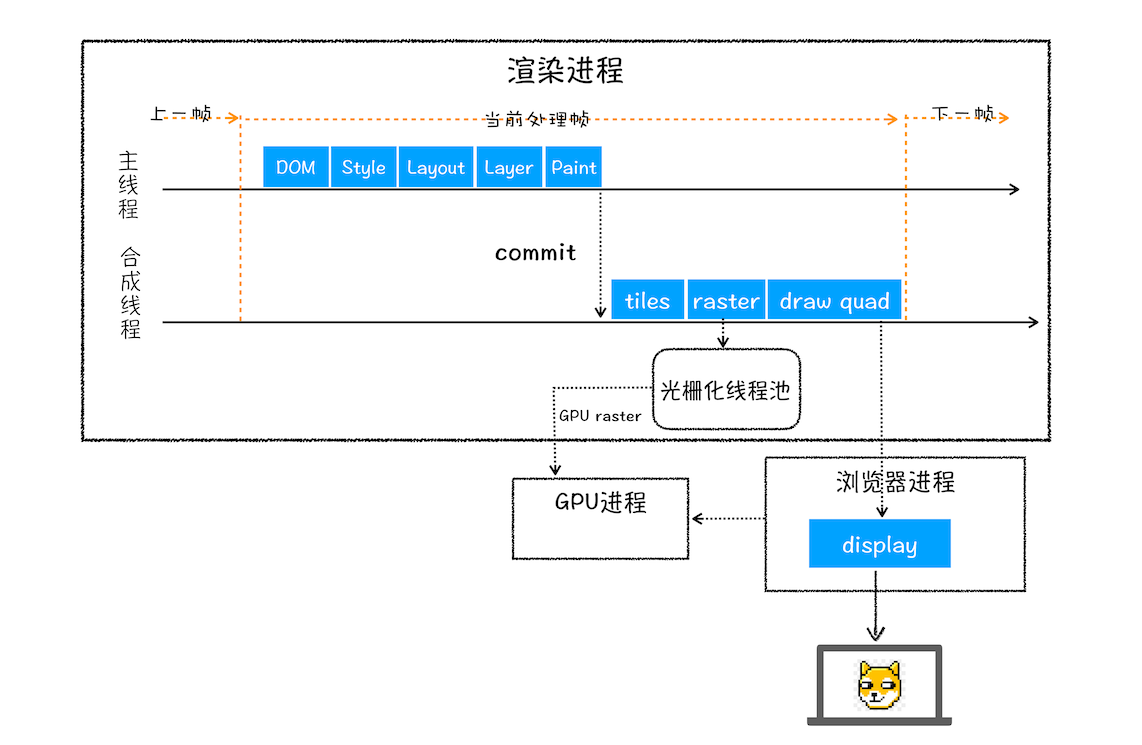

绘制列表只是用来记录绘制顺序和绘制指令的列表,而实际上绘制操作是由渲染引擎中的合成线程来完成的。你可以结合下图来看下渲染主线程和合成线程之间的关系:

如上图所示,当图层的绘制列表准备好之后,主线程会把该绘制列表**提交(commit)**给合成线程

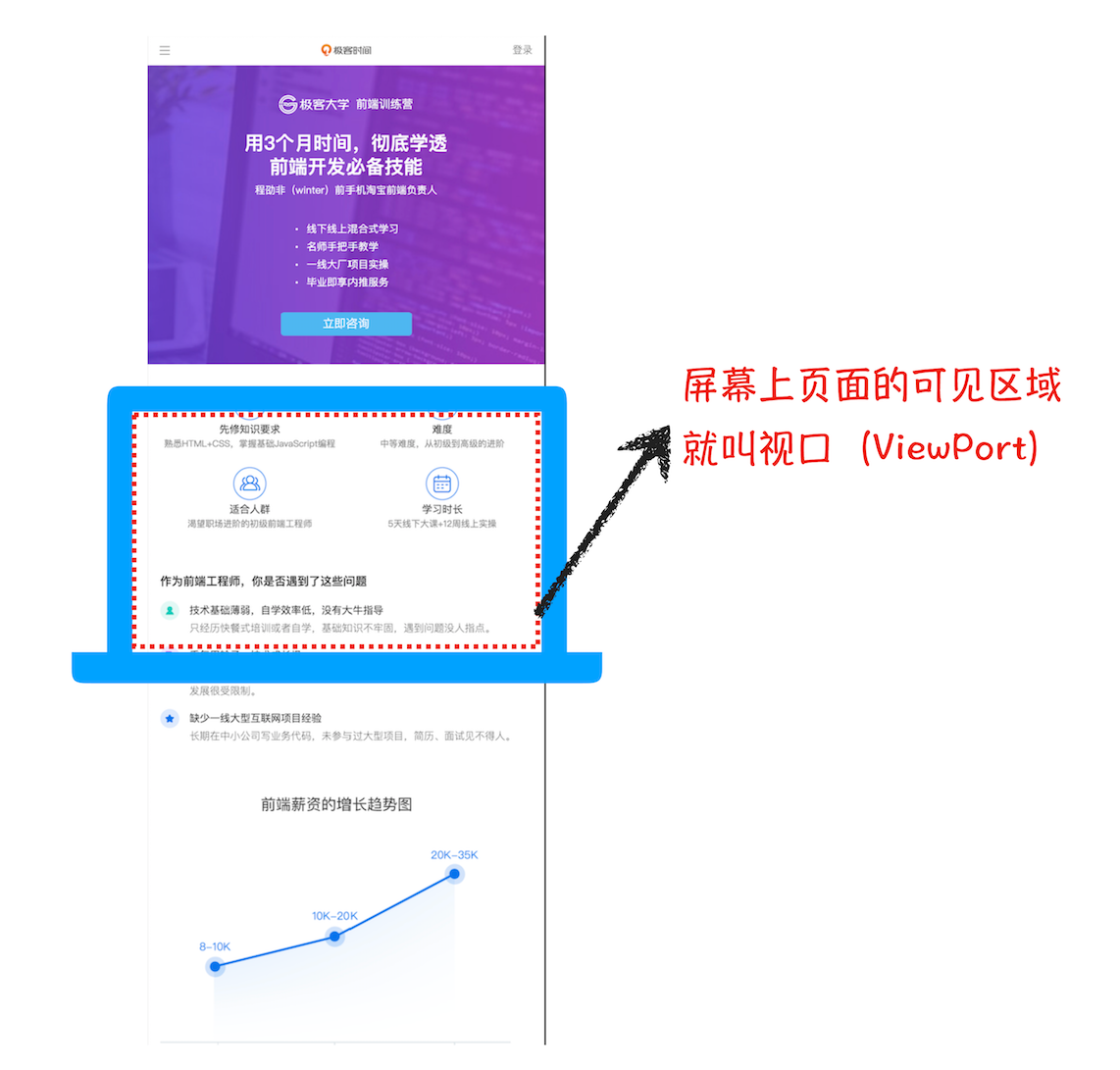

接下来合成线程是怎么工作的呢?那我们得先来看看什么是视口,你可以参看下图:

通常一个页面可能很大,但是用户只能看到其中的一部分,我们把用户可以看到的这个部分叫做视口(viewport)

在有些情况下,有的图层可以很大,比如有的页面你使用滚动条要滚动好久才能滚动到底部,但是通过视口,用户只能看到页面的很小一部分,所以在这种情况下,要绘制出所有图层内容的话,就会产生太大的开销,而且也没有必要

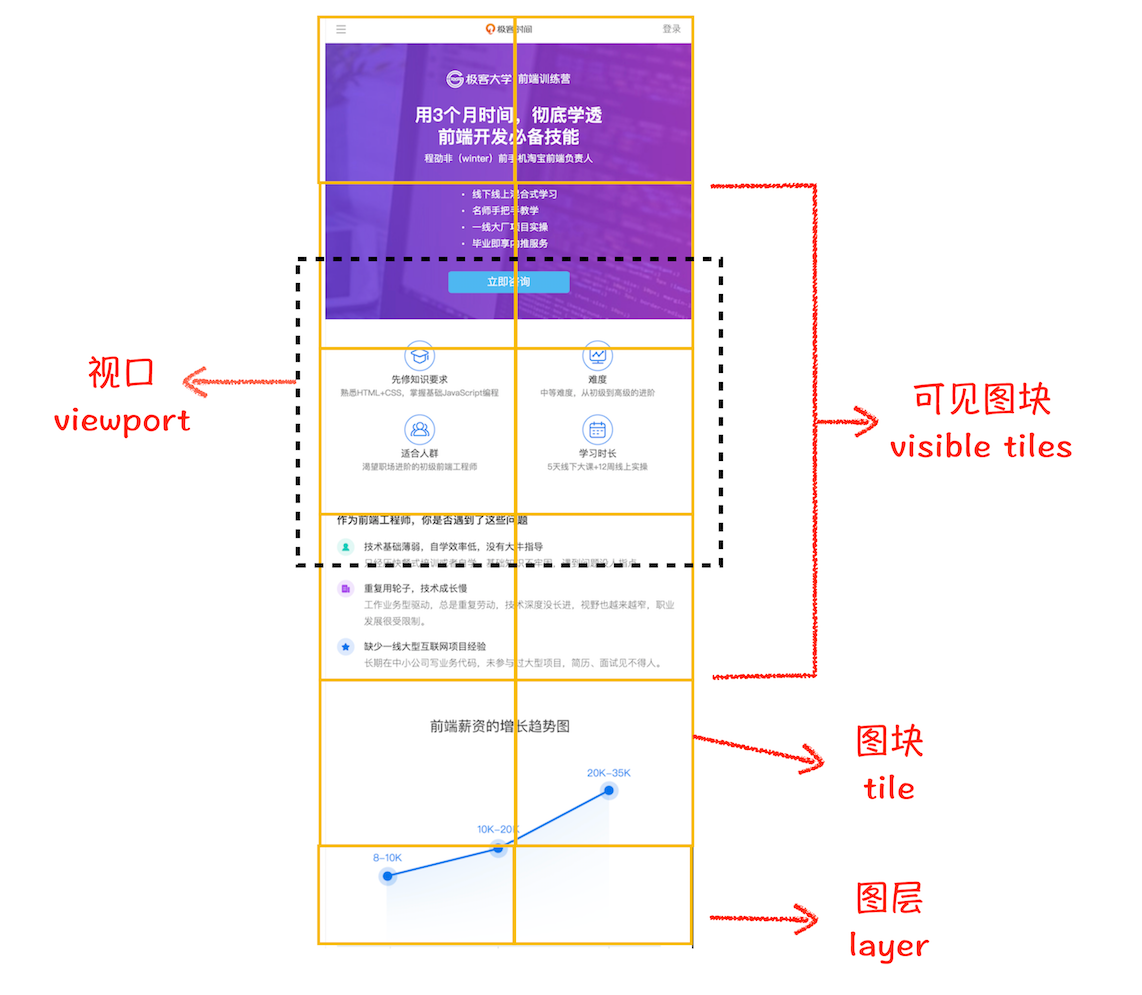

基于这个原因,合成线程会将图层划分为图块(tile),这些图块的大小通常是 256x256 或者 512x512,如下图所示:

然后合成线程会按照视口附近的图块来优先生成位图,实际生成位图的操作是由栅格化来执行的。所谓栅格化,是指将图块转换为位图。而图块是栅格化执行的最小单位。渲染进程维护了一个栅格化的线程池,所有的图块栅格化都是在线程池内执行的,运行方式如下图所示:

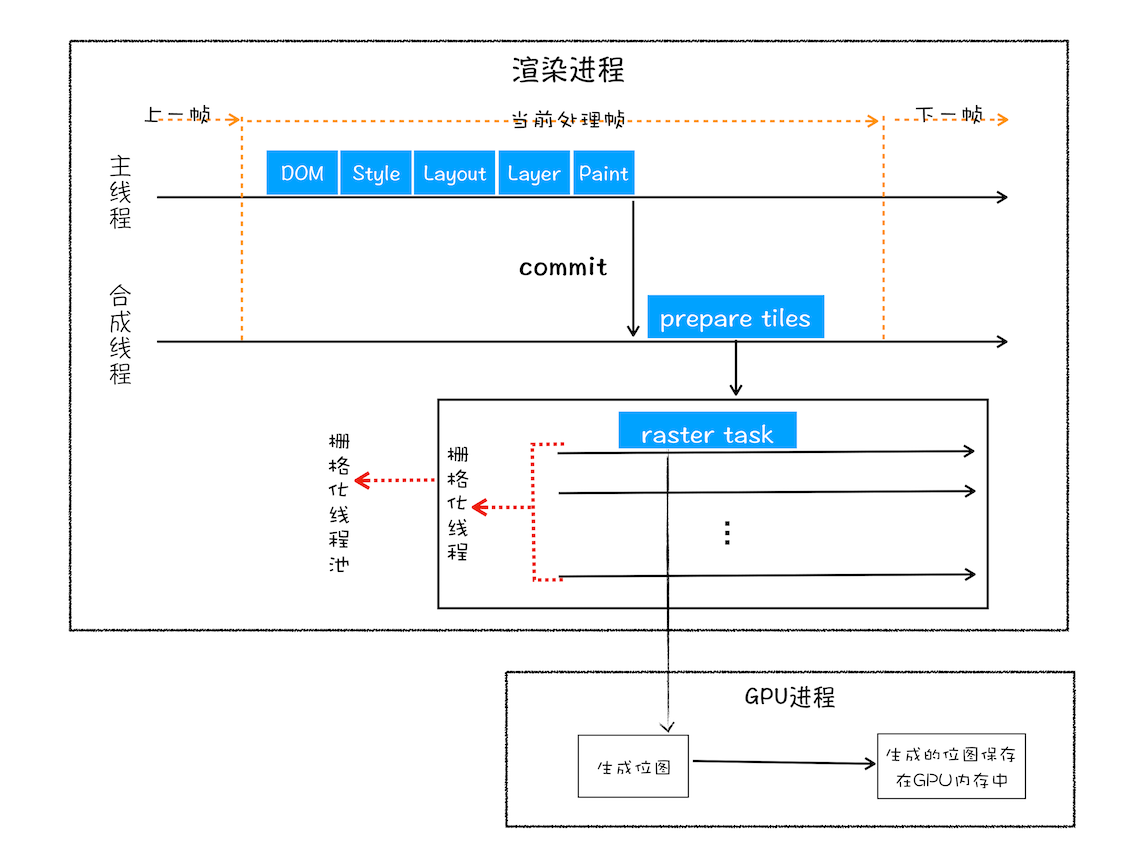

通常,栅格化过程都会使用 GPU 来加速生成,使用 GPU 生成位图的过程叫快速栅格化,或者 GPU 栅格化,生成的位图被保存在 GPU 内存中

如果栅格化操作使用了 GPU,终生成位图的操作是在 GPU 中完成的,这就涉及到了跨进程操作。具体形式你可以参考下图:

从图中可以看出,渲染进程把生成图块的指令发送给 GPU,然后在 GPU 中执行生成图块的位图,并保存在 GPU 的内存中

位图

位图图像(bitmap),亦称为点阵图像或栅格图像,是由称作像素(图片元素)的单个点组成的。这些点可以进行不同的排列和染色以构成图样。当放大位图时,可以看见赖以构成整个图像的无数单个方块。扩大位图尺寸的效果是增大单个像素,从而使线条和形状显得参差不齐。然而,如果从稍远的位置观看它,位图图像的颜色和形状又显得是连续的

合成和显示

一旦所有图块都被光栅化,合成线程就会生成一个绘制图块的命令——“DrawQuad”,然后将该命令提交给浏览器进程

浏览器进程里面有一个叫 viz 的组件,用来接收合成线程发过来的 DrawQuad 命令,然后根据 DrawQuad 命令,将其页面内容绘制到内存中,最后再将内存显示在屏幕上

渲染流水线大总结

总结下这整个渲染流程:

结合上图,一个完整的渲染流程大致可总结为如下:

1、渲染进程将 HTML 内容转换为能够读懂的 DOM 树结构

2、渲染引擎将 CSS 样式表转化为浏览器可以理解的 styleSheets,计算出 DOM 节点的样式

3、创建布局树,并计算元素的布局信息

4、对布局树进行分层,并生成分层树

5、为每个图层生成绘制列表,并将其提交到合成线程。

6、合成线程将图层分成图块,并在光栅化线程池中将图块转换成位图

7、合成线程发送绘制图块命令 DrawQuad 给浏览器进程

8、浏览器进程根据 DrawQuad 消息生成页面,并显示到显示器上。

相关概念

有了上面介绍渲染流水线的基础,我们再来看看三个和渲染流水线相关的概念——“重排”“重绘”和“合成”

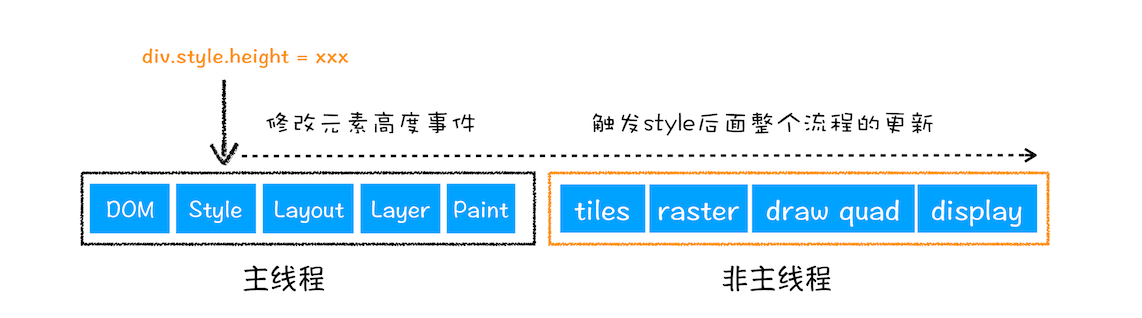

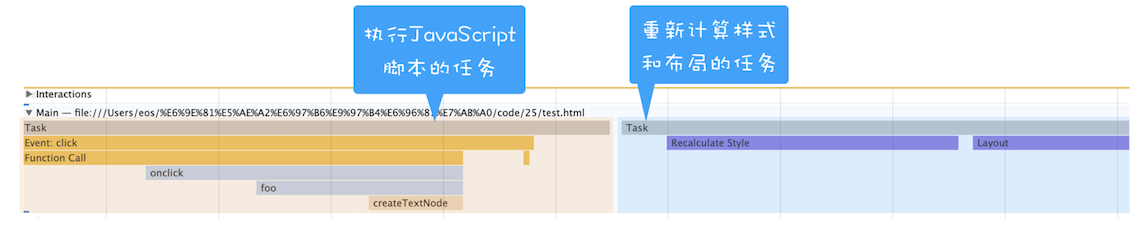

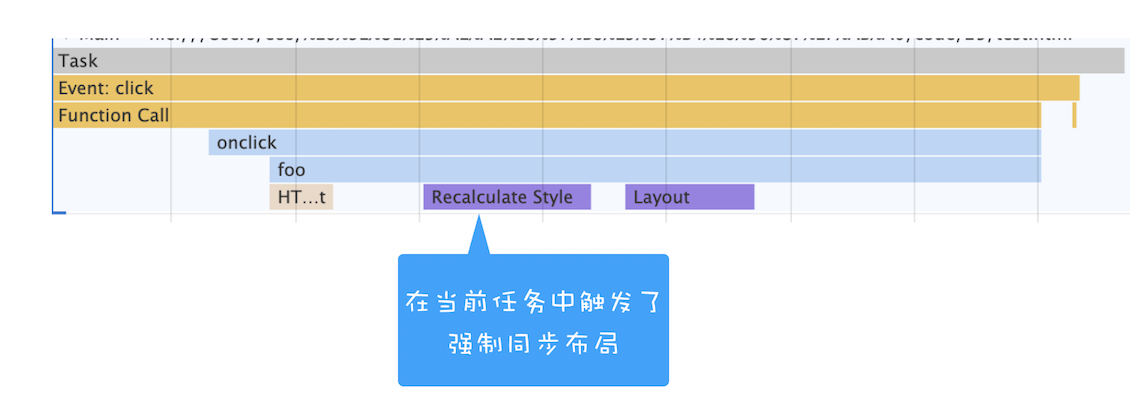

1、更新了元素的几何属性(重排)

从上图可以看出,如果你通过 JavaScript 或者 CSS 修改元素的几何位置属性,例如改变元素的宽度、高度等,那么浏览器会触发重新布局,解析之后的一系列子阶段,这个过程就叫重排。无疑,重排需要更新完整的渲染流水线,所以开销也是最大的

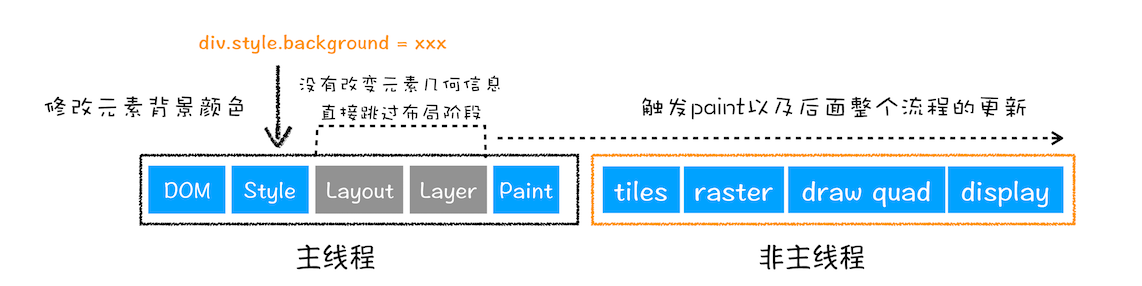

2、更新元素的绘制属性(重绘)

从图中可以看出,如果修改了元素的背景颜色,那么布局阶段将不会被执行,因为并没有引起几何位置的变换,所以就直接进入了绘制阶段,然后执行之后的一系列子阶段,这个过程就叫重绘。相较于重排操作,重绘省去了布局和分层阶段,所以执行效率会比重排操作要高一些

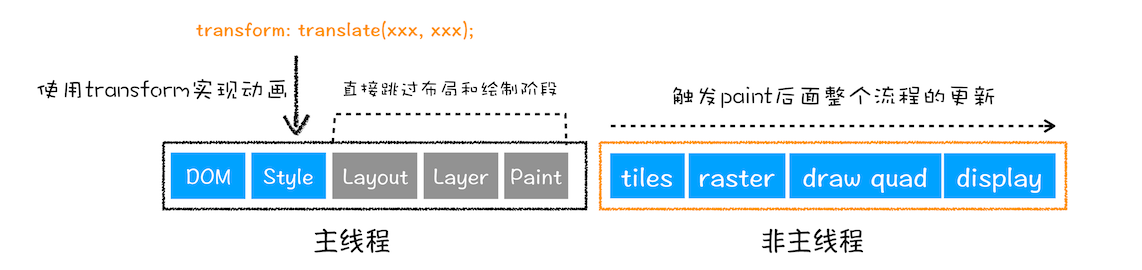

3、直接合成阶段

在上图中,我们使用了 CSS 的 transform 来实现动画效果,这可以避开重排和重绘阶段,直接在非主线程上执行合成动画操作。这样的效率是最高的,因为是在非主线程上合成,并没有占用主线程的资源,另外也避开了布局和绘制两个子阶段,所以相对于重绘和重排,合成能大大提升绘制效率

总结

Chrome 团队在不断添加新功能的同时,也在不断地重构一些子阶段,目的就是让整体渲染架构变得更加简单和高效,正所谓大道至简

通过这么多年的生活和工作经验来看,无论是做架构设计、产品设计,还是具体到代码的实现,甚至处理生活中的一些事情,能够把复杂问题简单化的人都是具有大智慧的

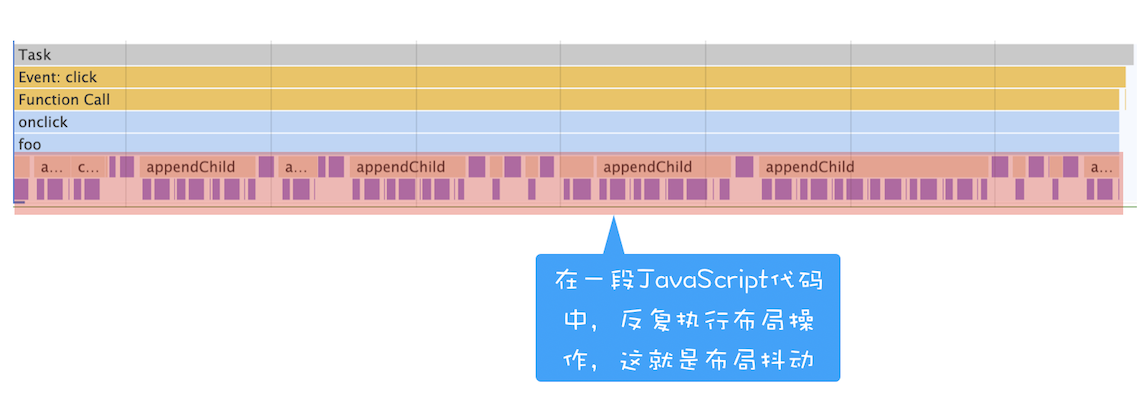

1、为什么减少重绘、重排能优化 Web 性能吗?那又有那些具体的实践方法能减少重绘、重排呢?

- 使用 class 操作样式,而不是频繁操作 style

- 避免使用 table 布局

- 批量 dom 操作,例如 createDocumentFragment,或者使用框架,例如 React

- Debounce window resize 事件

- 对 dom 属性的读写要分离

- will-change: transform 做优化

变量提升(Hoisting)

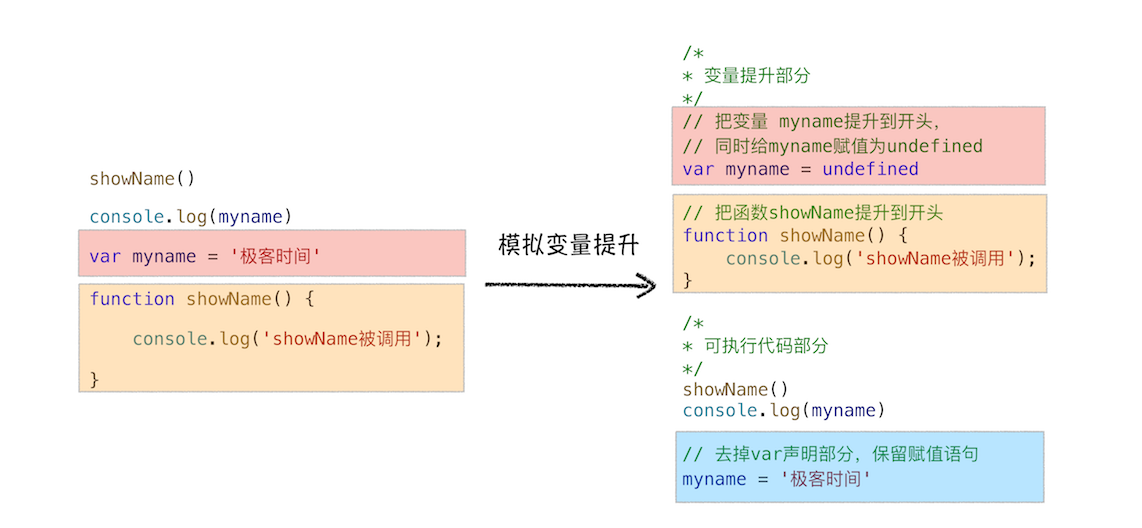

模拟变量提升

从图中可以看出,对原来的代码主要做了两处调整:

- 第一处是把声明的部分都提升到了代码开头,如变量 myname 和函数 showName,并给变量设置默认值 undefined;

- 第二处是移除原本声明的变量和函数,如 var myname = '极客时间'的语句,移除了 var 声明,整个移除 showName 的函数声明。

通过这段模拟的变量提升代码,相信你已经明白了可以在定义之前使用变量或者函数的原因——函数和变量在执行之前都提升到了代码开头

JavaScript 代码的执行流程

实际上变量和函数声明在代码里的位置是不会改变的,而且是在编译阶段被 JavaScript 引擎放入内存中,一段 JavaScript 代码在执行之前需要被 JavaScript 引擎编译,编译完成之后,才会进入执行阶段

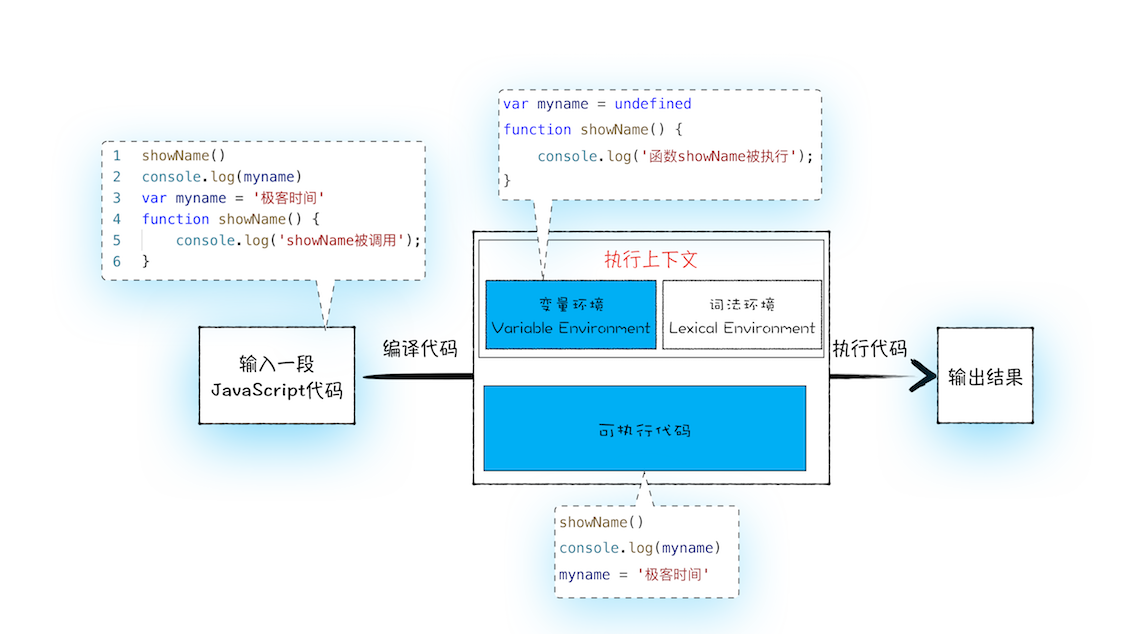

1.编译阶段

第一部分:变量提升部分的代码

第二部分:执行部分的代码

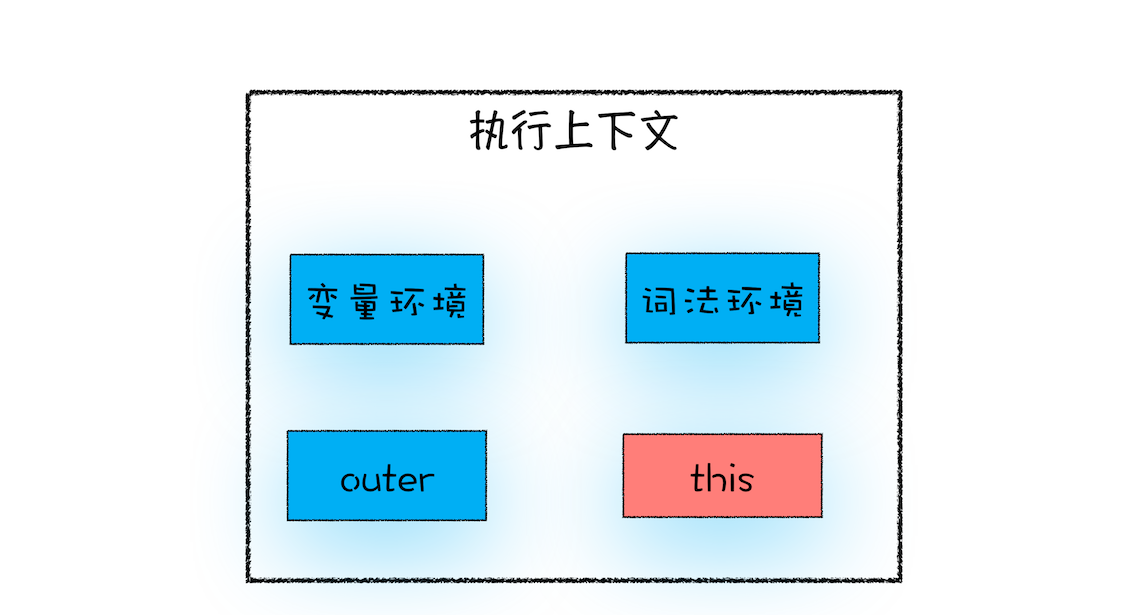

从上图可以看出,输入一段代码,经过编译后,会生成两部分内容:执行上下文(Execution context)和可执行代码

在执行上下文中存在一个变量环境的对象(Viriable Environment),该对象中保存了变量提升的内容,比如上面代码中的变量 myname 和函数 showName,都保存在该对象中

JavaScript 引擎发现了一个通过 function 定义的函数(例如 showName 函数),然后它将函数定义存储到堆 (HEAP)中,并在环境对象中创建一个 showName 的属性,然后将该属性值指向堆中函数的位置

2.执行阶段

JavaScript 引擎开始执行“可执行代码”,按照顺序一行一行地执行

同名函数

一段代码如果定义了两个相同名字的函数,那么最终生效的是最后一个函数,因为后定义的函数将会覆盖之前定义的函数

总结

- JavaScript 代码执行过程中,需要先做变量提升,而之所以需要实现变量提升,是因为 JavaScript 代码在执行之前需要先编译

- 在编译阶段,变量和函数会被存放到变量环境中,变量的默认值会被设置为 undefined

- 在代码执行阶段,JavaScript 引擎会从变量环境中去查找自定义的变量和函数

- 如果在编译阶段,存在两个相同的函数,那么最终存放在变量环境中的是最后定义的那个,这是因为后定义的会覆盖掉之前定义的

JavaScript 代码在浏览器中是:先编译,后执行

调用栈

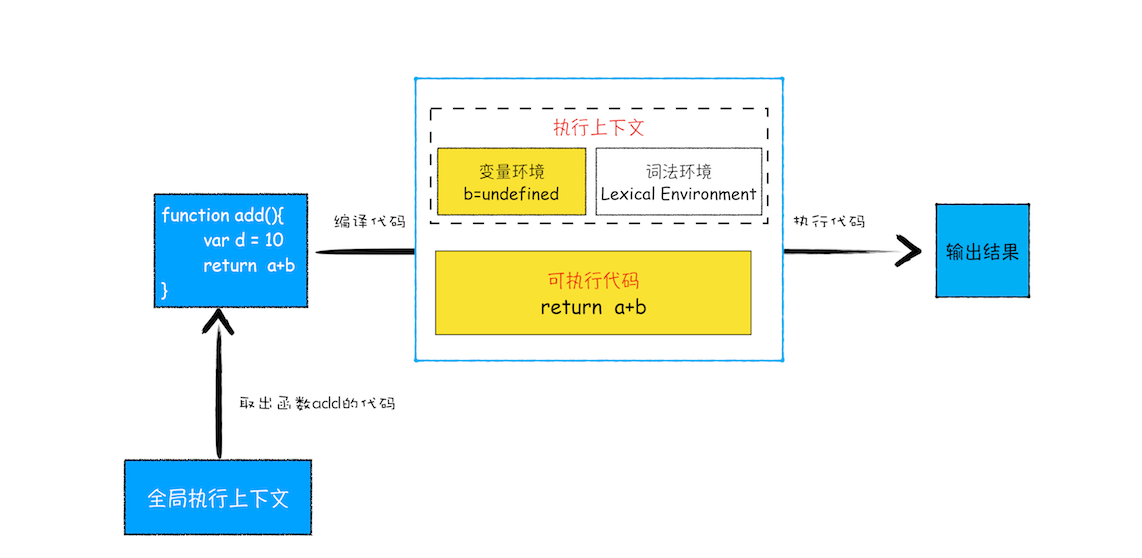

哪些情况下代码才会在执行之前就进行编译并创建执行上下文。一般说来,有这么三种情况:

1、当 JavaScript 执行全局代码的时候,会编译全局代码并创建全局执行上下文,而且在整个页面的生存周期内,全局执行上下文只有一份

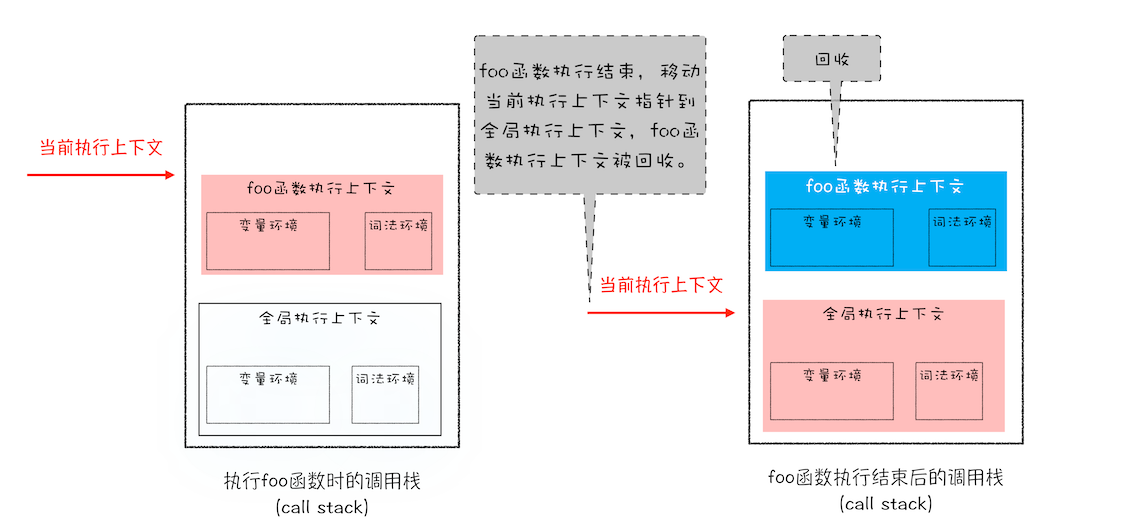

2、当调用一个函数的时候,函数体内的代码会被编译,并创建函数执行上下文,一般情况下,函数执行结束之后,创建的函数执行上下文会被销毁

3、当使用 eval 函数的时候,eval 的代码也会被编译,并创建执行上下文。

JavaScript 中有很多函数,经常会出现在一个函数中调用另外一个函数的情况,调用栈就是用来管理函数调用关系的一种数据结构。因此要讲清楚调用栈,还要先弄明白函数调用和栈结构

函数调用

JavaScript 引擎通过一种叫栈的数据结构来管理的多个执行上下文,一般称之为执行上下文栈,又称调用栈

调用栈过程

以下面的代码为例:

var a = 2;

function add(b, c) {

return b + c;

}

function addAll(b, c) {

var d = 10;

result = add(b, c);

return a + result + d;

}

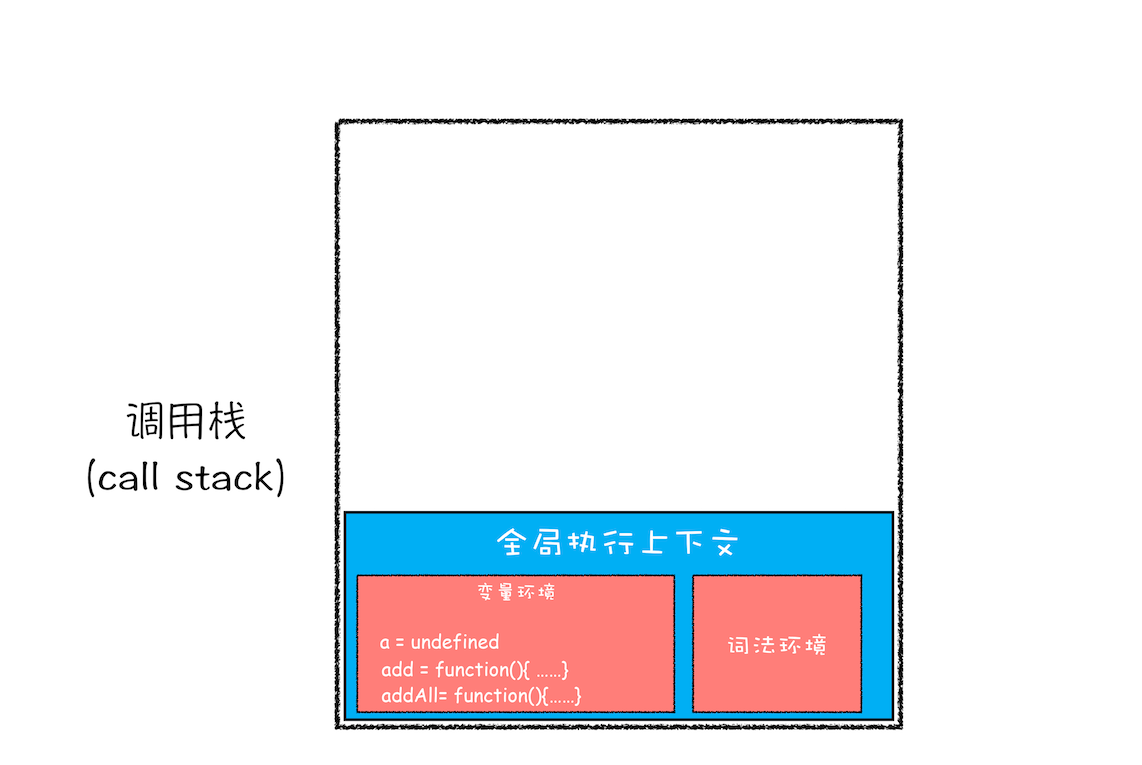

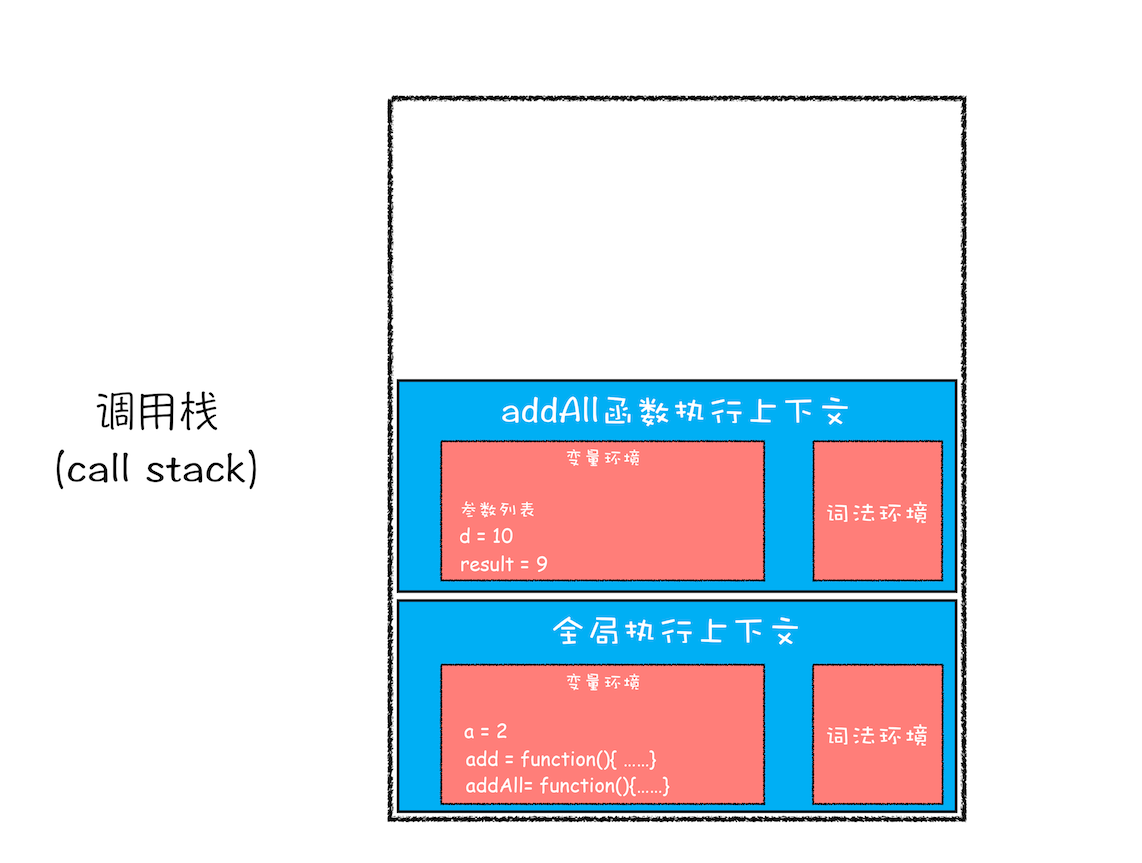

addAll(3, 6);第一步,创建全局上下文,并将其压入栈底

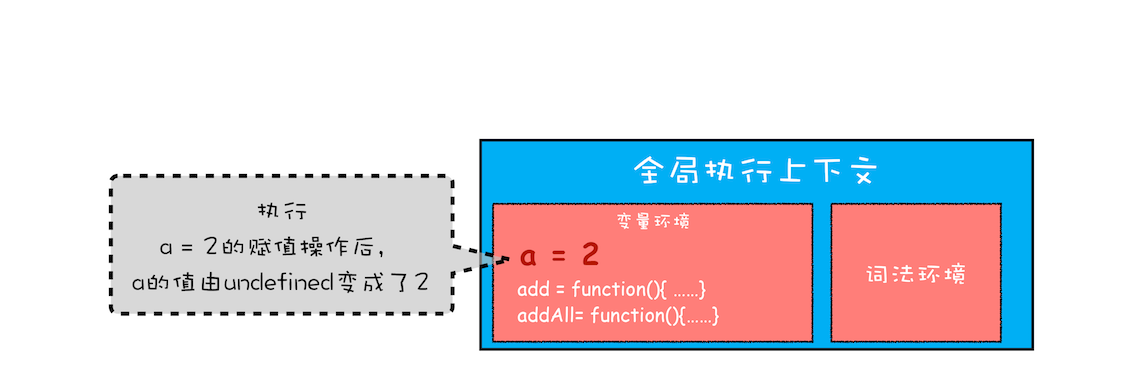

然后 js 引擎就会执行全局代码了,首先是变量 a 的赋值操作,该执行语句会将变量环境里 a 的值设置为 2

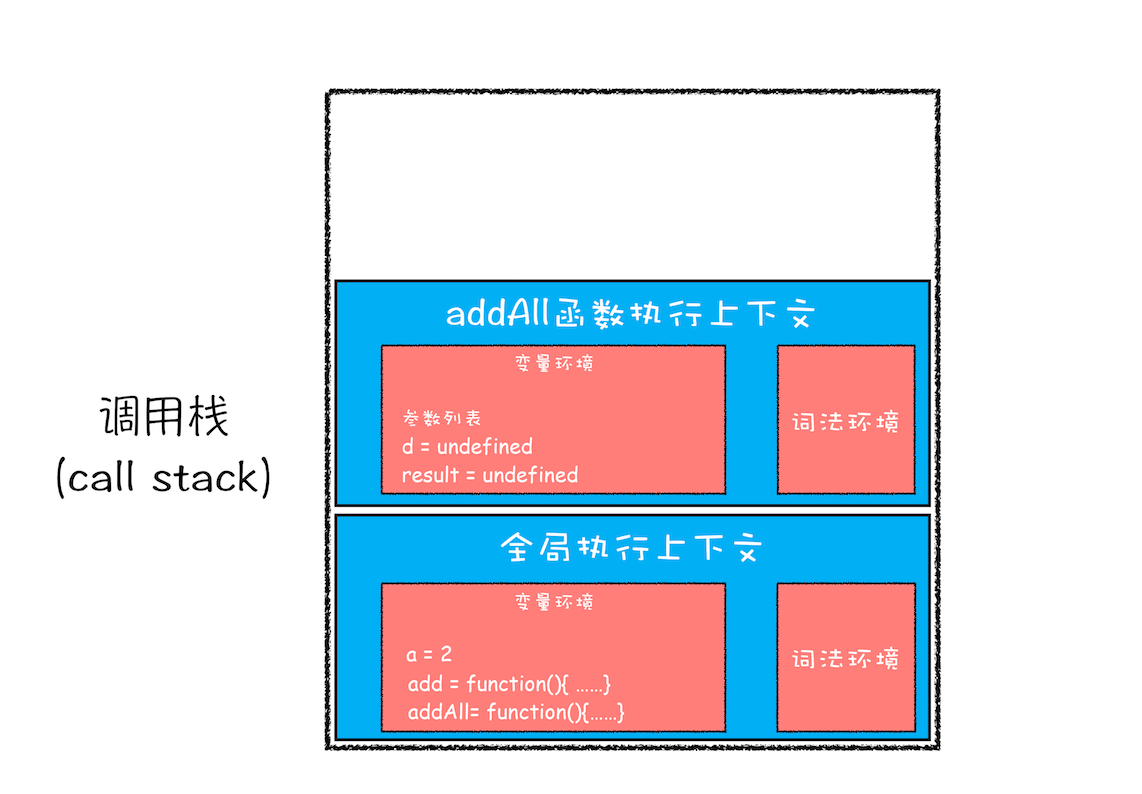

第二步是调用 addAll 函数。当调用该函数时,JavaScript 引擎会编译该函数,并为其创建一个执行上下文,最后还将该函数的执行上下文压入栈中

addAll 函数的执行上下文创建好之后,便进入了函数代码的执行阶段了,这里先执行的是 d=10 的赋值操作,执行语句会将 addAll 函数执行上下文中的 d 由 undefined 变成了 10

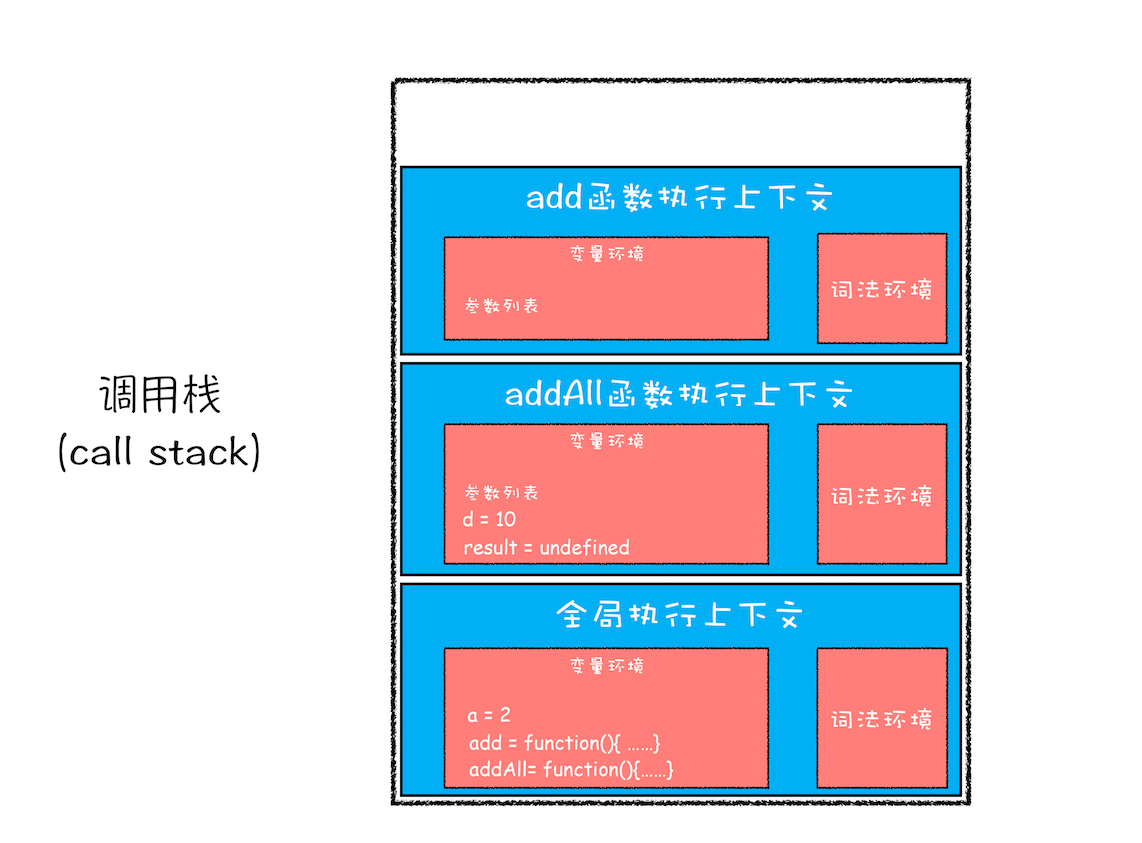

第三步,当执行到 add 函数调用语句时,同样会为其创建执行上下文,并将其压入调用栈,如下图所示:

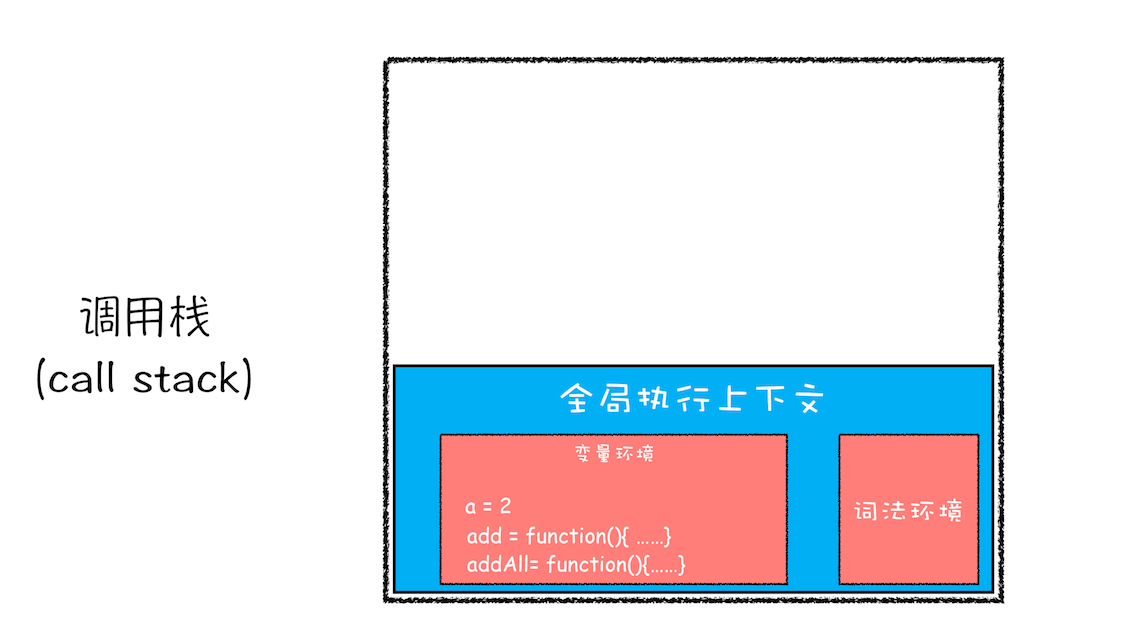

当 add 函数返回时,该函数的执行上下文就会从栈顶弹出,并将 result 的值设置为 add 函数的返回值,也就是 9

紧接着 addAll 执行最后一个相加操作后并返回,addAll 的执行上下文也会从栈顶部弹出,此时调用栈中就只剩下全局上下文了

调用栈是 JavaScript 引擎追踪函数执行的一个机制,当一次有多个函数被调用时,通过调用栈就能够追踪到哪个函数正在被执行以及各函数之间的调用关系

在开发中,如何利用好调用栈

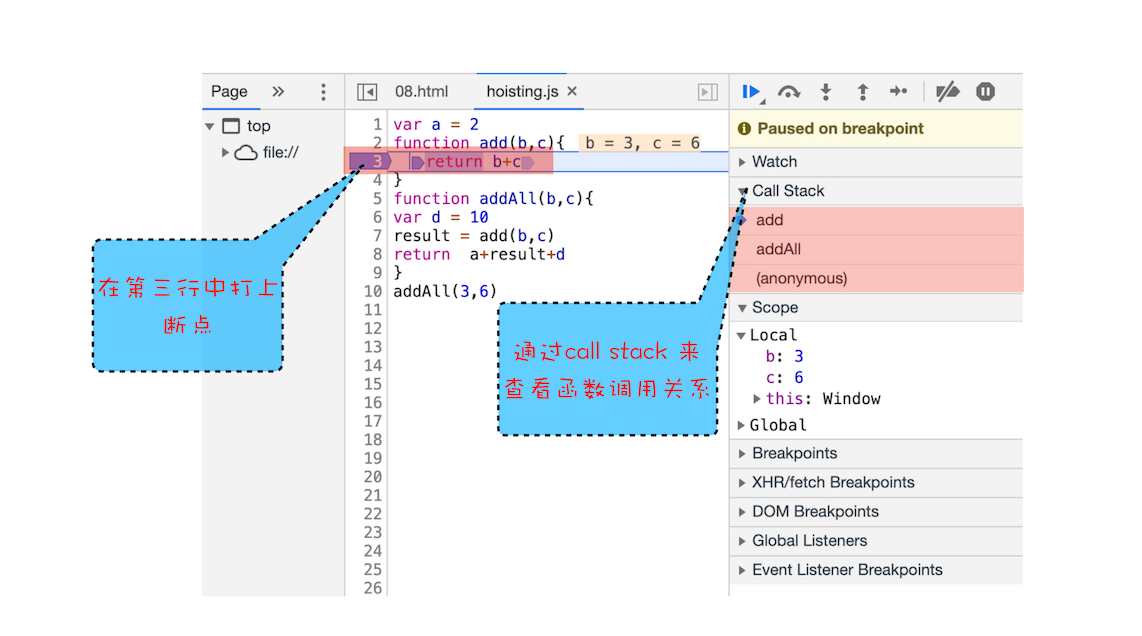

1.如何利用浏览器查看调用栈的信息

你可以打开“开发者工具”,点击“Source”标签,选择 JavaScript 代码的页面,然后在某一行加上断点,并刷新页面。你可以看到执行到相关函数时,执行流程就暂停了,这时可以通过右边“call stack”来查看当前的调用栈的情况

栈的最底部是 anonymous,也就是全局的函数入口;中间是 addAll 函数;顶部是 add 函数。这就清晰地反映了函数的调用关系

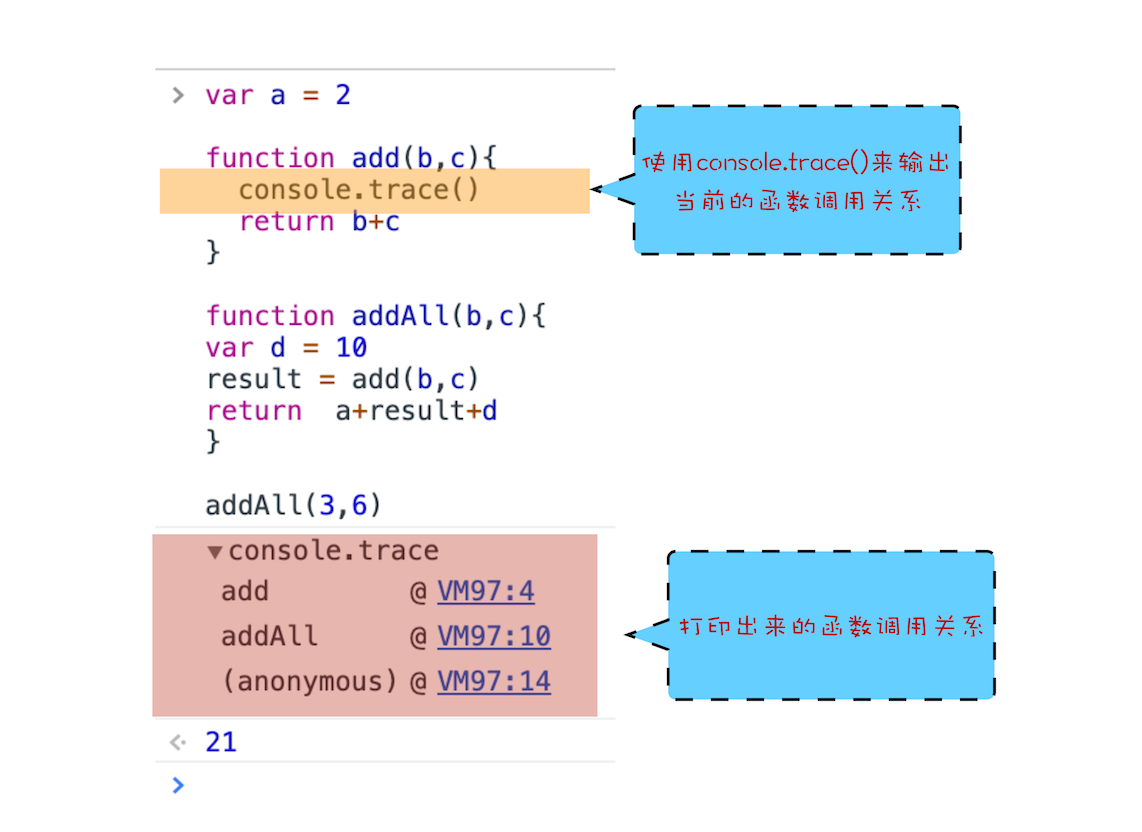

除了通过断点来查看调用栈,你还可以使用 console.trace() 来输出当前的函数调用关系,比如在示例代码中的 add 函数里面加上了 console.trace(),你就可以看到控制台输出的结果

2.栈溢出(Stack Overflow)

调用栈是有大小的,当入栈的执行上下文超过一定数目,JavaScript 引擎就会报错,我们把这种错误叫做栈溢出

可以使用一些方法来避免或者解决栈溢出的问题,比如把递归调用的形式改造成其他形式,或者使用加入定时器的方法来把当前任务拆分为其他很多小任务(为什么定时器能够避免栈溢出,请看这篇文章:https://juejin.im/post/5d2d146bf265da1b9163c5c9#heading-15)

总结

- 每调用一个函数,JavaScript 引擎会为其创建执行上下文,并把该执行上下文压入调用栈,然后 JavaScript 引擎开始执行函数代码

- 如果在一个函数 A 中调用了另外一个函数 B,那么 JavaScript 引擎会为 B 函数创建执行上下文,并将 B 函数的执行上下文压入栈顶

- 当前函数执行完毕后,JavaScript 引擎会将该函数的执行上下文弹出栈

- 当分配的调用栈空间被占满时,会引发“堆栈溢出”问题。

块级作用域

正是由于 JavaScript 存在变量提升这种特性,从而导致了很多与直觉不符的代码,这也是 JavaScript 的一个重要设计缺陷

我们先“探病因”——为什么在 JavaScript 中会存在变量提升,以及变量提升所带来的问题;然后再来“开药方”——如何通过块级作用域并配合 let 和 const 关键字来修复这种缺陷

作用域(scope)

作用域是指在程序中定义变量的区域,该位置决定了变量的生命周期。通俗地理解,作用域就是变量与函数的可访问范围,即作用域控制着变量和函数的可见性和生命周期

在 ES6 之前,ES 的作用域只有两种:全局作用域和函数作用域

- 全局作用域中的对象在代码中的任何地方都能访问,其生命周期伴随着页面的生命周期

- 函数作用域就是在函数内部定义的变量或者函数,并且定义的变量或者函数只能在函数内部被访问。函数执行结束之后,函数内部定义的变量会被销毁

在 ES6 之前,JavaScript 只支持这两种作用域,相较而言,其他语言则都普遍支持块级作用域。块级作用域就是使用一对大括号包裹的一段代码,比如函数、判断语句、循环语句,甚至单独的一个{}都可以被看作是一个块级作用域

如果一种语言支持块级作用域,那么其代码块内部定义的变量在代码块外部是访问不到的,并且等该代码块中的代码执行完成之后,代码块中定义的变量会被销毁

和 Java、C/C++ 不同,ES6 之前是不支持块级作用域的,因为当初设计这门语言的时候,并没有想到 JavaScript 会火起来,所以只是按照最简单的方式来设计。没有了块级作用域,再把作用域内部的变量统一提升无疑是最快速、最简单的设计,不过这也直接导致了函数中的变量无论是在哪里声明的,在编译阶段都会被提取到执行上下文的变量环境中,所以这些变量在整个函数体内部的任何地方都是能被访问的,这也就是 JavaScript 中的变量提升

变量提升所带来的问题

1.变量容易在不被察觉的情况下被覆盖掉

var myname = "极客时间";

function showName() {

console.log(myname); //undefined

if (0) {

var myname = "极客邦";

}

console.log(myname); //极客邦

}

showName();2.本应销毁的变量没有被销毁

function foo() {

for (var i = 0; i < 7; i++) {}

console.log(i); //7

}

foo();如果你使用 C 语言或者其他的大部分语言实现类似代码,在 for 循环结束之后,i 就已经被销毁了,但是在 JavaScript 代码中,i 的值并未被销毁,所以最后打印出来的是 7

这同样也是由变量提升而导致的,在创建执行上下文阶段,变量 i 就已经被提升了,所以当 for 循环结束之后,变量 i 并没有被销毁

ES6 是如何解决变量提升带来的缺陷

为了解决这些问题,ES6 引入了 let 和 const 关键字,从而使 JavaScript 也能像其他语言一样拥有了块级作用域

使用 let 关键字声明的变量是可以被改变的,而使用 const 声明的变量其值是不可以被改变的,两者都可以生成块级作用域

作用域块内声明的变量不影响块外面的变量

JavaScript 是如何支持块级作用域的

在同一段代码中,ES6 是如何做到既要支持变量提升的特性,又要支持块级作用域的呢?

我们就要站在执行上下文的角度来揭开答案

示例代码:

function foo() {

var a = 1;

let b = 2;

{

let b = 3;

var c = 4;

let d = 5;

console.log(a);

console.log(b);

}

console.log(b);

console.log(c);

console.log(d);

}

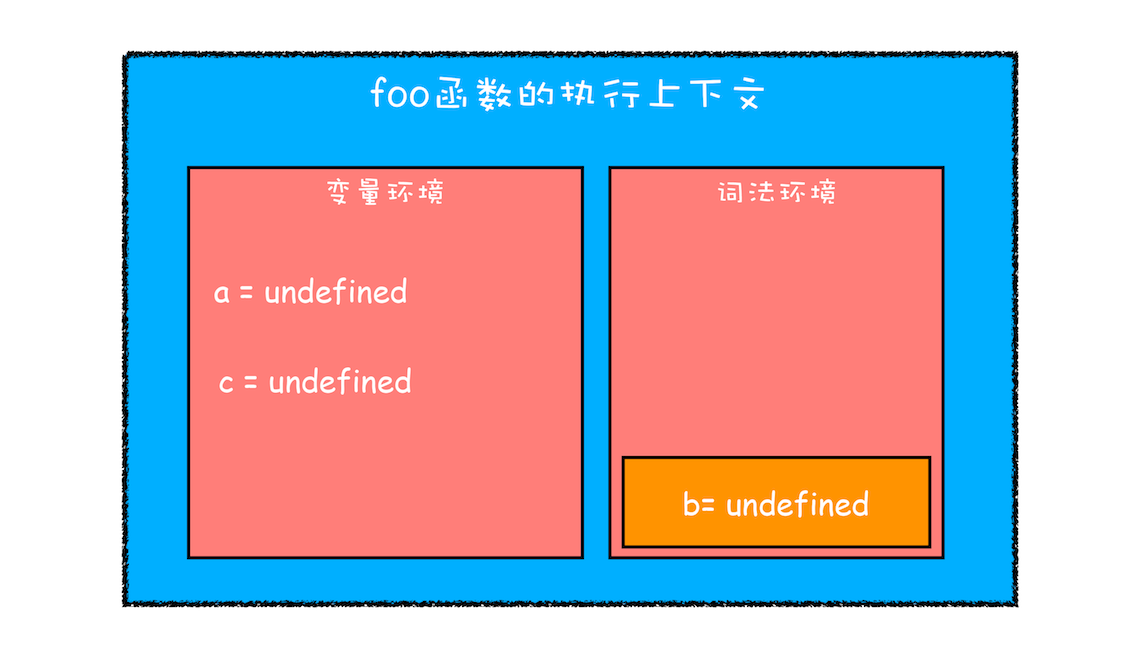

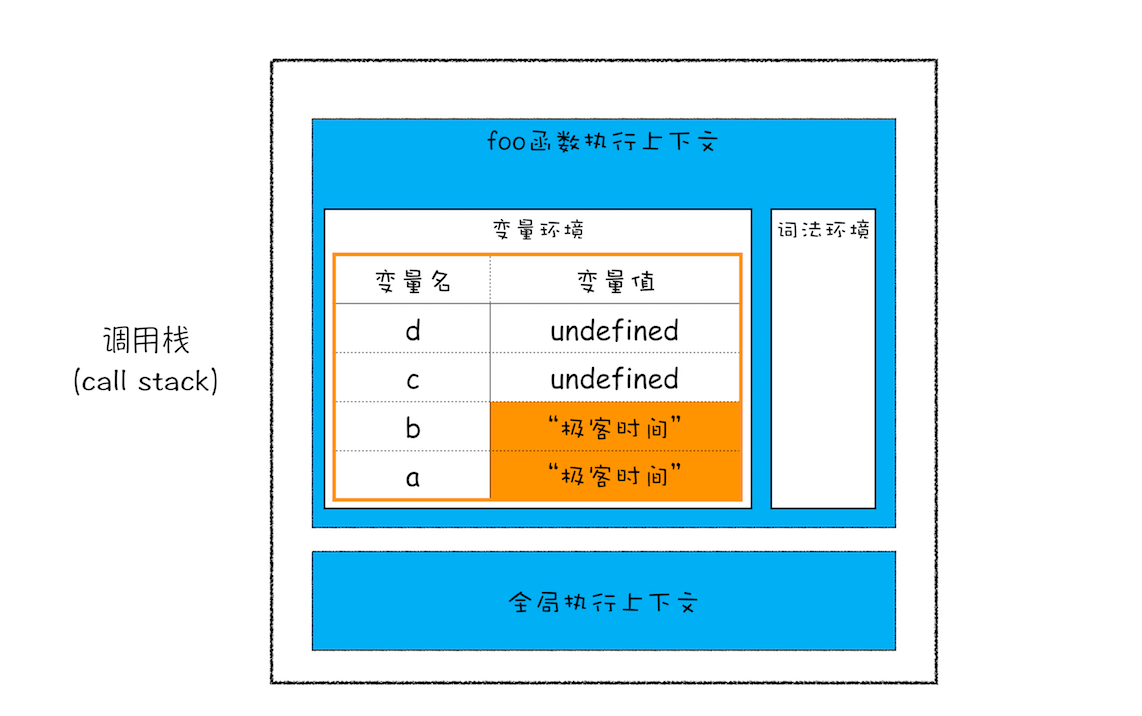

foo();第一步是编译并创建执行上下文

- 函数内部通过 var 声明的变量,在编译阶段全都被存放到变量环境里面了

- 通过 let 声明的变量,在编译阶段会被存放到词法环境(Lexical Environment)中

- 在函数的作用域块内部,通过 let 声明的变量并没有被存放到词法环境中

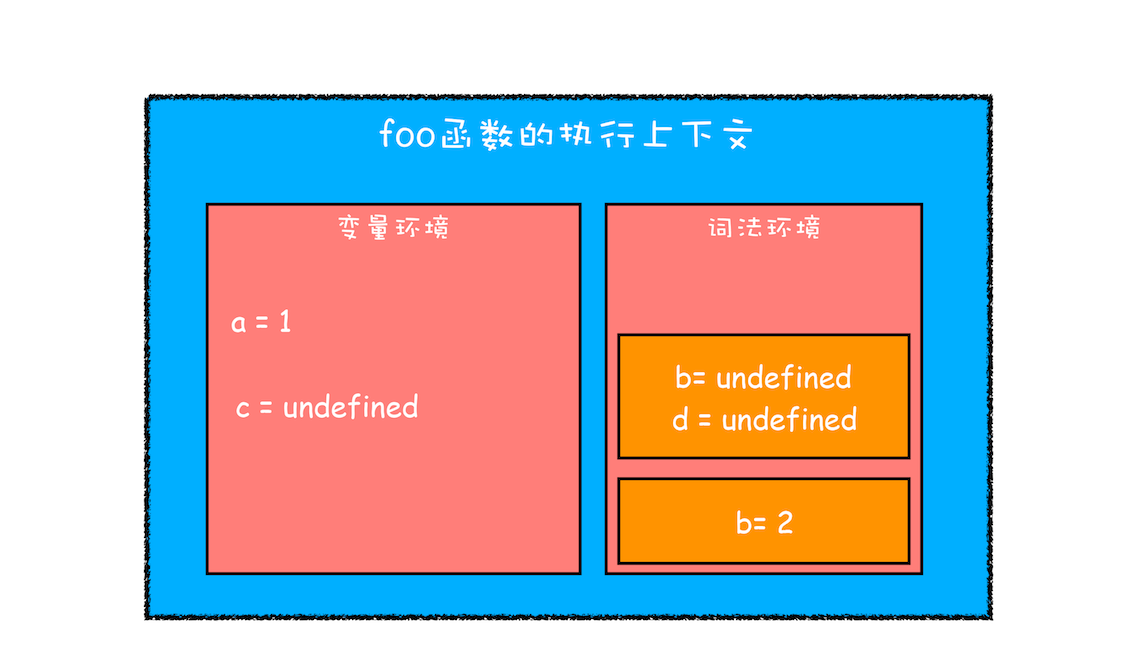

第二步继续执行代码(进入块级作用域)

函数只会在第一次执行的时候被编译,所以编译时变量环境和词法环境最顶层数据已经确定了。

当执行到块级作用域的时候,块级作用域中通过 let 和 const 申明的变量会被追加到词法环境中,当这个块执行结束之后,追加到词法作用域的内容又会销毁掉

当进入函数的作用域块时,作用域块中通过 let 声明的变量,会被存放在词法环境的一个单独的区域中,这个区域中的变量并不影响作用域块外面的变量,比如在作用域外面声明了变量 b,在该作用域块内部也声明了变量 b,当执行到作用域内部时,它们都是独立的存在

其实,在词法环境内部,维护了一个小型栈结构,栈底是函数最外层的变量,进入一个作用域块后,就会把该作用域块内部的变量压到栈顶;当作用域执行完成之后,该作用域的信息就会从栈顶弹出,这就是词法环境的结构

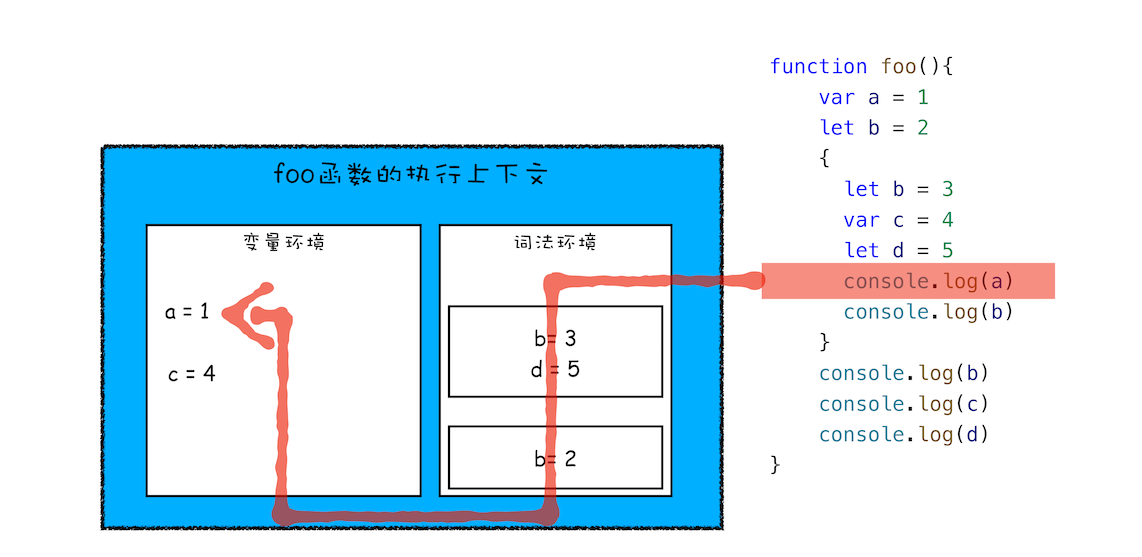

第三步继续执行代码(执行块级作用域中的赋值操作)

再接下来,当执行到作用域块中的 console.log(a)这行代码时,就需要在词法环境和变量环境中查找变量 a 的值了,具体查找方式是:沿着词法环境的栈顶向下查询,如果在词法环境中的某个块中查找到了,就直接返回给 JavaScript 引擎,如果没有查找到,那么继续在变量环境中查找

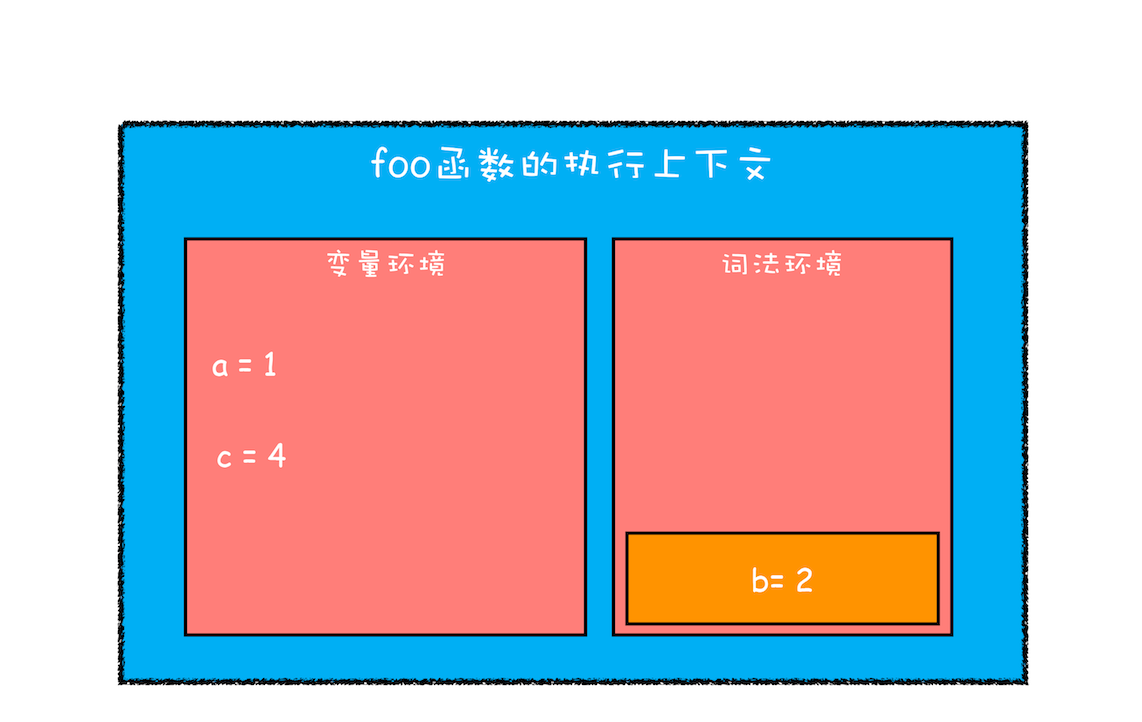

最后,当作用域块执行结束之后,其内部定义的变量就会从词法环境的栈顶弹出

总结

由于 JavaScript 的变量提升存在着变量覆盖、变量污染等设计缺陷,所以 ES6 引入了块级作用域关键字来解决这些问题

既然聊到了作用域,那再简单聊下编程语言。经常有人争论什么编程语言是世界上最好的语言,但如果站在语言本身来说,我觉得这种争论没有意义,因为语言是工具,而工具是用来创造价值的,至于能否创造价值或创造多大价值不完全由语言本身的特性决定。这么说吧,即便一门设计不那么好的语言,它也可能拥有非常好的生态,比如有完善的框架、非常多的落地应用,又或者能够给开发者带来更多的回报,这些都是评判因素

如果站在语言层面来谈,每种语言其实都是在相互借鉴对方的优势,协同进化,比如 JavaScript 引进了块级作用域、迭代器和协程,其底层虚拟机的实现和 Java、Python 又是非常相似,也就是说如果你理解了 JavaScript 协程和 JavaScript 中的虚拟机,其实你也就理解了 Java、Python 中的协程和虚拟机的实现机制

1、想问下这个块级作用域的 b=undefined; d=undefined 是不是应该在第一步的编译阶段里就有。还是说在执行阶段像函数那样,块级作用域会有一个自己的编译阶段?

执行函数时才有进行编译,抽象语法树(AST)在进入函数阶段就生成了,并且函数内部作用域是已经明确了,所以进入块级作用域不会有编译过程,只不过通过 let 或者 const 声明的变量会在进入块级作用域的时被创建,但是在该变量没有赋值之前,引用该变量 JavaScript 引擎会抛出错误---这就是“暂时性死区”

作用域链和闭包

作用域链

function bar() {

console.log(myName);

}

function foo() {

var myName = "极客邦";

bar();

}

var myName = "极客时间";

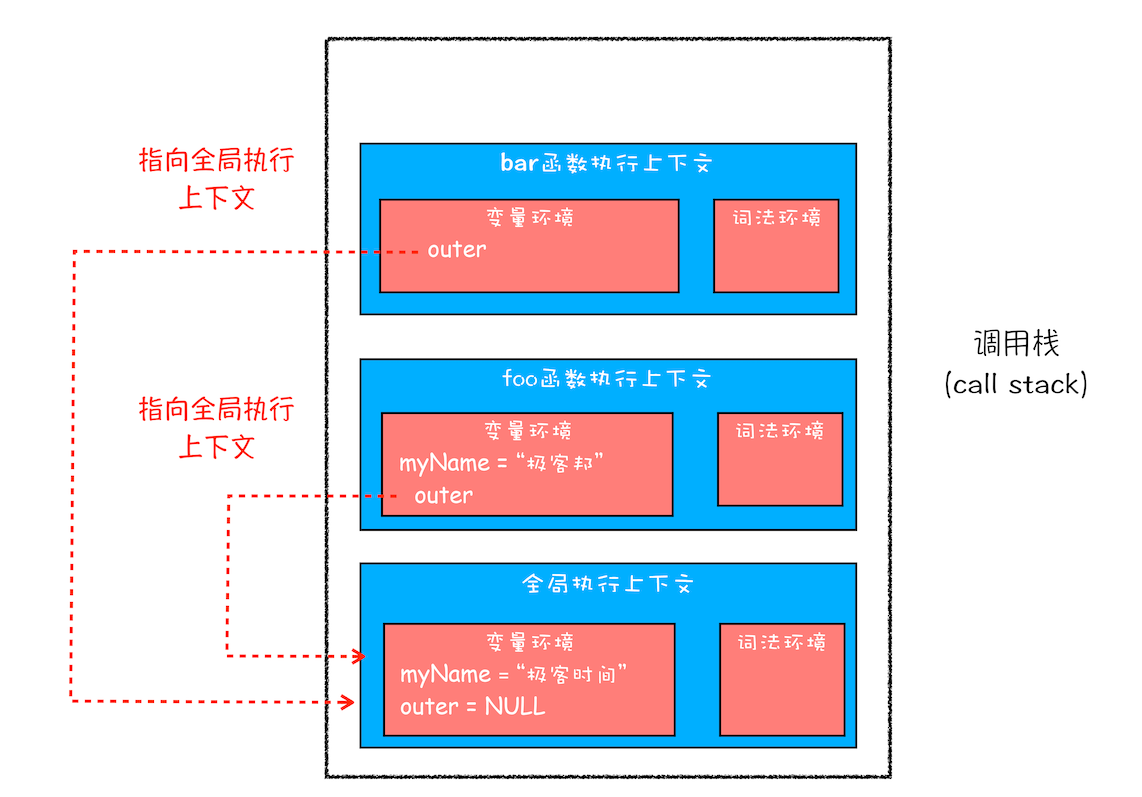

foo();其实在每个执行上下文的变量环境中,都包含了一个外部引用,用来指向外部的执行上下文,我们把这个外部引用称为outer

当一段代码使用了一个变量时,JavaScript 引擎首先会在“当前的执行上下文”中查找该变量,如果在当前的变量环境中没有查找到,那么 JavaScript 引擎会继续在 outer 所指向的执行上下文中查找,如下图:

这个查找的链条就称为作用域链

bar 函数的外部引用是全局上下文而不是 foo 函数的执行上下文,这是因为作用域链是由词法作用域决定的

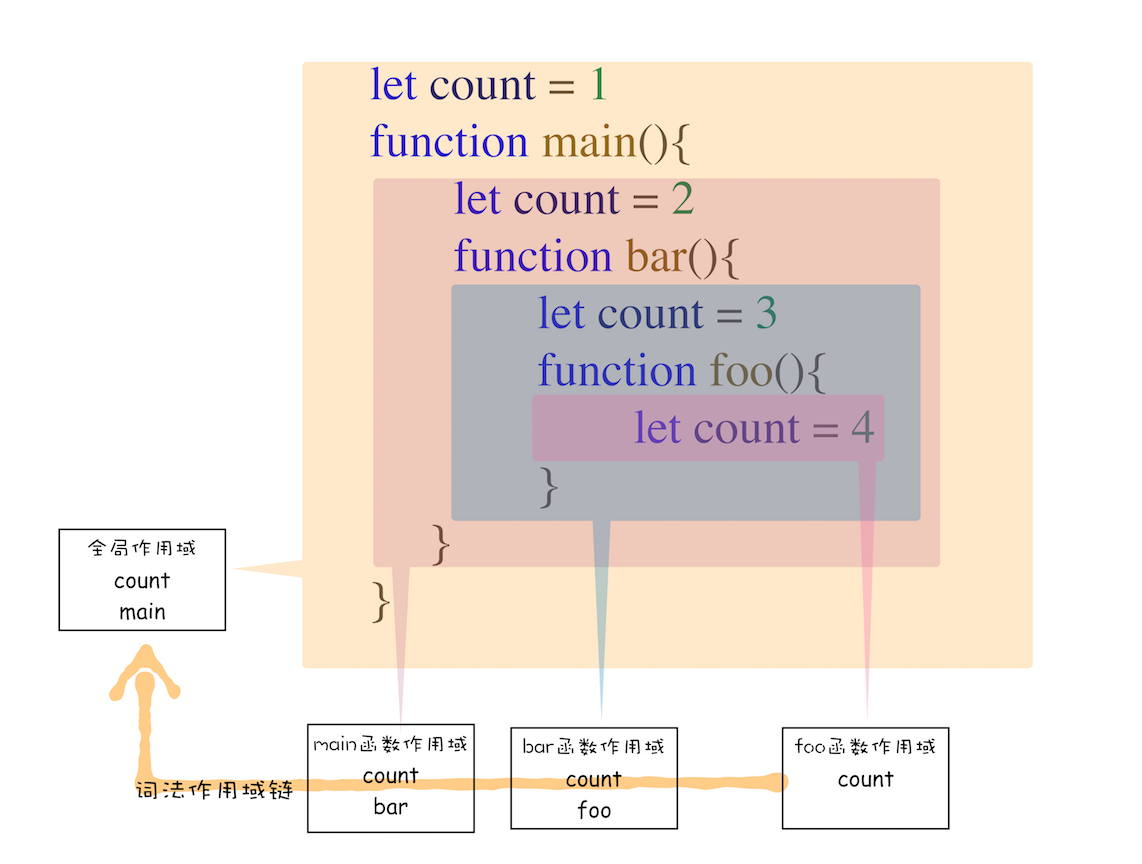

词法作用域

词法作用域就是指作用域是由代码中函数声明的位置来决定的,所以词法作用域是静态的作用域,通过它就能够预测代码在执行过程中如何查找标识符

整个词法作用域链的顺序是:foo 函数作用域—>bar 函数作用域—>main 函数作用域—> 全局作用域

词法作用域是代码编译阶段就决定好的,和函数是怎么调用的没有关系

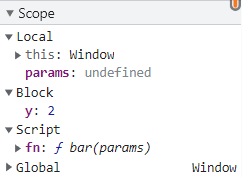

浏览器中打上断点也可以查看当前执行行作用域链情况:

闭包

function foo() {

var myName = "极客时间";

let test1 = 1;

const test2 = 2;

var innerBar = {

getName: function () {

console.log(test1);

return myName;

},

setName: function (newName) {

myName = newName;

},

};

return innerBar;

}

var bar = foo();

bar.setName("极客邦");

bar.getName();

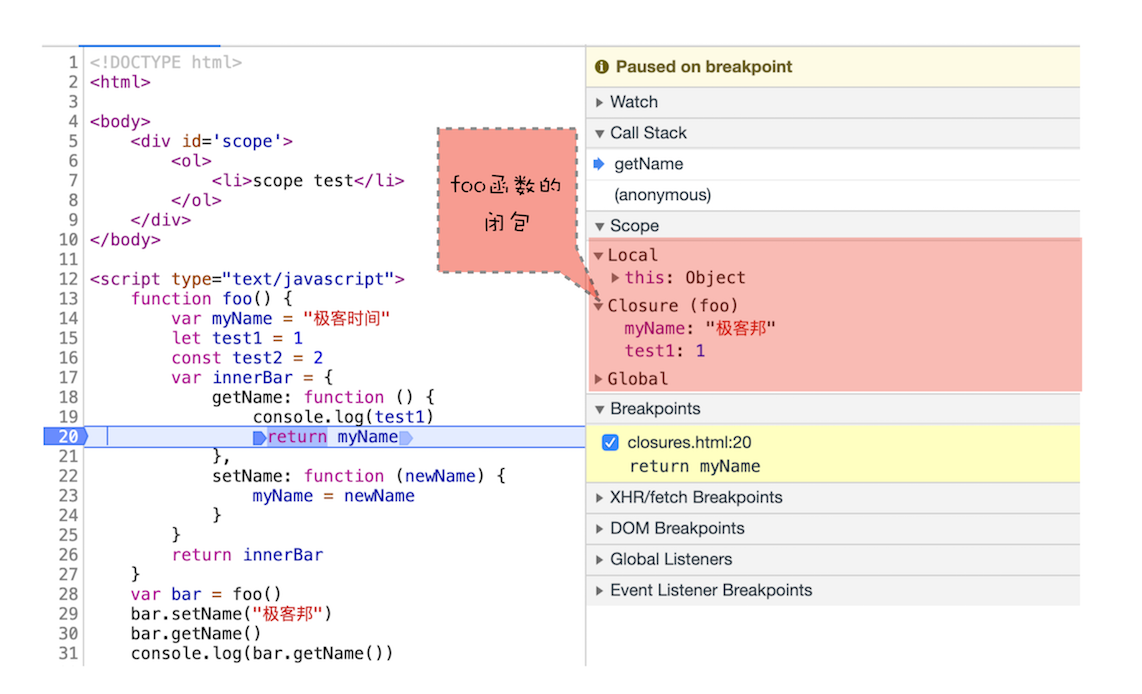

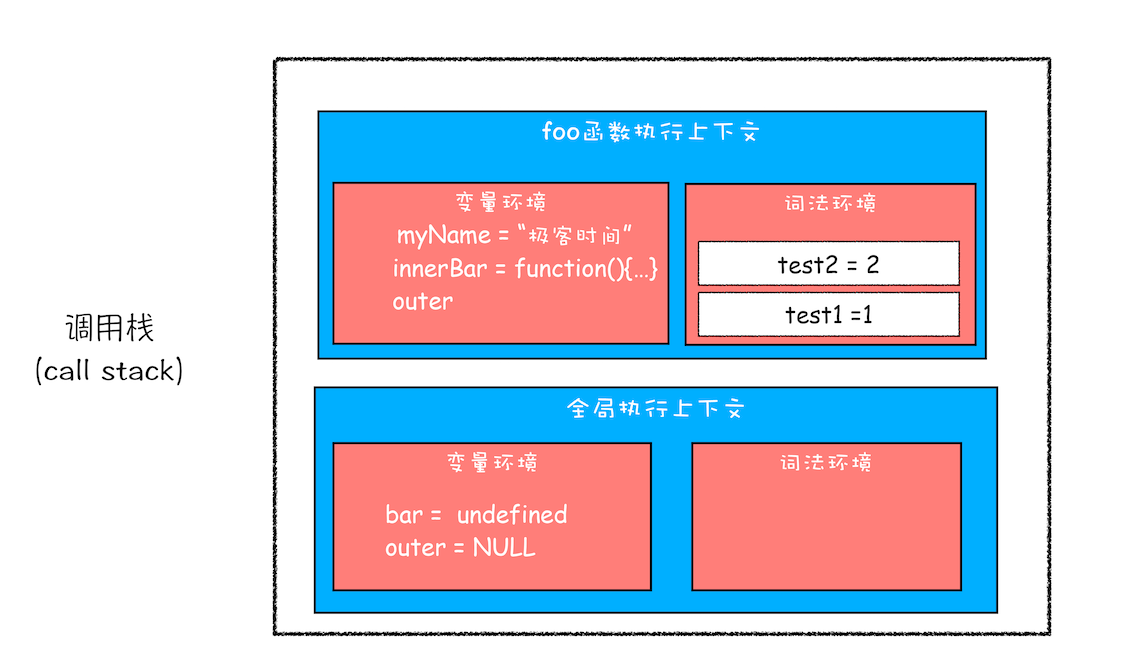

console.log(bar.getName());执行到 return innerBar 时,调用栈情况:

根据词法作用域的规则,内部函数 getName 和 setName 总是可以访问它们的外部函数 foo 中的变量,所以当 innerBar 对象返回给全局变量 bar 时,虽然 foo 函数已经执行结束,但是 getName 和 setName 函数依 然可以使用 foo 函数中的变量 myName 和 test1。当 foo 函数执行完后,调用栈情况:

因为 myName 和 test1 两个变量都有引用,所以会保存在内存中。而除了 getName 和 setName 外,其他任何方法都无法访问这两个变量;就像 getName 和 setName 方法生成的一个专属背包,也被称作 foo 函数的闭包

闭包的定义

在 JavaScript 中,根据词法作用域的规则,内部函数总是可以访问其外部函数中声明的变量,当通过调用一个外部函数返回一个内部函数后,即使该外部函数已经执行结束了,但是内部函数引用外部函数的变量依然保存在内存中,我们就把这些变量的集合称为闭包。比如外部函数是 foo,那么这些变量的集合就称为 foo 函数的闭包

闭包怎么回收

通常,如果引用闭包的函数是一个全局变量,那么闭包会一直存在直到页面关闭;但如果这个闭包以后不再使用的话,就会造成内存泄漏

如果引用闭包的函数是个局部变量,等函数销毁后,在下次 JavaScript 引擎执行垃圾回收时,判断闭包这块内容如果已经不再被使用了,那么 JavaScript 引擎的垃圾回收器就会回收这块内存

在使用闭包的时候注意一个原则:如果该闭包会一直使用,那么它可以作为全局变量而存在;但如果使用频率不高,而且占用内存又比较大的话,那就尽量让它成为一个局部变量

总结

- 首先,介绍了什么是作用域链,我们把通过作用域查找变量的链条称为作用域链;作用域链是通过词法作用域来确定的,而词法作用域反映了代码的结构

- 其次,介绍了在块级作用域中是如何通过作用域链来查找变量的

- 最后,又基于作用域链和词法环境介绍了到底什么是闭包。

思考

var bar = {

myName: "time.geekbang.com",

printName: function () {

console.log(myName);

},

};

function foo() {

let myName = "极客时间";

return bar.printName;

}

let myName = "极客邦";

let _printName = foo();

_printName();

bar.printName();

// 极客邦

// 极客邦因为没有使用 this,所以只与 bar.printName 作用域链有关,和 foo 与 bar 无关

1、闭包是存在调用栈里的,现在的模块化存在大量闭包,那不是调用栈底部存在大量闭包很容易栈溢出吧

当闭包函数执行结束之后,执行上下文都从栈中弹出来,只不过被内部函数引用的变量不会被垃圾回收,这块内容要到讲 v8 GC 那节来讲了

2、闭包是包含了整个变量环境和词法环境,还是只是包含用到的变量?

只包含用到的变量,这是因为在返回内部函数时,JS 引擎会提前分析闭包内部函数的词法环境,有引用的外部变量都不会被 gc 回收

3、在 return innerBar 的时候 bar.setName(" 极客邦 ")和 bar.getName()这两个函数还没有执行 为什么会执行词法作用域的分析,之前不是说只有函数调用时才创建这个函数的执行作用域和可执行代码吗?

这是预分析过程,主要是查看内部函数是否引用了外部作用域变量,用来判断是否要创建闭包,所以预分析过程并不是编译过程

4、函数执行上下文是在函数执行前的编译阶段存入执行栈的、那么执行上下文中的 outer 也是在编译阶段通过分析函数声明的位置来赋值的吗?

编译阶段就确定了

5、关于 AO

es6 已经不用 ao 了

6、所以变量环境是动态的,根据函数调用关系。词法环境是静态的,根据函数定义时的状态?

都是静态的,动态绑定的 this 下节内容讲,this 系统和作用域链是两套不一样的系统

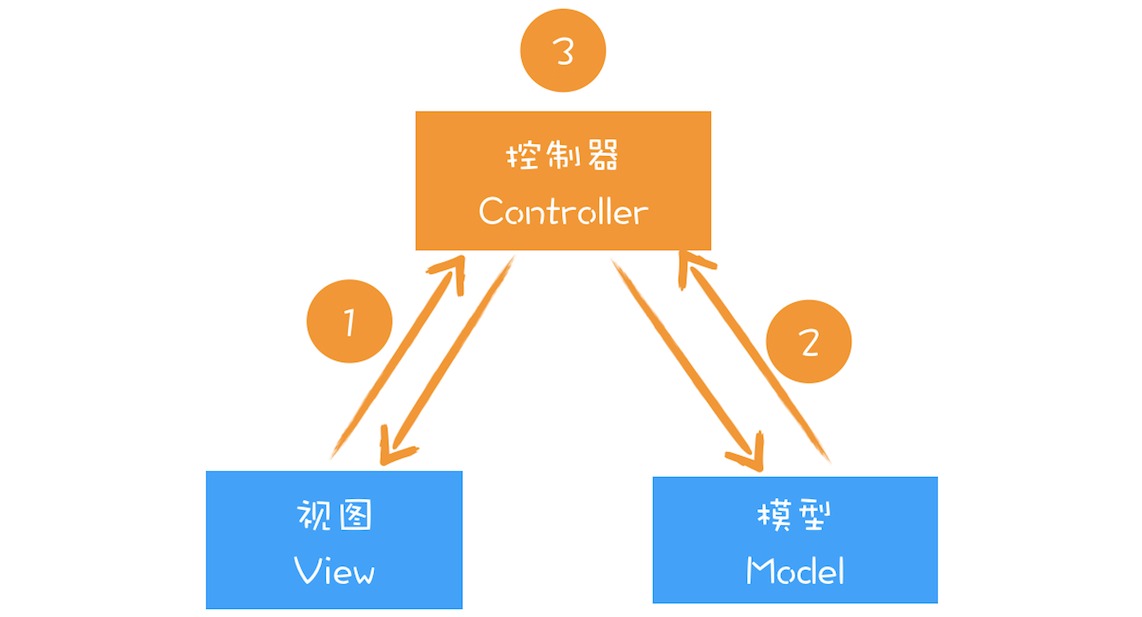

this

但是如果需要在对象内部方法中访问对象内部属性,JavaScript 提供了另一种机制——this

this和作用域链之间没有太多联系,是两套不同的系统

执行上下文中包含了变量环境、词法环境、外部环境、this

全局执行上下文中的 this

指向 window

函数执行上下文中的 this

指向 window 对象

但是可以改变 this 的指向

1、通过函数的 call 方法设置

可以通过函数的 call 方法来设置函数执行上下文的 this 指向

let bar = {

myName: "极客邦",

test1: 1,

};

function foo() {

this.myName = "极客时间";

}

foo.call(bar);

console.log(bar);

console.log(myName);

// {

// myName : "极客时间",

// test1 : 1

// }

// undefined还有bind和apply方法,也可以改变 this 指向

2、通过对象调用方法设置

var myObj = {

name: "极客时间",

showThis: function () {

console.log(this);

},

};

myObj.showThis();

// {

// name : "极客时间",

// showThis: function(){

// console.log(this)

// }

// }使用对象来调用其内部的一个方法,该方法的 this 是指向对象本身的

可以认为 JavaScript 引擎在执行myObject.showThis()时,将其转化为了:myObj.showThis.call(myObj)

如果把 showThis 赋值给一个全局对象,然后调用,this 指向也会改变:

var myObj = {

name: "极客时间",

showThis: function () {

this.name = "极客邦";

console.log(this);

},

};

var foo = myObj.showThis;

foo();this 又指向了全局 window 对象

所以,我们可以得到结论:

- 在全局环境中调用一个函数,函数内部的 this 指向的是全局变量 window

- 通过一个对象来调用其内部的一个方法,该方法的执行上下文中的 this 指向对象本身

3、通过构造函数中设置

function CreateObj() {

this.name = "极客时间";

}

var myObj = new CreateObj();当执行 new CreateObject 时,JavaScript 引擎做了四件事:

- 首先创建了一个空对象 tempObj

- 接着调用 CreateObj.call 方法,并将 tempObj 作为 call 方法的参数,这样当 CreateObj 的执行上下文创建时,它的 this 就指向了 tempObj 对象

- 然后执行 CreateObj 函数,此时的 CreateObj 函数执行上下文中的 this 指向了 tempObj 对象

- 最后返回 tempObj 对象

this 的设计缺陷以及应对方案

1、嵌套函数中的 this 不会从外层函数中继承

var myObj = {

name: "极客时间",

showThis: function () {

console.log(this);

function bar() {

console.log(this);

}

bar();

},

};

myObj.showThis();bar 函数 this 指向 window,showThis 函数指向的是 myObj 对象

可以使用一个小技巧解决这个问题,比如在 showThis 函数中声明一个 self 变量来保存 this,然后再 bar 中使用 self

var myObj = {

name: "极客时间",

showThis: function () {

console.log(this);

var self = this;

function bar() {

self.name = "极客邦";

}

bar();

},

};

myObj.showThis();

console.log(myObj.name);

console.log(window.name);这个方法的本质是把 this 体系转换为了作用域体系

同样的,可以使用 ES6 中箭头函数来解决这个问题:

var myObj = {

name: "极客时间",

showThis: function () {

console.log(this);

var bar = () => {

this.name = "极客邦";

console.log(this);

};

bar();

},

};

myObj.showThis();

console.log(myObj.name);

console.log(window.name);因为 ES6 中的箭头函数并不会创建其自身的执行上下文,所以箭头函数中的 this 取决于它的外部函数

2、普通函数中的 this 默认指向全局对象 window

在默认情况下调用一个函数,其执行上下文中的 this 是默认指向全局对象 window 的

如果要让函数执行上下文中的 this 指向某个对象,最好的方式是通过 call 方法来显示调用

同样,设置 JavaScript 的“严格模式”可以解决这个问题,在严格模式下,默认执行一个函数,其函数的执行上下文中的 this 值是 undefined,这就不会造成函数打破数据边界了

总结

1、当函数作为对象的方法调用时,函数中的 this 就是该对象

2、当函数被正常调用时,在严格模式下,this 值是 undefined,非严格模式下 this 指向的是全局对象 window

3、嵌套函数中的 this 不会继承外层函数的 this 值

4、因为箭头函数没有自己的执行上下文,所以箭头函数的 this 就是它外层函数的 this

注意:如果被 setTimeout 推迟执行的回调函数是某个对象的方法,那么该方法中的 this 关键字将指向全局环境,而不是定义时所在的那个对象

栈空间和堆空间

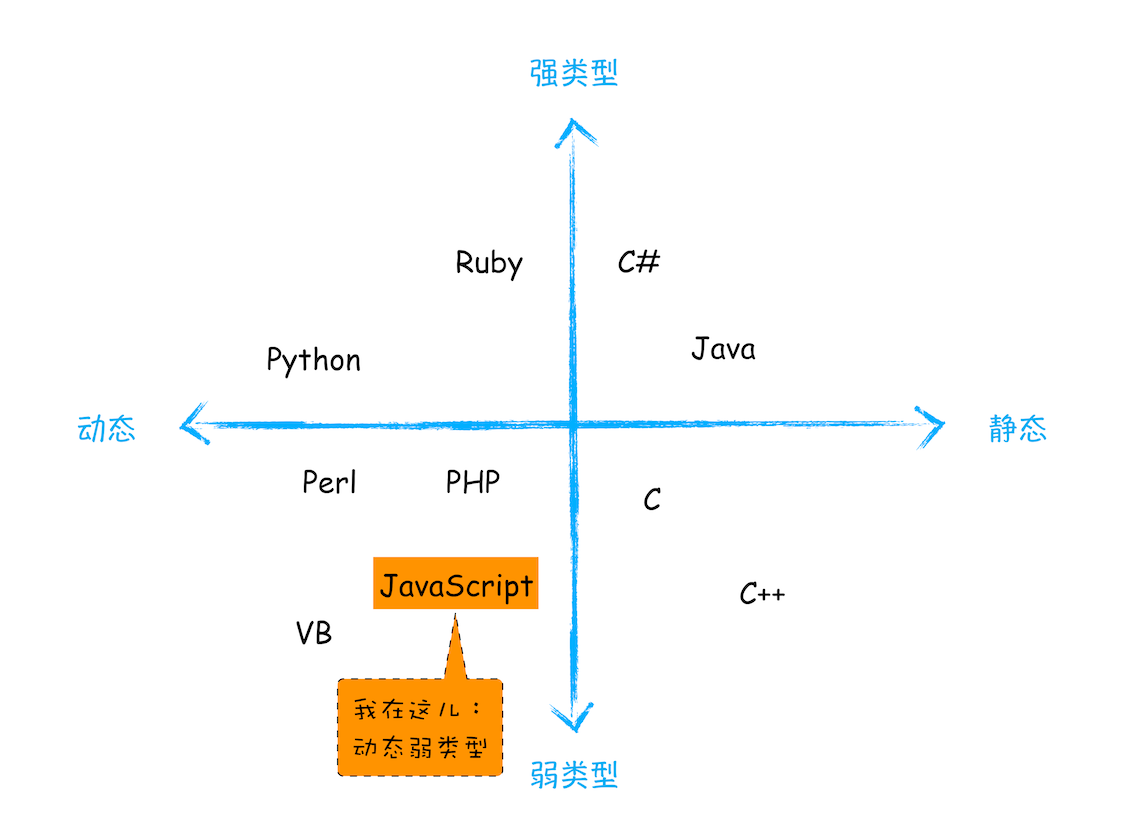

JavaScript 是什么类型的语言

C 语言这种在使用之前就需要确认其变量数据类型的称为静态语言;相反地,我们把在运行过程中需要检查数据类型的语言称为动态语言,例如 JavaScript,不需要确认数据类型

int a = 1;

bool c = true;

c = a;上面这段代码中 C 编译器会把 int 型的变量转换为 bool 型的变量,这种转换被称为隐式类型转换;支持隐式类型转换的语言称为弱类型语言,不支持隐式类型转换的语言称为强类型语言;C 和 JavaScript 都属于弱类型语言

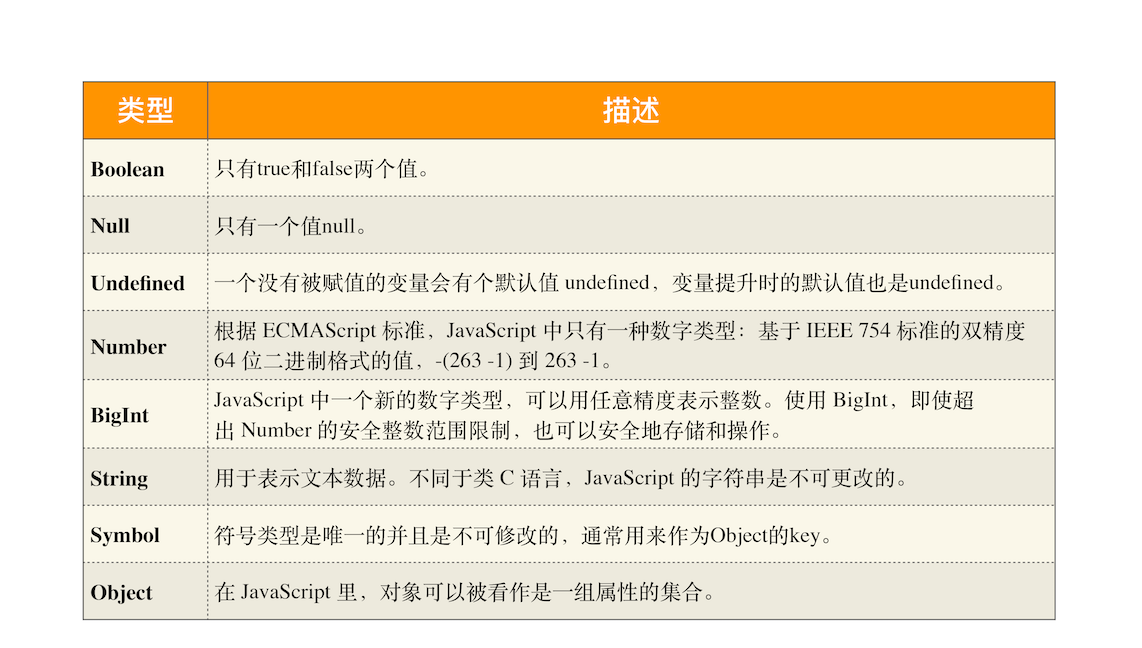

JavaScript 的数据类型

JavaScript 有八种数据类型:

注意

1、使用 typeof 检测 Null 类型时,返回的是 Object。这是当初 JavaScript 语言的一个 Bug,一直保留至今,之所以一直没修改过来,主要是为了兼容老的代码

2、Object 类型比较特殊,它是由上述 7 种类型组成的一个包含了 key-value 对的数据类型

3、我们把前面的 7 种数据类型称为原始类型,把最后一个对象类型称为引用类型,之所以把它们区分为两种不同的类型,是因为它们在内存中存放的位置不一样

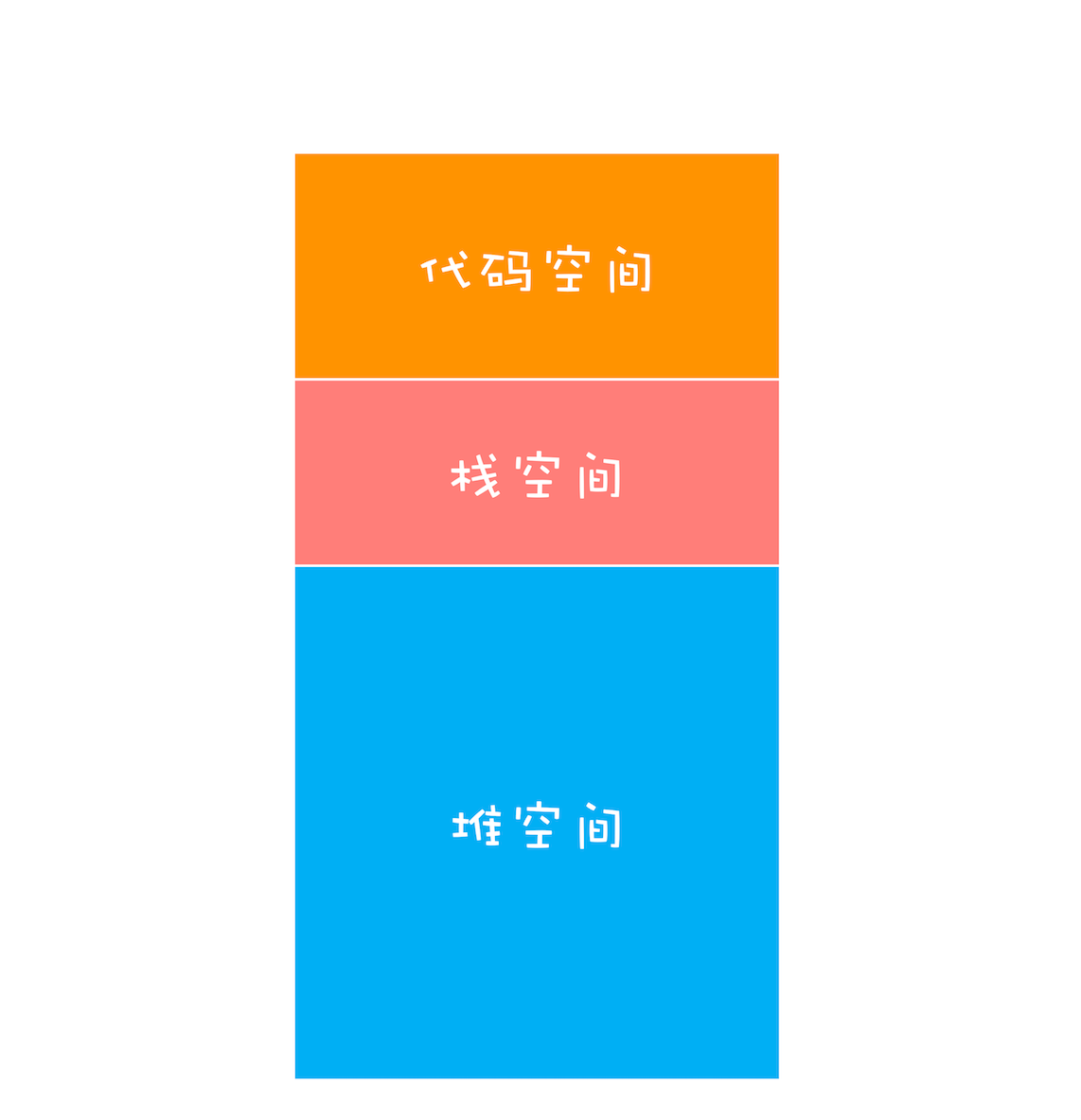

内存空间

JavaScript 内存模型

栈空间和堆空间

function foo() {

var a = "极客时间";

var b = a;

var c = { name: "极客时间" };

var d = c;

}

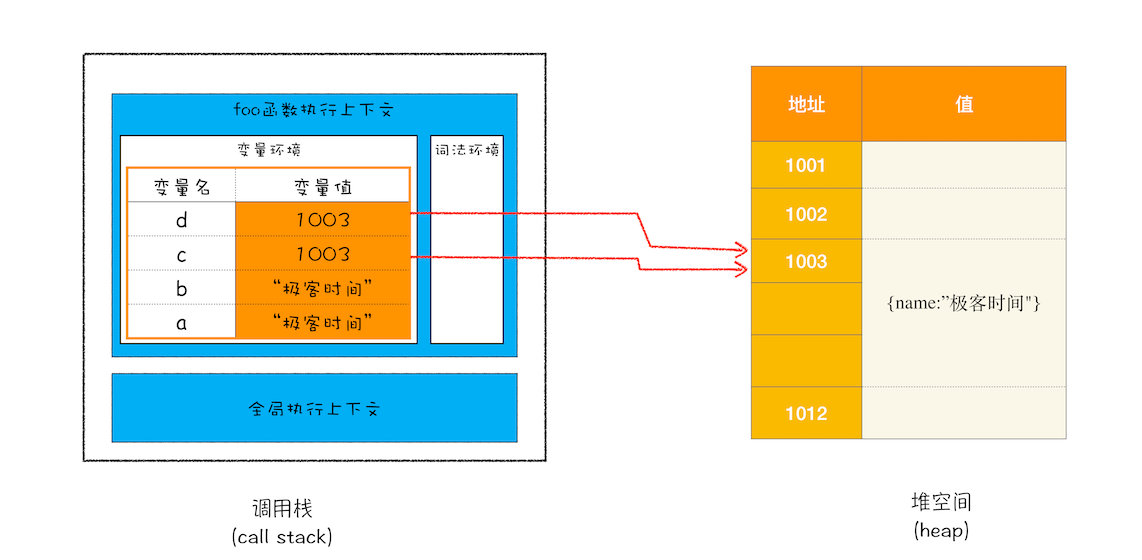

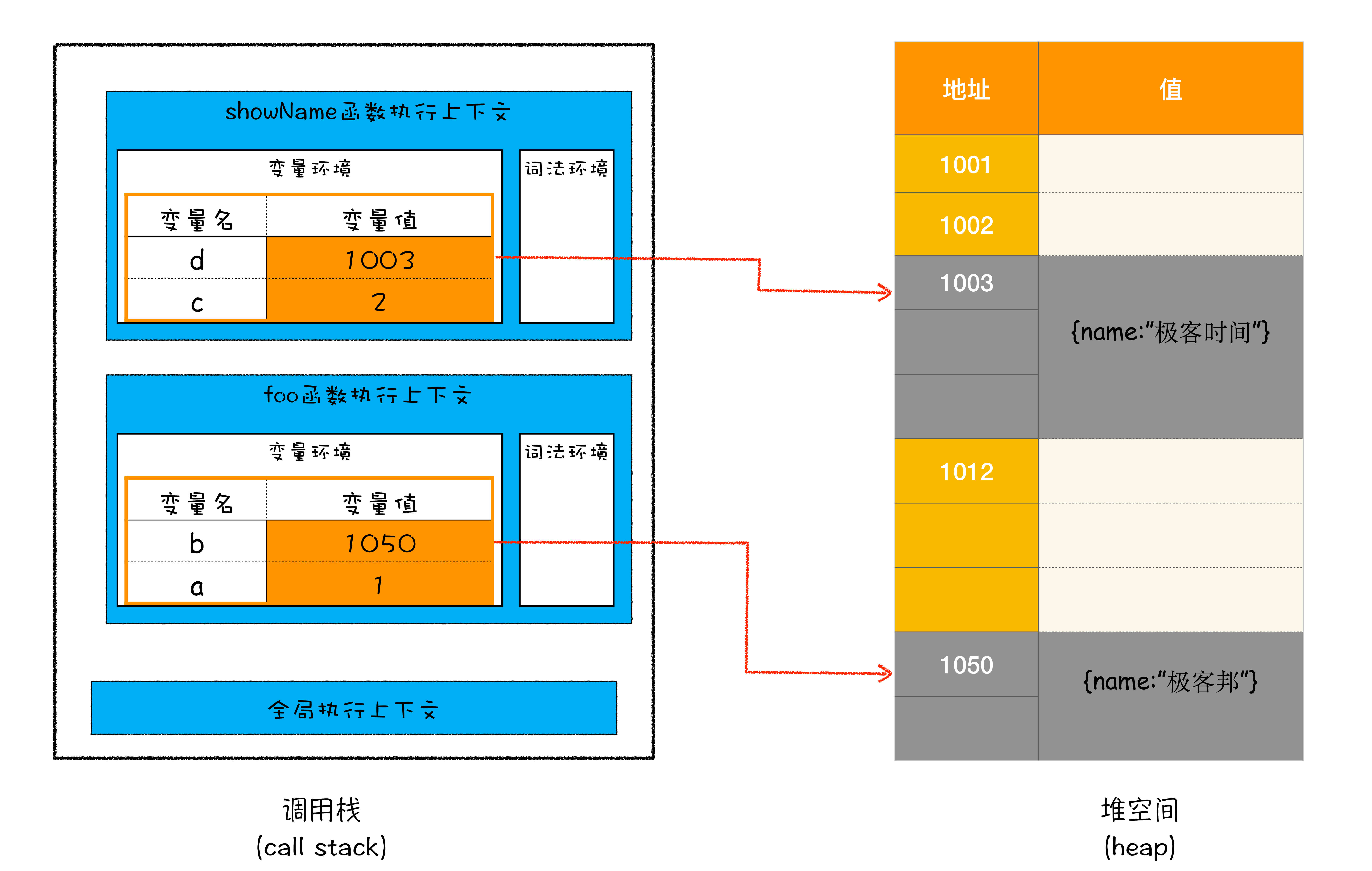

foo();当执行到 foo 函数第二行代码时,调用栈的状态:

这时变量 a、b 的值都是被保存在执行上下文中,执行上下文被压入到栈中,所以可以认为变量 a、b 的值都是放在栈中的

执行到 foo 函数第三行代码时,JavaScript 判断到等号右边是一个引用类型,JavaScript 引擎会将它分配到堆空间里面,分配后该对象会有一个在“堆”中的地址,然后再将该数据的地址写进 c 的变量值

原始类型的数据值都是直接保存在“栈”中的,引用类型的值是存放在“堆”中的

这是因为 JavaScript 引擎需要用栈来维护程序执行期间上下文的状态,如果栈空间大了话,所有的数据都存放在栈空间里面,那么会影响到上下文切换的效率,进而又影响到整个程序的执行效率

如果 foo 函数执行完了,JavaScript 只需要将指针下移到上个执行上下文地址就可以了,foo 函数执行上下文栈空间全部回收:

所以通常情况下,栈空间都不会设置太大,主要用来存放一些原始类型的小数据。而引用类型的数据占用的空间都比较大,所以这一类数据会被存放到堆中,堆空间很大,能存放很多大的数据,不过缺点是分配内存和回收内存都会占用一定的时间

在 JavaScript 中,原始类型的赋值会完整复制变量值,而引用类型的赋值是复制引用地址

所以当 foo 函数执行到第四行时,会将 c 引用的地址赋值给 d:

闭包

function foo() {

var myName = "极客时间";

let test1 = 1;

const test2 = 2;

var innerBar = {

setName: function (newName) {

myName = newName;

},

getName: function () {

console.log(test1);

return myName;

},

};

return innerBar;

}

var bar = foo();

bar.setName("极客邦");

bar.getName();

console.log(bar.getName());按常理来说,foo 函数执行上下文被销毁了,其栈空间内的变量也会被销毁,但是变量 myName 和 test1 并没有被销毁,而是保存在内存中,那么应该如何解释这个现象呢?

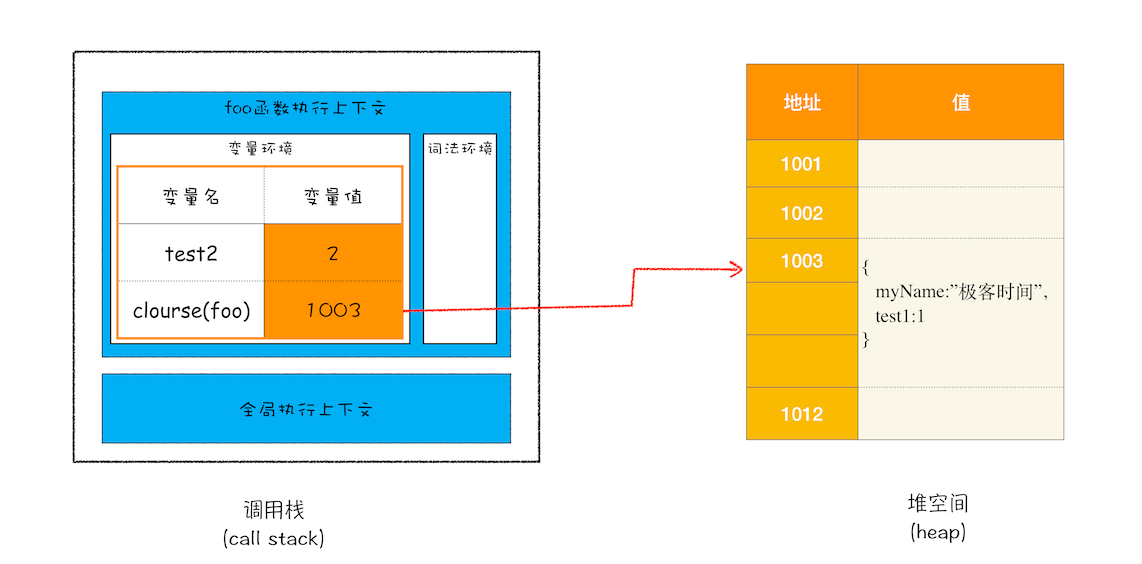

1、当 JavaScript 引擎执行到 foo 函数时,首先会编译,并创建一个空执行上下文

2、在编译过程中,遇到内部函数 setName,JavaScript 引擎还要对内部函数做一次快速的词法扫描,发现该内部函数引用了 foo 函数中的 myName 变量,由于是内部函数引用了外部函数的变量,所以 JavaScript 引擎判断这是一个闭包,于是在堆空间创建换一个“closure(foo)”的对象(这是一个内部对象,JavaScript 是无法访问的),用来保存 myName 变量

3、接着继续扫描到 getName 方法时,发现该函数内部还引用变量 test1,于是 JavaScript 引擎又将 test1 添加到“closure(foo)”对象中。这时候堆中的“closure(foo)”对象中就包含了 myName 和 test1 两个变量了

4、由于 test2 并没有被内部函数引用,所以 test2 依然保存在调用栈中。

执行到return innerBar时,调用栈状态:

当 foo 函数执行结束之后,返回的 getName 和 setName 方法都引用“closure(foo)”对象,所以即使 foo 函数退出了,“ closure(foo)”依然被其内部的 getName 和 setName 方法引用。所以在下次调用 bar.setName 或者 bar.getName 时,创建的执行上下文中就包含了“closure(foo)”

但是在浏览器中对块级作用域中的词法环境中的变量(如 let、const)进行引用时,浏览器将不会创建 closure(xx)对象,而是 Block 对象:

function foo() {

let y = 1;

{

let y = 2;

function bar(params) {

debugger;

return y;

}

}

return bar;

}

const fn = foo();

console.log(fn());

总的来说,产生闭包的核心有两步:第一步是需要预扫描内部函数;第二步是把内部函数引用的外部变量保存到堆中

总结

JavaScript 中的 8 种数据类型,它们可以分为两大类——原始类型和引用类型。

其中,原始类型的数据是存放在栈中,引用类型的数据是存放在堆中的。堆中的数据是通过引用和变量关联起来的。也就是说,JavaScript 的变量是没有数据类型的,值才有数据类型,变量可以随时持有任何类型的数据

在 JavaScript 中将一个原始类型的变量 a 赋值给 b,那么 a 和 b 会相互独立、互不影响;但是将引用类型的变量 a 赋值给变量 b,那会导致 a、b 两个变量都同时指向了堆中的同一块数据

垃圾回收

有些数据被使用之后,可能就不再需要了,我们把这种数据称为垃圾数据。如果这些垃圾数据一直保存在内存中,那么内存会越用越多,所以我们需要对这些垃圾数据进行回收,以释放有限的内存空间

不同语言的垃圾回收策略

通常情况下,垃圾数据回收分为手动回收和自动回收两种策略

C/C++ 就是使用手动回收策略,何时分配内存、何时销毁内存都是由代码控制的

//在堆中分配内存

char* p = (char*)malloc(2048); //在堆空间中分配2048字节的空间,并将分配后的引用地址保存到p中

//使用p指向的内存

{

//....

}

//使用结束后,销毁这段内存

free(p);

p = NULL;JavaScript、Java、Python 等语言,产生的垃圾数据是由垃圾回收器来释放的,并不需要手动通过代码来释放

调用栈中的数据是如何回收的

function foo() {

var a = 1;

var b = { name: "极客邦" };

function showName() {

var c = 2;

var d = { name: "极客时间" };

}

showName();

}

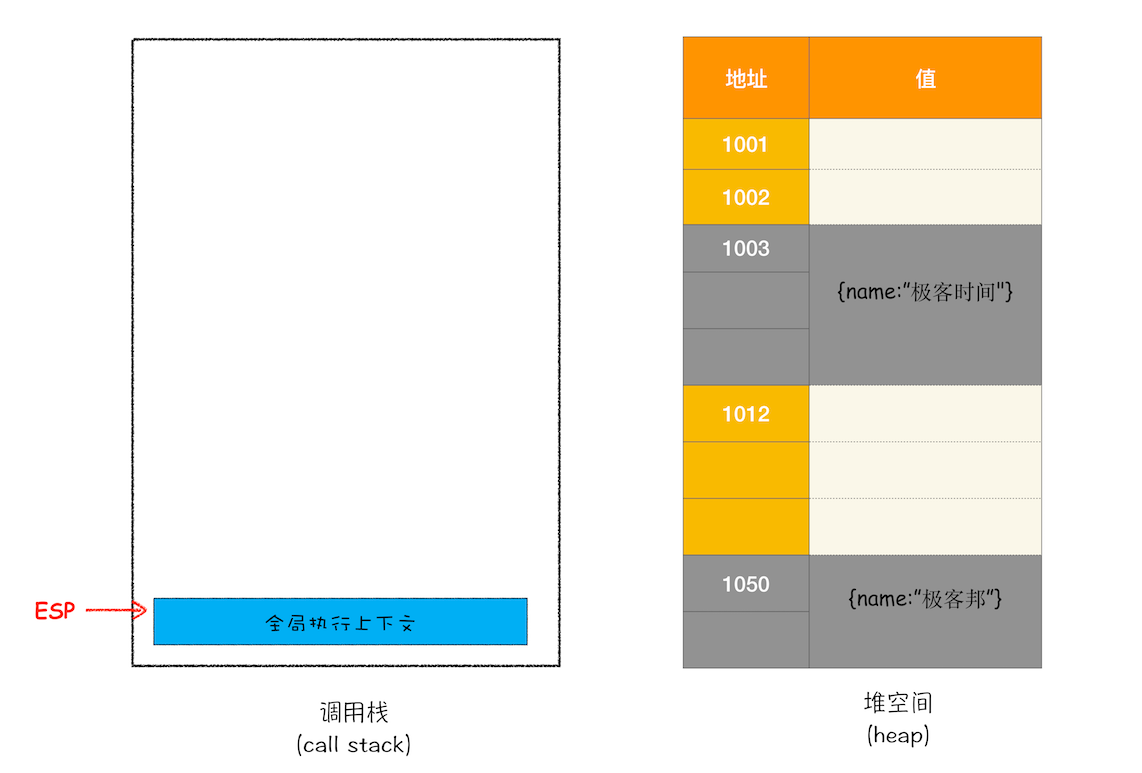

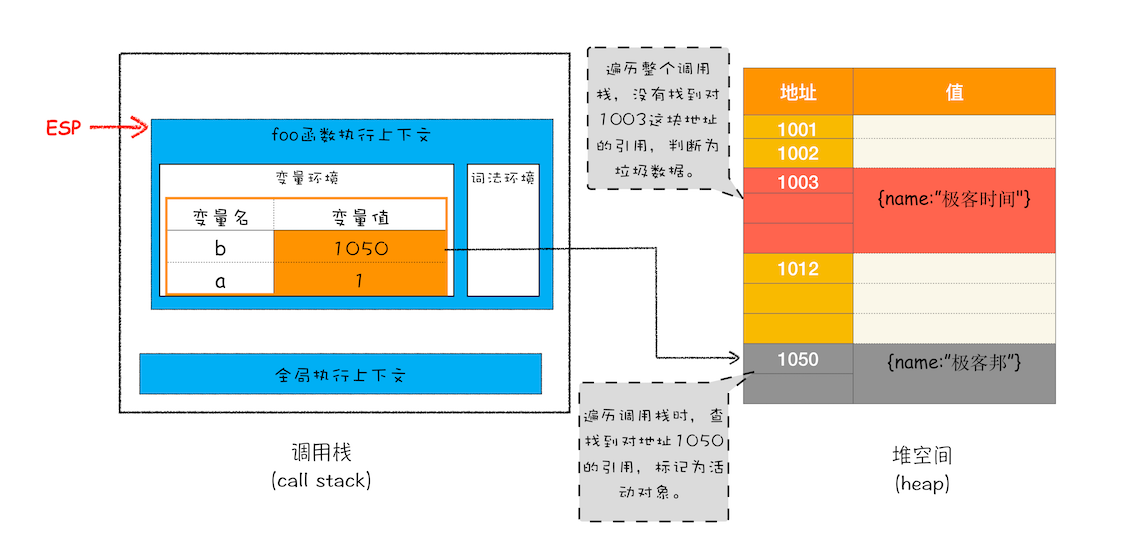

foo();当执行到第六行时,其调用栈和堆空间状态:

与此同时,还有一个记录当前执行状态的指针(称为 ESP),指向调用栈中 showName 函数的执行上下文,表示当前正在执行 showName 函数

接着,当 showName 函数执行完成之后,JavaScript 会将 ESP 下移到 foo 函数的执行上下文,这个下移操作就是销毁 showName 函数执行上下文的过程

当 showName 函数执行结束之后,ESP 向下移动到 foo 函数的执行上下文中,上面 showName 的执行上下文虽然保存在栈内存中,但是已经是无效内存了。比如当 foo 函数再次调用另外一个函数时,这块内容会被直接覆盖掉,用来存放另外一个函数的执行上下文

当一个函数执行结束之后,JavaScript 引擎会通过向下移动 ESP 来销毁该函数保存在栈中的执行上下文

堆中的数据是怎么回收的

foo 函数执行后:

要回收堆中的垃圾数据,就需要用到 JavaScript 中的垃圾回收器了

代际假说和分代收集

**代际假说(The Generational Hypothesis)**是垃圾回收领域中一个重要的术语,后续垃圾回收的策略都是建立在该假说的基础之上的

代际假说有以下两特点:

- 第一个是大部分对象在内存中存在的时间很短,简单来说,就是很多对象一经分配内存,很快就变得不可访问

- 第二个是不死的对象,会活得更久。

这两个特点不仅适用于 JavaScript,还适用于大多数动态语言,如 Java、Python 等

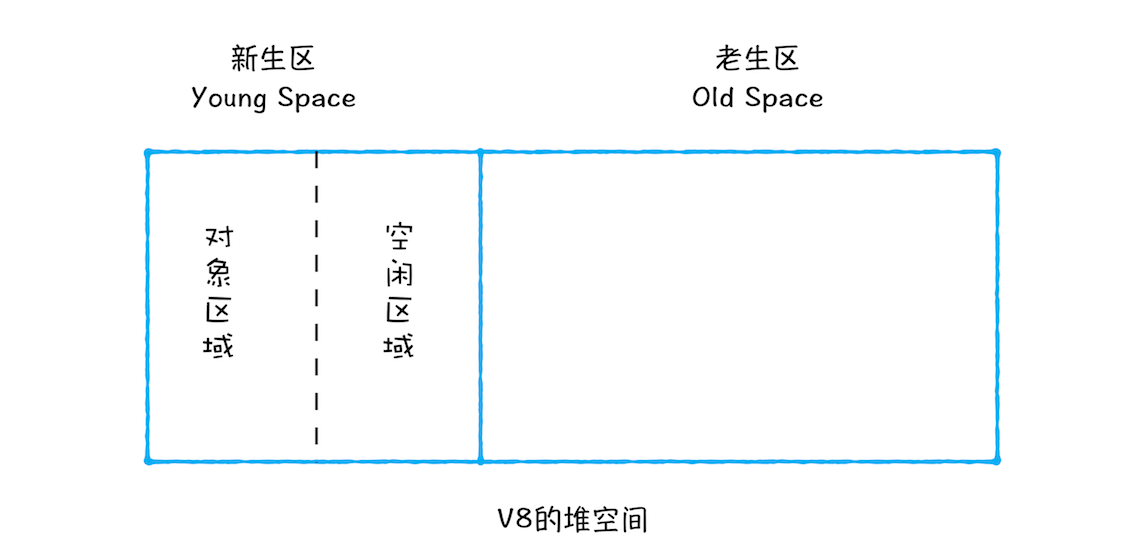

在 V8 中会把堆分为新生代和老生代两个区域,新生代中存放的是生存时间短的对象,老生代中存放的生存时间久的对象

新生区通常只支持 1 ~ 8M 的容量,而老生区支持的容量就大很多了。对于这两块区域,V8 分别使用两个不同的垃圾回收器,以便更高效地实施垃圾回收

- 副垃圾回收器,主要负责新生代的垃圾回收

- 主垃圾回收器,主要负责老生代的垃圾回收

垃圾回收器的工作流程

其实,不论什么类型的垃圾回收器,它们都有一套共同的执行流程

第一步是标记空间中活动对象和非活动对象。所谓活动对象就是还在使用的对象,非活动对象就是可以进行垃圾回收的对象

第二步是回收非活动对象所占据的内存。其实就是在所有的标记完成之后,统一清理内存中所有被标记为可回收的对象

第三步是做内存整理。一般来说,频繁回收对象后,内存中就会存在大量不连续空间,我们把这些不连续的内存空间称为内存碎片。当内存中出现了大量的内存碎片之后,如果需要分配较大连续内存的时候,就有可能出现内存不足的情况。所以最后一步需要整理这些内存碎片,但这步其实是可选的,因为有的垃圾回收器不会产生内存碎片,比如接下来我们要介绍的副垃圾回收器

副垃圾回收器

通常情况下,大多数小的对象都会被分配到新生区,所以说这个区域虽然不大,但是垃圾回收还是比较频繁的

新生代中用 Scavenge 算法来处理。所谓 Scavenge 算法,是把新生代空间对半划分为两个区域,一半是对象区域,一半是空闲区域

新加入的对象都会存放到对象区域,当对象区域快被写满时,就需要执行一次垃圾清理操作

在垃圾回收过程中,首先要对对象区域中的垃圾做标记;标记完成之后,就进入垃圾清理阶段,副垃圾回收器会把这些存活的对象复制到空闲区域中,同时它还会把这些对象有序地排列起来,所以这个复制过程,也就相当于完成了内存整理操作,复制后空闲区域就没有内存碎片了

完成复制后,对象区域与空闲区域进行角色翻转,也就是原来的对象区域变成空闲区域,原来的空闲区域变成了对象区域。这样就完成了垃圾对象的回收操作,同时这种角色翻转的操作还能让新生代中的这两块区域无限重复使用下去

每次执行清理操作时,都需要将存活的对象从对象区域复制到空闲区域。但复制操作需要时间成本,如果新生区空间设置得太大了,那么每次清理的时间就会过久,所以为了执行效率,一般新生区的空间会被设置得比较小

也正是因为新生区的空间不大,所以很容易被存活的对象装满整个区域。为了解决这个问题,JavaScript 引擎采用了对象晋升策略,也就是经过两次垃圾回收依然还存活的对象,会被移动到老生区中

主垃圾回收器

主垃圾回收器主要负责老生区中的垃圾回收。除了新生区中晋升的对象,一些大的对象会直接被分配到老生区。因此老生区中的对象有两个特点,一个是对象占用空间大,另一个是对象存活时间长

主垃圾回收器是采用**标记 - 清除(Mark-Sweep)**的算法进行垃圾回收的

首先是标记过程阶段。标记阶段就是从一组根元素开始,递归遍历这组根元素,在这个遍历过程中,能到达的元素称为活动对象,没有到达的元素就可以判断为垃圾数据

在上面 foo 函数代码中,showName 函数执行完后,栈堆空间如下:

这时候如果遍历调用栈,是不会找到引用 1003 地址的变量,也就意味着 1003 这块数据为垃圾数据,被标记为红色。由于 1050 这块数据被变量 b 引用了,所以这块数据会被标记为活动对象。这就是大致的标记过程

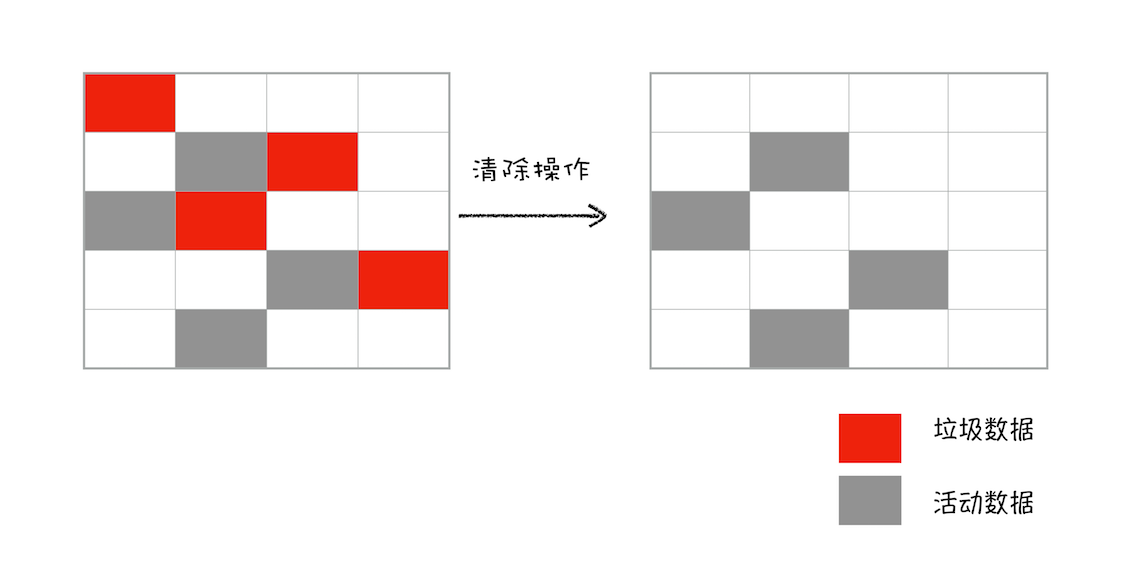

接下来就是垃圾的清除过程。它和副垃圾回收器的垃圾清除过程完全不同,你可以理解这个过程是清除掉红色标记数据的过程:

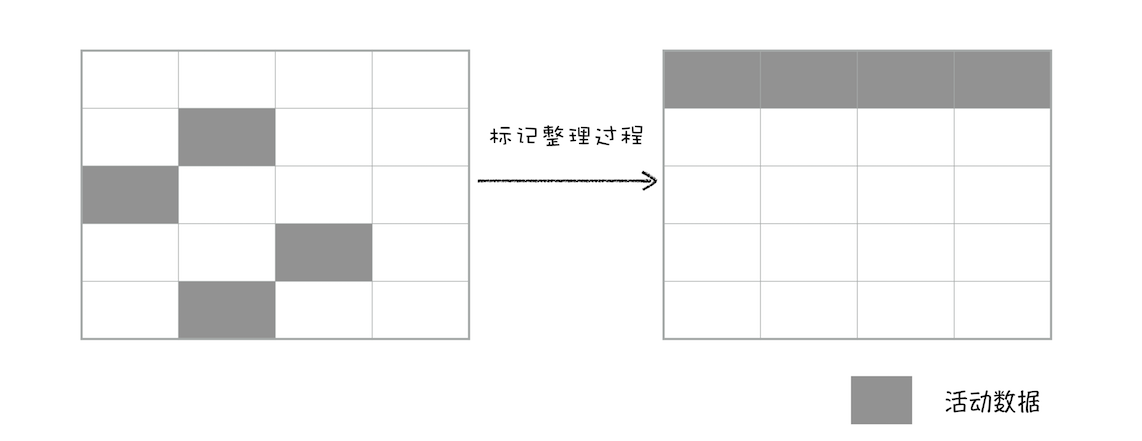

上面的标记过程和清除过程就是标记 - 清除算法,不过对一块内存多次执行标记 - 清除算法后,会产生大量不连续的内存碎片。而碎片过多会导致大对象无法分配到足够的连续内存,于是又产生了另外一种算法——标记 - 整理(Mark-Compact),这个标记过程仍然与标记 - 清除算法里的是一样的,但后续步骤不是直接对可回收对象进行清理,而是让所有存活的对象都向一端移动,然后直接清理掉端边界以外的内存:

全停顿

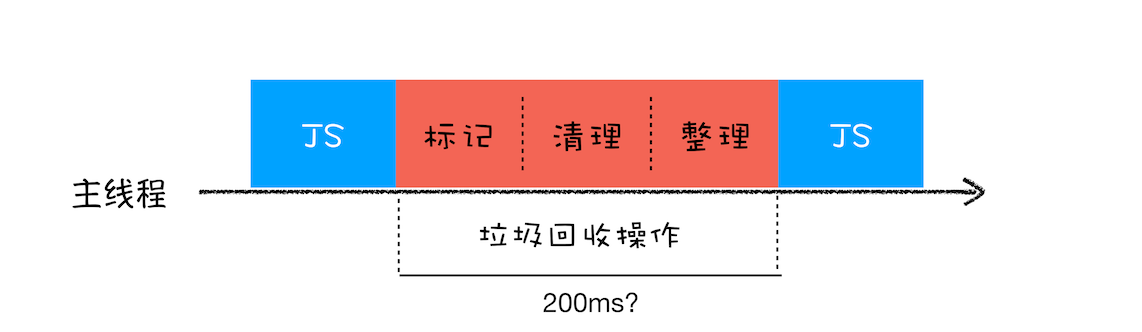

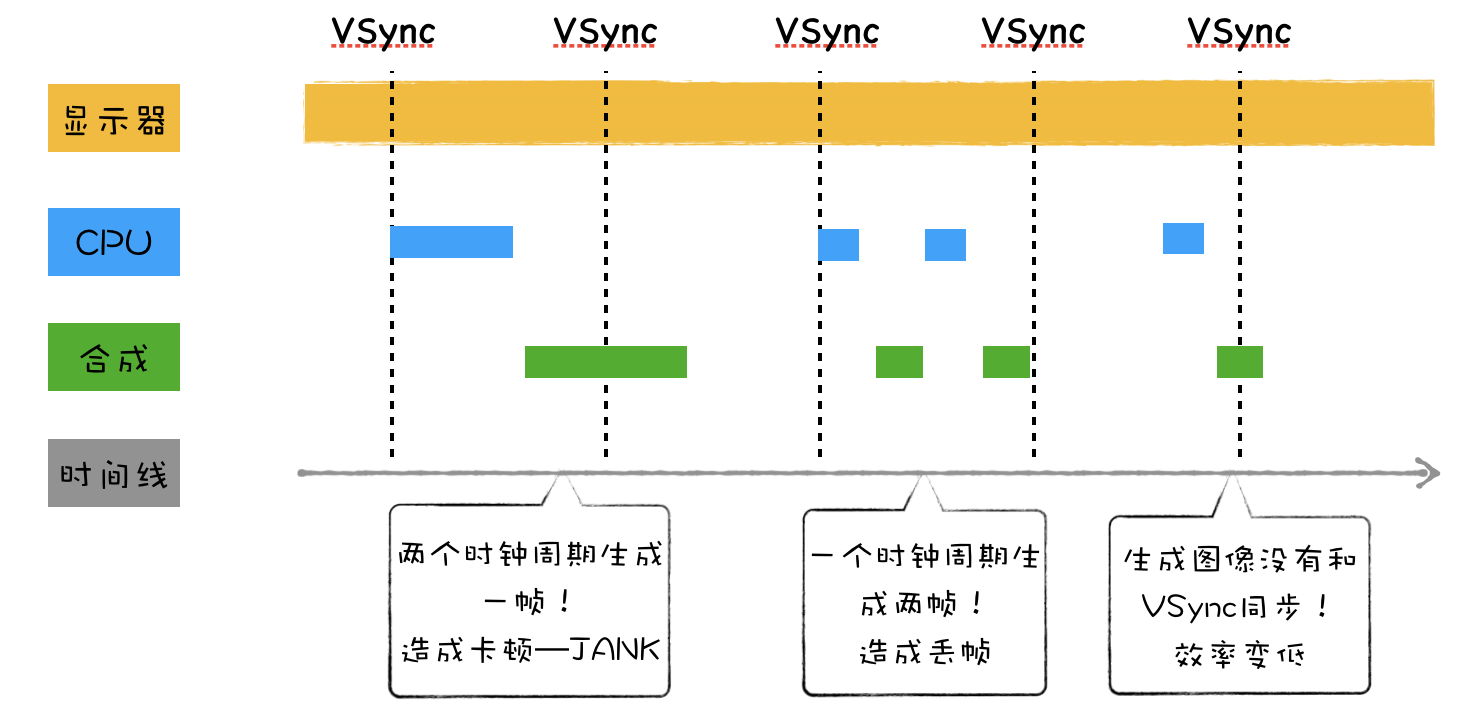

不过由于 JavaScript 是运行在主线程之上的,一旦执行垃圾回收算法,都需要将正在执行的 JavaScript 脚本暂停下来,待垃圾回收完毕后再恢复脚本执行。我们把这种行为叫做全停顿(Stop-The-World)

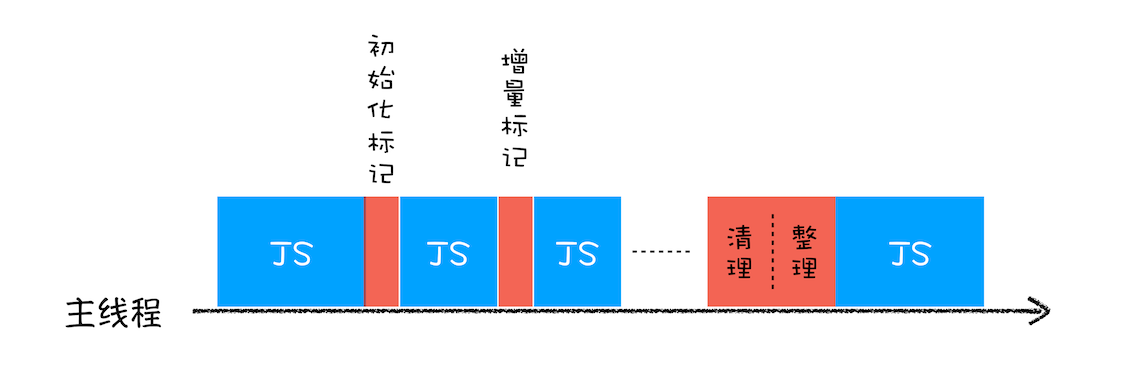

比如堆中的数据有 1.5GB,V8 实现一次完整的垃圾回收需要 1 秒以上的时间,这也是由于垃圾回收而引起 JavaScript 线程暂停执行的时间,若是这样的时间花销,那么应用的性能和响应能力都会直线下降。主垃圾回收器执行一次完整的垃圾回收流程如下图所示:

在 V8 新生代的垃圾回收中,因其空间较小,且存活对象较少,所以全停顿的影响不大,但老生代就不一样了。如果在执行垃圾回收的过程中,占用主线程时间过久,就像上面图片展示的那样,花费了 200 毫秒,在这 200 毫秒内,主线程是不能做其他事情的。比如页面正在执行一个 JavaScript 动画,因为垃圾回收器在工作,就会导致这个动画在这 200 毫秒内无法执行的,这将会造成页面的卡顿现象

为了降低老生代的垃圾回收而造成的卡顿,V8 将标记过程分为一个个的子标记过程,同时让垃圾回收标记和 JavaScript 应用逻辑交替进行,直到标记阶段完成,我们把这个算法称为增量标记(Incremental Marking)算法

使用增量标记算法,可以把一个完整的垃圾回收任务拆分为很多小的任务,这些小的任务执行时间比较短,可以穿插在其他的 JavaScript 任务中间执行,这样当执行上述动画效果时,就不会让用户因为垃圾回收任务而感受到页面的卡顿了

总结

无论是垃圾回收的策略,还是处理全停顿的策略,往往都没有一个完美的解决方案,你需要花一些时间来做权衡,而这需要牺牲当前某几方面的指标来换取其他几个指标的提升

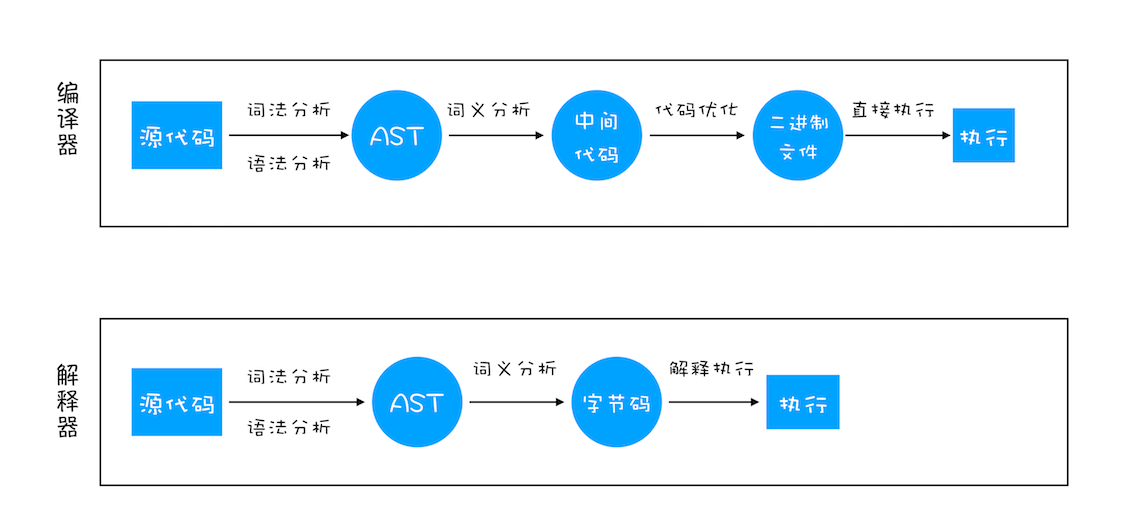

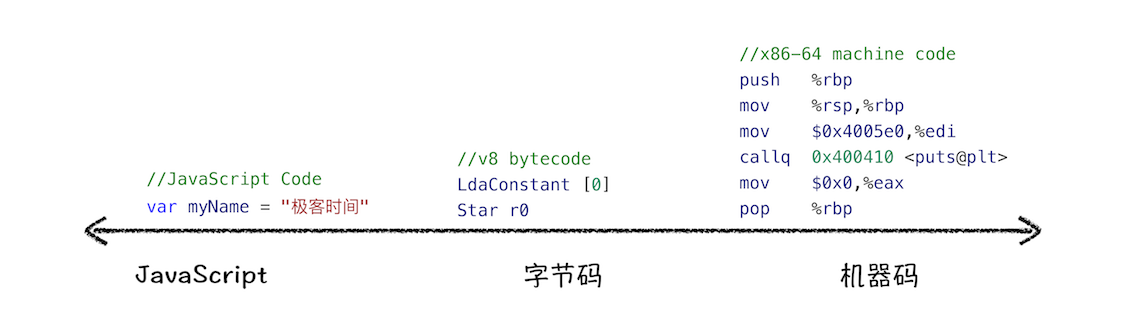

编译器和解释器

之所以存在编译器和解释器,是因为机器不能直接理解我们所写的代码,所以在执行程序之前,需要将我们所写的代码“翻译”成机器能读懂的机器语言。按语言的执行流程,可以把语言划分为编译型语言和解释型语言

编译型语言在程序执行之前,需要经过编译器的编译过程,并且编译之后会直接保留机器能读懂的二进制文件,这样每次运行程序时,都可以直接运行该二进制文件,而不需要再次重新编译了。比如 C/C++、GO 等都是编译型语言

而由解释型语言编写的程序,在每次运行时都需要通过解释器对程序进行动态解释和执行。比如 Python、JavaScript 等都属于解释型语言

1、在编译型语言的编译过程中,编译器首先会依次对源代码进行词法分析、语法分析,生成抽象语法树(AST),然后是优化代码,最后再生成处理器能够理解的机器码。如果编译成功,将会生成一个可执行的文件。但如果编译过程发生了语法或者其他的错误,那么编译器就会抛出异常,最后的二进制文件也不会生成成功

2、在解释型语言的解释过程中,同样解释器也会对源代码进行词法分析、语法分析,并生成抽象语法树(AST),不过它会再基于抽象语法树生成字节码,最后再根据字节码来执行程序、输出结果

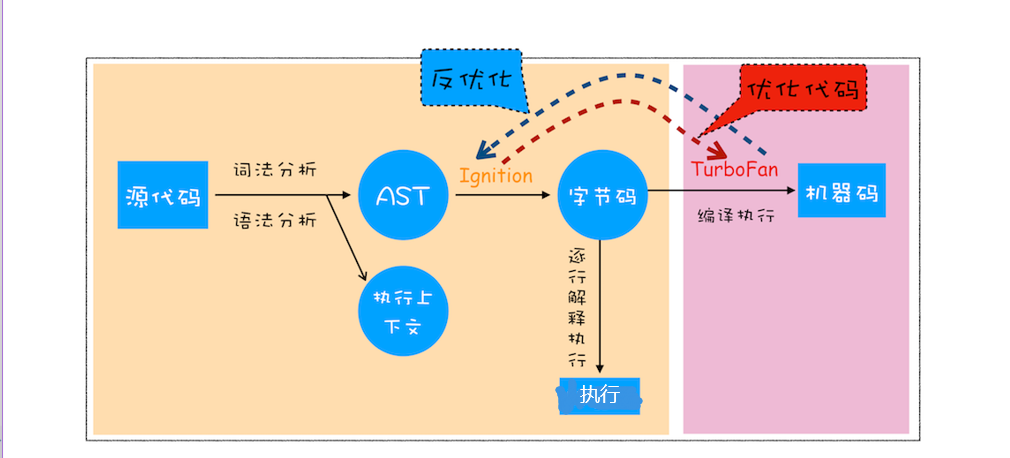

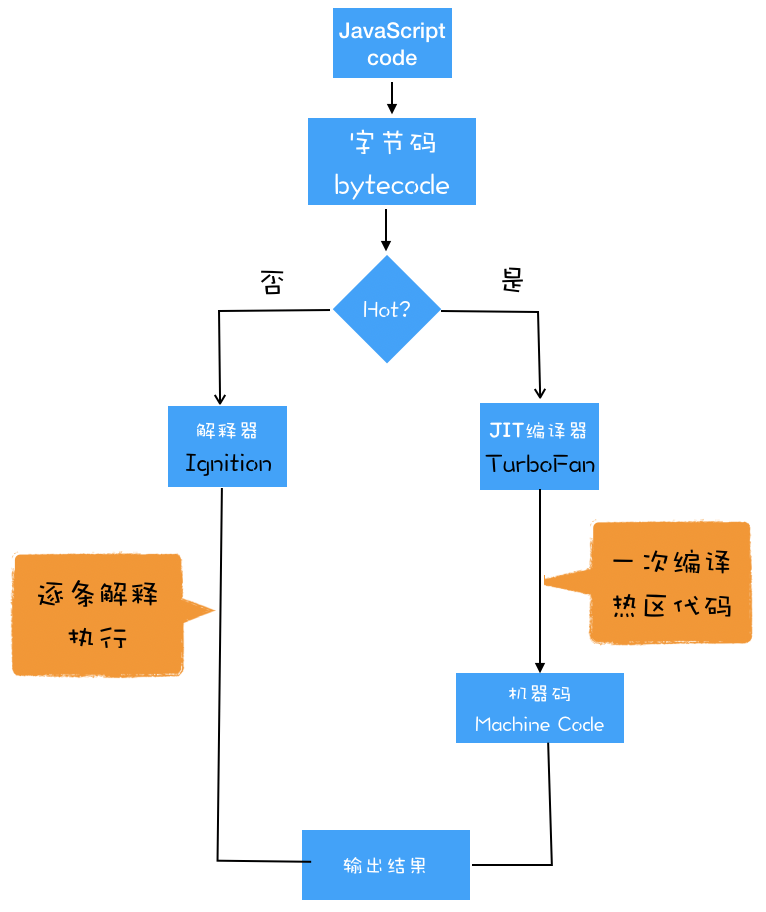

V8 是如何执行一段 JavaScript 代码的

从图中可以清楚地看到,V8 在执行过程中既有解释器 Ignition,又有编译器 TurboFan,那么它们是如何配合去执行一段 JavaScript 代码的呢?

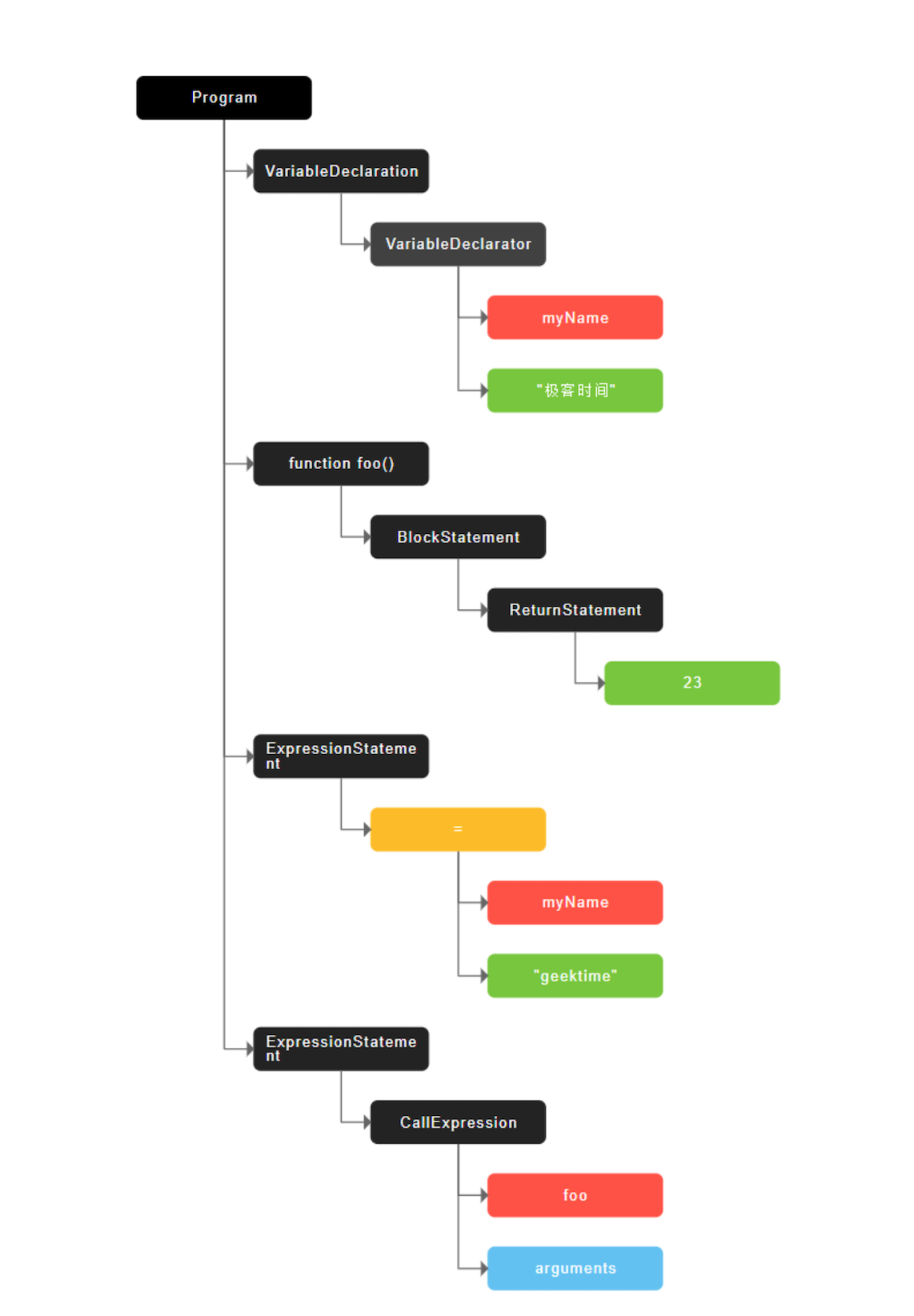

1、生成抽象语法树(AST)和执行上下文

将源代码转换为抽象语法树,并生成执行上下文

高级语言是开发者可以理解的语言,但是让编译器或者解释器来理解就非常困难了。对于编译器或者解释器来说,它们可以理解的就是 AST 了。所以无论你使用的是解释型语言还是编译型语言,在编译过程中,它们都会生成一个 AST

例如:

var myName = "极客时间";

function foo() {

return 23;

}

myName = "geektime";

foo();生成的 AST 结构如下(站点:https://resources.jointjs.com/demos/javascript-ast):

AST 的结构和代码的结构非常相似,其实也可以把 AST 看成代码的结构化的表示,编译器或者解释器后续的工作都需要依赖于 AST,而不是源代码

AST 是非常重要的一种数据结构,在很多项目中有着广泛的应用。其中最著名的一个项目是 Babel。Babel 是一个被广泛使用的代码转码器,可以将 ES6 代码转为 ES5 代码,这意味着你可以现在就用 ES6 编写程序,而不用担心现有环境是否支持 ES6。Babel 的工作原理就是先将 ES6 源码转换为 AST,然后再将 ES6 语法的 AST 转换为 ES5 语法的 AST,最后利用 ES5 的 AST 生成 JavaScript 源代码

除了 Babel 外,还有 ESLint 也使用 AST。ESLint 是一个用来检查 JavaScript 编写规范的插件,其检测流程也是需要将源码转换为 AST,然后再利用 AST 来检查代码规范化的问题

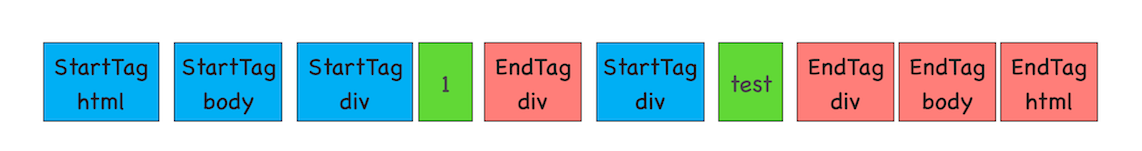

第一阶段是分词(tokenize),又称为词法分析,其作用是将一行行的源码拆解成一个个 token。所谓 token,指的是语法上不可能再分的、最小的单个字符或字符串

从图中可以看出,通过 var myName = “极客时间”简单地定义了一个变量,其中关键字“var”、标识符“myName” 、赋值运算符“=”、字符串“极客时间”四个都是 token,而且它们代表的属性还不一样

第二阶段是解析(parse),又称为语法分析,其作用是将上一步生成的 token 数据,根据语法规则转为 AST。如果源码符合语法规则,这一步就会顺利完成。但如果源码存在语法错误,这一步就会终止,并抛出一个“语法错误”

有了 AST 后,那接下来 V8 就会生成该段代码的执行上下文

2、生成字节码

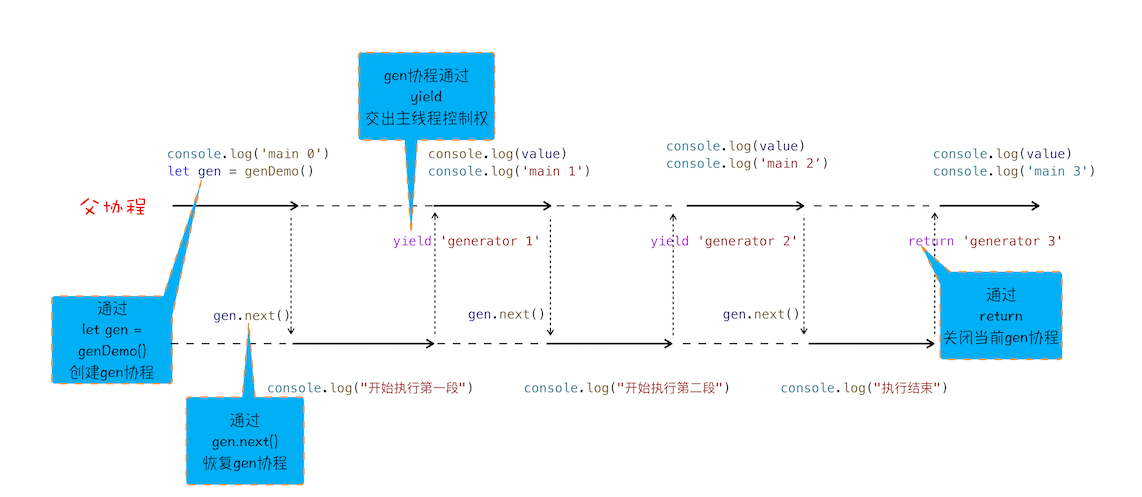

有了 AST 和执行上下文后,解释器 Ignition 就登场了,它会根据 AST 生成字节码,并解释执行字节码

其实一开始 V8 并没有字节码,而是直接将 AST 转换为机器码,由于执行机器码的效率是非常高效的,所以这种方式在发布后的一段时间内运行效果是非常好的。但是随着 Chrome 在手机上的广泛普及,特别是运行在 512M 内存的手机上,内存占用问题也暴露出来了,因为 V8 需要消耗大量的内存来存放转换后的机器码。为了解决内存占用问题,V8 团队大幅重构了引擎架构,引入字节码,并且抛弃了之前的编译器,最终花了将进四年的时间,实现了现在的这套架构字节码就是介于 AST 和机器码之间的一种代码。但是与特定类型的机器码无关,字节码需要通过解释器将其转换为机器码后才能执行

字节码就是介于 AST 和机器码之间的一种代码。但是与特定类型的机器码无关,字节码需要通过解释器将其转换为机器码后才能执行

机器码所占用的空间远远超过了字节码,所以使用字节码可以减少系统的内存使用

3、执行代码

生成字节码之后,接下来就要进入执行阶段了

通常,如果有一段第一次执行的字节码,解释器 Ignition 会逐条解释执行。到了这里,相信你已经发现了,解释器 Ignition 除了负责生成字节码之外,它还有另外一个作用,就是解释执行字节码。在 Ignition 执行字节码的过程中,如果发现有热点代码(HotSpot),比如一段代码被重复执行多次,这种就称为热点代码,那么后台的编译器 TurboFan 就会把该段热点的字节码编译为高效的机器码,然后当再次执行这段被优化的代码时,只需要执行编译后的机器码就可以了,这样就大大提升了代码的执行效率

V8 的解释器和编译器的取名也很有意思。解释器 Ignition 是点火器的意思,编译器 TurboFan 是涡轮增压的意思,寓意着代码启动时通过点火器慢慢发动,一旦启动,涡轮增压介入,其执行效率随着执行时间越来越高效率,因为热点代码都被编译器 TurboFan 转换了机器码,直接执行机器码就省去了字节码“翻译”为机器码的过程

其实字节码配合解释器和编译器是最近一段时间很火的技术,比如 Java 和 Python 的虚拟机也都是基于这种技术实现的,我们把这种技术称为即时编译(JIT)。具体到 V8,就是指解释器 Ignition 在解释执行字节码的同时,收集代码信息,当它发现某一部分代码变热了之后,TurboFan 编译器便闪亮登场,把热点的字节码转换为机器码,并把转换后的机器码保存起来,以备下次使用

对于 JavaScript 工作引擎,除了 V8 使用了“字节码 +JIT”技术之外,苹果的 SquirrelFish Extreme 和 Mozilla 的 SpiderMonkey 也都使用了该技术

JIT 工作过程:

JavaScript 性能优化

虽然在 V8 诞生之初,也出现过一系列针对 V8 而专门优化 JavaScript 性能的方案,比如隐藏类、内联缓存等概念都是那时候提出来的。不过随着 V8 的架构调整,你越来越不需要这些微优化策略了,相反,对于优化 JavaScript 执行效率,你应该将优化的中心聚焦在单次脚本的执行时间和脚本的网络下载上,主要关注以下三点内容:

1、提升单次脚本的执行速度,避免 JavaScript 的长任务霸占主线程,这样可以使得页面快速响应交互

2、避免大的内联脚本,因为在解析 HTML 的过程中,解析和编译也会占用主线程

3、减少 JavaScript 文件的容量,因为更小的文件会提升下载速度,并且占用更低的内存。

总结

1、V8 解析后的字节码或热节点的机器码是存在哪的,是以缓存的形式存储的么?和浏览器三级缓存原理的存储位置比如内存和磁盘有关系么?

判断是否命中强制缓存:当命中强制缓存时,状态码为 200, 请求对应的 Size 值则代表该缓存存放的位置,分别为 from memory cache 和 from disk cache。 from memory cache 代表使用内存中的缓存,from disk cache 则代表使用的是硬盘中的缓存,浏览器读取缓存的顺序为 memory > disk。 1.内存缓存(from memory cache):内存缓存具有两个特点,分别是快速读取和时效性: 快速读取:内存缓存会将编译解析后的文件,直接存入该进程的内存中,占据该进程一定的内存资源,以方便下次运行使用时的快速读取。 时效性:一旦该进程关闭,则该进程的内存则会清空。 2.硬盘缓存(from disk cache):硬盘缓存则是直接将缓存写入硬盘文件中,读取缓存需要对该缓存存放的硬盘文件进行 I/O 操作,然后重新解析该缓存内容,读取复杂,速度比内存缓存慢。退出进程不会清空。 一般 JS,字体,图片等会放在内存中,而 CSS 则会放在硬盘缓存

2、避免大的内联脚本,因为在解析 HTML 的过程中,解析和编译也会占用主线程;这句话可以理解为解析 HTML 代码的时候需要解析内联代码,而放到 js 文件的时候不需要吗?

只要是同步脚本都会阻塞

同步脚本尽量小,尽量能内联,其它的尽量采用异步脚本,如使用 aysnc 和 defer

3、字节码是解释器生成的吗?

流程是这样的:

v8 先生成 ast

然后 ignition 根据 ast 生成字节码

在然后 ignition 解释执行字节码

所以 ignition 生成了字节码并解释执行字节码

4、面试被问到:js 在编译过程中,会做一定的优化,那么日常开发,应该怎么利用这个优化,提升代码质量?

代码里尽量当做强类型语言来写,不要混用数据类型;比如:var a = ''; a = 1; 这样不利于 JIT 优化,因为 JIT 编译时,会因为这种类型的混用做一些额外的处理

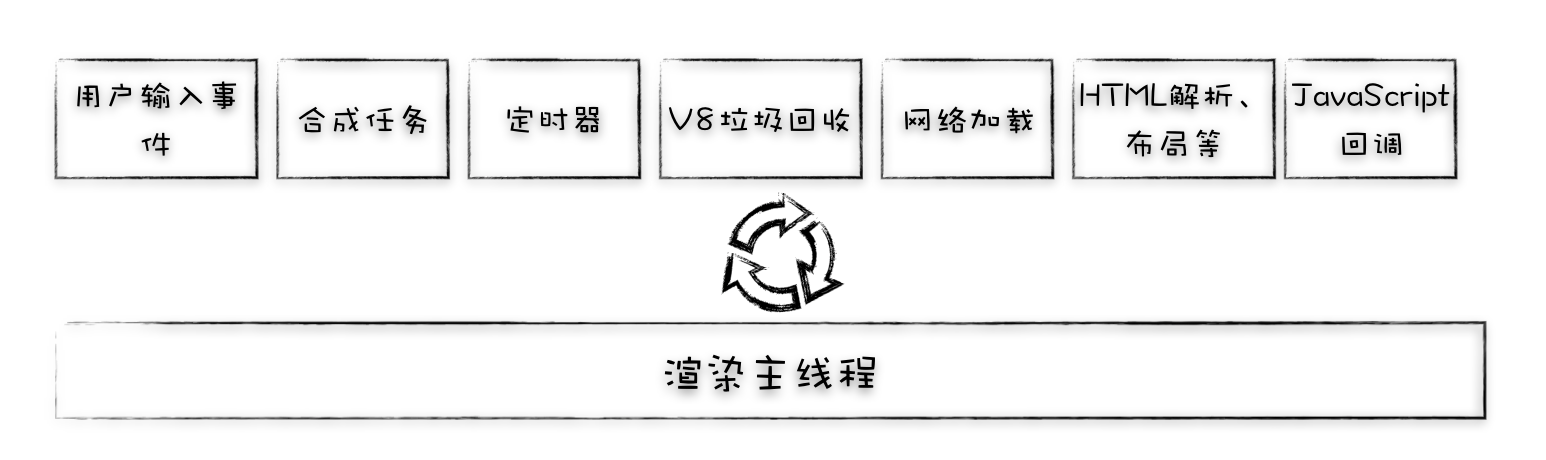

消息队列和事件循环

每个渲染进程都有一个主线程,并且主线程非常繁忙,既要处理 DOM,又要计算样式,还要处理布局,同时还需要处理 JavaScript 任务以及各种输入事件

要让这么多不同类型的任务在主线程中有条不紊地执行,这就需要一个系统来统筹调度这些任务,这个统筹调度系统就是我们今天要讲的消息队列和事件循环系统

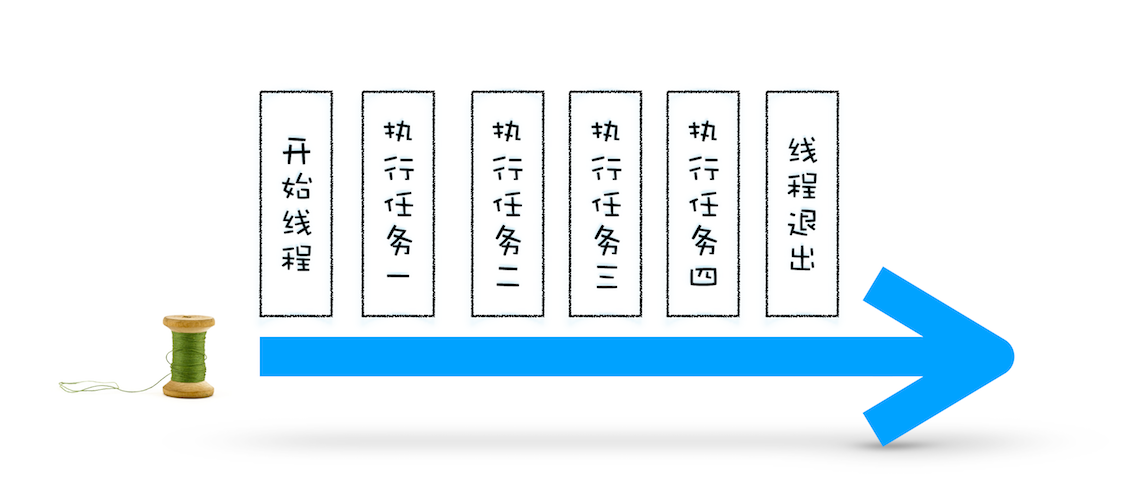

使用单线程处理安排好的任务

先从最简单的场景讲起,比如有如下一系列的任务:

- 任务 1:1+2

- 任务 2:20/5

- 任务 3:7*8

- 任务 4:打印出任务 1、任务 2、任务 3 的运算结果

void MainThread(){

int num1 = 1+2; //任务1

int num2 = 20/5; //任务2

int num3 = 7*8; //任务3

print("最终计算的值为:%d,%d,%d",num1,num2,num3); //任务4

}在上面的执行代码中,我们把所有任务代码按照顺序写进主线程里,等线程执行时,这些任务会按照顺序在线程中依次被执行;等所有任务执行完成之后,线程会自动退出。可以参考下图来直观地理解下其执行过程:

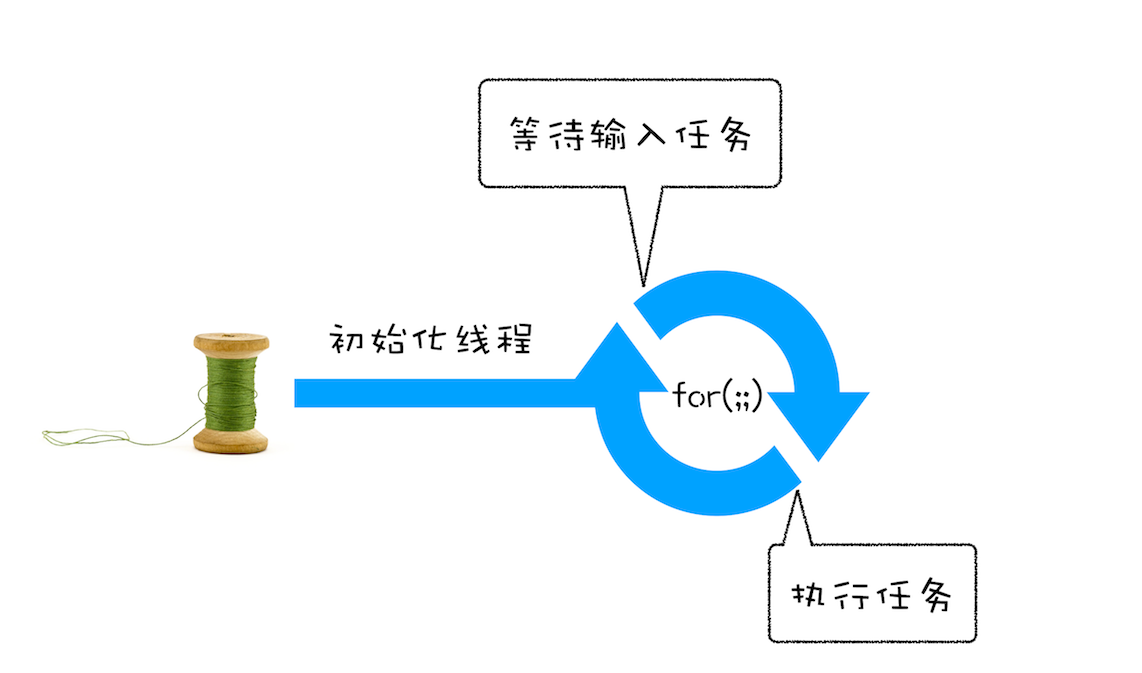

在线程运行过程中处理新任务

但并不是所有的任务都是在执行之前统一安排好的,大部分情况下,新的任务是在线程运行过程中产生的。比如在线程执行过程中,又接收到了一个新的任务要求计算“10+2”,那上面那种方式就无法处理这种情况了

要想在线程运行过程中,能接收并执行新的任务,就需要采用事件循环机制,可以通过一个 for 循环语句来监听是否有新的任务

//GetInput

//等待用户从键盘输入一个数字,并返回该输入的数字

int GetInput(){

int input_number = 0;

cout<<"请输入一个数:";

cin>>input_number;

return input_number;

}

//主线程(Main Thread)

void MainThread(){

for(;;){

int first_num = GetInput();

int second_num = GetInput();

result_num = first_num + second_num;

print("最终计算的值为:%d",result_num);

}

}相较于第一版的线程,这一版的线程做了两点改进

- 第一点引入了循环机制,具体实现方式是在线程语句最后添加了一个 for 循环语句,线程会一直循环执行

- 第二点是引入了事件,可以在线程运行过程中,等待用户输入的数字,等待过程中线程处于暂停状态,一旦接收到用户输入的信息,那么线程会被激活,然后执行相加运算,最后输出结果

通过引入事件循环机制,就可以让该线程“活”起来了,我们每次输入两个数字,都会打印出两数字相加的结果,可以结合下图来参考下这个改进版的线程:

处理其他线程发送过来的任务

在第二版的线程模型中,所有的任务都是来自于线程内部的,如果另外一个线程想让主线程执行一个任务,利用第二版的线程模型是无法做到的

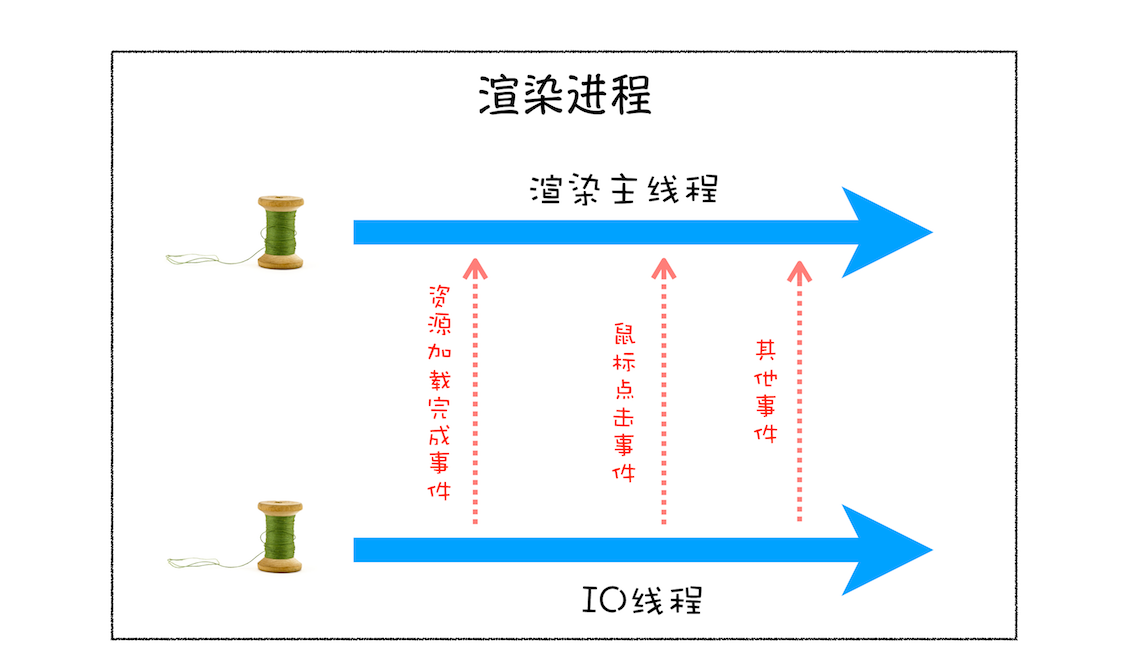

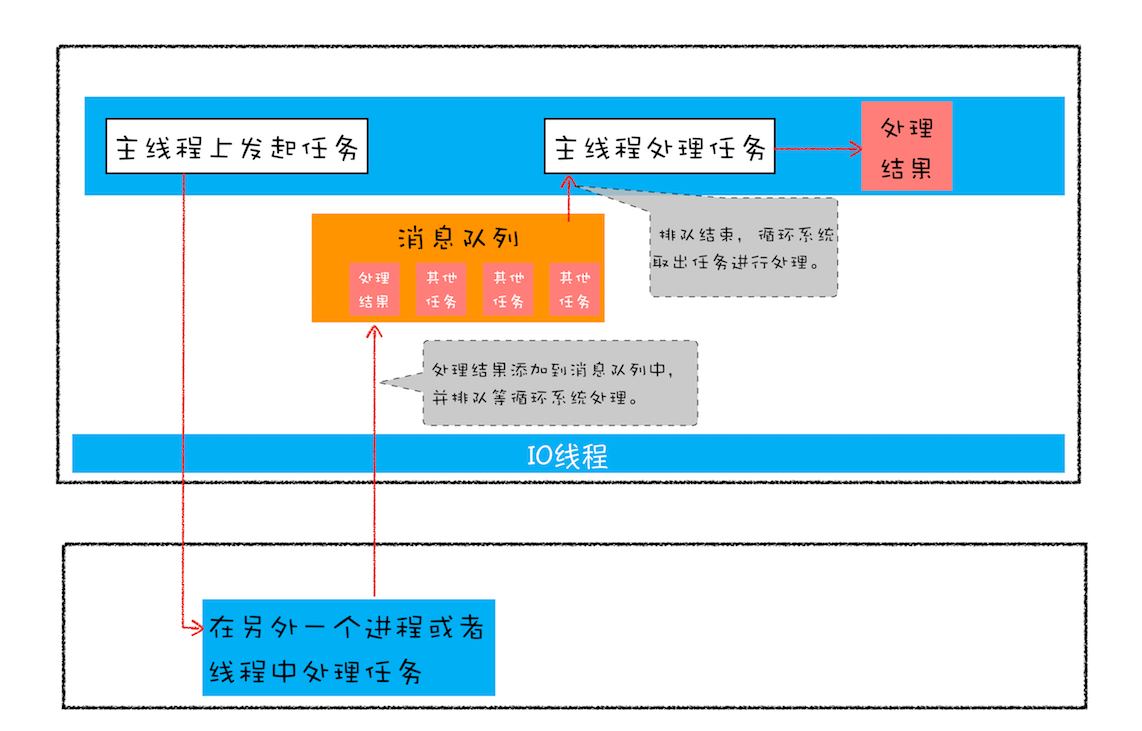

其他线程是如何发送消息给渲染主线程的:

从上图可以看出,渲染主线程会频繁接收到来自于 IO 线程的一些任务,接收到这些任务之后,渲染进程就需要着手处理,比如接收到资源加载完成的消息后,渲染主线程就要着手进行 DOM 解析了;接收到鼠标点击的消息后,渲染主线程就要开始执行相应的 JavaScript 脚本来处理该点击事件

如何设计好一个线程模型,能让其能够接收其他线程发送的消息呢?

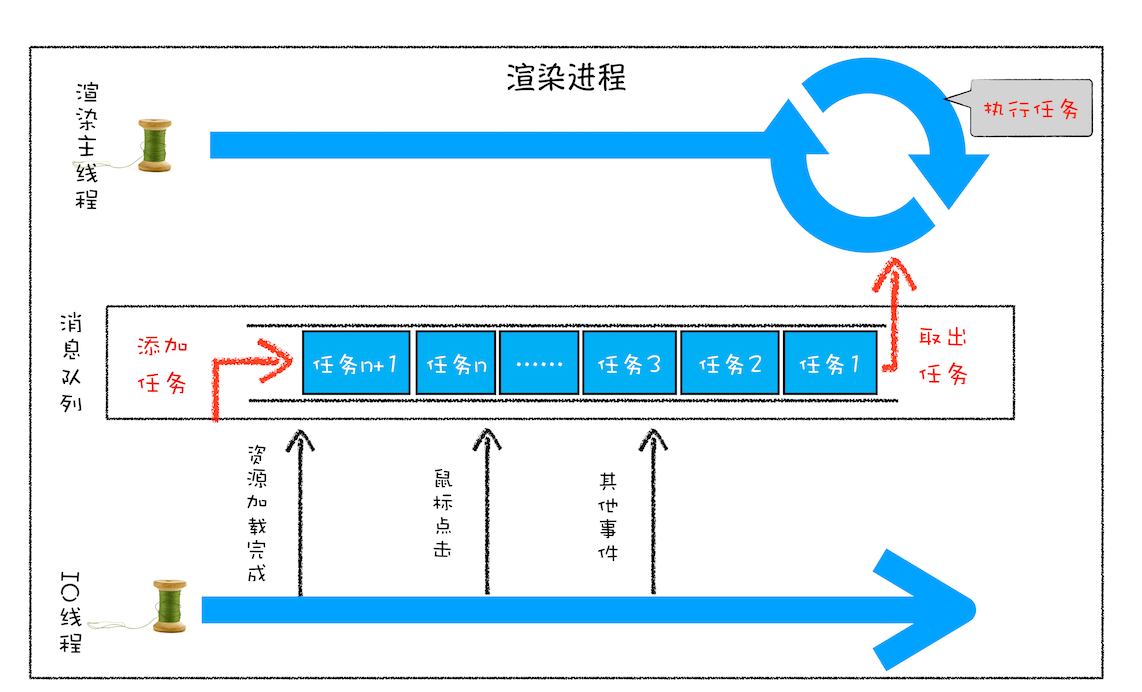

一个通用模式是使用消息队列

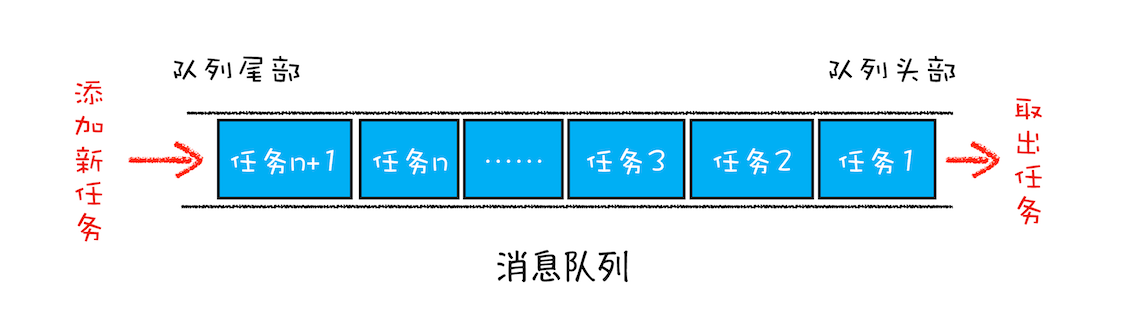

消息队列是一种数据结构,可以存放要执行的任务。它符合队列“先进先出”的特点,也就是说要添加任务的话,添加到队列的尾部;要取出任务的话,从队列头部去取

然后我们继续改造线程模型:

我们的改造可以分为下面三个步骤:

1、添加一个消息队列

2、IO 线程中产生的新任务添加进消息队列尾部

3、渲染主线程会循环地从消息队列头部中读取任务,执行任务

有了这些步骤之后,我们就可以按步骤使用代码来实现第三版的线程模型

class TaskQueue{

public:

Task takeTask(); //取出队列头部的一个任务

void pushTask(Task task); //添加一个任务到队列尾部

};

TaskQueue task_queue;

void ProcessTask();

void MainThread(){

for(;;){

Task task = task_queue.takeTask();

ProcessTask(task);

}

}

// 添加任务到消息队列

Task clickTask;

task_queue.pushTask(clickTask)由于是多个线程操作同一个消息队列,所以在添加任务和取出任务时还会加上一个同步锁

处理其他进程发送过来的任务

通过使用消息队列,我们实现了线程之间的消息通信。在 Chrome 中,跨进程之间的任务也是频繁发生的,那么如何处理其他进程发送过来的任务?

从图中可以看出,渲染进程专门有一个 IO 线程用来接收其他进程传进来的消息,接收到消息之后,会将这些消息组装成任务发送给渲染主线程

消息队列中的任务类型

如输入事件(鼠标滚动、点击、移动)、微任务、文件读写、WebSocket、JavaScript 定时器等等,都属于内部消息类型(更多事件类型查阅官方源码:https://source.chromium.org/chromium/chromium/src/+/main:third_party/blink/public/platform/task_type.h)

除此之外,消息队列中还包含了很多与页面相关的事件,如 JavaScript 执行、解析 DOM、样式计算、布局计算、CSS 动画等

以上这些事件都是在主线程中执行的,所以在编写 Web 应用时,你还需要衡量这些事件所占用的时长,并想办法解决单个任务占用主线程过久的问题

如何安全退出

当页面主线程执行完成之后,又该如何保证页面主线程能够安全退出呢?

Chrome 在确定要退出当前页面时,页面主线程会设置一个退出标志的变量,在每次执行完一个任务时,判断是否有设置退出标志

如果设置了,那么就直接中断当前的所有任务,退出线程,你可以参考下面代码

TaskQueue task_queue;

void ProcessTask();

bool keep_running = true;

void MainThread(){

for(;;){

Task task = task_queue.takeTask();

ProcessTask(task);

if(!keep_running) //如果设置了退出标志,那么直接退出线程循环

break;

}

}页面使用单线程的缺点

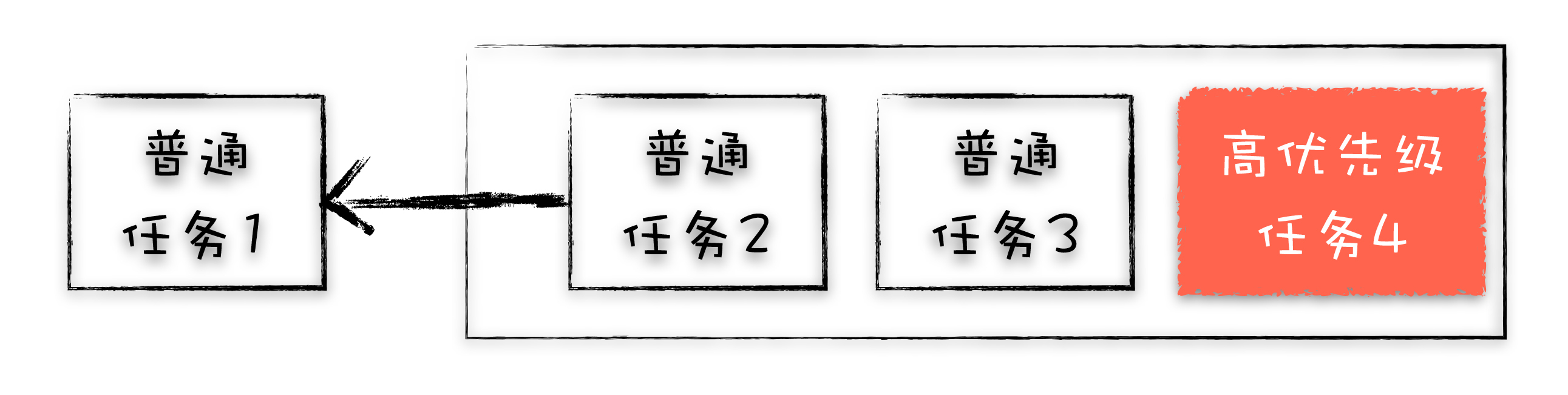

页面线程所有执行的任务都来自于消息队列。消息队列是“先进先出”的属性,也就是说放入队列中的任务,需要等待前面的任务被执行完,才会被执行。鉴于这个属性,就有如下两个问题需要解决

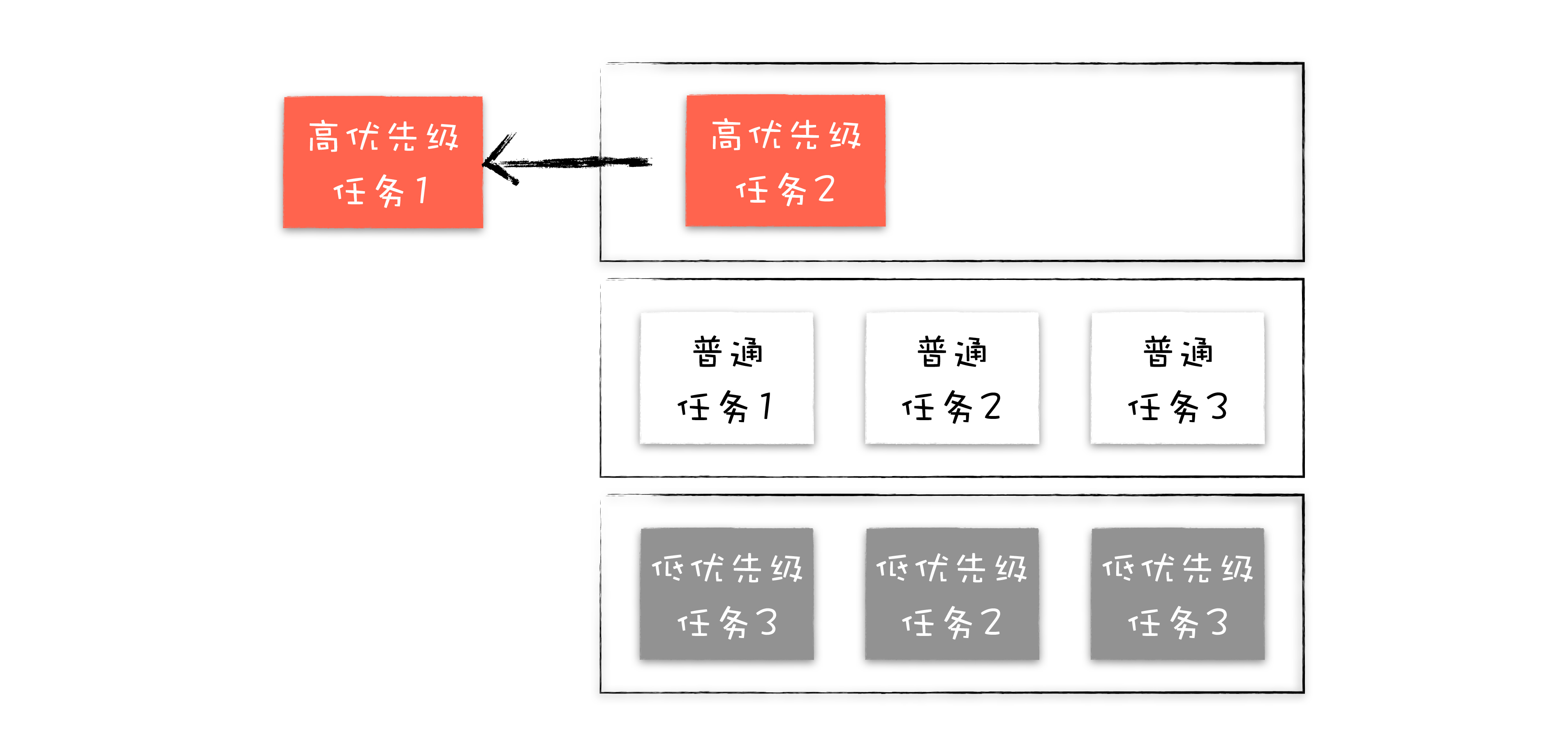

第一个问题是如何处理高优先级的任务

如何处理高优先级的任务。比如一个典型的场景是监控 DOM 节点的变化情况(节点的插入、修改、删除等动态变化),然后根据这些变化来处理相应的业务逻辑。一个通用的设计的是,利用 JavaScript 设计一套监听接口,当变化发生时,渲染引擎同步调用这些接口,这是一个典型的观察者模式

不过这个模式有个问题,因为 DOM 变化非常频繁,如果每次发生变化的时候,都直接调用相应的 JavaScript 接口,那么这个当前的任务执行时间会被拉长,从而导致执行效率的下降

如果将这些 DOM 变化做成异步的消息事件,添加到消息队列的尾部,那么又会影响到监控的实时性,因为在添加到消息队列的过程中,可能前面就有很多任务在排队了

这也就是说,如果 DOM 发生变化,采用同步通知的方式,会影响当前任务的执行效率;如果采用异步方式,又会影响到监控的实时性。那该如何权衡效率和实时性呢?

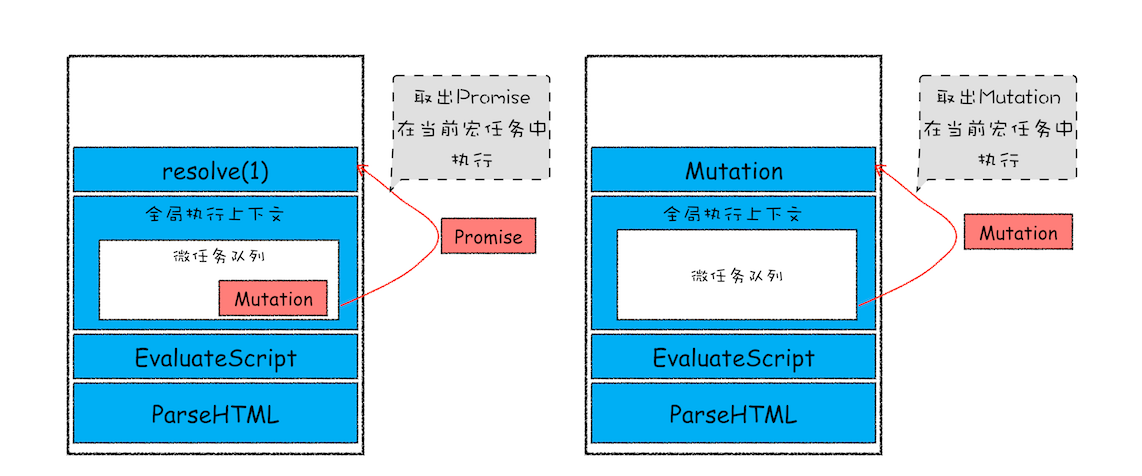

针对这种情况,微任务就应运而生了

通常我们把消息队列中的任务称为宏任务,每个宏任务中都包含了一个微任务队列,在执行宏任务的过程中,如果 DOM 有变化,那么就会将该变化添加到微任务列表中,这样就不会影响到宏任务的继续执行,因此也就解决了执行效率的问题

等宏任务中的主要功能都直接完成之后,这时候,渲染引擎并不着急去执行下一个宏任务,而是执行当前宏任务中的微任务,因为 DOM 变化的事件都保存在这些微任务队列中,这样也就解决了实时性问题

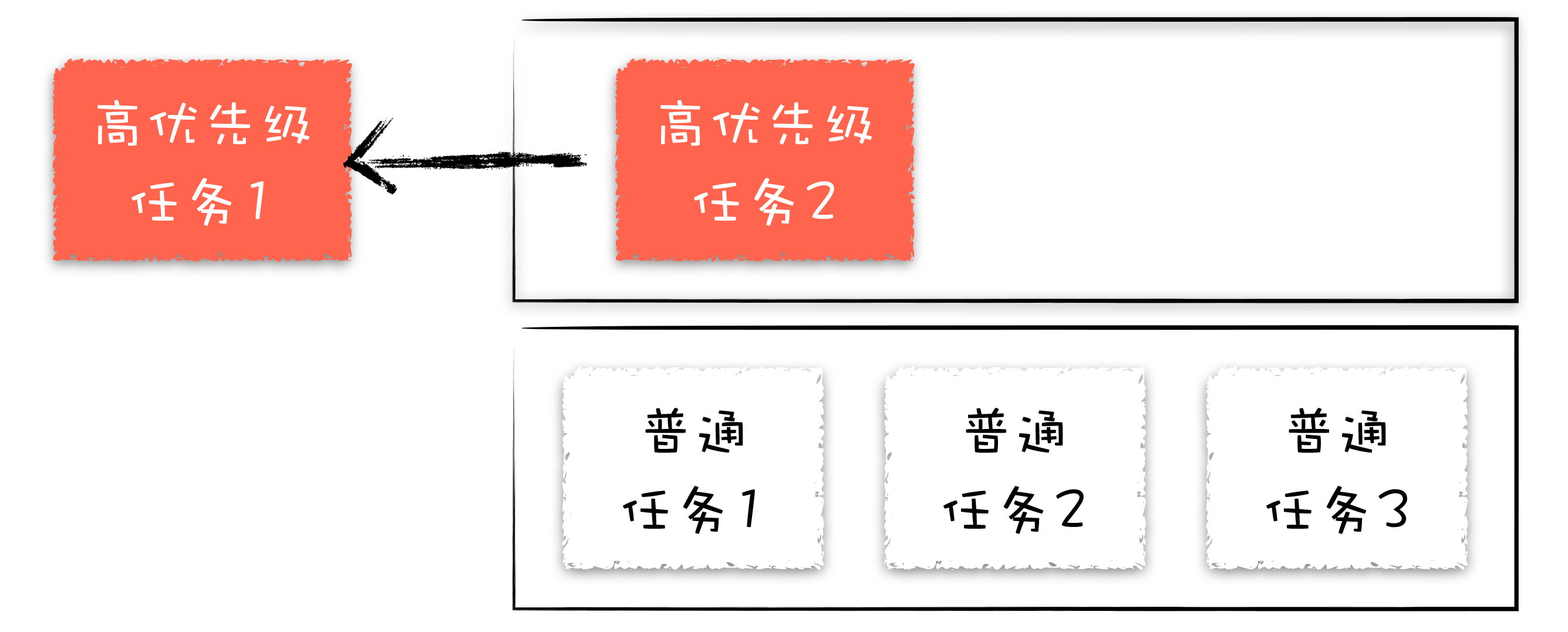

第二个是如何解决单个任务执行时长过久的问题

因为所有的任务都是在单线程中执行的,所以每次只能执行一个任务,而其他任务就都处于等待状态。如果其中一个任务执行时间过久,那么下一个任务就要等待很长时间。可以参考下图:

如果在执行动画过程中,其中有个 JavaScript 任务因执行时间过久,占用了动画单帧的时间,这样会给用户制造了卡顿的感觉,这当然是极不好的用户体验。针对这种情况,JavaScript 可以通过回调功能来规避这种问题,也就是让要执行的 JavaScript 任务滞后执行

实践:浏览器页面是如何运行的

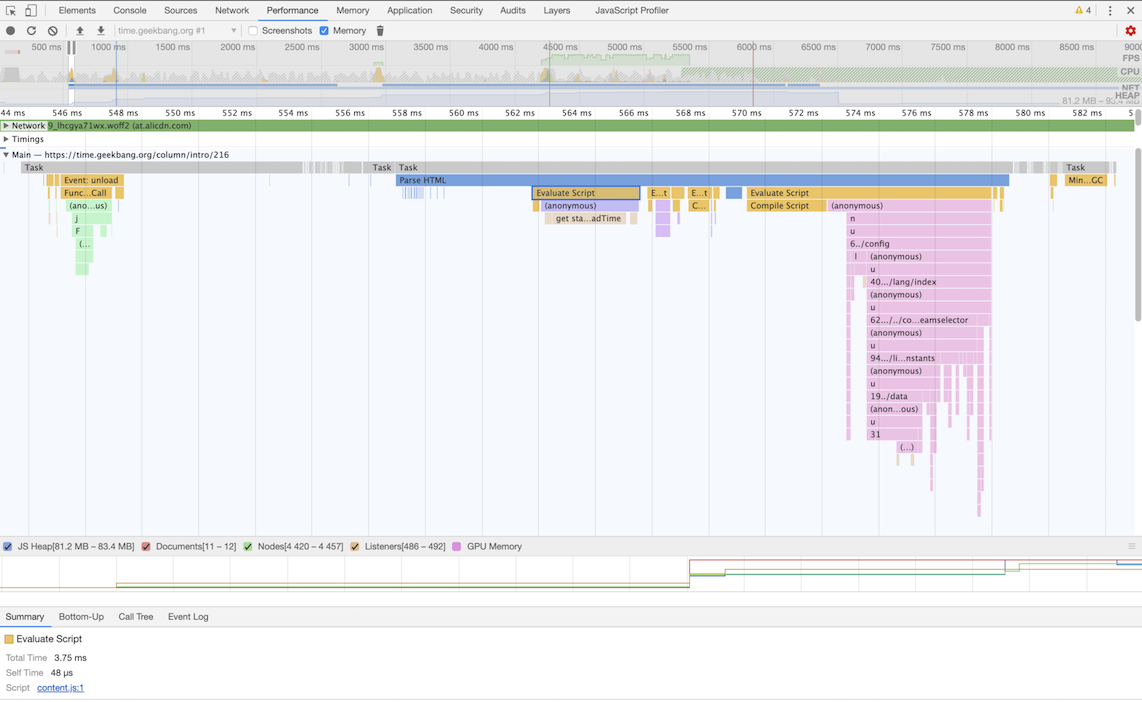

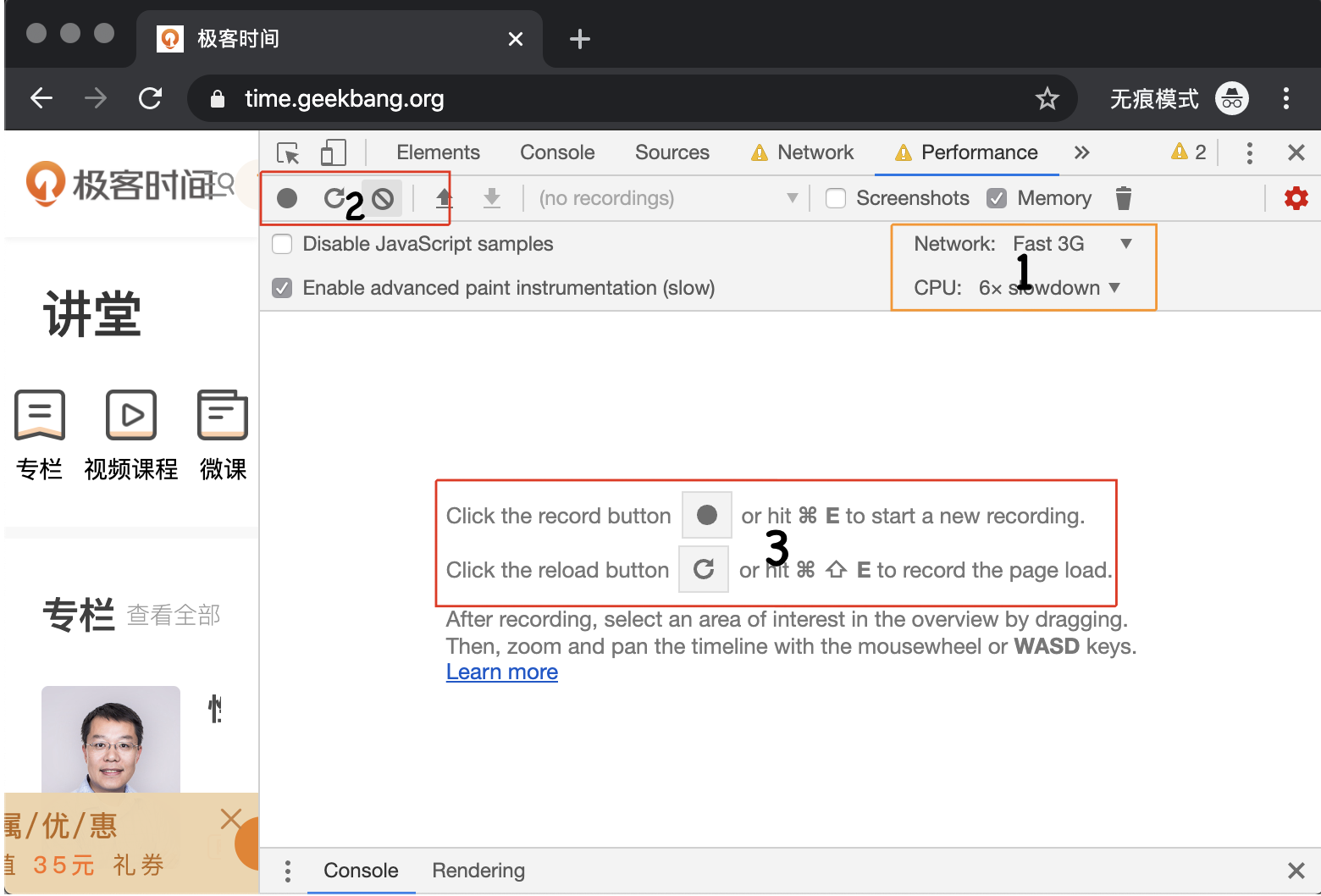

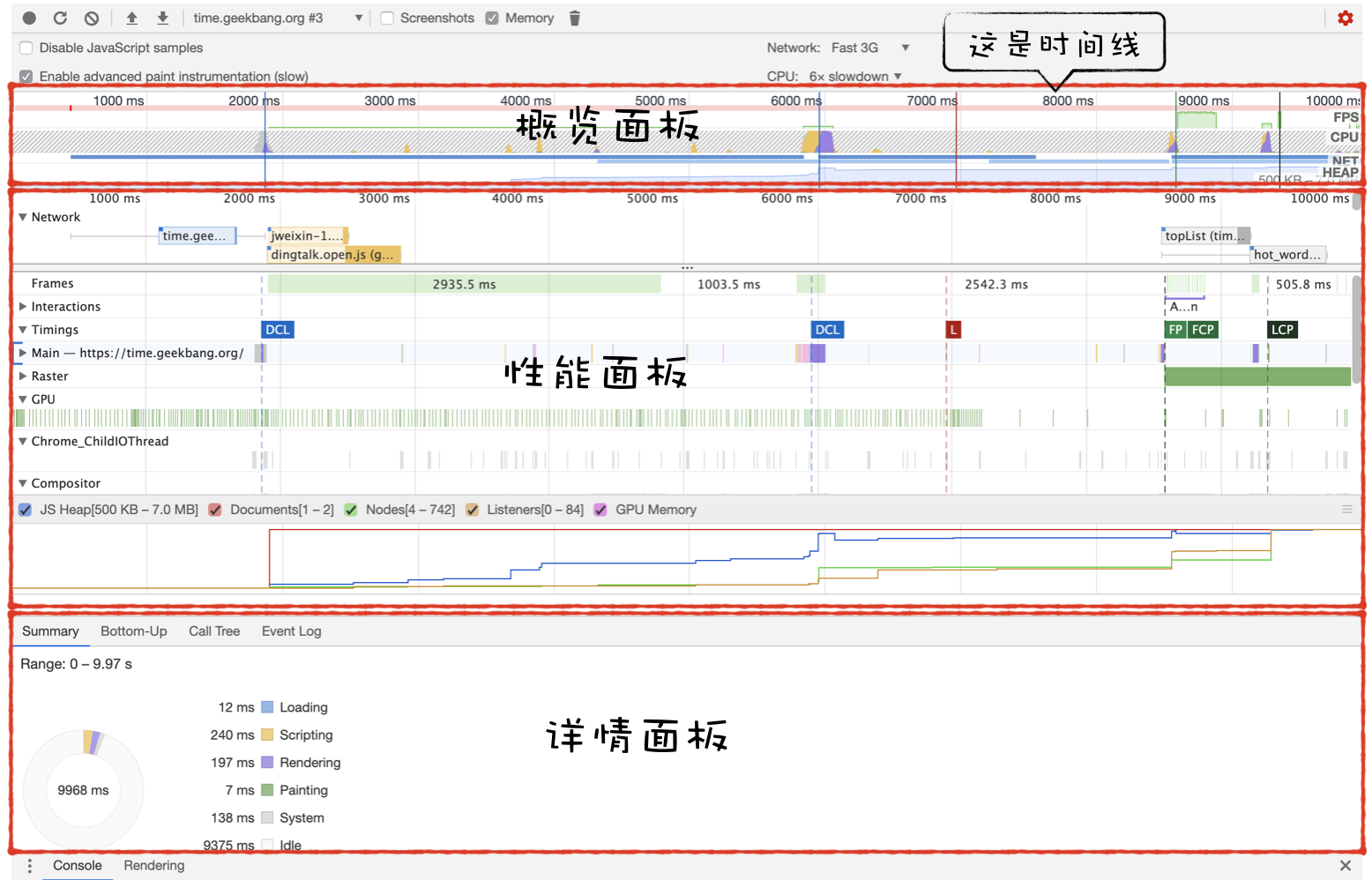

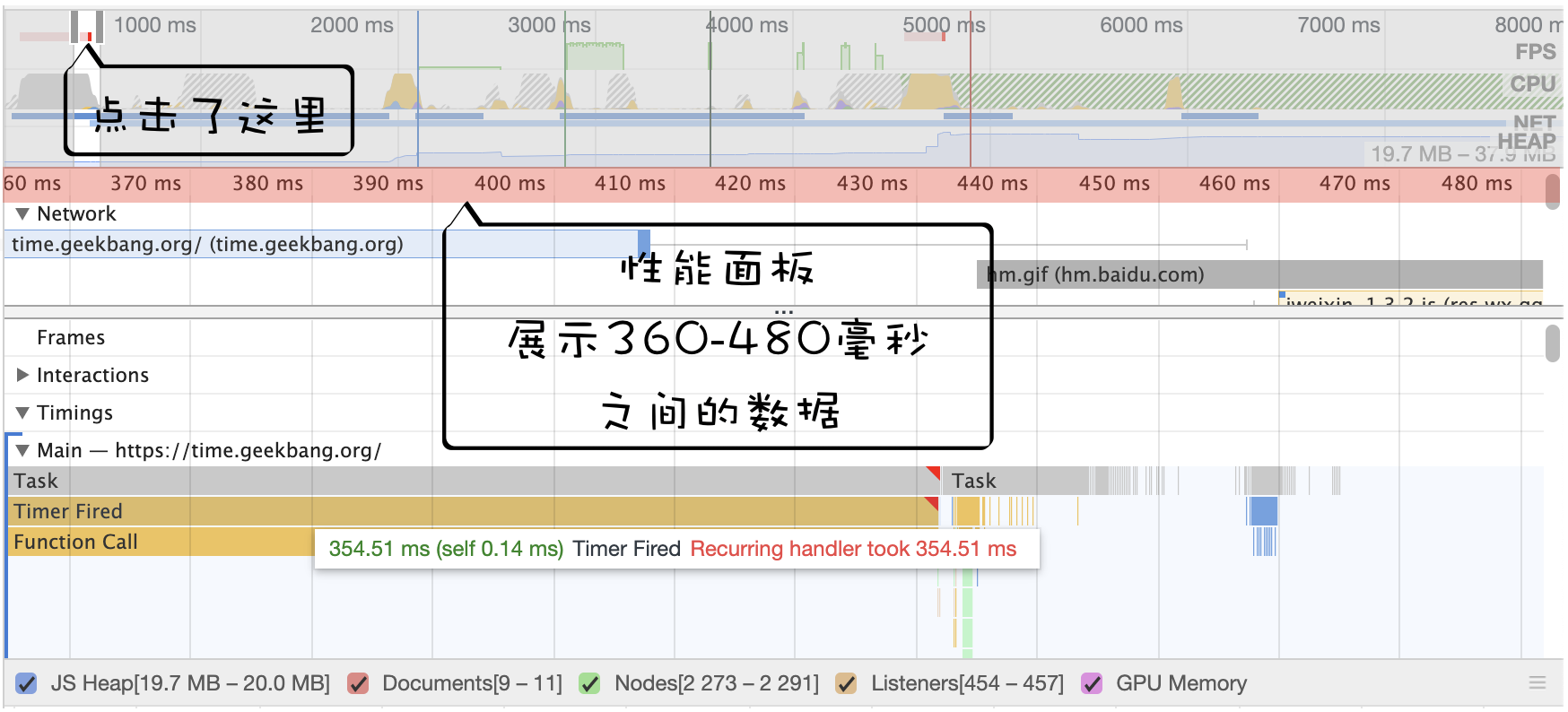

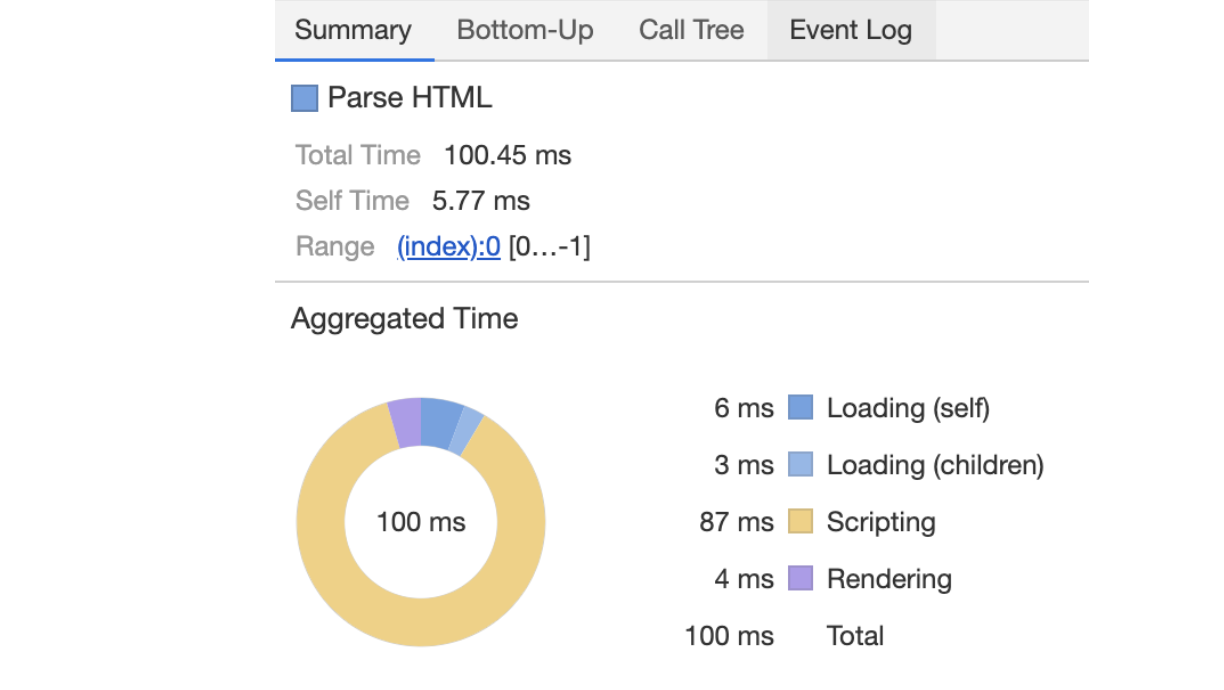

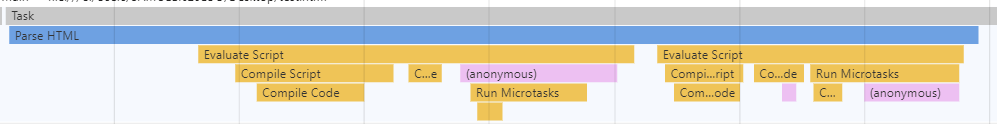

可以打开开发者工具,点击“Performance”标签,选择左上角的“start porfiling and load page”来记录整个页面加载过程中的事件执行情况:

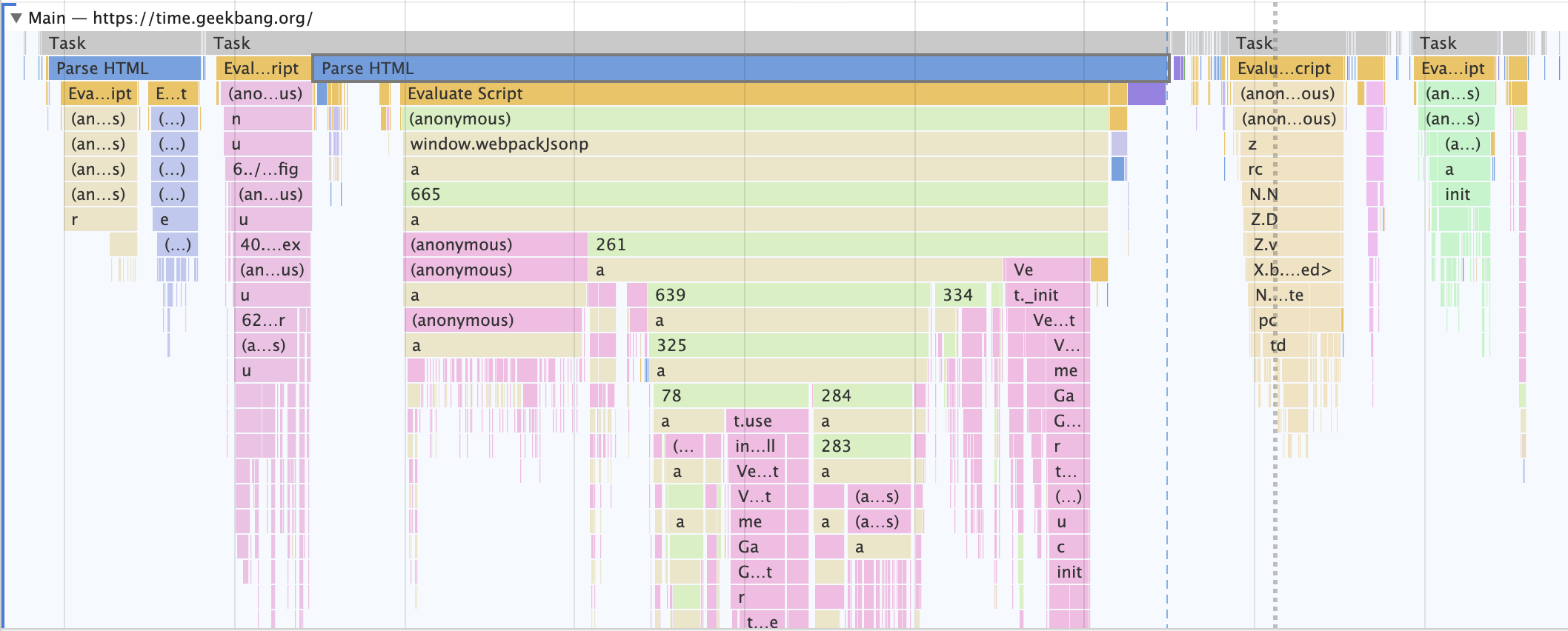

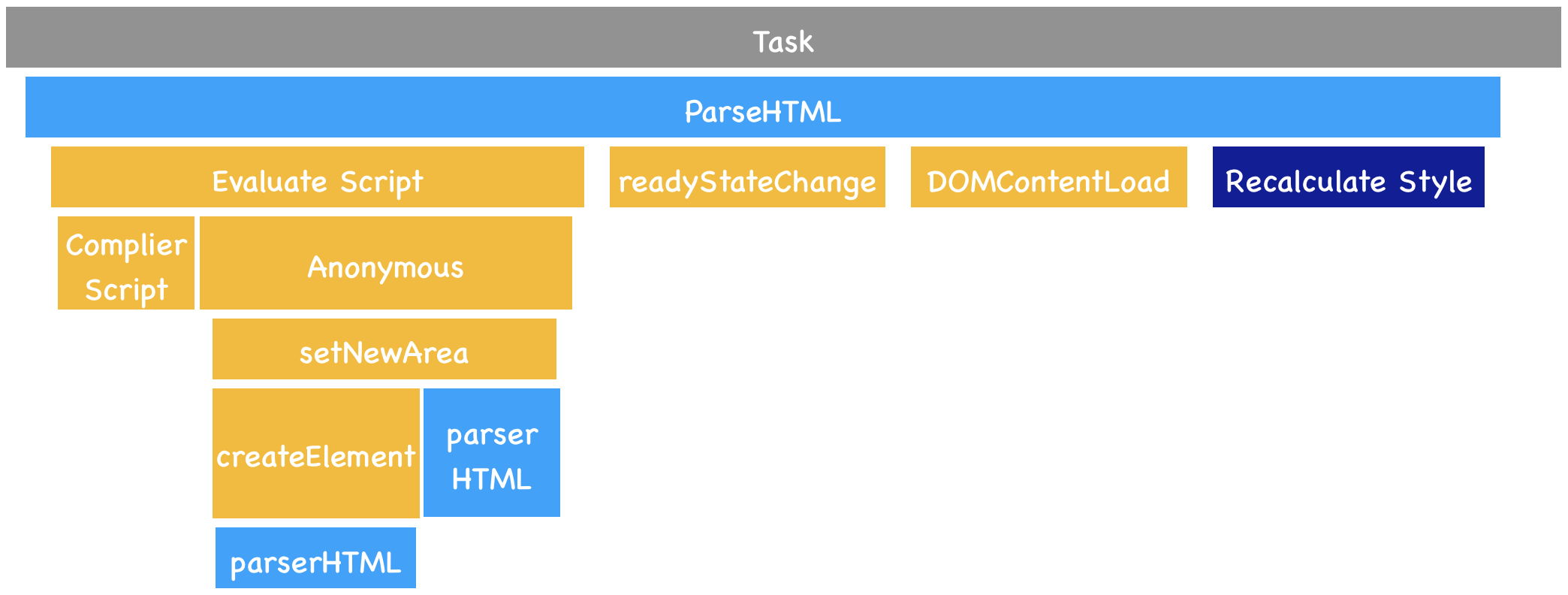

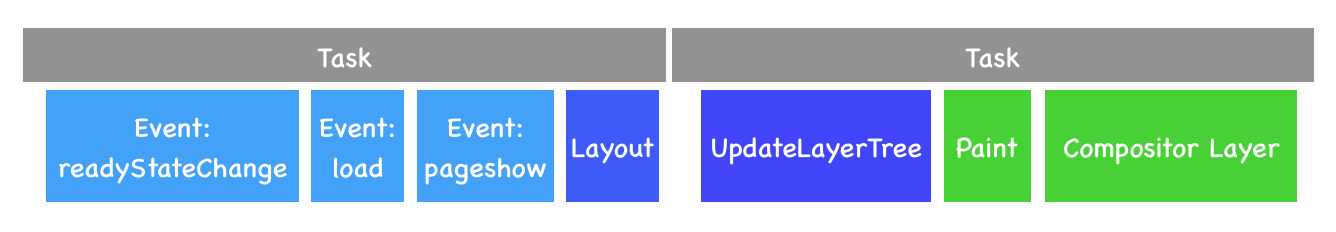

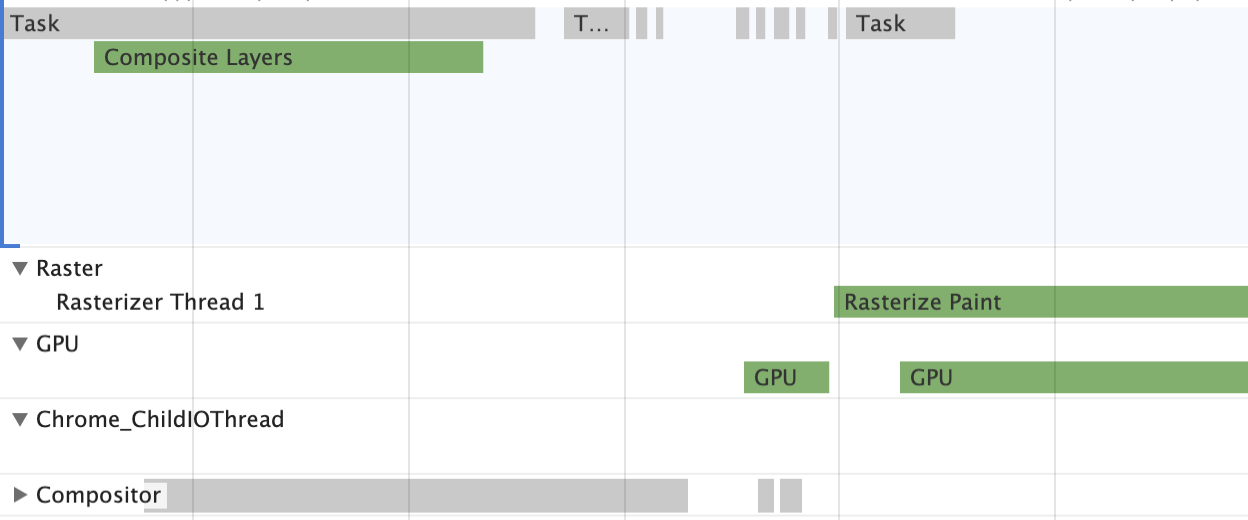

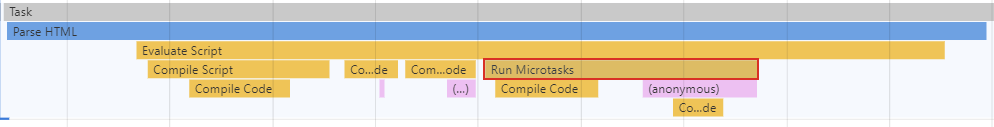

从图中可以看出,我们点击展开了 Main 这个项目,其记录了主线程执行过程中的所有任务。图中灰色的就是一个个任务,每个任务下面还有子任务,其中的 Parse HTML 任务,是把 HTML 解析为 DOM 的任务。值得注意的是,在执行 Parse HTML 的时候,如果遇到 JavaScript 脚本,那么会暂停当前的 HTML 解析而去执行 JavaScript 脚本

总结

- 如果有一些确定好的任务,可以使用一个单线程来按照顺序处理这些任务,这是第一版线程模型

- 要在线程执行过程中接收并处理新的任务,就需要引入循环语句和事件系统,这是第二版线程模型

- 如果要接收其他线程发送过来的任务,就需要引入消息队列,这是第三版线程模型

- 如果其他进程想要发送任务给页面主线程,那么先通过 IPC 把任务发送给渲染进程的 IO 线程,IO 线程再把任务发送给页面主线程

- 消息队列机制并不是太灵活,为了适应效率和实时性,引入了微任务

基于消息队列的设计是目前使用最广的消息架构,无论是安卓还是 Chrome 都采用了类似的任务机制

1、用 CSS3 实现动画是不是不会影响主线程,和用 JS 实现动画会影响主线程,这个说法对么?

部分 css3 的动画效果是在合成线程上实现的,不需要主线程介入,所以省去了重拍和重绘的过程,这就大大提升了渲染效率。

JavaScript 都是在在主线程上执行的,所以 JavaScript 的动画需要主线程的参与,所以效率会大打折扣!

2、老师,为什么说页面是单线程架构?

默认情况下每个标签页都会配套一个渲染进程,而一个渲染进程里不是有主线程、合成线程、IO 线程等多个线程吗

是因为【排版引擎 blink】 和【JavaScript 引擎 v8】都工作在渲染进程的主线程上并且是互斥的,基于这点说页面是单线程架构?

他们都是在渲染进程的主线程上工作,所以同时只能执行一个

比如 v8 除了在主线程上执行 JavaScript 代码之外,还会在主线程上执行垃圾回收,所以执行垃圾回收时停止主线程上的所有任务,我们把垃圾回收这个特性叫着全停顿

3、宏任务与微任务的关系

每个宏任务都有一个微任务列表,在宏任务的执行过程中产生微任务会被添加到改列表中,等宏任务快执行结束之后,会执行微认为列表,所以微任务依然运行在当前宏任务的执行环境中,这个特性会导致宏任务和微任务有一些本质上的区别!

4、由于是多个线程操作同一个消息队列,所以在添加任务和取出任务时还会加上一个同步锁。请问老师,JS 执行不是单线程的吗?为什么这里会说是由多个线程操作同一个队列?

这里提到的任务是指浏览器所需要处理的任务!

浏览器是基于多进程+多线程架构的,所以多进程通讯(IPC)和多线程同步的问题!

因为 JavaScript 引擎是运行在渲染进程的主线程上的,所以我们说 JavaScript 是单线程执行的!

5、老师,请问浏览器的事件循环和 js event loop 是一回事吗?

JavaScript 没有自己循环系统,它依赖的就是浏览器的循环系统,也就是渲染进程提供的循环系统!

所以可以说是一回事

6、事件循环的本质是 for 循环,循环不会一直迭代导致主线程卡主吗?

不会,实际过程中采用系统级中断机制,也就是有事件时,线程才会被激活,没事件时,线程就会被挂起

7、事件循环其实是监听执行任务的循环机制吗?而每一个执行任务都存档在消息队列里面,这些统称为宏任务,微任务是执行宏任务中遇到的异步操作吧,就是异步代码,如 promise,settimeout 任务。执行宏任务遇到异步任务先将其放入微任务列表,等该宏任务执行一遍后再执行该宏任务的微任务列表,我这样理解对吗?

第一个理解没错,事件循环系统就是在监听并执行消息队列中的任务!

第二个理解也没问题,不过 promise 触发的微任务,settimeout 触发的是宏任务!

WebAPI

浏览器页面是由消息队列和事件循环系统来驱动的

setTimeout 和 XMLHttpRequest 这两个 WebAPI 是两种不同类型的应用,比较典型,并且在 JavaScript 中的使用频率非常高

setTimeout 就是一个定时器,用来指定某个函数在多少毫秒之后执行。它会返回一个整数,表示定时器的编号,同时你还可以通过该编号来取消这个定时器

function showName() {

console.log("极客时间");

}

var timerID = setTimeout(showName, 200);浏览器怎么实现 setTimeout

我们知道渲染进程中所有运行在主线程上的任务都需要先添加到消息队列,然后事件循环系统再按照顺序执行消息队列中的任务,例如以下典型的事件:

- 当接收到 HTML 文档数据,渲染引擎就会将“解析 DOM”事件添加到消息队列中

- 当用户改变了 Web 页面的窗口大小,渲染引擎就会将“重新布局”的事件添加到消息队列中

- 当触发了 JavaScript 引擎垃圾回收机制,渲染引擎会将“垃圾回收”任务添加到消息队列中

- 同样,如果要执行一段异步 JavaScript 代码,也是需要将执行任务添加到消息队列中

所以说要执行一段异步任务,需要先将任务添加到消息队列中。不过通过定时器设置回调函数有点特别,它们需要在指定的时间间隔内被调用,但消息队列中的任务是按照顺序执行的,所以为了保证回调函数能在指定时间内执行,你不能将定时器的回调函数直接添加到消息队列中

在 Chrome 中除了正常使用的消息队列之外,还有另外一个消息队列,这个队列中维护了需要延迟执行的任务列表,包括了定时器和 Chromium 内部一些需要延迟执行的任务。所以当通过 JavaScript 创建一个定时器时,渲染进程会将该定时器的回调任务添加到延迟队列中

源码中延迟执行队列的定义如下所示:

DelayedIncomingQueue delayed_incoming_queue;当通过 JavaScript 调用 setTimeout 设置回调函数的时候,渲染进程将会创建一个回调任务,包含了回调函数 showName、当前发起时间、延迟执行时间:

struct DelayTask{

int64 id;

CallBackFunction cbf;

int start_time;

int delay_time;

};

DelayTask timerTask;

timerTask.cbf = showName;

timerTask.start_time = getCurrentTime(); //获取当前时间

timerTask.delay_time = 200;//设置延迟执行时间创建好回调任务之后,再将该任务添加到延迟执行队列中,代码如下所示:

delayed_incoming_queue.push(timerTask);现在通过定时器发起的任务就被保存到延迟队列中了,那接下来我们再来看看消息循环系统是怎么触发延迟队列的,我们可以来完善上一章中消息循环的代码,在其中加入执行延迟队列的代码,如下所示:

void ProcessTimerTask(){

//从delayed_incoming_queue中取出已经到期的定时器任务

//依次执行这些任务

}

TaskQueue task_queue;

void ProcessTask();

bool keep_running = true;

void MainTherad(){

for(;;){

//执行消息队列中的任务

Task task = task_queue.takeTask();

ProcessTask(task);

//执行延迟队列中的任务

ProcessDelayTask()

if(!keep_running) //如果设置了退出标志,那么直接退出线程循环

break;

}

}从上面代码可以看出来,我们添加了一个 ProcessDelayTask 函数,该函数是专门用来处理延迟执行任务的。这里我们要重点关注它的执行时机,在上段代码中,处理完消息队列中的一个任务之后,就开始执行 ProcessDelayTask 函数。ProcessDelayTask 函数会根据发起时间和延迟时间计算出到期的任务,然后依次执行这些到期的任务。等到期的任务执行完成之后,再继续下一个循环过程。通过这样的方式,一个完整的定时器就实现了

设置一个定时器,JavaScript 引擎会返回一个定时器的 ID。那通常情况下,当一个定时器的任务还没有被执行的时候,也是可以取消的,具体方法是调用 clearTimeout 函数,并传入需要取消的定时器的 ID

clearTimeout(timer_id);其实浏览器内部实现取消定时器的操作也是非常简单的,就是直接从 delayed_incoming_queue 延迟队列中,通过 ID 查找到对应的任务,然后再将其从队列中删除掉就可以了

使用 setTimeout 的一些注意事项

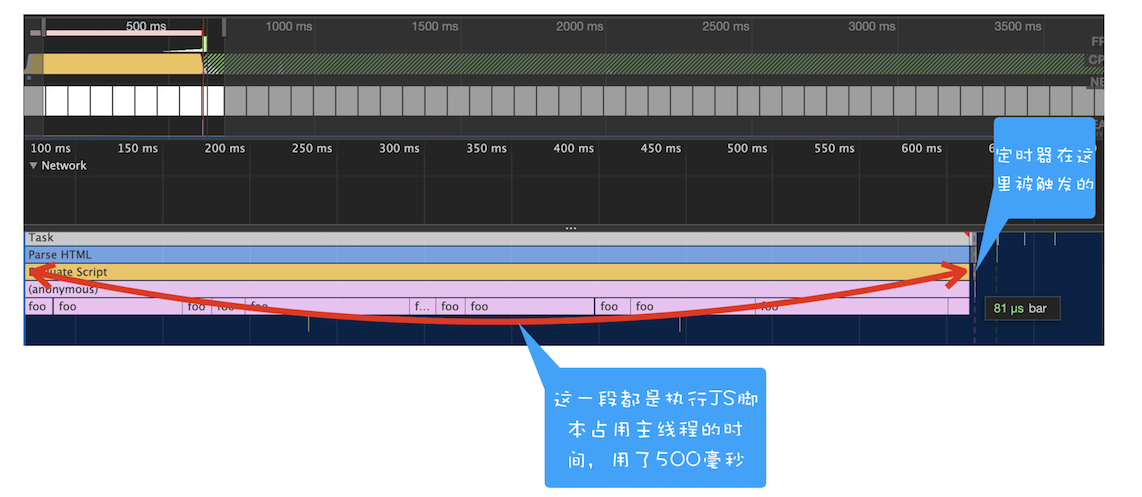

1、如果当前任务执行时间过久,会影响定时器任务的执行

在使用 setTimeout 的时候,有很多因素会导致回调函数执行比设定的预期值要久,其中一个就是当前任务执行时间过久从而导致定时器设置的任务被延后执行

function bar() {

console.log("bar");

}

function foo() {

setTimeout(bar, 0);

for (let i = 0; i < 5000; i++) {

let i = 5 + 8 + 8 + 8;

console.log(i);

}

}

foo();通过 setTimeout 设置的回调任务被放入了消息队列中并且等待下一次执行,这里并不是立即执行的;要执行消息队列中的下个任务,需要等待当前的任务执行完成,由于当前这段代码要执行 5000 次的 for 循环,所以当前这个任务的执行时间会比较久一点。这势必会影响到下个任务的执行时间

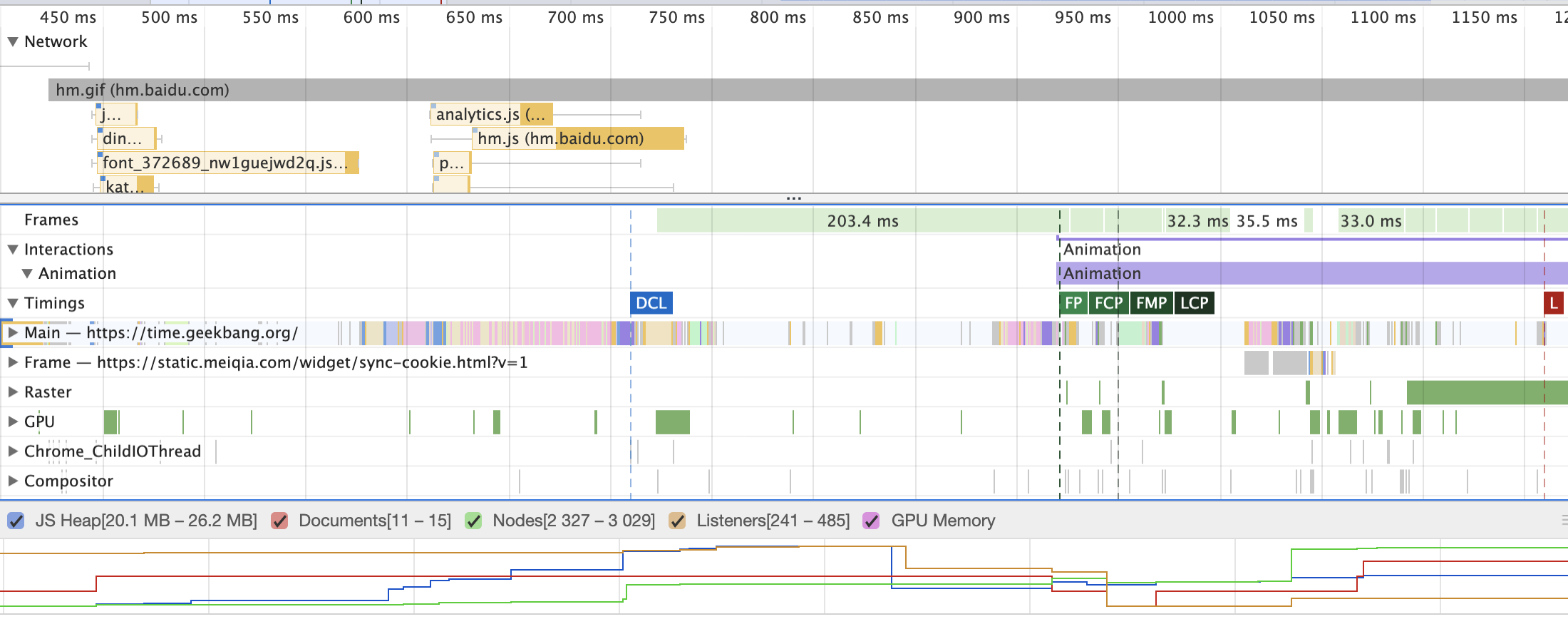

Performance 中的体现

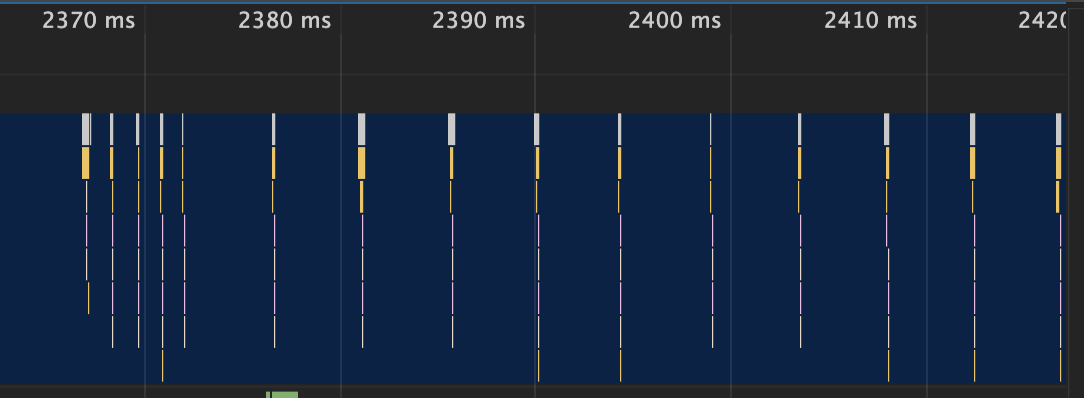

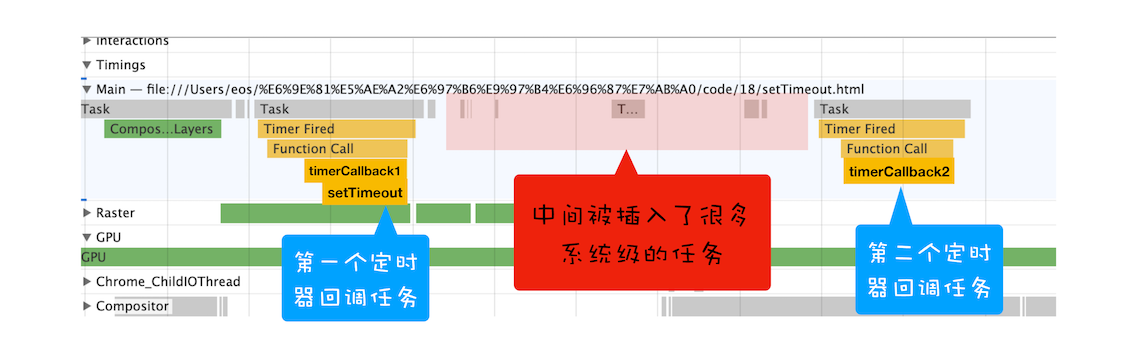

2、如果 setTimeout 存在嵌套调用,那么系统会设置最短时间间隔为 4 毫秒

在定时器函数里面嵌套调用定时器,也会延长定时器的执行时间

function cb() {

setTimeout(cb, 0);

}

setTimeout(cb, 0);通过 Performance 来记录下这段代码的执行过程:

上图中的竖线就是定时器的函数回调过程,从图中可以看出,前面五次调用的时间间隔比较小,嵌套调用超过五次以上,后面每次的调用最小时间间隔是 4 毫秒。

之所以出现这样的情况,是因为在 Chrome 中,定时器被嵌套调用 5 次以上,系统会判断该函数方法被阻塞了,如果定时器的调用时间间隔小于 4 毫秒,那么浏览器会将每次调用的时间间隔设置为 4 毫秒。

下面是 Chromium 实现 4 毫秒延迟的代码(https://source.chromium.org/chromium/chromium/src/+/main:third_party/blink/renderer/core/frame/dom_timer.cc):

// Chromium uses a minimum timer interval of 4ms. We'd like to go

// lower; however, there are poorly coded websites out there which do

// create CPU-spinning loops. Using 4ms prevents the CPU from

// spinning too busily and provides a balance between CPU spinning and

// the smallest possible interval timer.

// 以上是早期版本中的描述

// that a timeout less than 4ms is increased to 4ms when the nesting level is

// greater than 5.

constexpr int kMaxTimerNestingLevel = 5;

constexpr base::TimeDelta kMinimumInterval = base::Milliseconds(4);

// ....

DOMTimer::DOMTimer(ExecutionContext* context,

ScheduledAction* action,

base::TimeDelta timeout,

bool single_shot,

int timeout_id)

: ExecutionContextLifecycleObserver(context),

TimerBase(nullptr),

timeout_id_(timeout_id),

nesting_level_(context->Timers()->TimerNestingLevel()),

action_(action) {

DCHECK_GT(timeout_id, 0); // 这个函数等于'>',GT = greater than

// ......

if (nesting_level_ >= kMaxTimerNestingLevel && timeout < kMinimumInterval)

timeout = kMinimumInterval;

// ......

if (!single_shot || !blink::features::IsSetTimeoutWithoutClampEnabled())

// 不是单发计时器 || 需要将定时器限制到1ms

timeout = std::max(timeout, base::Milliseconds(1));

if (single_shot)

StartOneShot(interval_milliseconds, FROM_HERE);

else

StartRepeating(interval_milliseconds, FROM_HERE);

}

// ......

const char* name = single_shot ? "setTimeout" : "setInterval";所以,一些实时性较高的需求就不太适合使用 setTimeout 了,比如你用 setTimeout 来实现 JavaScript 动画就不是一个很好的主意

3、未激活的页面,setTimeout 执行最小间隔是 1000 毫秒

未被激活的页面中定时器最小值大于 1000 毫秒,也就是说,如果标签不是当前的激活标签,那么定时器最小的时间间隔是 1000 毫秒,目的是为了优化后台页面的加载损耗以及降低耗电量。这一点你在使用定时器的时候要注意

4、延时执行时间有最大值

Chrome、Safari、Firefox 都是以 32 个 bit 来存储延时值的,32bit 最大只能存放的数字是 2147483647 毫秒,这就意味着,如果 setTimeout 设置的延迟值大于 2147483647 毫秒(大约 24.8 天)时就会溢出,那么相当于延时值被设置为 0 了,这导致定时器会与setTimeout(fn, 0)保持一致

function showName() {

console.log("极客时间");

}

var timerID = setTimeout(showName, 2147483648); //会被立即调用执行5、使用 setTimeout 设置的回调函数中的 this 不符合直觉

如果被 setTimeout 推迟执行的回调函数是某个对象的方法,那么该方法中的 this 关键字将指向全局环境,而不是定义时所在的那个对象

var name = 1;

var MyObj = {

name: 2,

showName: function () {

console.log(this.name);

},

};

setTimeout(MyObj.showName, 1000);

// 1解决方法

1、将 MyObj.showName 放在匿名函数中执行

//箭头函数

setTimeout(() => {

MyObj.showName();

}, 1000);

//或者function函数

setTimeout(function () {

MyObj.showName();

}, 1000);2、使用 bind 方法,将 showName 绑定在 MyObj 上面

setTimeout(MyObj.showName.bind(MyObj), 1000);总结(setTimeout)

- 首先,为了支持定时器的实现,浏览器增加了延时队列

- 其次,由于消息队列排队和一些系统级别的限制,通过 setTimeout 设置的回调任务并非总是可以实时地被执行,这样就不能满足一些实时性要求较高的需求了

- 最后,在定时器中使用过程中,还存在一些陷阱,需要你多加注意。

思考

由于使用 setTimeout 设置的回调任务实时性并不是太好,所以很多场景并不适合使用 setTimeout。比如你要使用 JavaScript 来实现动画效果,函数 requestAnimationFrame 就是个很好的选择

需要网上搜索了解下 requestAnimationFrame 的工作机制,并对比 setTimeout,然后分析出 requestAnimationFrame 实现的动画效果比 setTimeout 好的原因

requestAnimationFrame 是在下一帧动画重绘之前执行传入的函数。能够保证传入的回调函数执行次数通常与浏览器屏幕刷新次数相匹配,一般是每秒钟 60 次。但是 setTimeout 函数执行的间隔时间不一定是约定好的间隔时间,还与当前事件循环中的任务执行的时间有关,如果执行的时间太长的话,setTimeout 里面的函数将会被延迟执行。另外,当页面最小化的时候,setTimeout 依然会执行,浪费性能,而 requestAnimationFrame 则没有这个问题

1、我没有太理解这个异步延迟队列,既然是队列,但好像完全不符合先进先出的特点。在每次执行完任务队列中的一个任务之后都会去执行那些已经到期的延迟任务,这些延迟的任务具体是如何取出的呢?

其实是一个 hashmap 结构,等到执行这个结构的时候,会计算 hashmap 中的每个任务是否到期了,到期了就去执行,直到所有到期的任务都执行结束,才会进入下一轮循环!

2、setTimeout 是宏任务,宏任务应该放在消息队列中,文中说是放在延迟队列中,为什么?延迟队列和消息队列的区别是什么?

延迟队列也是宏任务,实际上 blink 维护了很多不同优先级的队列,这些队列里面都是宏任务

3、延迟队列的任务是在当前宏任务执行完之后执行,微任务队列是在当前宏任务将要结束时执行对吗?

微任务是在宏任务执行过程中的某个时间点执行的,通常是在宏任务快要结束的时候执行

4、requestAnimationFrame 也是在主线程上执行吗?如果当前任务执行时间过久,也会导致 requestAnimationFrame 被延后执行吗?

raf 的回调函数也是在主线程上执行的,如果其中的一个回调函数执行过久,会影响到其他的任务的

5、执行延迟队列的任务,是一次循环只取出一个,还是检查只要时间到了,就执行?

比如有五个定时的任务到期了,那么会分别把这个五个定时器的任务执行掉,再开始下次循环过程!

五个定时任务到期了(就是告诉浏览器可以执行 宏任务 队列里的回调了),浏览器会依次把这 5 个回调任务清空,只不过每次拿出一个回调任务放入执行栈执行,单个回调任务执行的过程中,如果遇到宏任务,添加到下次的宏任务队列,遇到微任务,添加到本轮执行栈底部的微任务队里,等到执行栈清空当前的回调任务,再清空微任务队列(补充:微任务队列是每次执行栈清空都要执行完毕,所以会阻塞事件环)。 然后拿出第二个回调任务继续执行以上操作,如此往复,直到清空这 5 个回调任务,本轮结束,进入下一轮循环。

Node 10 及以前的版本和浏览器不一致,表现是一次性把已经到期宏任务队列全部压入执行栈,执行完在执行微任务队列。 而 Node 11 及以上版本和浏览器一致了

6、微任务是在宏任务里的,是执行完一个宏任务,就去执行宏任务里面的微任务?

chromium 中,当执行一个宏任务时,才会创建微任务队列,等遇到 checkpoint 时就会执行微任务!

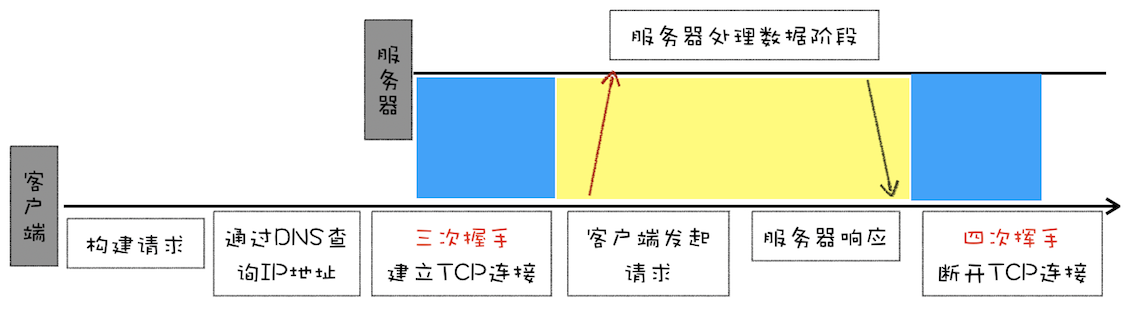

浏览器怎么实现 XMLHttpRequest

自从网页中引入了 JavaScript,我们就可以操作 DOM 树中任意一个节点,例如隐藏 / 显示节点、改变颜色、获得或改变文本内容、为元素添加事件响应函数等等, 几乎可以“为所欲为”了

不过在 XMLHttpRequest 出现之前,如果服务器数据有更新,依然需要重新刷新整个页面。而 XMLHttpRequest 提供了从 Web 服务器获取数据的能力,如果你想要更新某条数据,只需要通过 XMLHttpRequest 请求服务器提供的接口,就可以获取到服务器的数据,然后再操作 DOM 来更新页面内容,整个过程只需要更新网页的一部分就可以了,而不用像之前那样还得刷新整个页面,这样既有效率又不会打扰到用户

在深入讲解 XMLHttpRequest 之前,我们得先介绍下同步回调和异步回调这两个概念

回调函数 VS 系统调用栈

将一个函数作为参数传递给另外一个函数,那作为参数的这个函数就是回调函数

let callback = function () {

console.log("i am do homework");

};

function doWork(cb) {

console.log("start do work");

cb();

console.log("end do work");

}

doWork(callback);上面的回调方法有个特点,就是回调函数 callback 是在主函数 doWork 返回之前执行的,我们把这个回调过程称为同步回调

let callback = function () {

console.log("i am do homework");

};

function doWork(cb) {

console.log("start do work");

setTimeout(cb, 1000);

console.log("end do work");

}

doWork(callback);在这个例子中,我们使用了 setTimeout 函数让 callback 在 doWork 函数执行结束后,又延时了 1 秒再执行,这次 callback 并没有在主函数 doWork 内部被调用,我们把这种回调函数在主函数外部执行的过程称为异步回调

所以可以说是消息队列和主线程循环机制保证了页面有条不紊地运行

当循环系统在执行一个任务的时候,都要为这个任务维护一个系统调用栈。这个系统调用栈类似于 JavaScript 的调用栈,只不过系统调用栈是 Chromium 的开发语言 C++ 来维护的

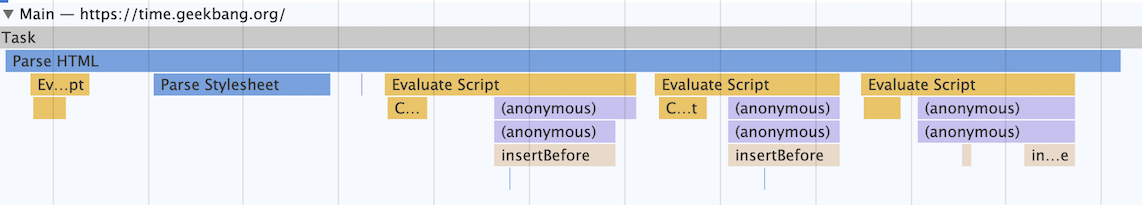

其调用信息可以通过 chrome://tracing/ 来抓取,也可以通过 Performance 来抓取:

这幅图记录了一个 Parse HTML 的任务执行过程,其中黄色的条目表示执行 JavaScript 的过程,其他颜色的条目表示浏览器内部系统的执行过程

通过该图你可以看出来,Parse HTML 任务在执行过程中会遇到一系列的子过程,比如在解析页面的过程中遇到了 JavaScript 脚本,那么就暂停解析过程去执行该脚本,等执行完成之后,再恢复解析过程。然后又遇到了样式表,这时候又开始解析样式表……直到整个任务执行完成

需要说明的是,整个 Parse HTML 是一个完整的任务,在执行过程中的脚本解析、样式表解析都是该任务的子过程,其下拉的长条就是执行过程中调用栈的信息

每个任务在执行过程中都有自己的调用栈,那么同步回调就是在当前主函数的上下文中执行回调函数,而异步回调是指回调函数在主函数之外执行,一般有两种方式:

- 第一种是把异步函数做成一个任务,添加到消息队列尾部

- 第二种是把异步函数添加到微任务队列中,这样就可以在当前任务的末尾处执行微任务了

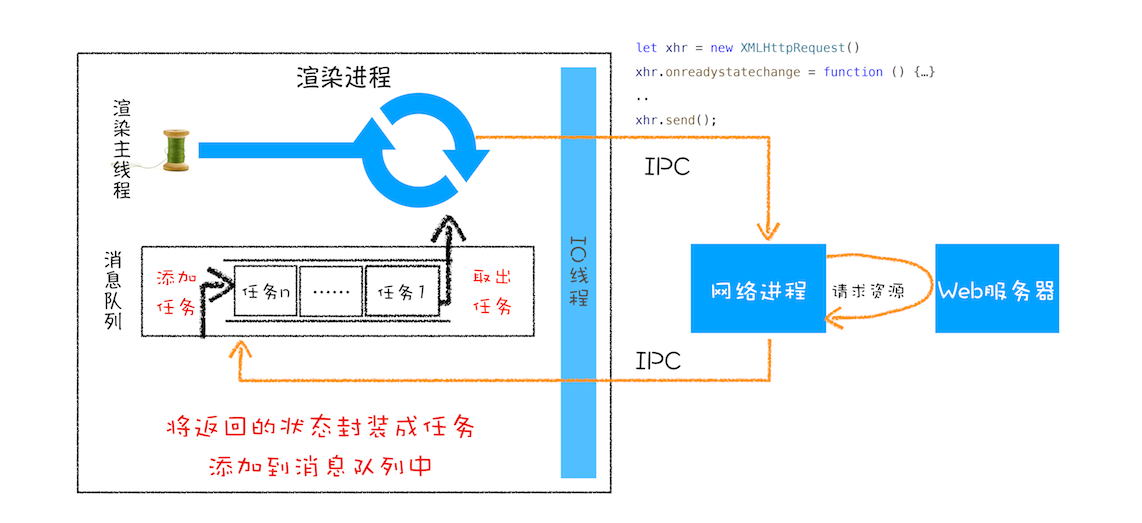

XMLHttpRequest 运作机制

这是 XMLHttpRequest 的总执行流程图:

function GetWebData(URL) {

/**

* 1:新建XMLHttpRequest请求对象

*/

let xhr = new XMLHttpRequest();

/**

* 2:注册相关事件回调处理函数

*/

xhr.onreadystatechange = function () {

switch (xhr.readyState) {

case 0: //请求未初始化

console.log("请求未初始化");

break;

case 1: //OPENED

console.log("OPENED");

break;

case 2: //HEADERS_RECEIVED

console.log("HEADERS_RECEIVED");

break;

case 3: //LOADING

console.log("LOADING");

break;

case 4: //DONE

if (this.status == 200 || this.status == 304) {

console.log(this.responseText);

}

console.log("DONE");

break;

}

};

xhr.ontimeout = function (e) {

console.log("ontimeout");

};

xhr.onerror = function (e) {

console.log("onerror");

};

/**

* 3:打开请求

*/

xhr.open("Get", URL, true); //创建一个Get请求,采用异步

/**

* 4:配置参数

*/

xhr.timeout = 3000; //设置xhr请求的超时时间

xhr.responseType = "text"; //设置响应返回的数据格式

xhr.setRequestHeader("X_TEST", "time.geekbang");

/**

* 5:发送请求

*/

xhr.send();

}第一步:创建 XMLHttpRequest 对象

当执行到let xhr = new XMLHttpRequest()后,JavaScript 会创建一个 XMLHttpRequest 对象 xhr,用来执行实际的网络请求操作

第二步:为 xhr 对象注册回调函数

因为网络请求比较耗时,所以要注册回调函数,这样后台任务执行完成之后就会通过调用回调函数来告诉其执行结果

XMLHttpRequest 的回调函数主要有下面几种:

- ontimeout,用来监控超时请求,如果后台请求超时了,该函数会被调用

- onerror,用来监控出错信息,如果后台请求出错了,该函数会被调用

- onreadystatechange,用来监控后台请求过程中的状态,比如可以监控到 HTTP 头加载完成的消息、HTTP 响应体消息以及数据加载完成的消息等

第三步:配置基础的请求信息

注册好回调事件之后,接下来就需要配置基础的请求信息了,首先要通过 open 接口配置一些基础的请求信息,包括请求的地址、请求方法(是 get 还是 post)和请求方式(同步还是异步请求)

然后通过 xhr 内部属性类配置一些其他可选的请求信息,我们通过 xhr.timeout = 3000 来配置超时时间,也就是说如果请求超过 3000 毫秒还没有响应,那么这次请求就被判断为失败了

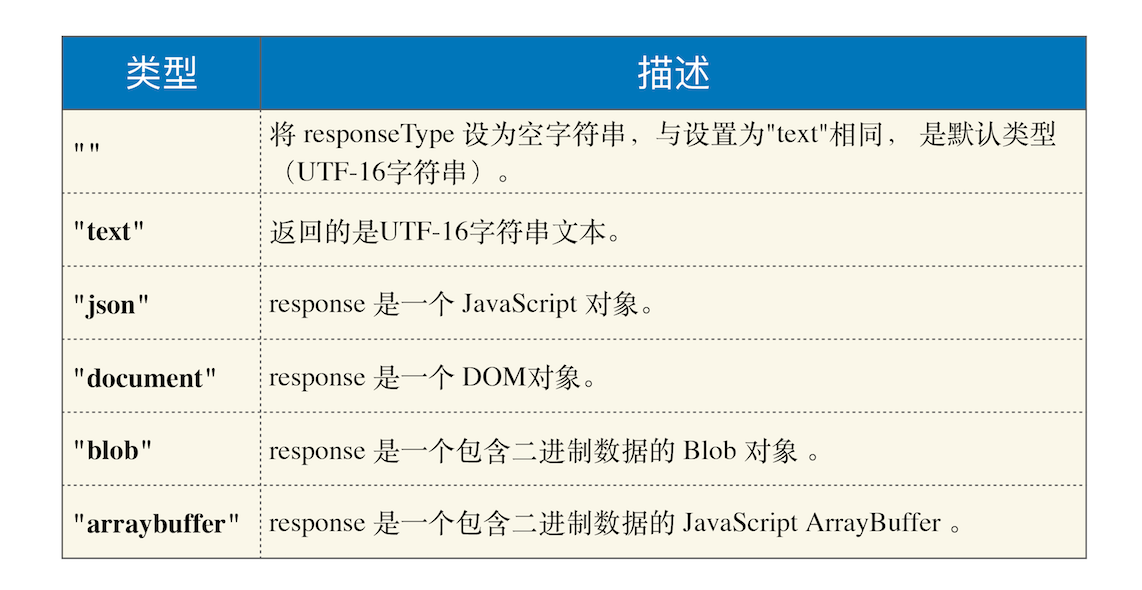

我们还可以通过 xhr.responseType = "text"来配置服务器返回的格式,将服务器返回的数据自动转换为自己想要的格式,如果将 responseType 的值设置为 json,那么系统会自动将服务器返回的数据转换为 JavaScript 对象格式

假如你还需要添加自己专用的请求头属性,可以通过 xhr.setRequestHeader 来添加

第四步:发起请求

一切准备就绪之后,就可以调用 xhr.send 来发起网络请求了。你可以对照上面那张请求流程图,可以看到:渲染进程会将请求发送给网络进程,然后网络进程负责资源的下载,等网络进程接收到数据之后,就会利用 IPC 来通知渲染进程;渲染进程接收到消息之后,会将 xhr 的回调函数封装成任务并添加到消息队列中,等主线程循环系统执行到该任务的时候,就会根据相关的状态来调用对应的回调函数

- 如果网络请求出错了,就会执行 xhr.onerror

- 如果超时了,就会执行 xhr.ontimeout

- 如果是正常的数据接收,就会执行 onreadystatechange 来反馈相应的状态

有一些使用方面的细节我之前也做过笔记:https://blog.csdn.net/m0_49242719/article/details/119873476?spm=1001.2014.3001.5501

XMLHttpRequest 使用过程中的“坑”

上述过程看似简单,但由于浏览器很多安全策略的限制,所以会导致你在使用过程中踩到非常多的“坑”

浏览器安全问题是前端工程师避不开的一道坎,通常在使用过程中遇到的“坑”,很大一部分都是由安全策略引起的,不管你喜不喜欢,它都在这里。本来很完美的一个方案,正是由于加了安全限制,导致使用起来非常麻烦

下面我们就来看看在使用 XMLHttpRequest 的过程中所遇到的跨域问题和混合内容问题

1、跨域问题

比如在极客邦的官网使用 XMLHttpRequest 请求极客时间的页面内容,由于极客邦的官网是 https://www.geekbang.org,极客时间的官网是 https://time.geekbang.org,它们不是同一个源,所以就涉及到了跨域(在 A 站点中去访问不同源的 B 站点的内容)。默认情况下,跨域请求是不被允许的

var xhr = new XMLHttpRequest();

var url = "https://time.geekbang.org/";

function handler() {

switch (

xhr.readyState

// ......

) {

}

}

function callOtherDomain() {

if (xhr) {

xhr.open("GET", url, true);

xhr.onreadystatechange = handler;

xhr.send();

}

}

callOtherDomain();执行,会看到请求被 Block 了

Access to XMLHttpRequest at 'https://time.geekbang.org/' from origin 'https://www.geekbang.org' has been blocked by CORS policy: No 'Access-Control-Allow-Origin' header is present on the requested resource.因为 https://www.geekbang.org 和 https://time.geekbang.com 不属于一个域,所以以上访问就属于跨域访问了,这次访问失败就是由于跨域问题导致的

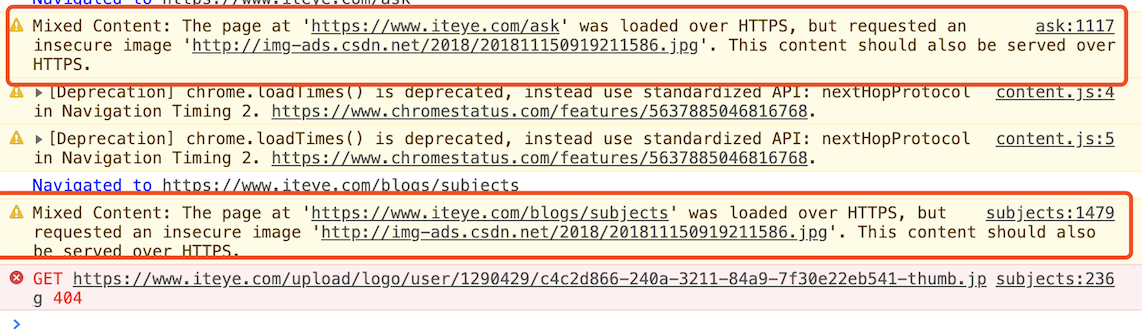

2、HTTPS 混合内容的问题

HTTPS 混合内容是 HTTPS 页面中包含了不符合 HTTPS 安全要求的内容,比如包含了 HTTP 资源,通过 HTTP 加载的图像、视频、样式表、脚本等,都属于混合内容

通常,如果 HTTPS 请求页面中使用混合内容,浏览器会针对 HTTPS 混合内容显示警告,用来向用户表明此 HTTPS 页面包含不安全的资源

可以通过控制台看到混合内容的警告

从上图可以看出,通过 HTML 文件加载的混合资源,虽然给出警告,但大部分类型还是能加载的。而使用 XMLHttpRequest 请求时,浏览器认为这种请求可能是攻击者发起的,会阻止此类危险的请求

例如在 HTTPS 页面使用 XMLHttpRequest 请求 HTTP 图片,浏览器会直接报错

总结

setTimeout 是直接将延迟任务添加到延迟队列中,而 XMLHttpRequest 发起请求,是由浏览器的其他进程或者线程去执行,然后再将执行结果利用 IPC 的方式通知渲染进程,之后渲染进程再将对应的消息添加到消息队列中。如果你搞懂了 setTimeout 和 XMLHttpRequest 的工作机制后,再来理解其他 WebAPI 就会轻松很多了,因为大部分 WebAPI 的工作逻辑都是类似的

1、请教老师,我看到 es6 中可以通过一个 fetch api 来请求,它的实现是用了 xmlHttpRequest 么?如果不是,原理上有什么不同?

fetch 采用了 promise 来封装,在使用方式上更强现代化,同时还原生支持 async/await。在 chromium 中,fetch 是完全重新实现的,和 xmlhttprequest 没有什么关系!

在项目中推荐使用 fetch

2、异步函数的调用不应该有三种方式吗,可以放到队列尾,微任务中,也可以放入延迟队列中,为什么不放入延迟队列中呢?

延时队列中的任务包含 JS 通过定时器设置的回调函数、还有一些浏览器内部的延时回调函数。 它们属于宏任务!

另外正常的消息队列中的任务也属于宏任务!

所以通常我说放入消息队列就是指放入了宏任务队列(包括了延时队列或者正常的消息队列)

3、IPC 是什么?

进程间通信,比如浏览器进程需要网络进程下载数据,浏览器进程就是通过 IPC 告诉网络进程需要下载哪些数据,网络进程接收到之后才会开启下载流程

4、异步回调的第二种方式 把异步函数添加到微任务队列中 具体是哪些 WebAPI 呢? Promise.then?

Promise 的 resolve 和 reject 会创建微任务

还有 MutationObserver,如果监听了某个节点,那么通过 DOMAPI 修改这些被监听的节点也会产生微任务

宏任务和微任务

随着浏览器的应用领域越来越广泛,消息队列中这种粗时间颗粒度的任务已经不能胜任部分领域的需求,所以又出现了一种新的技术——微任务。微任务可以在实时性和效率之间做一个有效的权衡

基于微任务的技术有 MutationObserver、Promise 以及以 Promise 为基础开发出来的很多其他的技术

宏任务

页面中的大部分任务都是在主线程上执行的,这些任务包括了:

- 渲染事件(如解析 DOM、计算布局、绘制)

- 用户交互事件(如鼠标点击、滚动页面、放大缩小等)

- JavaScript 脚本执行事件;网络请求完成、文件读写完成事件

为了协调这些任务有条不紊地在主线程上执行,页面进程引入了消息队列和事件循环机制,渲染进程内部会维护多个消息队列,比如延迟执行队列和普通的消息队列。然后主线程采用一个 for 循环,不断地从这些任务队列中取出任务并执行任务。我们把这些消息队列中的任务称为宏任务

消息队列中的任务是通过事件循环系统来执行的,这里我们可以看看在WHATWG 规范中是怎么定义事件循环机制的

大致总结了下 WHATWG 规范定义的大致流程:

- 先从多个消息队列中选出一个最老的任务,这个任务称为 oldestTask

- 然后循环系统记录任务开始执行的时间,并把这个 oldestTask 设置为当前正在执行的任务

- 当任务执行完成之后,删除当前正在执行的任务,并从对应的消息队列中删除掉这个 oldestTask

- 最后统计执行完成的时长等信息。

宏任务可以满足我们大部分的日常需求,不过如果有对时间精度要求较高的需求,宏任务就难以胜任了

页面的渲染事件、各种 IO 的完成事件、执行 JavaScript 脚本的事件、用户交互的事件等都随时有可能被添加到消息队列中,而且添加事件是由系统操作的,JavaScript 代码不能准确掌控任务要添加到队列中的位置,控制不了任务在消息队列中的位置,所以很难控制开始执行任务的时间

<!DOCTYPE html>

<html>

<body>

<div id='demo'>

<ol>

<li>test</li>

</ol>

</div>

</body>

<script type="text/javascript">

function timerCallback2(){

console.log(2)

}

function timerCallback(){

console.log(1)

setTimeout(timerCallback2,0)

}

setTimeout(timerCallback,0)

</script>

</html>在这段代码中,我的目的是想通过 setTimeout 来设置两个回调任务,并让它们按照前后顺序来执行,中间也不要再插入其他的任务,因为如果这两个任务的中间插入了其他的任务,就很有可能会影响到第二个定时器的执行时间了

但实际情况是我们不能控制的,比如在你调用 setTimeout 来设置回调任务的间隙,消息队列中就有可能被插入很多系统级的任务

打开 Performance 工具,来记录下这段任务的执行过程:

如果中间被插入的任务执行时间过久的话,那么就会影响到后面任务的执行了

所以说宏任务的时间粒度比较大,执行的时间间隔是不能精确控制的,对一些高实时性的需求就不太符合了,比如后面要介绍的监听 DOM 变化的需求

微任务

异步回调有两种方式:

第一种是把异步回调函数封装成一个宏任务,添加到消息队列尾部,当循环系统执行到该任务的时候执行回调函数,setTimeout 和 XMLHttpRequest 的回调函数都是通过这种方式来实现的

第二种方式的执行时机是在主函数执行结束之后、当前宏任务结束之前执行回调函数,这通常都是以微任务形式体现的

所以,

微任务就是一个需要异步执行的函数,执行时机是在主函数执行结束之后、当前宏任务结束之前

我们知道当 JavaScript 执行一段脚本的时候,V8 会为其创建一个全局执行上下文,在创建全局执行上下文的同时,V8 引擎也会在内部创建一个微任务队列。顾名思义,这个微任务队列就是用来存放微任务的,因为在当前宏任务执行的过程中,有时候会产生多个微任务,这时候就需要使用这个微任务队列来保存这些微任务了。不过这个微任务队列是给 V8 引擎内部使用的,所以你是无法通过 JavaScript 直接访问的

也就是说每个宏任务都关联了一个微任务队列。那么接下来,我们就需要分析两个重要的时间点——微任务产生的时机和执行微任务队列的时机

在现代浏览器里面,产生微任务有两种方式:

- 第一种方式是使用 MutationObserver 监控某个 DOM 节点,然后再通过 JavaScript 来修改这个节点,或者为这个节点添加、删除部分子节点,当 DOM 节点发生变化时,就会产生 DOM 变化记录的微任务

- 第二种方式是使用 Promise,当调用 Promise.resolve() 或者 Promise.reject() 的时候,也会产生微任务

通过 DOM 节点变化产生的微任务或者使用 Promise 产生的微任务都会被 JavaScript 引擎按照顺序保存到微任务队列中

通常情况下,在当前宏任务中的 JavaScript 快执行完成时,也就在 JavaScript 引擎准备退出全局执行上下文并清空调用栈的时候,JavaScript 引擎会检查全局执行上下文中的微任务队列,然后按照顺序执行队列中的微任务。WHATWG 把执行微任务的时间点称为检查点。当然除了在退出全局执行上下文式这个检查点之外,还有其他的检查点

如果在执行微任务的过程中,产生了新的微任务,同样会将该微任务添加到微任务队列中,V8 引擎一直循环执行微任务队列中的任务,直到队列为空才算执行结束。也就是说在执行微任务过程中产生的新的微任务并不会推迟到下个宏任务中执行,而是在当前的宏任务中继续执行

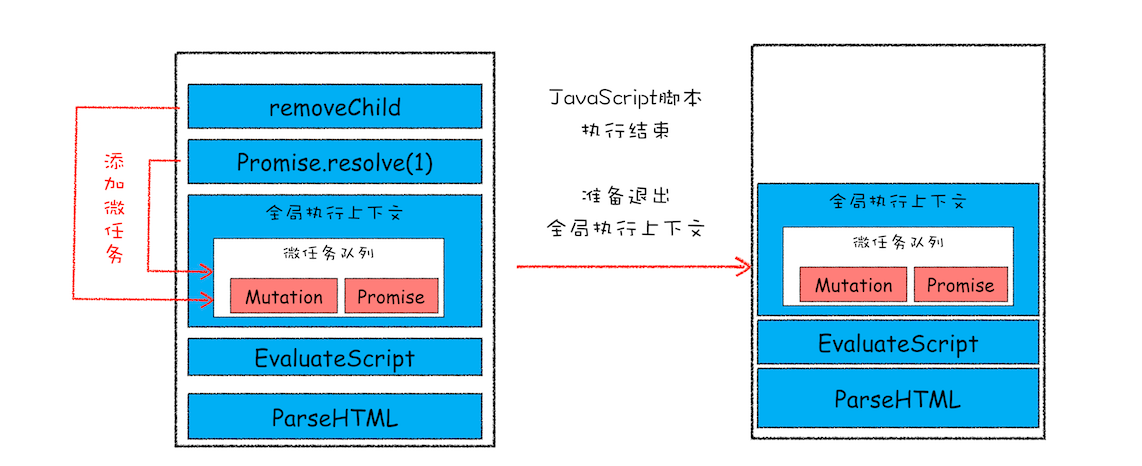

该示意图是在执行一个 ParseHTML 的宏任务,在执行过程中,遇到了 JavaScript 脚本,那么就暂停解析流程,进入到 JavaScript 的执行环境。从图中可以看到,全局上下文中包含了微任务列表

在 JavaScript 脚本的后续执行过程中,分别通过 Promise 和 removeChild 创建了两个微任务,并被添加到微任务列表中。接着 JavaScript 执行结束,准备退出全局执行上下文,这时候就到了检查点了,JavaScript 引擎会检查微任务列表,发现微任务列表中有微任务,那么接下来,依次执行这两个微任务。等微任务队列清空之后,就退出全局执行上下文

以上就是微任务的工作流程,从上面分析我们可以得出如下几个结论:

- 微任务和宏任务是绑定的,每个宏任务在执行时,会创建自己的微任务队列

- 微任务的执行时长会影响到当前宏任务的时长。比如一个宏任务在执行过程中,产生了 100 个微任务,执行每个微任务的时间是 10 毫秒,那么执行这 100 个微任务的时间就是 1000 毫秒,也可以说这 100 个微任务让宏任务的执行时间延长了 1000 毫秒。所以你在写代码的时候一定要注意控制微任务的执行时长

- 在一个宏任务中,分别创建一个用于回调的宏任务和微任务,无论什么情况下,微任务都早于宏任务执行

监听 DOM 变化方法演变

MutationObserver 是用来监听 DOM 变化的一套方法,而监听 DOM 变化一直是前端工程师一项非常核心的需求

比如许多 Web 应用都利用 HTML 与 JavaScript 构建其自定义控件,与一些内置控件不同,这些控件不是固有的。为了与内置控件一起良好地工作,这些控件必须能够适应内容更改、响应事件和用户交互。因此,Web 应用需要监视 DOM 变化并及时地做出响应

虽然监听 DOM 的需求是如此重要,不过早期页面并没有提供对监听的支持,所以那时要观察 DOM 是否变化,唯一能做的就是轮询检测,比如使用 setTimeout 或者 setInterval 来定时检测 DOM 是否有改变。这种方式简单粗暴,但是会遇到两个问题:如果时间间隔设置过长,DOM 变化响应不够及时;反过来如果时间间隔设置过短,又会浪费很多无用的工作量去检查 DOM,会让页面变得低效

直到 2000 年的时候引入了 Mutation Event,Mutation Event 采用了观察者的设计模式,当 DOM 有变动时就会立刻触发相应的事件,这种方式属于同步回调

采用 Mutation Event 解决了实时性的问题,因为 DOM 一旦发生变化,就会立即调用 JavaScript 接口。但也正是这种实时性造成了严重的性能问题,因为每次 DOM 变动,渲染引擎都会去调用 JavaScript,这样会产生较大的性能开销。比如利用 JavaScript 动态创建或动态修改 50 个节点内容,就会触发 50 次回调,而且每个回调函数都需要一定的执行时间,这里我们假设每次回调的执行时间是 4 毫秒,那么 50 次回调的执行时间就是 200 毫秒,若此时浏览器正在执行一个动画效果,由于 Mutation Event 触发回调事件,就会导致动画的卡顿

也正是因为使用 Mutation Event 会导致页面性能问题,所以 Mutation Event 被反对使用,并逐步从 Web 标准事件中删除了

为了解决了 Mutation Event 由于同步调用 JavaScript 而造成的性能问题,从 DOM4 开始,推荐使用 MutationObserver 来代替 Mutation Event。MutationObserver API 可以用来监视 DOM 的变化,包括属性的变化、节点的增减、内容的变化等

MutationObserver 将响应函数改成异步调用,可以不用在每次 DOM 变化都触发异步调用,而是等多次 DOM 变化后,一次触发异步调用,并且还会使用一个数据结构来记录这期间所有的 DOM 变化。这样即使频繁地操纵 DOM,也不会对性能造成太大的影响

我们通过异步调用和减少触发次数来缓解了性能问题,那么如何保持消息通知的及时性呢?如果采用 setTimeout 创建宏任务来触发回调的话,那么实时性就会大打折扣,因为上面我们分析过,在两个任务之间,可能会被渲染进程插入其他的事件,从而影响到响应的实时性。

这时候,微任务就可以上场了,在每次 DOM 节点发生变化的时候,渲染引擎将变化记录封装成微任务,并将微任务添加进当前的微任务队列中。这样当执行到检查点的时候,V8 引擎就会按照顺序执行微任务了

综上所述, MutationObserver 采用了“异步 + 微任务”的策略

- 通过异步操作解决了同步操作的性能问题

- 通过微任务解决了实时性的问题

总结

1、之前讲过,在循环系统的一个循环中,先从消息队列头部取出一个任务执行,该任务执行完后,再去延迟队列中找到所有的过期任务依次执行完。那前面这句话和本篇文章的这句话好像有矛盾:"先从多个消息队列中选出一个最老的任务,这个任务称为 oldestTask"?

第一段话是 WHATWG 标准定义的,在 WHATWG 规范,定义了在主线程的循环系统中,可以有多个消息队列,比如鼠标事件的队列,IO 完成消息队列,渲染任务队列,并且可以给这些消息队列排优先级

但是在浏览器实现的过程中,目前只有一个消息队列,和一个延迟执行队列。 一个是规范,一个是实现

Promise

DOM/BOM API 中新加入的 API 大多数都是建立在 Promise 上的,而且新的前端框架也使用了大量的 Promise。可以这么说,Promise 已经成为现代前端的“水”和“电”,很是关键,所以深入学习 Promise 势在必行

本文我们就来重点聊聊 JavaScript 引入 Promise 的动机,以及解决问题的几个核心关键点

异步编程的问题:代码逻辑不连续

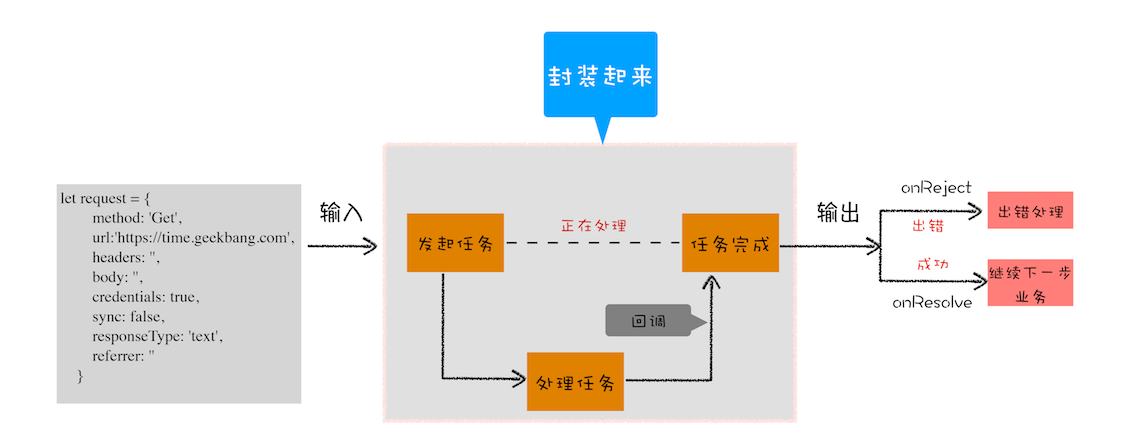

页面中任务都是执行在主线程之上的,相对于页面来说,主线程就是它整个的世界,所以在执行一项耗时的任务时,比如下载网络文件任务、获取摄像头等设备信息任务,这些任务都会放到页面主线程之外的进程或者线程中去执行,这样就避免了耗时任务“霸占”页面主线程的情况。你可以结合下图来看看这个处理过程:

上图展示的是一个标准的异步编程模型,页面主线程发起了一个耗时的任务,并将任务交给另外一个进程去处理,这时页面主线程会继续执行消息队列中的任务。等该进程处理完这个任务后,会将该任务添加到渲染进程的消息队列中,并排队等待循环系统的处理。排队结束之后,循环系统会取出消息队列中的任务进行处理,并触发相关的回调操作

这就是页面编程的一大特点:异步回调

//执行状态

function onResolve(response) {

console.log(response);

}

function onReject(error) {

console.log(error);

}

let xhr = new XMLHttpRequest();

xhr.ontimeout = function (e) {

onReject(e);

};

xhr.onerror = function (e) {

onReject(e);

};

xhr.onreadystatechange = function () {

onResolve(xhr.response);

};

//设置请求类型,请求URL,是否同步信息

let URL = "https://time.geekbang.com";

xhr.open("Get", URL, true);

//设置参数

xhr.timeout = 3000; //设置xhr请求的超时时间

xhr.responseType = "text"; //设置响应返回的数据格式

xhr.setRequestHeader("X_TEST", "time.geekbang");

//发出请求

xhr.send();这短短的一段代码里面竟然出现了五次回调,这么多的回调会导致代码的逻辑不连贯、不线性,非常不符合人的直觉,这就是异步回调影响到我们的编码方式

封装异步代码,让处理流程变得线性

由于我们重点关注的是输入内容(请求信息)和输出内容(回复信息),至于中间的异步请求过程,我们不想在代码里面体现太多,因为这会干扰核心的代码逻辑

将 XMLHttpRequest 请求过程的代码封装起来了,重点关注输入数据和输出结果

我们把输入的 HTTP 请求信息全部保存到一个 request 的结构中,包括请求地址、请求头、请求方式、引用地址、同步请求还是异步请求、安全设置等信息。将所有的请求细节封装进 XFetch 函数

这个 XFetch 函数需要一个 request 作为输入,然后还需要两个回调函数 resolve 和 reject,当请求成功时回调 resolve 函数,当请求出现问题时回调 reject 函数

新的问题:回调地狱

不过一旦接触到稍微复杂点的项目时,你就会发现,如果嵌套了太多的回调函数就很容易使得自己陷入了回调地狱,不能自拔

XFetch(makeRequest('https://time.geekbang.org/?category'),

function resolve(response) {

console.log(response)

XFetch(makeRequest('https://time.geekbang.org/column'),

function resolve(response) {

console.log(response)

XFetch(makeRequest('https://time.geekbang.org')

function resolve(response) {

console.log(response)

}, function reject(e) {

console.log(e)

})

}, function reject(e) {

console.log(e)

})

}, function reject(e) {

console.log(e)

})这段代码之所以看上去很乱,归结其原因有两点:

- 第一是嵌套调用,下面的任务依赖上个任务的请求结果,并在上个任务的回调函数内部执行新的业务逻辑,这样当嵌套层次多了之后,代码的可读性就变得非常差了

- 第二是任务的不确定性,执行每个任务都有两种可能的结果(成功或者失败),所以体现在代码中就需要对每个任务的执行结果做两次判断,这种对每个任务都要进行一次额外的错误处理的方式,明显增加了代码的混乱程度

原因分析出来后,那么问题的解决思路就很清晰了:

- 第一是消灭嵌套调用

- 第二是合并多个任务的错误处理

Promise:消灭嵌套调用和多次错误处理

首先,我们使用 Promise 来重构 XFetch 的代码,示例代码如下所示:

function XFetch(request) {

function executor(resolve, reject) {

let xhr = new XMLHttpRequest();

xhr.open("GET", request.url, true);

xhr.ontimeout = function (e) {

reject(e);

};

xhr.onerror = function (e) {

reject(e);

};

xhr.onreadystatechange = function () {

if (this.readyState === 4) {

if (this.status === 200) {

resolve(this.responseText, this);

} else {

let error = {

code: this.status,

response: this.response,

};

reject(error, this);

}

}

};

xhr.send();

}

return new Promise(executor);

}再利用 XFetch 来构造请求流程,代码如下:

var x1 = XFetch(makeRequest("https://time.geekbang.org/?category"));

var x2 = x1.then((value) => {

console.log(value);

return XFetch(makeRequest("https://www.geekbang.org/column"));

});

var x3 = x2.then((value) => {

console.log(value);

return XFetch(makeRequest("https://time.geekbang.org"));

});

x3.catch((error) => {

console.log(error);

});- 首先我们引入了 Promise,在调用 XFetch 时,会返回一个 Promise 对象

- 构建 Promise 对象时,需要传入一个 executor 函数,XFetch 的主要业务流程都在 executor 函数中执行

- 如果运行在 excutor 函数中的业务执行成功了,会调用 resolve 函数;如果执行失败了,则调用 reject 函数

- 在 excutor 函数中调用 resolve 函数时,会触发 promise.then 设置的回调函数;而调用 reject 函数时,会触发 promise.catch 设置的回调函数

Promise 主要通过下面两步解决嵌套回调问题的

首先,Promise 实现了回调函数的延时绑定。回调函数的延时绑定在代码上体现就是先创建 Promise 对象 x1,通过 Promise 的构造函数 executor 来执行业务逻辑;创建好 Promise 对象 x1 之后,再使用 x1.then 来设置回调函数。